深度学习论文: Multi-modal Sensor Fusion for Auto Driving Perception: A Survey

Multi-modal Sensor Fusion for Auto Driving Perception: A Survey

PDF: https://arxiv.org/pdf/2202.02703.pdf

PyTorch代码: https://github.com/shanglianlm0525/CvPytorch

PyTorch代码: https://github.com/shanglianlm0525/PyTorch-Networks

1 概述

单模态数据(图像或者点云)的感知存在固有的缺陷。例如,摄像机数据主要在前视低位捕获。在更复杂的场景中,物体可能被遮挡,给目标检测和语义分割带来严峻挑战。此外,由于机械结构的限制,激光雷达在不同距离上具有不同的分辨率,并且容易受到极端天气(如雾天和大雨)的影响。尽管两种模态的数据在单独使用时在各个领域都有优秀表现,但激光雷达和摄像机的互补性使得它们的结合可以在感知方面取得更好的性能。

作者对关于自动驾驶中多模态传感器融合论文进行简要综述。同时提出了一种新颖的分类方法,将超过50篇相关论文按照融合阶段的角度划分为两个主类(强融合和弱融合)和四个次类(早期融合,深度融合,后期融合和非对称融合)。

2 Tasks, and Open Competitions

2-1 Multi-modal Sensor Fusion Perception Tasks

总的来说,自动驾驶感知任务包括了目标检测、语义分割、深度补全和预测等,这里主要关注目标检测和语义分割。

2-2 Open competitions and Datasets

KITTI开放基准数据集是自动驾驶中最常用的目标检测数据集之一,包含2D、3D和鸟瞰视图检测任务。配备四个高分辨率视频摄像机、一个Velodyne激光扫描仪和一个最先进的定位系统,KITTI收集了7481张训练图像和7518张测试图像以及相应的点云。其中三种目标被标记为汽车、行人和骑车者,具有超过20万个3D目标注释,分为三类:简单、中等和困难的检测难度。对于KITTI目标检测任务,平均精度通常用于模型性能比较。此外,平均方向相似度也用于评估联合检测目标和估计其3D方向的性能。

Waymo开放数据集由五个LiDAR传感器和五个高分辨率针孔相机收集。具体来说,有79个场景用于训练,202个用于验证,150个场景用于测试。每个场景持续20秒,注释在车辆、骑车者和行人中。对于评估3D目标检测任务,Waymo包括四个指标:AP/L1、APH/L1、AP/L2、APH/L2。更具体地说,AP和APH表示两种不同的性能测量,而L1和L2包含具有不同检测难度的对象。至于APH,它与AP类似,但是会经过航向精度加权计算。

NuScenes开放数据集包含1000个驾驶场景,其中700个用于训练,150个用于验证,150个用于测试。配备了摄像机、LiDAR和雷达传感器,nuScenes在每个关键帧中注释了23种目标类别,包括不同类型的车辆、行人和其他。NuScenes使用AP、TP进行检测性能评估。此外,它提出了一个创新的标量分数作为nuScenes检测分数(NDS),由AP、TP进行计算,分离不同的错误类型。

3 Representations for LiDAR and Image

3-1 Image Representation

一般为RGB通道

3-2 Point-based Point Cloud Representation

大多数LiDAR的原始数据是四元数格式(x; y; z; r) 其中 r表示每个点的反射率。不同的纹理导致不同的反射率,这能为模型提供了额外的信息。

3-3 Voxel-based Point Cloud Representation

通过使用3DCNN将3D空间离散化为3D体素来,表示为 { x 1 ; x 2 ; x 3 : : : x g } \left \{ x_{1}; x_{2}; x_{3}:::x_{g} \right \} {x1;x2;x3:::xg},其中每个 x i x_{i} xi表示一个特征向量 x i = { s i ; v i } x_{i}=\left \{ s_{i}; v_{i}\right \} xi={si;vi} 。 s i s_{i} si表示体素化立方体的中心,而 v i v_{i} vi表示基于统计的局部信息。

3-4 2D-mapping-based Point Cloud Representation

基于2D映射的点云表示将LiDAR数据投影到图像空间中。常见有两种类型:相机平面图(CPM)和鸟瞰图(BEV)

相机平面图(CPM):CPM可以通过外参标定来获得,将每个3D点投影到相机坐标系中。由于CPM具有与相机图像相同的格式,可以将CPM作为额外通道自然融合。但是由于投影后LiDAR的分辨率较低,CPM中许多像素的特征已经损坏,因此上采样特征图或者留空等方法用来改善特征图。

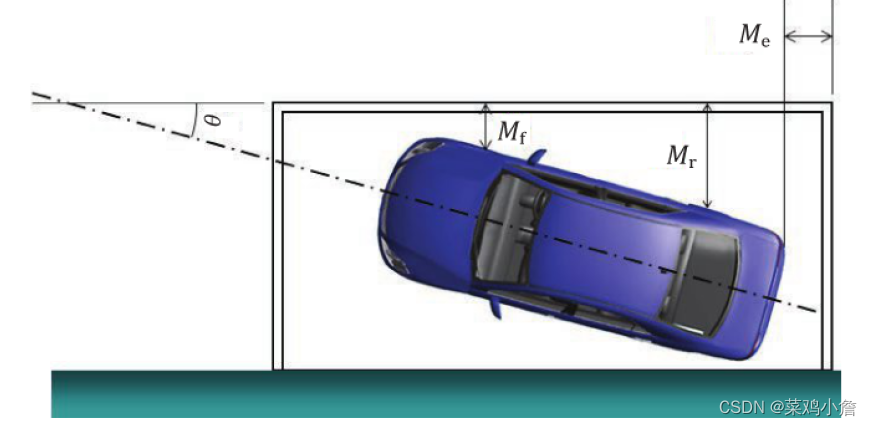

鸟瞰图(BEV):BEV映射提供了场景的俯视图。经常被用作定位和检测使用。首先,与安装在挡风玻璃后面的相机不同,大多数LiDAR都在车顶上,遮挡较少。其次,在BEV中,所有物体都放在地面上,模型可以在不扭曲长度和宽度的情况下生成预测。

4 Fusion Methodology

4-1 Strong-fusion

强融合中的每个次类高度依赖于LiDAR点云,而不是相机数据。

4-1-1 Early-fusion

Early-fusion(数据级融合)方法通过空间对齐直接融合不同模态的原始传感器数据。Early-fusion是一种在每种模态中通过空间对齐和投影直接融合数据的方法,早期融合在数据级别融合LiDAR数据和在数据级别或特征级别融合相机数据。

4-1-2 Deep-fusion

Deep-fusion(特征级融合)方法通过连接或元素逐位乘法在特征空间中混合跨模态数据。Deep-fusion方法在LiDAR分支的特征层级上融合跨模态数据,但是对于图像分支则进行数据层级和特征层级的融合。

4-1-3 Late-fusion

Late-fusion(对象级融合)方法结合每种模态中模型的预测结果并做出最终决策。Late-fusion可以被视为一种集成方法,利用多模态信息来优化最终结果。

4-1-4 Asymmetry-fusion

Asymmetry-fusion 从一个分支融合对象级信息,而从其他分支融合数据级或特征级信息的不对称融合方法。与强融合中的其他方法不同,非对称融合中至少有一个分支占主导地位,而其他分支提供辅助信息来进行最终任务。

4-2 Weak-fusion

基于弱融合的方法通常使用基于规则的方法来利用一种模态的数据作为监督信号来指导另一种模态的交互