摘要

我们从一个统一的角度总结了现有的高效标签图像分割方法,讨论了一个重要的问题:如何弥合弱监督和密集预测之间的差距——目前的方法大多是基于启发式先验,如跨像素相似性、跨标签约束、跨视图一致性和跨图像关系。最后,对标签高效深度图像分割的未来研究方向进行了展望。

跨像素相似性(Cross-Pixel Similarity)

跨像素相似性指的是在图像中找到相似的像素。这通常用于图像分割和超分辨率任务中。通过计算和利用相似像素之间的相似度,可以更准确地进行分割或增强图像的细节。常见的方法包括利用像素的颜色、纹理和其他特征来衡量相似度。

跨标签约束(Cross-Label Constraints)

跨标签约束是指在多标签分类任务中,利用标签之间的关系和约束来提高分类性能。例如,在图像标注中,一个对象的出现可能会影响另一个对象的标签,通过这种跨标签的约束,可以更准确地进行分类和标注。这些约束可以基于先验知识或者通过学习得到。

跨视图一致性(Cross-View Consistency)

跨视图一致性指的是在多视图学习中,确保来自不同视角或视图的数据在表示和预测上保持一致。例如,在3D重建、立体视觉或多视图图像分析中,来自不同视角的图像应当提供一致的结果和特征表示。通过确保这种一致性,可以提高模型的鲁棒性和准确性。

跨图像关系(Cross-Image Relationships)

跨图像关系是指在分析多张图像时,考虑这些图像之间的相互关系。这在图像检索、图像匹配和多图像拼接中尤为重要。通过分析和利用图像之间的关系,可以实现更复杂的任务,如全景图像拼接、视频跟踪中的目标一致性等。

引言

本文旨在全面概述最近的高效标签深度图像分割方法。

这些方法关注不同的问题。在这里,一个问题被定义为特定的分割问题,即语义分割、实例分割和全景分割,并具有一定类型的弱监督。为了组织这些方法来解决不同的问题,我们需要在本调查中解决两个问题:

- 如何为这些方法建立一个分类法?

- 如何从统一的角度总结这些方法中使用的策略?

我们试图从弱监督的角度来回答上述两个问题。为此,我们首先提供弱监督的类型分类,这种分类是分层的。

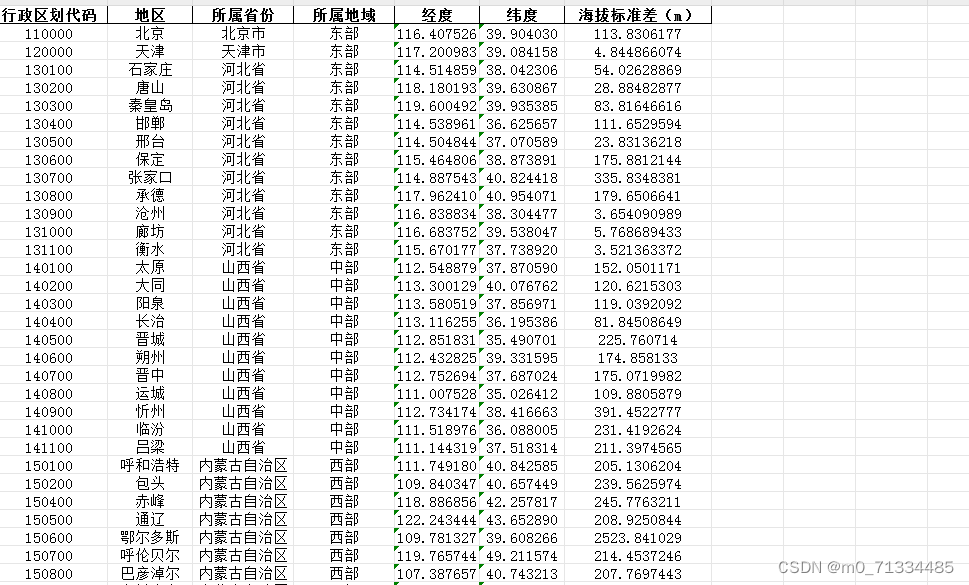

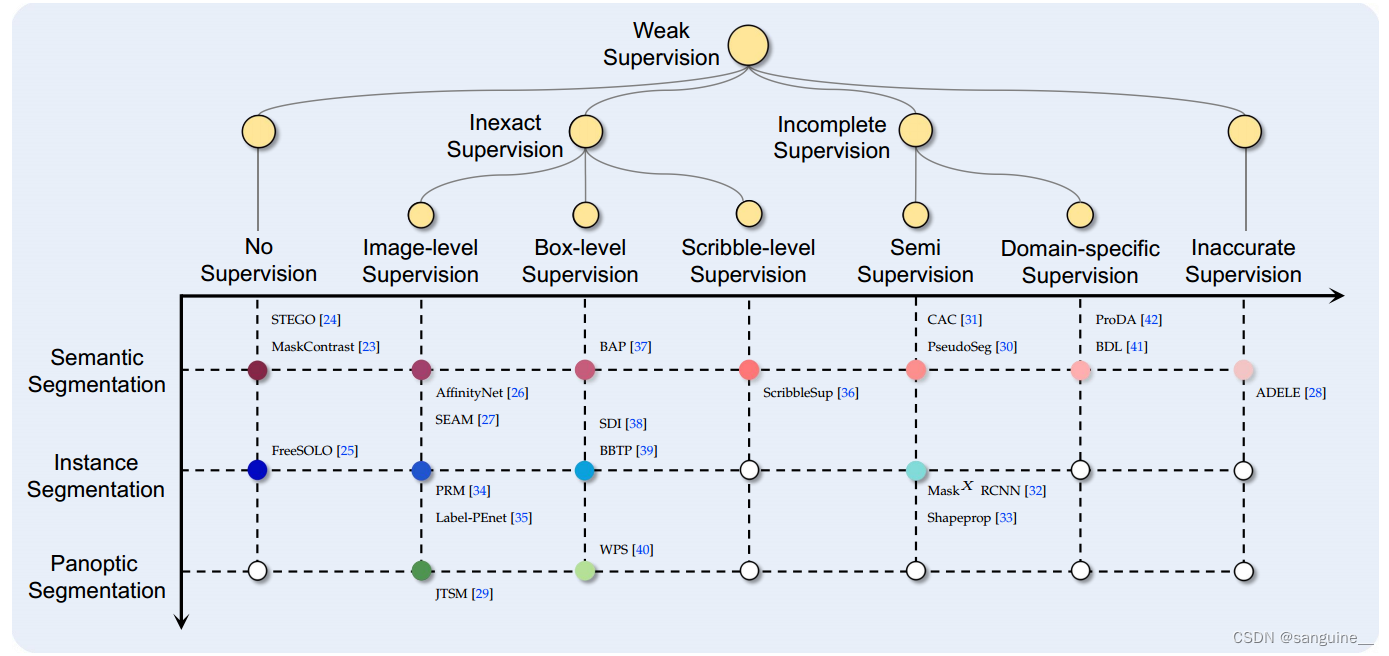

图1:填充点和空心点之间的相互作用分别表明对某些弱监督类型的分割问题进行了探索和未进行探索。

图2:对各种类型的弱监督与全密集监督进行了实例比较

弱监管的类型包括:

- 无监督:未对任何训练图像进行标注(图2 (a));

- 不精确监督:所有训练图像都提供了注释,但每张图像的注释并不如预期那样精确,不能完全覆盖所有像素的标签(如图2(b)所示)。不精确监督可以分为以下几类:(i) 图像级监督,(ii) 框级监督,以及 (iii) 涂鸦级监督。

- 不完全监督:仅对训练图像子集提供完整的逐像素注释(图2 (c))。不完全监督可以分为(i)半监督,即其余的训练图像没有完全标注或没有标注和(ii)特定领域的监督,如果其余的训练图像来自不同的领域;

-

监督不准确:对所有训练图像都提供逐像素标注,但存在标注错误,即噪声标注。(图2 (d))。

特定领域监督指的是在训练图像中只有特定领域的数据集有标注的情况。在图二中,特定领域监督的示例是指只有COCO数据集有标注,而其他训练图像没有标注。这种情况属于不完全监督的一种,其中只有部分训练图像具有完整标注,而其余图像来自不同的领域或数据集,并且缺乏完整标注。

通过这种层次化的弱监督类型分类,我们可以构建一个高效标签的深度图像分割方法的分类法。如图1所示,该分类法主要是根据弱监督的类型补充分割问题的类型来构建的:横轴和纵轴分别显示不同类型的弱监督和分割任务;每个交点表示对应分割任务与对应弱监督的结合问题,其中实心点和空心点分别表示已被探索和尚未被探索的问题;对于每个带有彩色实心点的交点,即已被探索的问题,给出了一些代表性的工作。

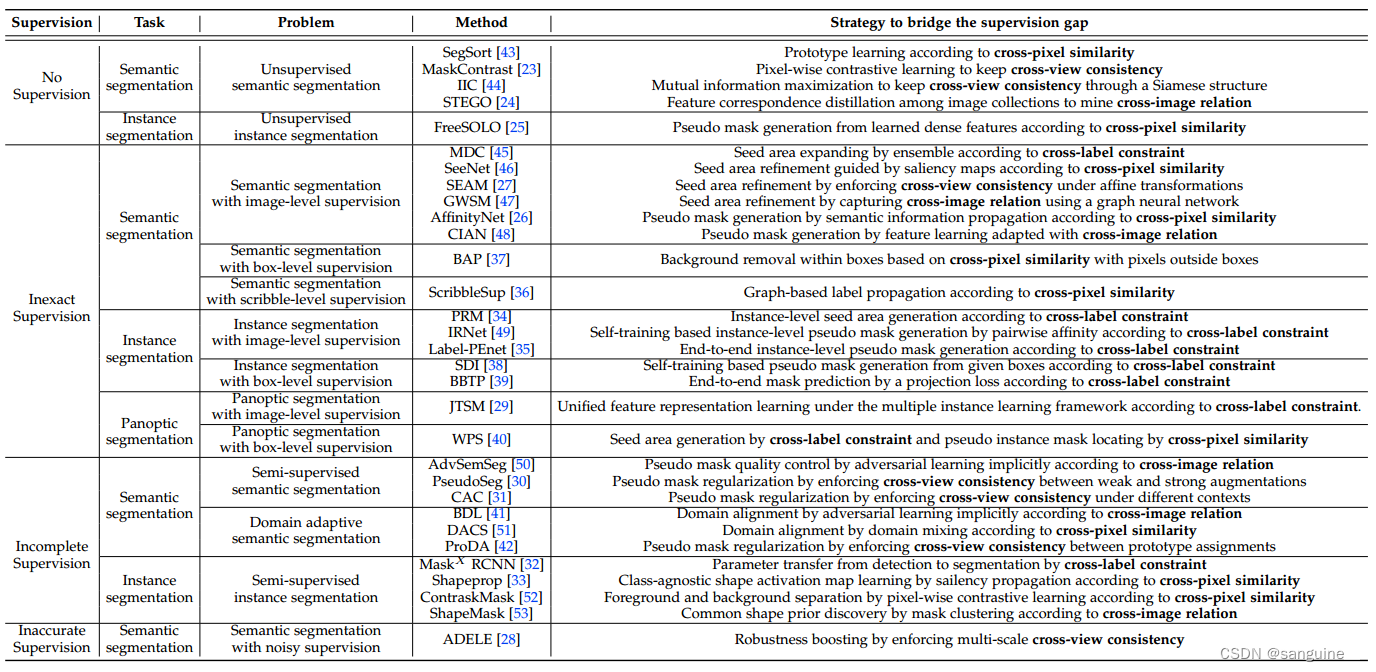

表一:标签高效深度图像分割的代表作品。

2.FOUNDATIONS

2.1 Problem Definition

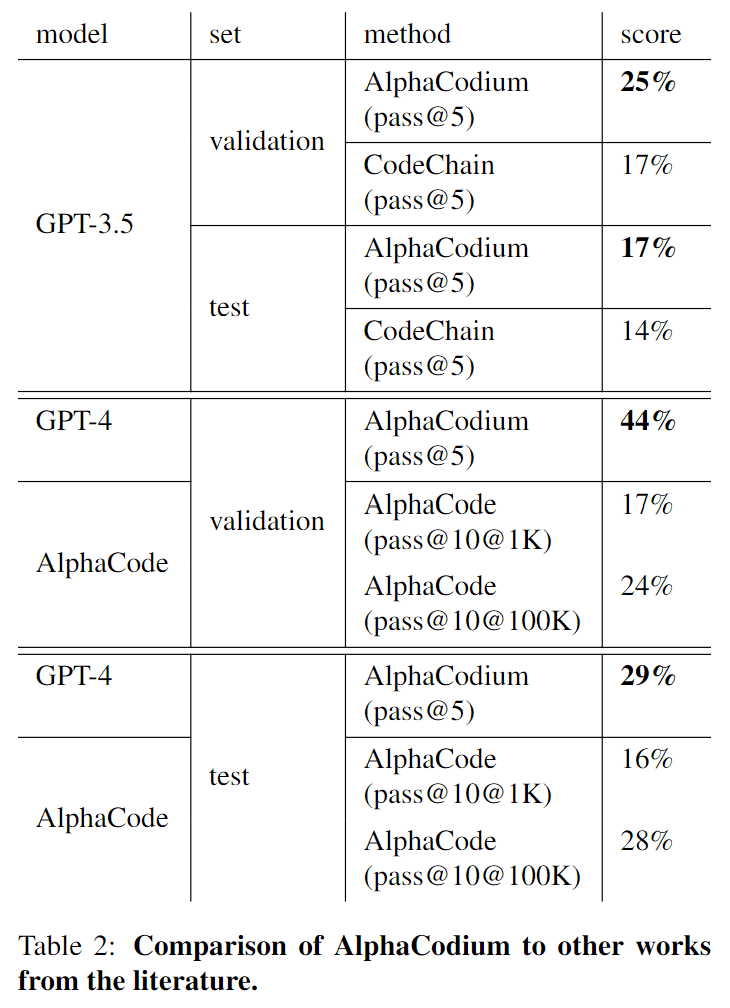

表2:不同监督类型下图像分割的数学定义

- b 表示图像 X 中的一个边界框(bounding box)的顶点坐标。边界框通常用于表示图像中对象的位置,它是一个矩形框,由其左上角和右下角的坐标定义。

- Ib 表示边界框 b 内所有像素的空间位置集合。这意味着 Ib 包含了边界框内所有像素点的位置信息。

来表示已被标注的像素的空间位置集合。这里的

是图像 I 的一个子集,其中 I 是整个图像上所有像素的位置集合。

- 在表 2 中,作者总结了在不同类型的监督信号下进行分割的数学定义。这包括了从无监督到完全监督的各种情况。

- 全密集监督:训练集T包含图像X(n)和完整的密集标签Y(n),其中n表示第n个图像。这意味着每个训练图像都有完整的标注信息,包括每个像素的语义类别和实例ID。

-

无监督(No Supervision):训练集T只包含图像X(n),没有任何标注信息。这意味着训练图像没有任何监督信号,模型需要自主学习图像的特征和结构。

-

不准确监督(Inaccurate Supervision):训练集T包含图像X(n)和不准确的标签

,其中

可能与真实标签Y(n)存在差异。这种监督类型下,标签可能存在噪声或错误,需要模型具有一定的鲁棒性来处理这种情况。

-

不完全监督(Incomplete Supervision):

- 半监督(Semi):训练集T包含部分图像X(n)和完整的密集标签Y(n),以及另一部分图像X(n)没有完整标注。这种情况下,只有部分训练图像具有完整标注,其余图像缺少完整标注。

- 特定领域(Domain-specific):训练集T包含源领域(source)图像X(n)和完整的密集标签Y(n),以及目标领域(target)图像X(n)没有完整标注。这种情况下,源领域具有完整标注,而目标领域缺少完整标注。

-

不准确监督(Inaccurate Supervision):

- 训练集T包含图像X(n)和不准确的标签

,其中

可能与真实标签Y(n)存在差异。这种监督类型下,标签可能存在噪声或错误,需要模型具有一定的鲁棒性来处理这种情况。

- 训练集T包含图像X(n)和不准确的标签

2.2 方法概述

自我训练:由于标签高效图像分割的主要困难是缺乏密集标签,一种朴素的解决方案是首先基于每个训练图像的弱标签生成(密集)伪标签,然后用伪标签训练分割模型。为了提高自训练过程中生成的伪标签的质量,通常对其进行正则化处理。

-

训练集T的定义:

- 在这里,T = {(X(n); Y(n)},其中n ∈ N,表示用于标签高效图像分割的给定训练集。Y(n)代表任何类型的监督,例如,它可以是C(n)用于图像级监督,如果n ∈ N或者是空集;如果n ∈ N但n不在Nl中,表示半监督。

-

生成伪标签的过程:

- 首先,通过参数化为θ的深度网络fθ对每个训练图像X(n)生成密集特征图Z(n) =

。然后,通过参数化为w的函数gw应用于密集特征图Z(n),生成伪标签图P(n) = gw(Z(n))。这个伪标签生成过程受Y(n)的监督,即通过最小化损失函数LGEN(P(n); Y(n))来优化θ和w,具体形式取决于如何设计P(n)和Y(n)之间的映射。

- 首先,通过参数化为θ的深度网络fθ对每个训练图像X(n)生成密集特征图Z(n) =

-

正则化:

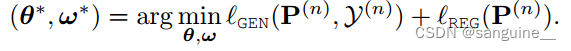

- 为了进一步提高P(n)的质量,通常会使用正则化损失LREG(P(n))与生成损失LGEN一起使用。因此,在自训练过程中,包括以下步骤:学习每个训练图像X(n)的伪标签图,通过最小化伪标签生成损失LGEN(P(n); Y(n))和可选的伪标签生成损失LREG(P(n))。

- 优化后的伪标签映射:

- 基于训练集,用优化后的伪标签{(

,

)|n∈N}训练分割模型。

端到端训练:端到端训练直接优化与自训练中使用的形式相同的损失函数,即LGEN(P(n); Y(n)) + LREG(P(n)),通过梯度下降或交替方向方法进行优化,如果我们将图像X(n)的最终分割视为伪标签P(n)的特殊情况。端到端训练可以避免自训练中昂贵的迭代推理过程,并且甚至可以在某些标签高效分割问题上取得更好的结果,例如半监督语义分割。简而言之,端到端训练是一种直接优化损失函数的方法,而不需要像自训练那样生成伪标签并进行迭代训练。通过端到端训练,可以更高效地训练模型,并在某些情况下实现比自训练更好的结果,特别是在半监督语义分割等标签高效分割问题上。

交替方向方法:

- 交替方向方法是一种优化算法,通常用于解决包含多个变量的优化问题。在每次迭代中,该方法会依次固定其中一个变量,对其他变量进行优化,然后再固定另一个变量,对其余变量进行优化,如此交替进行直到收敛。这种方法可以用于解决复杂的非凸优化问题,并在某些情况下比传统的梯度下降方法更有效。

将图像X(n)的最终分割视为伪标签P(n)的特殊情况:

- 这句话的意思是将图像X(n)的最终分割结果视为一种特殊的伪标签P(n)。在标签高效图像分割任务中,通常会通过自训练或端到端训练的方式生成伪标签来指导模型学习。将图像的最终分割结果视为伪标签的特殊情况意味着将已有的分割结果作为一种伪标签来训练模型,而不是通过其他方式生成伪标签。这种做法可能会在某些情况下简化训练过程或提高模型性能。

2.3启发式先验函数

我们确定了特定先验适用于处理哪种类型的弱监督

- 交叉标签约束描述了细粒度标签和粗粒度标签之间的关系,因此它大多适用于不精确的监督;

- 跨像素相似性表示具有高度相似线索(如颜色、亮度和纹理)的像素可能属于图像中相同的语义区域。由于该先验来源于感知分组原则,因此适用于所有类型的弱监督;

- 交叉视图一致性和交叉图像关系也非常普遍,可以适用于所有类型的弱监督。

- 然后,我们总结了先验在训练过程中的作用,对于不同类型的弱监督,先验的作用可能会有所不同。例如,交叉像素相似度通常用于生成无监督的伪标签,因为它可以以无监督的方式指导像素分组。其功能成为其他类型弱监督的伪标签正则化;交叉图像关系作为生成不完全监督伪标签的基础,用于正则化其他类型弱监督的伪标签。

表3: 系统研究了启发式先验在处理不同类型弱监督中的作用。“-”表示“尚未提出”。

2.4数据集和评估指标

2.4数据集和评估指标

标签高效图像分割通常遵循用于全监督图像分割的评估指标和数据集。例如,标签高效的语义分割方法通常在PASCAL VOC[58]和cityscape[59]上进行评估,有时使用mIoU[20]或Acc[20]度量。一个特殊的例子是领域自适应语义分割,它需要来自不同领域的两个数据集。因此,在GTA5[60]和SYNTHIA[61]等合成数据集上进行训练,在cityscape上进行评估;标签高效的实例分割方法通常在PASCAL VOC[58]和COCO[62]上进行评估,有时使用平均精度(AP)[62]或平均召回率(AR)度量;标签高效的全景分割方法在PASCAL VOC[58]和COCO-Stuff[63]用PQ指标评估。

表4:用于标签高效深度图像分割的数据集和评价指标。

Accuracy (ACC):准确率是指分类正确的样本数占总样本数的比例。在图像分割任务中,准确率可以表示为正确分割像素数与总像素数的比值,用来衡量模型对图像进行正确分割的能力。

Average Precision (AP):平均精度是用于评估检测或分割任务中模型的准确性和召回率之间的平衡。在图像分割中,平均精度通常是通过计算每个类别的精度-召回率曲线下的面积来得到的,用来衡量模型在不同类别上的性能。

Average Recall (AR):平均召回率是指模型在所有类别上的召回率的平均值。在图像分割任务中,平均召回率可以帮助评估模型对各个类别的识别能力,即模型能够正确检测到多少目标。

Panoptic Quality (PQ):全景质量是一种综合评估指标,用于评估模型在实例分割和语义分割任务中的综合性能。全景质量考虑了模型在实例级别和像素级别上的准确性,通过综合考虑分割结果的匹配度和覆盖度来评估模型的整体性能。

3.无监督

3.1无监督语义分割

早期,无监督语义分割是通过对手工制作的图像特征执行聚类算法(如Kmeans和Graph Cut[66])来实现的,将图像划分为具有高自相似度的多个片段。近年来,随着无监督特征表示学习的迅速发展,尤其是MoCo[67]、SimCLR[68]、BYOL[69]等的推广,无监督密集特征表示学习促进了无监督语义分割,它通过一个参数化为θ的深度网络fθ,对给定图像X学习一个不带任何标签的密集特征映射Z = fθ(X),其中zi为空间位置i的特征表示。

3.1.1跨像素相似性作为密集的自我监督

由于跨像素相似度来源于感知分组原理,几乎所有的无监督语义分割方法都利用它来产生密集的自监督。在本节中,我们只回顾仅依赖于此先验的方法。

Hwang等人[43]声称他们的SegSort是语义分割的第一种无监督深度学习方法:

-

生成密集的自监督信号(dense self-supervision):在无监督学习中,没有现成的标注数据,因此需要生成自己的监督信号。SegSort 通过聚类方法生成伪分割(pseudo segments),这些伪分割作为训练信号,帮助模型学习分割任务。

-

轮廓检测器的作用:为了生成伪分割,SegSort 利用了轮廓检测器 [70], [71]。轮廓检测器帮助识别图像中物体的边缘,这些边缘信息对于后续的聚类和分割至关重要。

-

提取原型(prototypes):对于每个伪分割,SegSort 提取了一个原型,这是该分割区域内像素表示的平均值。原型可以被视为该区域特征的代表或中心点。

-

训练目标:SegSort 的训练目标是优化像素的特征表示,使得同一伪分割内的像素特征向该分割的原型靠拢,同时远离其他伪分割的原型。这样,模型学习到区分不同分割区域的特征表示。

-

特征表示的拉近和推远:通过这种方式,SegSort 训练网络识别和区分不同的语义区域,即使没有显式的标注信息。这要求网络能够根据图像内容自动学习到有用的特征。

3.1.2交叉视图一致性作为密集的自监督

跨视图间一致性(Cross-view consistency),指的是同一对象在不同视角下表现出一致性,是无监督语义分割中常用的先验知识。这一先验知识广泛应用于基于对比学习【67】【68】和基于孪生结构【69】【72】【73】的无监督表征学习中,并取得了巨大的成功,同时也激发了无监督密集表征学习的发展。

3.1.2.1跨视图一致性的对比学习

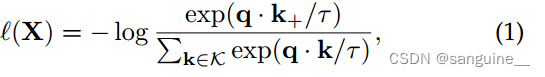

在对比学习中,给定图像X,首先生成图像的两个视图,其中一个视图作为查询q,另一个视图作为查询的正键k+。对比学习的优化目标是使对比损失最小化:

- K是由来自其他图像的正键K +和负键组成的键集,τ是温度参数。Eq.(1)也称为信息归一化交叉熵(InfoNCE)损失

- 可以看出,对比学习的两个关键是1)如何产生不同的观点和2)如何确定正/负对。

- 这个损失函数的目标是通过最小化对比损失来学习图像中每个像素的特征表示,使得来自同一对象的像素在特征空间中更加接近,而来自不同对象的像素在特征空间中更加分散。

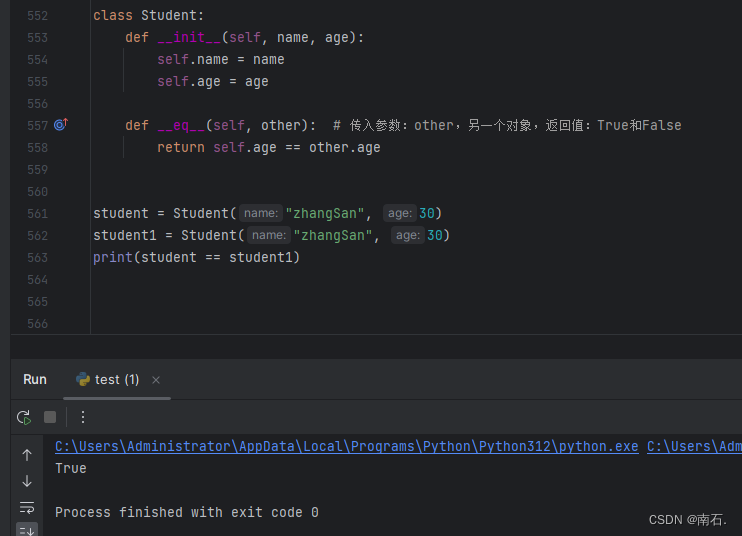

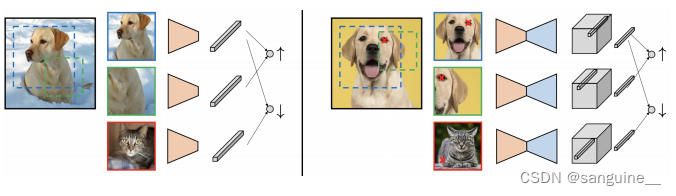

Pinheiro等人【74】首次将对比学习扩展到了密集表示学习。他们提出了视图无关的密集表示(View-Agnostic Dense Representation,VADeR)【74】,这是一种基于像素级对比学习的方法。图3展示了VADeR与图像级对比学习的比较。遵循MoCo【67】的做法,VADeR的作者:

- 采用了数据增强,包括几何变换(如缩放、倾斜、旋转和翻转)和光度变换(如对比度变化和颜色饱和度),生成同一图像X的两个视图Xa和Xb,其中一个视图用于查询(queries),另一个视图用于键(keys)。

- 使用了两个具有相同架构的网络fθ和fθ¯来分别计算查询和键的特征表示,其中第一个网络的参数θ是可训练的,而另一个网络的参数¯θ通过θ的滑动平均获得。

- 维护了一个内存库M,用于存储负样本的键。

- 他们将来自两个不同视图的相同像素i的特征表示,即

和

,定义为正样本对,并将来自不同图像的像素的特征表示定义为负样本对。然后,应用像素级对比损失来学习每个像素i的特征表示,如表3所示。后续的像素级对比学习方法主要试图改进确定正样本/负样本对的标准【75】【76】。

图3:VADeR的插图(图片来自[74])。左边是图像级对比学习,右边是VADeR(像素级对比学习)。

对比学习:【深度学习:(Contrastive Learning) 对比学习】深入浅出讲解对比学习-CSDN博客

-

VADeR [74]:这是一种像素级的对比学习方法,用于无监督的语义分割。VADeR 通过数据增强(如几何变换和光度变换)生成图像的两种视图:查询视图(query view)和键视图(key view)。

-

MaskContrast [23]:Gansbeke 等人提出了 MaskContrast 方法,它结合了 SegSort 和对比学习。在这个方法中,也生成了查询视图和键视图,但是引入了“原型”(prototypes)作为对比学习中的“键”。每个原型是对象掩码提议(object mask proposal)内像素表示的平均值,这些掩码提议是通过无监督显著性检测生成的。MaskContrast 使用像素级对比学习,将查询视图中的每个像素表示拉近到它在键视图中对应的掩码提议的原型(正键),同时推开其他掩码提议的原型(负键)。

-

Ouali et al. [64]:Ouali 等人提出了另一种像素级对比学习方法,与 VADeR 类似,但是在生成图像的不同视图时采用了不同的策略。他们不是使用几何和光度变换,而是利用不同形式的掩码卷积来对输入图像进行不同的排序,从而构建图像的不同视图。

-

Wang et al. [77]:Wang 等人提出了一种方法,通过将前景图像裁剪粘贴到不同的背景图像上,生成正样本对。这种“复制粘贴”操作提供了一个更直观的密集目标,即前景-背景分割,它允许在无监督的方式下联合训练一个主干网络(backbone)和一个分割头(segmentation head)。

"对象掩码提议(object mask proposal)内像素表示的平均值"这个概念涉及到图像分割和特征表示的计算。下面是对这个概念的通俗解释:

对象掩码提议:在图像分割任务中,尤其是在无监督或弱监督的分割方法中,对象掩码提议是指算法自动生成的,代表图像中某个对象可能位置的区域。这些提议可以基于多种启发式方法生成,例如显著性检测、边缘信息等。

像素表示:在深度学习模型中,输入图像会通过一系列卷积层进行处理,每个像素点会被转换成一个多维的特征向量,这个向量包含了该像素点的多种特征信息,我们称之为像素的表示(representation)。

平均值:对于一个给定的对象掩码提议,它会包含多个像素点。这些像素点的表示可以被汇总起来,计算它们的平均值。这里的“平均值”通常指的是这些特征向量在各个维度上的平均,即对所有提议区域内像素的特征向量求和,然后除以像素的数量。

原型:通过计算得到的对象掩码提议内像素表示的平均值,可以被视为该提议区域的“原型”(prototype)。原型提供了该区域特征的一个概括性描述,可以用于后续的比较或学习过程。

在无监督语义分割的上下文中,对象掩码提议内像素表示的平均值可能被用作对比学习中的“正键”(positive key),帮助模型学习区分不同对象的特征表示,从而提高分割的精度。通过这种方式,模型可以在没有人工标注的情况下,自动学习到如何识别和区分图像中的不同对象。

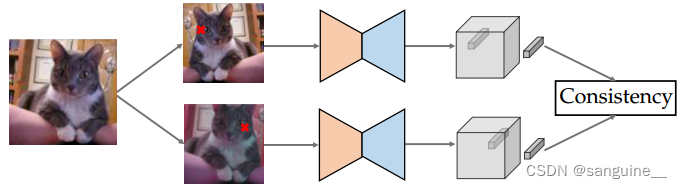

3.1.2.2交叉视图一致性的孪生结构

基于Siamese结构的无监督表示学习也会生成图像的两个视图,但它在没有负样本的情况下最大化了两个视图之间的一致性,如图4所示。通常,一个视图的表示是在线更新的,而另一个视图的梯度流是停止的[73]。此外,跨视图一致性通常用跨两个视图的聚类分配关系来表示[72]。

图4:基于Siamese结构的无监督密集表示学习

两种基于孪生网络(Siamese network)结构的无监督密集表示学习(dense representation learning)方法,用于无监督分割任务:

-

Ji 等人 [44]:提出了一种名为不变信息聚类(Invariant Information Clustering, IIC)的方法。这种方法的目标是最大化不同视图(即同一图像经过不同变换得到的视图)中相邻像素之间的互信息(mutual information),以确保跨视图的一致性。

-

互信息:互信息是衡量两个随机变量之间相互依赖程度的指标。在这里,它用于衡量不同视图中相邻像素的相似性。IIC 方法通过聚类来计算互信息,即基于一系列聚类中心(cluster centroids)的相似性分布,定义了两个视图中相邻像素的联合分布。

-

聚类中心:在 IIC 方法中,聚类中心是用于代表图像中不同区域特征的点。每个像素的特征表示需要与其所在视图的聚类中心相似,同时也要与另一视图中相应聚类中心相似。

-

Cho 等人 [65]:提出了另一种策略,称为 PiCIE(Pixel-level feature Clustering using Invariance and Equivariance),用于测量基于孪生网络的密集表示学习中的聚类分配关系。PiCIE 方法分别对两个不同视图进行聚类。

-

像素级特征表示:在 PiCIE 方法中,每个像素的特征表示应该尽可能接近它所在视图的聚类中心,同时也要接近另一视图中的聚类中心。这意味着像素的特征表示在两个视图之间应该是一致的,这有助于无监督学习过程中的特征对齐和一致性。

3.1.3 交叉图像关系作为密集的自我监督

来自同一类别对象的像素在图像中具有语义关系。然而,由于没有可用的监督,如何挖掘跨图像语义相似的像素是一个瓶颈。为了解决这一问题,目前的方法通常使用从无监督预训练中学习到的特征,如MoCo[67]和BYOL[69],作为建立交叉图像关系的基础,然后对特征进行细化。

Zhang等[78]提出了一种隐式涉及交叉图像关系的逐像素对比学习方法,用于无监督语义分割。他们对通过无监督预训练学习到的所有训练图像的特征进行聚类,能够根据聚类分配为所有训练图像的每个像素分配一个伪标签。在对比学习中,使用伪标签进行正/负对的选择。

Hamilton 等人【24】提出了 STEGO,这是一种密集表示学习方法,通过显式挖掘跨图像关系,根据特征对应关系进行无监督语义分割。他们通过保持网络主干输出的特征对应关系和分割头输出的特征对应关系,在同一图像内和跨图像集合内进行自监督训练,从而训练分割模型。

3.2无监督实例分割

无监督实例分割是一个更具挑战性的问题,直到最近才被探索。 据我们所知,FreeSOLO [79] 是首个研究这一问题的工作。FreeSOLO 将 SOLO [18] 中的分割过程和 DenseCL [75] 中的密集自监督学习统一为一种“查询-键”(query-key)注意力设计。它利用了自监督预训练模型(DenseCL)中涉及的密集对应关系,通过跨像素相似性为每个未标记的图像生成一些类别无关的粗略掩码。这些粗略掩码随后被用于以弱监督和自训练的方式训练一个 SOLO 分割器,从而提高了分割性能。此外,FreeSOLO 可以被视为一个强大的自监督预训练任务。通过在有限的完全标注图像上进行微调,它可以显著提升相对于 DenseCL 的表现。

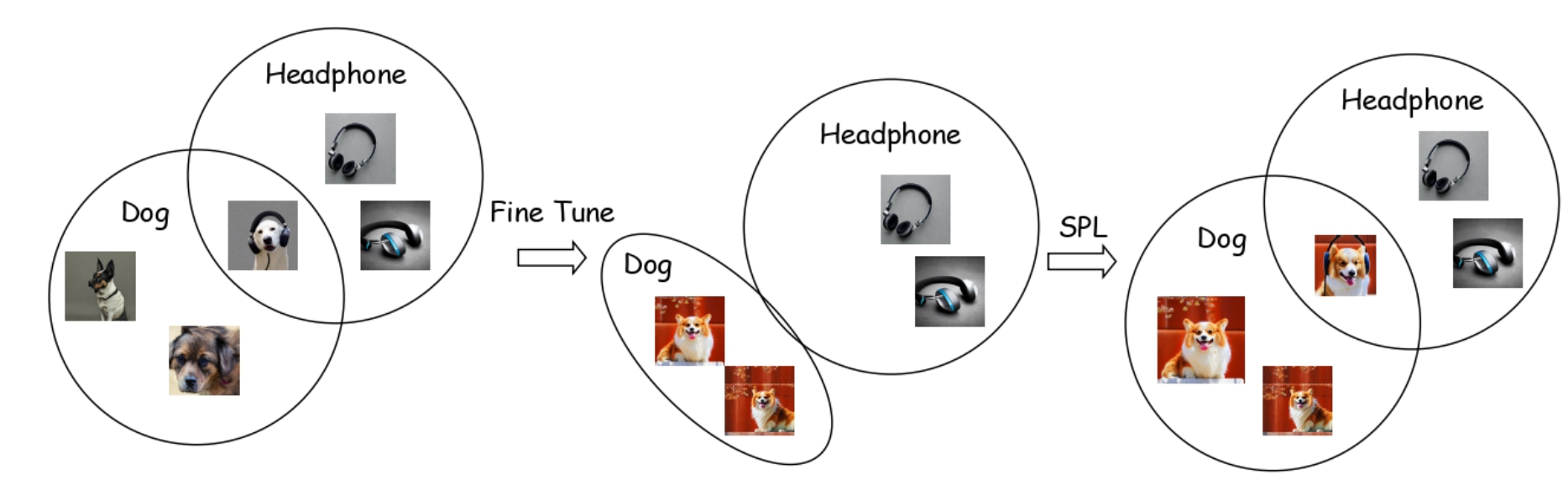

3.3讨论

随着无监督密集表示学习的兴起,无监督分割已成为一个很有前途的研究方向。[77]中的实验结果表明,基于无监督分割学习到的密集表示进行微调,其性能优于全监督分割模型。例如,经过[77]预训练的DeepLabV3[9]在Pascal VOC 2012数据集[58]上的微调结果达到77.6%的平均交并比(Intersection-over-Union, mIoU),优于完全监督的DeepLabV3[9]的结果(76.0% mIoU)。这一令人鼓舞的结果证明,以无监督方式学习的密集表示具有良好的结构化,可以促进分割。

然而,密集表示学习在无监督分割中的探索仍处于初级阶段。与图像级表示学习不同,密集表示学习需要一些区域先验来表示像素之间的关系,即它们是否属于同一语义区域。这本质上与无监督分割的目标相同。因此,无监督分割面临着先有鸡还是先有蛋的问题。如何在初始阶段引入更准确的区域先验,或者如何在学习过程中对其进行细化,是值得未来探索的问题。

4.不精确监督

如图2和表2所示,不精确监督可以是图像级(每个训练图像只提供类别标签),盒级(除了类别标签,还为每个训练图像标注对象边界框)或潦草级(每个训练图像中一个像素子集进行标注)。不精确监督分词在文献中通常称为弱监督分词。

虽然在更广泛的意义上,这个术语也可以指其他类型的弱监督的分割,如不完全监督。

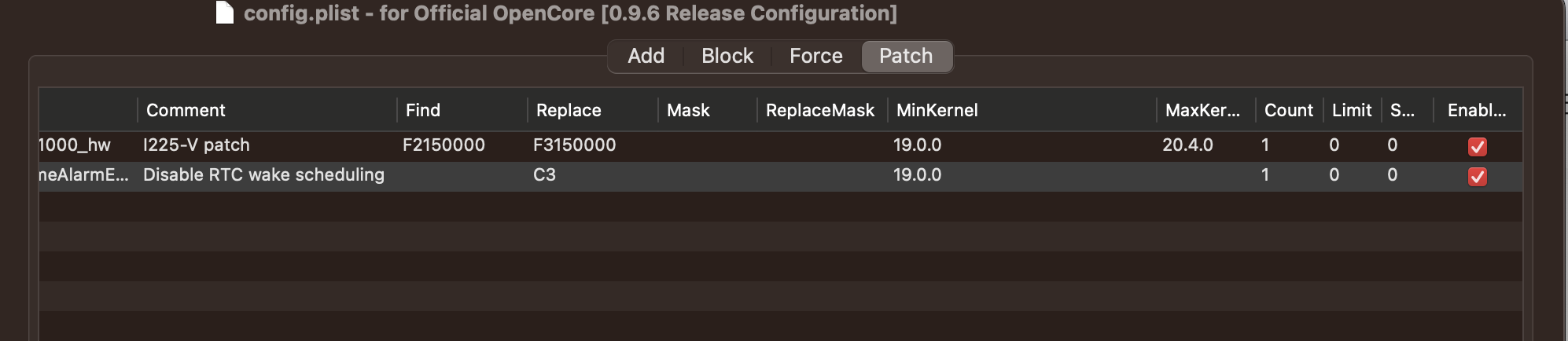

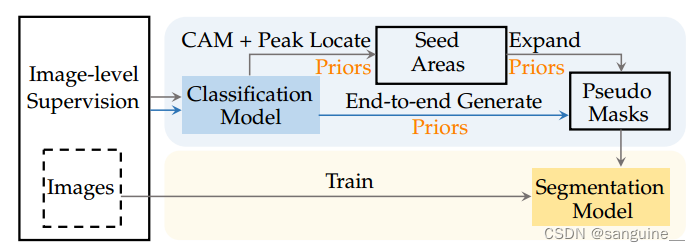

图5:具有图像级监督的语义分割的主流管道

4.1图像级监督分割

4.1.1具有图像级监督的语义分割

在本节中,我们回顾了在图像级监督下进行语义分割的方法。问题的难点在于图像级监督与像素级密集预测之间存在很大的监督差距。前者用于训练图像分类模型,而后者则要求划分物体/物质的掩码。

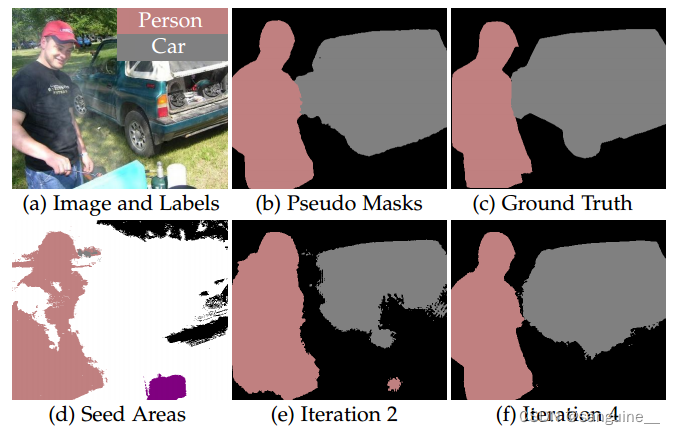

为了弥补监督缺口,如图5所示,研究人员采用了两阶段的流水线,第一阶段通过图像级监督训练的分类模型为每个训练图像生成伪掩码(密集标签),然后基于伪掩码训练语义分割模型(从种子区域生成伪掩码的示例如图6所示)。由于伪掩码不可避免地存在噪声,用伪掩码训练分割模型相当于带噪声监督的分割问题。因此,我们在第6节中回顾了第二阶段的方法,在本节中我们主要回顾了第一阶段的方法

第一阶段的目标是生成高质量的伪掩码,该步骤包括两个后续步骤:1)第一步,根据分类模型得到的信息,在每个训练图像中获得一些种子区域。这一步通常是通过计算分类模型的类激活图(class activation maps, CAMs)[81]、[82]、[83]来实现的,这样种子区域就可以覆盖每张图像中的判别语义区域。2)然后,在第二步中,通过将种子区域的语义信息传播到整个图像,生成伪掩码(密集标签)。这种伪掩码生成过程通常是迭代的,涉及到分割模型的自我训练。现有的方法或者是精炼种子区域使其更准确和完整,或者是在种子区域的基础上生成更可靠的伪掩码,通过使用我们总结的常见先验。其次,回顾了基于不同先验的种子区域细化和伪掩码生成方面的研究进展。

4.1.1.1交叉标签约束的种子区域细化

类激活图(CAMs)作为基于分类模型生成种子区域的实际工具,被所有带有图像级监督的语义分割方法采用。CAMs本质上利用跨标签约束的先验信息,根据分类模型提供的信息在图像中定位种子区域。然而,CAMs捕捉到的种子区域存在两个局限性:1) 不完整性:CAM通常无法覆盖目标类别的整个语义区域;2) 冗余性:CAM可能会与其他类别的区域重叠。为了解决这些问题,研究人员设计了几种策略来改进CAMs,生成用于种子区域优化的类似CAM的图,包括:1) 通过集成扩展 [45], [84], [85],2) 通过擦除重新发现 [86], [87], [88],3) 通过优化发现 [89], [90], [91] 和 4) 通过解耦推理 [92], [93]。

集成方法通过组合多个模型或方法的结果来提升性能和鲁棒性。集成方法可以减少单一模型的偏差和方差,从而生成更可靠和全面的种子区域。

优化方法通过迭代调整模型参数或输入图像,以逐步改进类激活图的质量。这种方法通常利用某种损失函数来衡量当前CAM的质量,并通过最小化该损失函数来改进CAM

解耦推理方法通过分离不同类别的特征来改进类激活图。这种方法旨在减少不同类别之间的干扰,从而生成更清晰和准确的CAM。

通过集成(ensemble)多种不同的类激活图(Class Activation Maps, CAMs)来扩展种子区域,以便更好地覆盖目标类别的整个语义区域:

-

扩展种子区域的问题:通常,单个CAM无法覆盖目标类别的所有语义区域,因为它可能只突出显示对象的一部分。

-

集成策略:为了解决这个问题,一种直观的策略是使用多个CAM的集成来扩展种子区域。这意味着结合多个不同CAM的特征,以期望能够更全面地覆盖目标对象。

-

使用不同扩张率的卷积:Wei 等人 [45] 提出了一种方法,通过使用具有不同扩张率的多个扩张卷积(Multi-Dilated Convolutional, MDC)块计算的CAM集成来扩大种子区域。这种方法利用了不同扩张率的卷积核来捕获不同尺度的特征。

-

随机组合隐藏单元:与 Wei 等人的方法不同,Lee 等人 [85] 提出了一种生成多种CAM的方法,通过在分类模型中使用随机组合的隐藏单元。这是通过在分类模型的特征图上应用空间dropout [94] 来实现的,dropout是一种正则化技术,它随机地将一些网络单元的输出置为零。

-

CAM的漂移现象:Jiang 等人 [84] 观察到一个有趣的现象,即在训练过程中,CAM倾向于在目标类别的不同区域之间漂移。这意味着随着训练的进行,CAM可能会集中在对象的不同部分。

-

在线累积方法:基于这一观察,Jiang 等人提出了一种在线累积方法。该方法通过在不同的训练阶段累积CAM来获取类似CAM的图。这样,随着训练的进行,模型可以不断调整和更新CAM,以期望最终获得一个更加全面和准确的CAM集成。

通过擦除重新发现。另一种直观的策略是擦除当前的CAM,然后强制分类模型重新找到其他区域以形成新的CAM。新旧cam的集成可以扩展种子区域以覆盖目标类的更完整的语义区域。Wei等[86]提出了一种开创性的“擦除”框架,该框架迭代地擦除当前CAM,然后发现另一个CAM。由于当前CAM覆盖的语义区域被擦除,因此鼓励分类网络发现其他相关的语义区域以维持分类预测。最后,将在所有迭代中发现的cam进行组合,以获得最终的类cam地图,该地图可能覆盖整个目标区域。Zhang等人[87]通过引入对抗性互补学习(ACoL)改进了“擦除”框架。他们在单个网络中生成了两个并行分类器,它们的初始化方式不同,因此每个分类器产生的cam可以鼓励对应的分类器发现互补的语义区域。ACoL将来自两个分类器的cam融合为最终的cam样地图。Sun等人[88]认为,与其仅仅将不同步骤获得的cam聚合在一起,cam之间的相互作用可以提供额外的监督,以学习更多的像素级信息。基于这一假设,他们提出了一个擦除的CAM监督网络(ECS-Net),从擦除的CAM中采样可靠的像素,以生成像素级的伪标签,以监督新CAM的生成。

对抗性互补学习(Adversarial Complementary Learning,ACoL)是一种用于改进语义分割的方法,旨在发现互补的语义区域以提高分割性能。在ACoL中,通过引入两个并行的分类器,这两个分类器在网络中初始化不同,以促使每个分类器发现对方无法发现的语义区域,从而实现互补学习。

通过优化进行发现。与融合不同的CAM不同,可以通过在优化过程中鼓励分类模型看到更大区域来发现种子区域。Lee等人[89]采用了一种反对抗方式,通过针对目标类别分类的像素梯度来扰动图像。这种操作迫使更大的语义区域参与分类,并生成一个类似CAM的图,以识别目标对象的更完整区域。从信息瓶颈原理的角度来看[95], [96],Wang等人[90]解释了为什么CAM无法覆盖目标类别的整个语义区域。根据信息瓶颈理论,关于输入图像的信息在通过网络的层层传递过程中被压缩,只有与任务相关的信息才能通过网络的最终层。在分类任务中,最相关的信息通常存在于对象或物体的辨别部分,因此,训练后的分类模型容易忽略非辨别部分。此外,Chang等人[91]指出,CAM仅覆盖目标类别的辨别子区域的核心原因是训练分类网络的目标函数并不要求网络“看到”目标类别的整个区域。基于这一观点,他们引入了一个额外的自监督子类别分类任务,强制网络也关注目标类别的非辨别子区域 。

解耦推理。CAM可能与非目标类的区域重叠的原因可能是存在所谓的共现类,例如“马”和“人”经常相互共现。共现类误导了分类模型。Zhang等[92]通过因果推理解决了这一问题[97]。他们分析并解耦了图像与混杂集(即共现类集)之间的因果关系,以防止种子区域被阐述为冗余区域。此外,Su等[93]为了避免背景干扰,使用复制-粘贴操作来解耦混杂集之间的关系。他们将前景图像粘贴到不同的图像上,这样前景图像中的类就可以摆脱与相应背景的刻板的上下文关系,从而鼓励种子区域更多地关注前景区域。

4.1.1.2基于跨像素相似性的种子区域细化

“擦除”框架可能会误导种子区域逐渐扩展到不正确语义的区域。为了解决这一问题,最近的一些方法利用跨像素相似度的先验来指导种子面积的扩展。这可以通过涉及显著性地图[99]来实例化,以确保扩展到类似语义的区域。

使用显著性图(saliency maps)来指导种子区域(seed area)精细化的计算机视觉方法:

-

Self-Erasing Network (SeeNet) [46]:Hou等人提出了一种名为Self-Erasing Network的方法,这是首次尝试使用显著性图来指导种子区域的精细化。显著性图是一种突出图像中重要或显著区域的图,有助于模型识别图像中的关键部分。

-

显著性图的广泛应用:在SeeNet之后,显著性图在后续的研究工作中得到了广泛的应用。例如,文献[100]中提到的方法将显著性图作为软性指导来控制种子区域的扩展。这意味着在种子区域增长的过程中,显著性图提供了一种温和的指导,帮助模型决定哪些区域应该被包含在内。

-

跨任务亲和学习框架:Xu等人[101]提出了一个跨任务亲和学习框架,用于同时学习分类任务、显著性检测任务和分割任务。这个框架的特点是,它认识到显著性检测任务和分割任务在结构化语义上具有相似性。

-

学习跨任务亲和图:由于显著性检测和分割任务之间的相似性,研究者们被激励去从显著性和分割表示中学习跨任务的亲和图。亲和图是一种表示像素之间关系的图,可以帮助模型更好地理解图像中的结构和对象。

-

种子区域精细化:通过学习这些跨任务的亲和图,模型能够更准确地精细化种子区域,即在图像分割过程中确定对象的确切边界。

4.1.1.3通过交叉视图一致性来细化种子区域

一些研究人员提出使用交叉视图一致性来提高种子区域的质量,因为交叉视图一致性可以促进从同一图像的不同空间扰动中获得的cam之间的语义一致性[27],[102]。

Wang等人[27]设计了一个孪生网络用于种子面积细化。Siamese网络包含两个具有不同数据增强的分支,其中一个分支与对应的分支相比,为每个输入图像添加额外的仿射变换。基于Siamese网络,作者鼓励从两个分支计算的cam保持一致。Zhang等[102]遵循[27]的精神,认为种子面积扩大的本质是信息的增加,并证明了由具有互补部分的一对图像生成的CAM集合(称为CP对)的信息总是大于等于一个CAM个体。基于这一思想,作者提出了一种CP网络,以减小由CP对生成的CAM集合与初始CAM之间的差距。CP网络提供了一个信息更丰富、覆盖更完整语义区域的CAM。最近,Jiang等人[103]提出了一种新的增强技术来构建多个视图,以强制从具有不同分辨率的视图组计算的cam之间的局部到全局一致性。

4.1.1.4基于交叉图像关系的种子区域细化

跨图像关系可以通过鼓励具有语义共现的不同图像之间的像素级交互来增强种子区域生成的鲁棒性。

通过比较和整合多个图像中的相似特征,跨图像关系可以更准确地识别和确认种子区域。例如,在多幅图像中都出现的“猫”可能在不同的图像中具有不同的姿势或光照条件,通过跨图像比较,可以更全面地捕捉到“猫”的所有特征。

在不同图像的像素级别进行交互和特征比较,有助于捕捉细节和微小的特征差异。这种精细的交互能提高种子区域生成的精确性。

当某个语义特征(如“车”)在多幅图像中共现时,可以利用这种共现关系增强对该特征的识别和确认。例如,如果在一幅图像中“车”的某部分特征不明显,但在另一幅图像中同一类型的“车”的该部分特征清晰,那么可以通过跨图像的信息整合,增强对“车”种子区域的识别。

Sun等人提出了两种神经协同注意力机制,用于互补地捕捉具有语义共现的每对图像之间的交叉图像语义相似性和差异性。其中一种是协同注意力,旨在帮助CAMs覆盖属于同一类别的对象的互补部分,另一种是对比协同注意力,旨在帮助CAMs区分属于不同类别的对象的语义。

Li等人提出了一种组内语义挖掘(GWSM)方法,通过图神经网络(GNN)捕获图像组中一组图像之间的交叉图像关系,而不是仅限于一对图像。作者将GNN嵌入到分类模型中,以传播像素级语义对应关系,逐步推动CAMs覆盖更完整的对象区域。

最近,Zhou等人引入了一个包含数据集级典型区域特征嵌入的记忆库,通过交叉图像关系调节学习到的CAMs。这些方法的目的是通过不同的注意力机制和关系建模技术,帮助模型更好地理解图像之间的语义关系,从而提高语义分割的准确性和鲁棒性。通过引入这些方法,研究人员可以更好地利用图像之间的关联信息,从而改善分割结果并提高模型的性能。

4.1.1.5通过跨像素相似度生成伪掩码

伪掩码通常以迭代的方式生成,即从种子区域开始,或者阐述当前的伪掩码(由种子区域初始化),然后使用通过自我训练学习的分割模型来更新伪掩码。跨像素相似性先验在伪掩码阐述中得到了广泛的应用,其关键是如何度量像素间的相似性(亲和度),从而使阐述过程规范化。亲和性可以基于低级特征(如颜色和纹理)[56]、[107]、[108]、[109]或高级语义[26]、[98]、[110]。

低级特征:

- 直接在图像数据中提取的原始或基本特征。包括颜色、纹理、边缘、角点等。

- 较低的抽象级别,直接反映的是图像基本属性和局部结构。

高级特征:

- 在低阶特征的基础上通过更高层次的计算和分析得到的特征表示。

- 包括物体的形状、姿态、上下文信息、语义标签。

- 具有更高的抽象级别,能表示图像中更复杂的语义和概念。

低层次线索的亲和学习。

- Kolesnikov等[107]提出了训练分割模型以从种子区域生成伪掩码的三个原则:1)只使用高置信度的伪标签进行训练;2)更新后的伪标签应与给定的图像级标签一致;3)约束更新的伪掩码以尊重对象边界。这三个原则在后续的工作中被广泛采用。

- Kolesnikov等人通过测量低级图像线索(如颜色和空间位置)的像素级亲和力实现了第三种方法。Huang等[108]遵循了三个原则。他们采用了种子区域生长(SRG)策略[111],以高置信度对邻域像素进行伪掩码的阐述。Wang等[109]利用显著性图指导伪掩码阐述。

- Zhang等[56]也遵循这三个原则,提出了端到端的可靠区域挖掘(RRM)框架,共同进行分类和分割。他们引入了密集的能量损失[112],通过利用低水平的图像线索,将语义信息从种子区域传播到剩余的未标记区域。

具有高级学习特征的亲和学习。亲和性也可以通过学习到的高级特征之间的相似性来衡量。Ahn等人[26]提出AffinityNet学习像素级特征提取器,该提取器由种子区域的语义标签监督。使用训练好的AffinityNet构建像素间语义亲和矩阵,并将其进一步应用于随机行走[113],生成伪掩码。Ru等人[114]直接利用从Transformer学习到的关注来形成像素间的语义亲和矩阵。Wang等[98]构建了一个端到端迭代亲和学习框架(IAL),该框架类似于之前介绍的RRM框架[56]。不同之处在于[98]中的两两亲和矩阵是建立在习得的高级特征而不是低级图像线索上的。图6显示了一个由IAL从种子区域逐步生成的伪掩码示例。Zhang等[110]指出,平等对待所有种子区域可能会导致对某些错误种子的过度拟合。为了解决这个问题,作者引入了自适应亲和损失,其中采用自适应权重来衡量像素亲和的可靠性。

图6:从种子区域生成伪掩码。(图片来自[98]。)

4.1.1.6基于交叉图像关系的伪掩码生成

亲和学习也可以从交叉图像关系中受益。Fan等[48]构建了一个跨图像关联模块(CIAN),用于从语义共现的图像对生成伪掩码。在每对图像中,取一幅作为查询图像,另一幅作为参考图像。查询图像的特征图根据参考图像的像素级相似度进行了调整,这导致生成了更完整和准确的伪掩码。

语义共现的图像对指的是在一组图像中,具有相似语义内容或主题的图像之间的配对。这种配对可以基于它们所包含的对象、场景或概念等方面的相似性。通过对这些语义共现的图像对进行分析和处理,可以帮助模型更好地理解图像之间的语义关系,从而提高图像处理任务的性能和准确性。

4.1.2具有图像级监督的实例分割

在本节中,我们回顾具有图像级监督的实例分割方法。如图7所示,与具有图像级监督的语义分割策略类似,具有图像级监督的实例分割方法也是首先生成伪掩码,然后训练分割模型。但是,由于实例分割进一步需要定位每个对象,因此伪掩码应该是实例级的,而不是类别级的。实例级伪掩码可以通过以下两种方式获得:1)根据跨像素相似性(图7中灰色流线)进行自训练,阐述实例级种子区域;2)根据跨标签约束进行端到端训练(图7中蓝色流线)。

图7:主流流水线用于实例分割与图像级监督。

4.1.2.1实例级种子区域生成

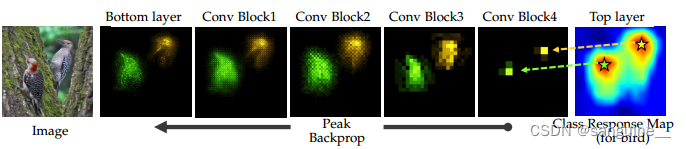

直观地,可以通过峰定位从类别级种子区域中获得实例级种子区域[34]。PRM[34]是第一个通过引入峰值响应图来解决这一任务的作品。分类模型为特定类别提供的种子区域中的高置信度响应(峰值)暗示了属于该类别的实例的可能位置。通过一个学习核,将种子区的峰值逐渐合并为几个,并假设每个峰值对应一个实例。如图8所示,将语义信息从峰值反向传播到整个图像,得到峰值响应图。利用GrabCut[1]在峰值响应图上定位每个实例的边界。

4.1.2.2实例级伪掩码生成

通过自我训练进行阐述。从实例级种子区域生成实例级伪掩码通常涉及一个自我训练过程。WISE[115]和IAM[116]是两个基于PRM的自我训练作品[34]。WISE选择PRM输出的局部最大值作为伪标签来训练实例分割模型。IAM[116]的作者指出,PRM只能识别实例中最具区别性的部分。在IAM中,他们通过一个可微分填充模块阐述峰值响应映射,从而生成实例级伪掩码。IRNet[49]通过从高置信度种子中同时学习与类无关的实例映射和成对语义亲和力来生成实例级伪掩码。后者用于识别对象边界,使前者的传播能够形成准确的实例级伪掩码。

图8 通过峰值反向传播生成实例级种子区域的说明。(图片来自[34]。)

峰值反向传播是一种技术,用于从神经网络中的特定层反向传播梯度,以确定激活最强烈的区域。在实例级种子区域生成中,峰值反向传播可以帮助确定每个实例的种子区域,从而为实例分割任务提供初始的区域标记。

- 从底层到顶层:首先,通过神经网络的底层到顶层传播图像信息,得到类别响应图(Class Response Map)。

- 峰值反向传播:然后,通过峰值反向传播技术,从顶层向底层反向传播梯度,以确定激活最强烈的区域。

- 生成种子区域:根据反向传播得到的梯度信息,确定每个实例的种子区域,作为实例分割任务的初始标记。

端到端(end-to-end)训练方法,这些方法直接将图像级别的标签转换为实例级别的伪掩码(pseudo masks),并用于实例分割任务:

-

端到端训练:与传统的自训练方法不同,端到端训练方法在一个统一的框架中直接从图像级别的标签生成实例级别的伪掩码,而不是通过多个离线阶段。

-

Label-PEnet [35]:Ge等人提出了Label-PEnet,这是一种在线且由粗到细(coarse-to-fine)的方式,用于将图像级别的标签转换为像素级别的标签。Label-PEnet设计了一个由四个并行模块组成的级联管道,包括分类、目标检测、实例细化和实例分割。这些模块共享相同的主干网络,并通过课程学习策略进行训练,逐步提高从图像级监督到像素级伪掩码的泛化能力。

-

WSIS-CL [117]:Hwang等人介绍了一个简单而高效的社区学习框架WSIS-CL,它在目标检测和实例掩码生成之间形成了正反馈循环。WSIS-CL采用了弱监督目标检测中最流行的方法OICR来生成对象提议,并使用来自空间金字塔池化的多级CAM来监督高置信度提议的实例分割模型。

-

PDSL [120]:PDSL并行执行弱监督目标检测和自监督实例分割,使用选择性搜索获得的相同提议。这两个分支的结果通过相关性学习进行约束,以保持一致的预测。

-

Zhou等人[122]:Zhou等人提出了一种简单的方法,通过在图像分类数据上训练分类器,将检测器和实例分割器的词汇量扩展到数万个概念。

4.1.3具有图像级监督的全景分割

全景分割(Panoptic Segmentation)使用图像级监督尚未被广泛探索,可能是因为这非常具有挑战性。据我们所知,Shen等人[29]是唯一解决这一问题的工作。他们提出了一个联合物体和背景挖掘(Joint Thing-and-Stuff Mining,JTSM)框架,其中设计了感兴趣区域掩码池(mask-of-interest pooling),用于为任意类别的片段形成固定大小的像素精确特征表示。事物和背景的统一特征表示使得可以根据跨标签约束,通过多实例学习将像素级伪标签连接到图像级标签。根据跨像素相似性,伪掩码通过Grabcut [1]进行精细化,并用于自我训练全景分割模型。

4.2基于盒级监督的分割

4.2.1具有盒级监督的语义分割

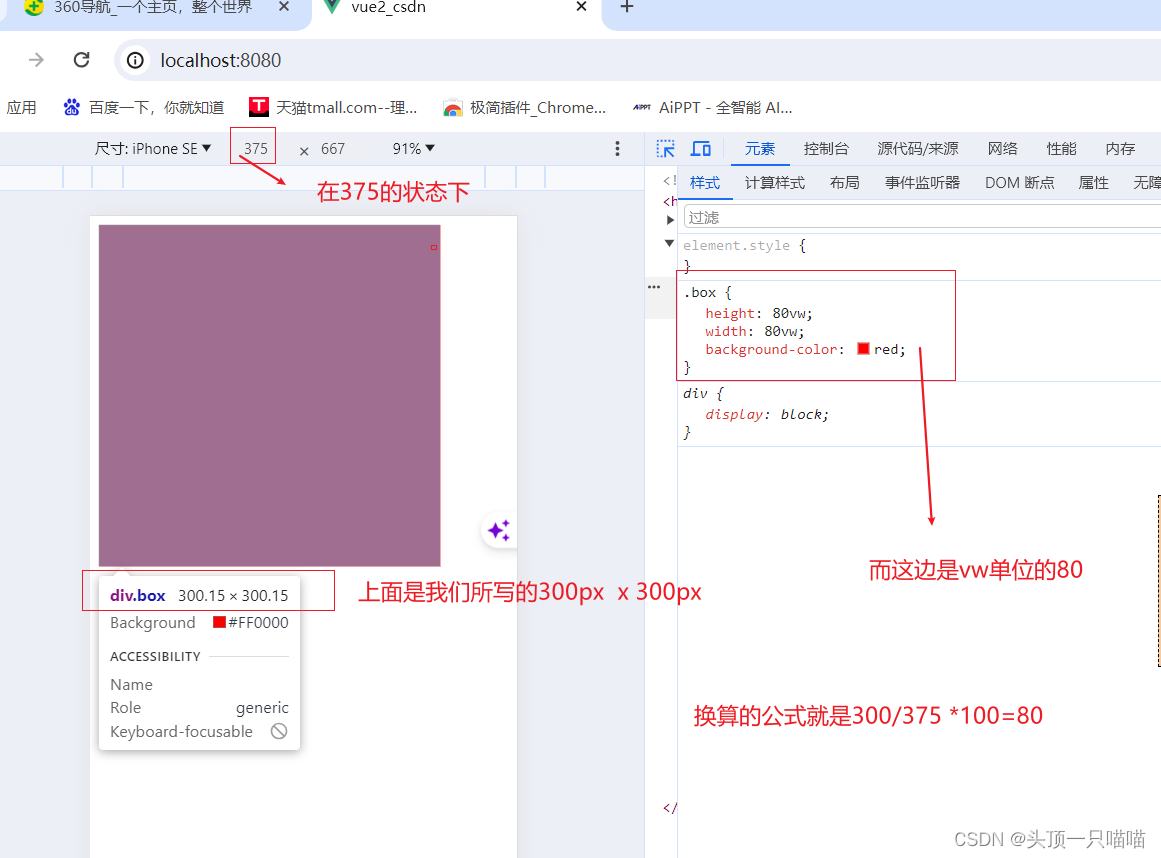

在本节中,我们回顾了使用框级监督进行语义分割的方法。框级监督作为图像级监督的更强大替代方案,自然缩小了定位对象的搜索空间。使用框级监督进行语义分割的核心挑战转变为区分注释边界框内的前景对象和背景区域。由于注释边界框起到类似于CAM图的作用,如图9所示,使用框级监督进行语义分割也包括两个步骤:1)根据跨像素相似性从注释边界框中挖掘伪掩码;2)基于伪掩码训练分割模型。

图9 具有箱级监督的语义分割的主流管道。

图10:主流管道实例分割与盒级监督。

Dai等人在尝试解决这一任务时采取的方法。他们提出了一种交替更新伪标记和分割模型的方法。具体来说,采用了MCG[123],这是一种无监督的区域提议方法,用于每个图像生成大约2,000个候选段。然后他们反复执行以下三个步骤:

- 使用分割模型为每个候选段预测语义标签;

- 对于每个带有注释的边界框,从被预测的与边界框相同语义标签的候选段中,选择与边界框具有最大重叠区域的候选段作为该边界框的伪标记;

- 通过伪标记更新分割模型。

由于MCG[124]生成候选段时没有考虑盒级监督,因此MCG生成的伪掩码的可靠性有限。相反,最近的方法[37],[125],[126]将盒级监督作为一个有噪声的起点来挖掘前景对象的伪掩码

Song等[125]提出计算带注释的边界框中每个类的填充率,作为指导分割模型训练的稳定指导。类似地,Kulharia等[126]基于类似cam的地图计算了每个边界框内每个空间位置的填充率,这可以减少背景区域的错误兴趣。Oh等人[37]不是在边界框中发现前景对象[125],[126],而是试图通过从带注释的边界框中移除背景区域来获得伪掩码。他们假设图像背景区域的小块在感知上是一致的,这就给出了一个标准来去除每个注释的边界框内的背景像素。

4.2.2具有盒级监督的实例分割

使用框级监督进行实例分割比使用图像级监督进行实例分割要容易一些,因为注释边界框已经为训练提供了实例位置。训练中的剩余难点是如何在给定的注释边界框内进行前景/背景分割。如图10所示,这可以通过以下两种方法解决:1)根据跨标签约束从注释边界框生成伪掩码,然后进行自我训练(图10中的灰色流程线);或2)使用直接表达跨标签约束的损失函数进行端到端训练(图10中的蓝色流程线)。

4.2.2.1通过自我训练掩码预测

SDI[38]是解决这一问题的第一个基于深度学习的方法。对于每个给定的带注释的box, SDI使用box内的整个box区域或Grabcut[1]生成的初始片段作为伪掩码,然后进行自训练,迭代改进伪掩码,最终给出mask预测。Lee等人提出BBAM[127],利用来自对象检测器的高级语义信息生成伪掩码。他们试图在一个盒子中找到一些可学习的区域,从这些区域中,物体检测器可以预测出与从整个盒子区域获得的几乎相同的检测和分类结果。直观地说,这些区域代表了物体的不同部分。将给定的标注框对应的不同对象建议的区域组合为其伪掩码。BoxCaSeg[128]通过引入来自显著性分割数据集的额外知识来增强前景/背景分离的能力,从而产生更精确的伪掩码

4.2.2.2 端到端训练掩码预测

在BBTP [39] 和 BoxInst [80] 这两种基于端到端训练的实例分割方法中,采用了盒级别监督。在这两种方法中,设计了一个投影损失(projection loss),用于直接制定交叉标签约束,以确保给定的注释框与预测掩模沿其四个边的投影之间的一致性。然而,这种投影损失无法对预测掩模的形状施加任何约束,这可能导致一些简单的解决方案,例如全为1的矩形。为了解决这个问题,在BBTP 和 Boxinst 中还提供了额外的成对损失函数,这些损失函数分别基于空间位置和颜色定义了基于像素的相似性。

在实例分割任务中,投影损失通常用于保证预测的掩模(mask)与给定的注释框(bounding box)之间的一致性。通过计算预测掩模在注释框四个边界上的投影与注释框之间的差异,可以评估模型的性能并指导模型训练。

投影损失的设计旨在引导模型学习正确的形状和位置信息,以便更准确地预测目标对象的掩模。然而,投影损失可能存在一些局限性,例如无法约束掩模的具体形状,可能导致一些不理想的结果。为了克服这些问题,有时会引入额外的损失函数,如成对损失函数,以更好地约束模型的输出,提高模型的性能和准确性

4.2.3 具有盒级监督的全景分割

基于盒级监督的全视分割仍然是一个具有挑战性的问题。唯一试图解决这个问题的工作是WPS[40]。在这项工作中,背景材料用图像级标签标注,前景实例用框级标签标注。WPS[40]首先利用Grad-CAM[82]根据交叉标签约束获得前景和背景类别的热图,然后利用Grabcut[1]根据交叉像素相似度从热图中定位每个前景实例的伪掩码。

Grad-CAM(Gradient-Weighted Class Activation Mapping)是一种用于可视化和解释深度学习模型(尤其是卷积神经网络CNN)预测的方法。它通过突出显示对模型输出类别决策贡献最大的图像区域来工作。以下是Grad-CAM的关键特点:

可视化:Grad-CAM生成的类激活图(Class Activation Map, CAM)是一种热图,它可视化了图像中对模型分类决策影响最大的区域。

基于梯度:Grad-CAM利用了模型最后卷积层的梯度信息。它计算每个类别相对于最后卷积层特征图的梯度,然后将这些梯度与特征图相乘,以突出显示对类别预测贡献最大的特征。

全局平均池化:Grad-CAM通常与全局平均池化(Global Average Pooling, GAP)层结合使用。GAP层将每个特征图的平均值作为类别的全局响应。

解释性:Grad-CAM提供了一种解释模型预测的方法,使研究人员和开发人员能够理解模型为何做出特定的分类决策。

应用:Grad-CAM广泛应用于各种视觉任务,包括图像分类、目标检测和分割,帮助分析模型的决策过程和识别模型可能的缺陷或偏见。

实现:Grad-CAM可以通过修改深度学习模型的最后一层来实现。具体来说,它需要访问模型的权重和梯度信息,然后通过一些数学操作生成CAM。

变体:Grad-CAM有几种变体,如Grad-CAM++,它提供了更准确的可视化,通过考虑模型中所有卷积层的贡献,而不仅仅是最后一层。

总结来说,Grad-CAM是一种强大的工具,它通过可视化模型的内部决策过程,帮助我们更好地理解和解释深度学习模型的行为。这对于提高模型的透明度和信任度非常重要。

4.3 具有Scribble-level 监督的分割

在本节中,我们将回顾基于Scribble的(语义)分割的方法,其中注释仅提供一小部分像素,通常以手绘Scribbles的形式提供。手绘Scribbles作为一种种子领域,图11显示了scribbllevel监督下的主流语义分割流水线。解决这个问题的关键是如何将语义信息从稀疏的涂鸦传播到所有其他未标记的像素。目前的方法通过利用图像的内部先验,即跨像素相似性来实现这一点。

作为第一次尝试,Di等[36]通过图形模型将信息从涂鸦传播到未标记的像素。图模型建立在图像的超像素上[129],其中节点是超像素,边缘表示相邻节点之间的相似性,通过低级外观线索(如颜色和纹理)来测量。他们采用交替方案共同优化图模型和分割模型:固定分割模型,采用多标签图切割求解器[130]为图模型中每个未标记的节点分配语义标签,形成伪掩码;基于伪掩码,他们重新训练了分割模型。类似地,Xu等人[131]利用多层语义特征而不是图模型中的低级特征来推断伪掩码。Paul等人[132]通过标签传播器从scribble生成伪掩码。标签传播器是一种基于随机游走的可微模型[113],用于语义传播,可以使用分割模型进行端到端联合训练。它进一步结合了一个可学习的边界预测器[133],以明确地约束空间传播在对象区域内“行走”。

上述方法都需要一个额外的模型来获得伪掩码。也有一些直接优化分割模型的方法,通过设计一个损失函数来连接潦草和密集的预测。Tang等[112]设计了一种新的损失函数,其中使用涂鸦作为部分逐像素监督,并采用归一化切割[66]来软保证所有像素的一致性。Tang等[55]进一步提出了一个扩展版本,也将CRF纳入损失函数

4.4 讨论

使用不精确监督进行分割降低了对具有完整密集标签的训练图像质量的要求。如本节所总结,解决此问题的主要流程是分阶段的:1)通过传播或挖掘从种子区域生成伪掩码(参见表1);2)基于伪掩码训练分割模型(自我训练)。如附录中的表5、表7和表9所示,使用不精确监督进行图像分割的最新结果可与使用完整密集监督的分割结果相媲美。然而,对于小物体和具有孔洞的物体,基于CAM的种子区域可能会显著不准确。对于这些具有挑战性的情况,另一种流程,即直接将密集预测与不精确标签直接链接的端到端流程(参见表1),可能是一种解决方案,值得进一步探索。

5.不完整的监督

如图2和表2所示,不完全监管可分为1)半监管、2)特定领域监管和3)部分监管。因此,具有这三种弱监督的分割分别称为半监督分割、领域自适应分割和部分监督分割。

5.1 半监督分割

5.1.1半监督语义分割

-

半监督语义分割问题:在这项任务中,只有一小部分训练图像具有像素级别的标注,而其余的图像没有标注。目标是利用这些未标注的图像来提升分割模型的性能。

-

半监督学习框架:一种常用的半监督学习框架是自训练(self-training)。在这个框架中,首先使用有标注的图像训练一个分割模型,这个模型被称为“教师模型”(teacher model)。

-

生成伪标签:然后,教师模型被用来对未标注的图像进行预测,生成伪密集标签(pseudo dense labels),这些标签是对未标注图像的分割预测。

-

重训练模型:接下来,使用这些伪标签来重新训练一个新的分割模型,这个新模型被称为“学生模型”(student model)。

-

伪标签的噪声问题:由于伪标签是基于模型自身的预测生成的,因此不可避免地会包含噪声和错误。

-

改进策略:为了提高伪标签的可靠性,当前的半监督语义分割方法采取了以下两种策略:

- 隐式改进:根据跨图像关系(cross-image relation)隐式地改进伪标签的可靠性。这可能涉及到使用图像间的相似性或差异性来优化标签。

- 显式正则化:通过引入额外的监督信号来显式地正则化伪标签,这通常基于跨视角一致性(cross-view consistency)。例如,通过确保同一图像的不同变换视图之间的预测一致性来提高标签的质量。

-

自训练过程:自训练过程可能包括迭代地生成和细化伪标签,以及使用这些标签来逐步提升学生模型的性能。

5.1.1.1用于自我训练的伪标签细化

直观地,伪密集标签的可靠性可以通过分割模型提供的置信度来确定。现有的方法通过迭代的自我训练来改进伪密集标签的可靠性,或者忽略那些可信度较低的标签。

两个不同的方法来改进半监督语义分割中的伪标签(pseudo labels)的生成和精细化,以提高模型性能。以下是对这些方法的解释:

关键点:

-

Hung等人的方法 [50]:

- 使用了一个鉴别器网络(discriminator network)来为未标注的图像生成可靠的置信度图(confidence maps)。

- 鉴别器网络使用有标注的图像进行训练,目的是判断输入图像的标签是来自真实的密集标注(groundtruth dense labels)还是来自分割模型的预测。

- 这种方法的目的是利用鉴别器网络来评估和提高伪标签的可靠性。

-

Ke等人的方法 [134]:

- 提出了一个三阶段的自训练框架(three-stage self-training framework),用于逐步精细化伪标签。

- 对分割模型进行了修改,增加了一个辅助分支(auxiliary branch),这个分支是原始模型最后两个块的副本。

- 原始分支的最后两个块和辅助分支分别使用伪标签的未标注数据和有标注数据进行训练。

- 因为辅助分支仅用有标注数据训练,所以它能够为下一阶段生成更可靠的伪标签。

- 这个分阶段的自训练框架通过迭代的方式提高了伪标签的可靠性,从而提高了模型的整体性能。

- 伪标签的生成:在半监督学习中,使用有监督数据训练的模型来为未标注数据生成伪标签,这些标签随后用于训练,以提高模型性能。

- 伪标签的可靠性:由于伪标签可能包含噪声和错误,提高其可靠性是一个关键问题。Hung等人使用鉴别器网络来评估伪标签的可靠性,而Ke等人通过分阶段自训练来精细化这些标签。

- 自训练框架:Ke等人的方法中,通过在不同阶段使用不同数据训练的分支,逐步提高了伪标签的质量,这种方法允许模型在每个阶段学习更准确的分割信息。

He等人[135]提出了一种自我训练的质量控制策略,其中引入标记比率α来控制伪标签的质量,使得未标记图像中只有α%的像素保留相应的伪标签。由于标注比例由特定类别的置信阈值决定,他的方法可以解决半监督语义分割中数据长尾分布的问题。

在图像分割任务中,我们的目标是将图像中的每一个像素归类到特定的类别中(例如,猫、狗、车、建筑等)。但是,数据集中不同类别的像素数量分布通常是不均衡的:

- 头部(Head)类别:一些常见的类别在数据集中占据了大量的像素。例如,“天空”、“道路”、“建筑”等,这些类别在大多数图像中都很常见,所以有大量的数据。

- 尾部(Tail)类别:一些不常见的类别在数据集中只占据了少量的像素。例如,“摩天轮”、“热气球”、“企鹅”等,这些类别在大多数图像中很少见,因此数据非常稀少。

这种不平衡会导致模型在训练时倾向于更好地识别和分割常见的类别,而在不常见的类别上表现较差。

5.1.1.2跨视图一致性的伪标签正则化

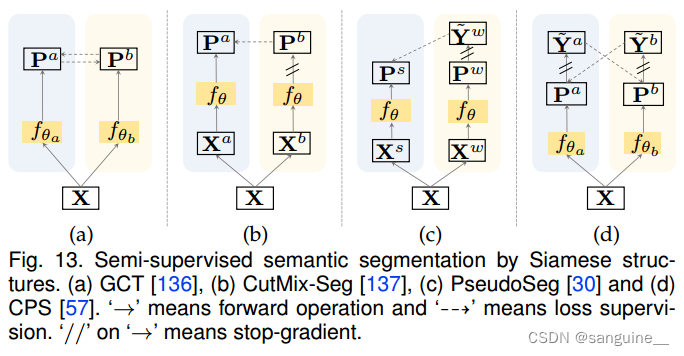

伪标签正则化可以从无监督密集表示学习中受益(第3节),因为它们都旨在在未标记的图像上训练分割模型。因此,在半监督语义分割中也使用了Siamese结构和对比学习,以保证同一图像在不同视图下的伪密集标签的跨视图一致性。

基于Siamese结构。图13展示了半监督语义分割中用于伪标签正则化的几种典型Siamese结构。GCT[136]利用两个具有相同架构但初始化方式不同的分割网络,分别从未标记图像的两个不同视图计算两个分割概率图。对分割概率图保持一致,作为训练的额外监督。CutMix-Seg[137]也使用了两个架构相同的分割网络,但其中一个网络的参数为另一个网络的移动平均值。两个网络输出的两个分割概率图保持一致,用于训练。PseudoSeg[30]使用弱增强视图生成的伪密集标签来监督强增强视图生成的伪密集标签。CPS[57]采用了使用两个具有相同架构的不同初始化的分割网络的策略,并强制从它们输出的伪密集标签之间的一致性。实验结果表明,该方法能取得较好的分割效果。

基于对比学习。Zhong等[138]采用像素对比学习促进中间层的特征学习。对于查询像素,他们研究了在逐像素对比学习中选择负键(像素)的几种采样策略,包括

- 均匀:一个图像中不同位置的像素或来自不同图像的像素是负键,

- 不同的图像作为负样本(Negative Keys),在对比学习中,负样本是指与查询样本(query)不匹配的样本。在这里,不同图像中的像素被用作负样本,即它们与查询图像中的像素不相似。

-

均匀分布加上伪标签:这种方法使用来自同一图像中不同位置的像素或来自不同图像的像素作为负样本,但这些像素的伪标签置信度较低。这意味着,如果伪标签不够确定,这些像素就被视为负样本。

-

不同图像加上伪标签:这种方法专注于使用来自不同图像的像素作为负样本,这些像素的伪标签置信度也较低。这有助于模型学习区分不同图像中相似但不属于同一类别的像素。

-

Lai等人 [31] 的策略:

- Lai等人提出了一种新颖的策略,通过考虑上下文信息来生成未标注图像的不同视图。对于一个未标注图像,随机裁剪出两个不同的区域,这两个区域有重叠部分。

- 使用编码器(encoder)和非线性投影器(non-linear projector)计算这两个区域的特征图。

- 应用对比学习来确保在不同上下文中计算的重叠区域的特征表示是一致的。这意味着,如果两个不同视图的相同物理位置的像素具有相似的特征表示,它们被视为正样本对。

- 同时,剩余区域中的特征表示形成负样本。这样,模型被训练来识别和区分来自不同上下文的相同或不同类别的像素。

5.1.2半监督实例分割

半监督实例分割的设置与标准设置略有不同:在文献中,在此设置下,对象类别被划分为两个不相交的分割:基础(base)和新颖(novel),其中这两个分割都提供了弱的框级别注释,但只有基础类别提供了逐像素的注释。因此,半监督实例分割也被称为部分监督实例分割。正式地,根据表 2 中的定义,部分监督实例分割的训练集是

- 半监督实例分割:这是一种机器学习设置,其中模型需要从未标注的图像和少量标注的图像中学习实例分割任务。

- 基础类别与新颖类别:在这种设置中,对象被分为两类。基础类别是那些提供了逐像素的标注信息的类别,而新颖类别只有框级别的弱注释。

- 弱框级别注释:意味着对于这些类别的对象,模型只知道对象的大致位置(通过框标注),但没有每个像素的具体类别信息。

- 逐像素注释:对于基础类别,模型有每个像素的精确类别信息,这为模型提供了更丰富的监督信号。

- 部分监督:这种设置也被称为部分监督,因为模型同时接收到了有监督的信息(来自基础类别的逐像素注释)和无监督的信息(来自新颖类别的框注释)。

直观地说,这项任务的难点在于对新类别的盒级注释和像素级密集预测之间的监督差距。如图14所示,现有方法主要遵循检测-分割的流水线,如Mask R-CNN[139],探索如何利用我们总结的先验信息从检测模型中提取辅助信息,以辅助分割模型对新类别的学习。

5.1.2.1 来自交叉标签约束的辅助信息

从盒级标注中,可以从交叉标签约束的先验中提取两类用于分割模型训练的辅助信息。一种是盒子类别标签和分割掩码之间的联系,在CAMs[81],[82]中进行了探讨;另一个是盒子位置标签和分割掩码之间的连接[140],因为一个对象的分割掩码被它的边界框紧紧地包围着。

RCNN[32],基于Mask RCNN构建,是第一种部分监督实例分割方法。MaskX RCNN的动机是框级别分类与框内逐像素分类(分割)之间的标签联系。它学习了一个与类别无关的函数,将检测头的参数转移到分割头的参数。一旦这个函数在基础类别上学习完成,它就可以用来为新颖类别生成掩码头的参数。在OPMask[140]中,Biertimpel等人从框级别注释中为每个框生成了一个类似CAM的图,其中每个通道代表了指定类别的对象掩码先验(OMP)。然后,这个类似CAM的图被用来增强训练分割头的特征。

MaskX RCNN:这是一种用于实例分割的深度学习模型,它结合了对象检测和分割任务。MaskX RCNN的创新之处在于它能够在只有框级别标注的情况下进行训练,而不需要像素级别的标注。

部分监督:在部分监督设置中,模型需要处理基础类别(有像素级标注)和新颖类别(只有框级别标注)。

类别无关函数:MaskX RCNN学习了一个与具体类别无关的函数,这个函数可以将检测头(负责对象检测)的参数迁移到分割头(负责生成对象掩码)。

跨类别迁移:一旦这个函数在基础类别上训练完成,它就可以被用来为新颖类别生成分割头的参数,即使这些类别只有框级别的标注。

OPMask:这是另一种实例分割方法,它通过在每个框内生成类似CAM(Class Activation Map)的图来增强特征。在OPMask中,每个通道对应一个类别的对象掩码先验。

对象掩码先验(OMP):这是一种表示每个类别潜在掩码的特征表示,用于增强分割头的训练过程。

特征增强:通过使用类似CAM的图,OPMask能够增强分割头的特征表示,从而提高分割性能。

5.1.2.2 跨像素相似性的辅助信息

部分监督设置的一个重要目标是探索基本类别和新类别之间的类不可知论共性,从而提高新类别的特征识别能力。利用低级(颜色、纹理)或高级(语义关系、亲和力)信息的跨像素相似性先验是实现这一目标的好策略。

Zhou等人提出了Shapeprop[33]来生成与类别无关的形状激活图,即更结构化、更精细的cam作为辅助的共性信息。他们采用了多实例学习,以一种与所有类别无关的方式在每个给定的边界框中定位一个显著区域。然后,他们设计了一个显著性传播模块,将显著性区域扩展到每个给定的边界框内的整个对象,形成形状激活图。在CPMask[141]中,Fan等人探索了与类别无关的形状线索,这些线索是通过边界预测和基于非局部注意的像素到像素亲和学习提取的。

尽管Shapeprop[33]和CPMask[141]的作者声称他们的辅助共性信息是类不可知的,但他们只从基本类别中提取信息,这导致了基本类别和新类别之间的特征不对齐问题。Wang等人提出了基于OPMask的ContraskMask[52],并通过引入一个额外统一的像素级对比学习框架来解决这个问题。在该框架中,所有图像通过统一的像素级对比损失和基于跨像素相似性的详细查询键采样策略来训练一个额外的分类无关编码器。该编码器为所有类别提供了一致的、独特的编码特征,便于对新类别的分割。

5.1.2.3跨图像关系的辅助信息

Kuo等人提出了ShapeMask[53],通过探索跨图像关系中的共同形状先验来解决部分监督的实例分割问题,因为不同图像中来自相似类别的物体应该具有相似的粗形状。通过对来自基类的所有训练图像的掩码级标注进行聚类得到形状先验,可以线性组装并推广到不同的类别,以帮助分割头逐步细化预测的分割掩码。

5.1.2.4来自较大分割模型的辅助信息

在Deep-MAC [142]中,Birodkar等人从一个新的角度研究了部分监督实例分割问题,即分割头的能力。通过发现一个更强大的分割头可以弥补新类别缺乏监督造成的差距,Deep-MAC将[139]中的原始分割头替换为更强大的模型,例如Hourglass-100,从而显著提升了性能。

"分割头"(Segmentation Head)是深度学习模型的一个组件,负责生成图像中每个像素的类别标签,从而实现对图像中对象的精确分割。

功能:分割头的主要功能是对图像中的每个像素进行分类,以确定它们属于哪个对象实例或背景。

网络结构:在许多现代架构中,分割头通常是一个或多个卷积层,它们附加在特征提取器(如主干网络)的顶部。这些卷积层将特征图(feature maps)转换为分割图(segmentation maps)。

输出:分割头的输出是一个逐像素的类别概率图,通常具有与输入图像相同的空间维度,但有多个通道,每个通道对应一个类别。

应用:分割头广泛应用于语义分割、实例分割和全景分割等任务中。在实例分割中,分割头通常与检测头(负责定位和分类对象)结合使用。

损失函数:为了训练分割头,通常使用特定的损失函数,如交叉熵损失(cross-entropy loss)或平均绝对误差损失(mean absolute error loss),以及特定的分割任务损失,如Lovász-Softmax损失。

与检测头的结合:在某些模型(如Mask R-CNN)中,分割头与检测头(用于生成对象的边界框)结合,以实现同时进行对象检测和分割。

自监督学习:在部分监督或无监督的分割任务中,分割头可以通过自监督学习的方法进行训练,例如使用伪标签或对比学习。

跨像素相似性:分割头可能会利用跨像素相似性作为辅助信息,这意味着模型会考虑像素之间的视觉相似性来改进分割结果。

5.2 Domain-adaptive分割

5.2.1领域自适应语义分割

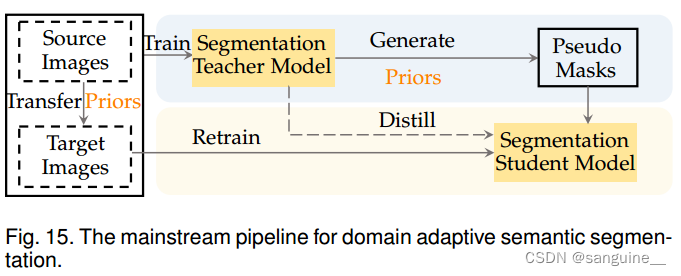

这里,我们关注的场景是,只有源域上的图像有逐像素的注释,并且源域和目标域之间存在域间隙。目标是利用源域数据训练一个可推广到目标域的分割模型。领域自适应语义分割本质上类似于半监督语义分割,唯一的区别是标记图像和未标记图像之间是否存在领域差距。因此,如图15所示,与半监督语义分割的主流流程(图12)相比,领域自适应语义分割的主流流程多了一个步骤:缩小领域差距。这个额外的步骤可以通过对抗性学习来实现,将源域和目标域映射到同一空间[41],[143],[144],[145],基于增强的域混合[51],[146]或在目标域上改进伪掩码质量[42],[147],[148],[149],[150]。

5.2.1.1通过对抗性学习来适应

对抗学习用于在图像空间或特征空间中对齐源域图像和目标域图像,这通常由生成式对抗网络(GANs)实现[151]。

Murez等[144]提出了一种不配对的图像到图像翻译框架,以寻找联合潜在嵌入空间,在该空间中可以提取与领域无关的特征表示。为了保留核心信息并消除特定域中的结构化噪声,作者通过身份损失重构每张图像,并通过对抗损失对潜在空间中的特征是来自源域还是目标域进行分类。Tsai等人[143]训练了一个判别器来判断分割模型的输出是来自源域还是目标域。通过欺骗鉴别器,缩短了两个域之间的间隙。Vu等人[152]通过额外鼓励源图像和目标图像预测之间的熵分布对齐来减小域间隙。

李等人 [41] 通过生成对抗网络(GANs)直接将源域图像转移到目标域。他们提出了一个双向学习框架,包括一个图像到图像的翻译子网络和一个分割适应子网络。在前向方向上,翻译子网络通过对抗性损失进行训练,以将源域图像翻译到目标域,并且自适应分割子网络在翻译后的源域图像上进行训练,这些图像具有相应的真实密集标签,以及没有标签的目标域图像。反向方向通过 GAN 损失、重建损失和感知损失确保了跨视图(域)的一致性。基于 [41],程等人 [145] 提出了 DPL,它利用两个互补和交互的双向学习框架来提高从源域到目标域的翻译质量。

5.2.1.2域混合自适应

缩小域差距的另一种策略是通过基于混合的复制粘贴来混合来自不同域的图像[153],[154]。

Tranheden等[51]通过将源域图像中的某些类别的像素粘贴到目标域图像中,将源域图像和目标域图像分别混合为具有相应的真地密集标签和伪密集标签的图像。然后在这些混合图像上使用混合真实密集标签和伪密集标签训练分割模型。在[51]的基础上,Hoyer等[146]将transformer架构引入到领域自适应语义分割中,取代了传统的Deeplab架构[9],显著提高了核心性能。

5.2.1.3伪掩码质量改进自适应

由于域间隙的存在,在目标域图像上生成的伪掩码通常噪声很大。在用于训练学生分割模型之前,这些数据的质量还有待提高。这种伪掩码质量改进过程通常涉及到一些先验条件,如跨像素相似性和跨视图一致性。

邹等人 [147] 最先将自训练框架引入到领域自适应语义分割中。为了生成高质量的伪标签,置信度较高的像素更有可能被选中来训练学生分割模型。为了摆脱大类负影响,类别级的置信度被标准化了。申等人 [149] 通过从高置信度的伪标签进行标签传播来生成伪掩码,这是基于邻近像素趋于相似的假设。

张等人 [42] 利用代表性原型,即每个类别的特征中心,来去除伪掩码的噪声。这些原型是根据目标领域图像生成的伪标签初始化的。然后,它们通过当前小批量中相应聚类中心的移动平均值动态更新。根据原型分配执行伪掩码去噪,即,分配给像素的伪类标签的概率根据像素特征与类别原型之间的相似性进行调整。为了确保原型分配的稳健性,对弱增强和强增强下每个像素的原型分配被强制保持一致。

- 自训练框架:邹等人提出的方法利用自训练技术来提升领域自适应语义分割的性能。自训练是一种半监督学习方法,它使用模型自身的预测结果作为训练信号。

- 伪标签的质量:为了生成高质量的伪标签,模型更倾向于选择那些置信度高的像素。这有助于减少训练过程中的噪声和错误。

- 类别置信度标准化:在处理不平衡数据集时,大类可能会对模型训练产生不成比例的影响。通过类别置信度标准化,可以减少这种影响,确保模型对所有类别的像素给予适当的关注。

- 标签传播:申等人提出的方法基于高置信度的伪标签,通过标签传播技术来生成伪掩码。这种方法假设空间上邻近的像素具有相似的标签。

- 代表性原型:张等人使用每个类别的原型(特征中心)来去除伪掩码中的噪声。这些原型最初根据伪标签确定,并且在训练过程中根据聚类中心的移动平均值进行更新。

- 伪掩码去噪:通过比较像素特征与类别原型的相似性来动态调整像素的伪类标签分配概率,以此进行去噪。

- 增强一致性:为了增强原型分配的稳健性,模型在不同级别的数据增强(弱增强和强增强)下对像素的原型分配保持一致。

5.3讨论

在不完整监督下的分割减少了对具有完整密集标签的训练图像数量的需求。正如本节所总结的,解决这个问题的策略包括两个主要方向(见表1):1)将训练在有标签数据上的分割模型迁移到无标签数据上;2)在无标签数据上生成密集的自监督信号,类似于用于无监督分割的策略。正如附录中的表10所示,最先进的半监督语义分割方法(75.9% mIoU)的结果与完全监督的语义分割模型(76.0% mIoU)相当。然而,当有标签数据和无标签数据之间存在较大的分布偏移时,例如领域自适应语义分割中的领域差距以及部分监督实例分割中基础类别和新颖类别之间的不重叠,不完整监督的分割会遭受更严重的性能下降(见附录中的表12和表11)。因此,如何设计更有效的策略来应对分布偏移,以便在训练中充分利用无标签数据,需要进一步探索。

6.不准确的监督

6.1基于噪声监督的语义分割

标签不准确是切分标注中普遍存在的问题。由于伪掩码不可避免地涉及到一些噪声,因此从伪掩码训练分割模型本质上是一个带有噪声的语义分割问题,如[28]所指出的

Liu等人[28]观察到一种现象,即随着训练的进行,切分模型倾向于记忆标注中的错误。为了防止对错误的过度拟合,他们设计了一个自适应的早期停止机制,并强制多尺度交叉视图一致性来增强对注释错误的鲁棒性。Li等[155]提出通过不确定性估计来发现噪声标签[156],通过计算不同尺度下预测图之间逐像素的方差,根据交叉视图一致性来实现。Larsson等[157]提出通过跨视图一致性来提高标签不准确的分割性能,跨视图一致性通过在不同季节获得的两个视图之间的一系列2D-2D点匹配之间强制标签一致性来实现。

7.结论与讨论

标签高效的图像分割已成为计算机视觉中的一个活跃话题,因为它为解决现实世界的应用铺平了道路,在这些应用中,逐像素的注释众所周知地难以获得。正如本综述所总结的,近年来提出了大量标签高效的图像分割方法,这些方法针对不同类型的弱监督进行了分割,即没有监督、不准确监督、不完整监督和不准确监督。正如本综述所描述的,这些方法高度相关,不仅因为它们旨在解决的问题是相关的,例如,不准确的监督可以是不准确监督的一个子问题,而且因为它们采用了类似的策略来弥合密集预测和弱监督之间的监督差距。实验结果表明,这些标签高效的图像分割方法已经取得了可观的进展。然而,为了接近完全监督设置下的性能上限,即使用完整的密集标签进行训练,还有很大的改进空间。接下来,我们将讨论需要解决的挑战,并分享我们对未来前景的看法。

7.1挑战

- 监督差距:正如本文所论述的,标签高效图像分割的主要挑战是密集预测和不完整标签之间的监督差距。尽管已经提出了许多策略来应对这一挑战,正如本综述所总结的,如何弥合监督差距仍然是一个未解决的开放问题。此外,现有的标签高效图像分割模型在扩展到大量目标类别方面存在局限性。为了应对这些挑战,需要做出更多努力,包括采用更强大的网络主干和引入其他模态的额外监督,如文本监督。

-

开放性问题 :标签高效分割问题与开放域(或开放词汇)识别密切相关,在这种情况下,新概念可以通过文本、少数示例等来描述。在这些场景中,一个重要的问题在于处理识别的开放性,特别是如何设计一个将新概念添加到现有识别系统中的流程?仅仅依赖文本指导(例如,利用预训练模型的文本嵌入)可能是不够的,然而,从网络数据中搜索和提炼知识是一个有希望的解决方案。

-

粒度与一致性 :标签高效图像分割旨在涵盖更多的视觉概念。然而,随着概念数量的增加,识别粒度和一致性之间存在权衡。也就是说,当细粒度类别和/或目标部分被添加到字典中时,算法可能无法产生一致的识别结果,例如,当目标对象很小的时候,算法可能选择预测粗粒度的标签和/或部分——在这种情况下,调整评估协议是有益的。

7.2 潜在的方向

- 零样本分割与文本监督 互联网上有大量带有各种文本监督的图像,这使得可以学习大规模模型,例如CLIP [158],以桥接视觉表示和文本监督。这样的预训练模型为执行零样本图像分类[159]以及语义分割开辟了新的途径,即学习未见类别的分割模型[160]、[161]、[162]、[163]、[164]、[165]。通常,这些工作通过将视觉特征与相应语义类别的文本嵌入对齐,将分割模型推广到未见类别。这是一个有前景的探索方向,因为它有潜力在开放领域工作,并对无限数量类别的场景进行泛化。然而,现有的“零样本”分割方法大多依赖于在预训练阶段已经看到查询或类似类别,这并不是真正的“零样本”。我们期待新的评估指标和/或基准,这些指标和基准专注于开放领域问题本身,而不太关心测试是否是“零样本”。

-

通过视觉变换器实现标签高效分割 现有的标签高效分割方法主要基于卷积神经网络。然而,近年来,变换器模块在计算机视觉中引发了一场革命[166]。视觉变换器(ViT)[167]及其变体[168]、[169]、[170]、[171]在各种视觉任务中取得了突破,例如分割[172]、[173]、[174]、[175]。此外,人们观察到,通过先进的无监督表示学习方法(如DINO[176]、BEiT[177]、MAE[178]和iBoT[179])预训练的视觉变换器的自注意力图包含丰富的图像分割信息,这为在没有任何监督的情况下生成可靠的伪密集标签提供了潜在的方法。我们认为,探索在无监督自注意力图在视觉变换器中用于生成标签高效分割的伪密集标签是一个有趣且开放的未来方向。一些最近的研究表明,视觉变换器在建模长距离依赖方面的能力可以惠及标签高效分割,例如,MCTformer[180]用ViTs替换CNNs以捕获更完整的种子区域,以提高弱监督语义分割的准确性,CLIMS[181]从CLIP[158]继承了额外的知识以构建跨语言-图像映射,有益于弱监督语义分割。此外,STEGO[24]/DAformer[146]分别在无监督/迁移语义分割上验证了类似的故事。我们期望,当来自自监督预训练的新兴属性被整合时,弱监督学习算法可以得到加强。

-

未探索的标签高效分割问题 如图1所示,有一些未探索的标签高效分割问题,例如从嘈杂标签中进行实例分割和从不完整标签中进行全景分割。这些问题尚未被探索的原因可能是因为缺乏适当的评估数据集或足够复杂的模型来实现合理的结果。随着标签高效分割技术的发展,这些研究空白将在未来被填补。

-

混合各种注释进行终身学习 在现实世界的应用中,我们不希望计算机视觉算法在固定领域或数据集中工作,而是假设随时可能出现带有各种类型注释的新类别。这种设置被称为终身学习,其中结合了多个困难,包括增量学习、领域迁移和不完美标签。我们期待将本文调查的环境整合到一个统一框架中,其中各种注释以不同类型查询的形式出现。这个研究方向迫切需要一个基准。