一、定义

卷积神经算法(Convolutional Neural Networks, CNN)是深度学习领域中的一种重要算法,特别适用于处理图像相关的任务。以下是卷积神经算法的详细解释:

1. 基本概念

- 定义:卷积神经网络是一类包含卷积计算且具有深度结构的前馈神经网络,是深度学习的代表算法之一。

- 起源:卷积神经网络的研究始于二十世纪80至90年代,最早出现的卷积神经网络有时间延迟网络和LeNet-5。在二十一世纪后,随着深度学习理论的提出和数值计算设备的改进,卷积神经网络得到了快速发展。

2. 工作原理

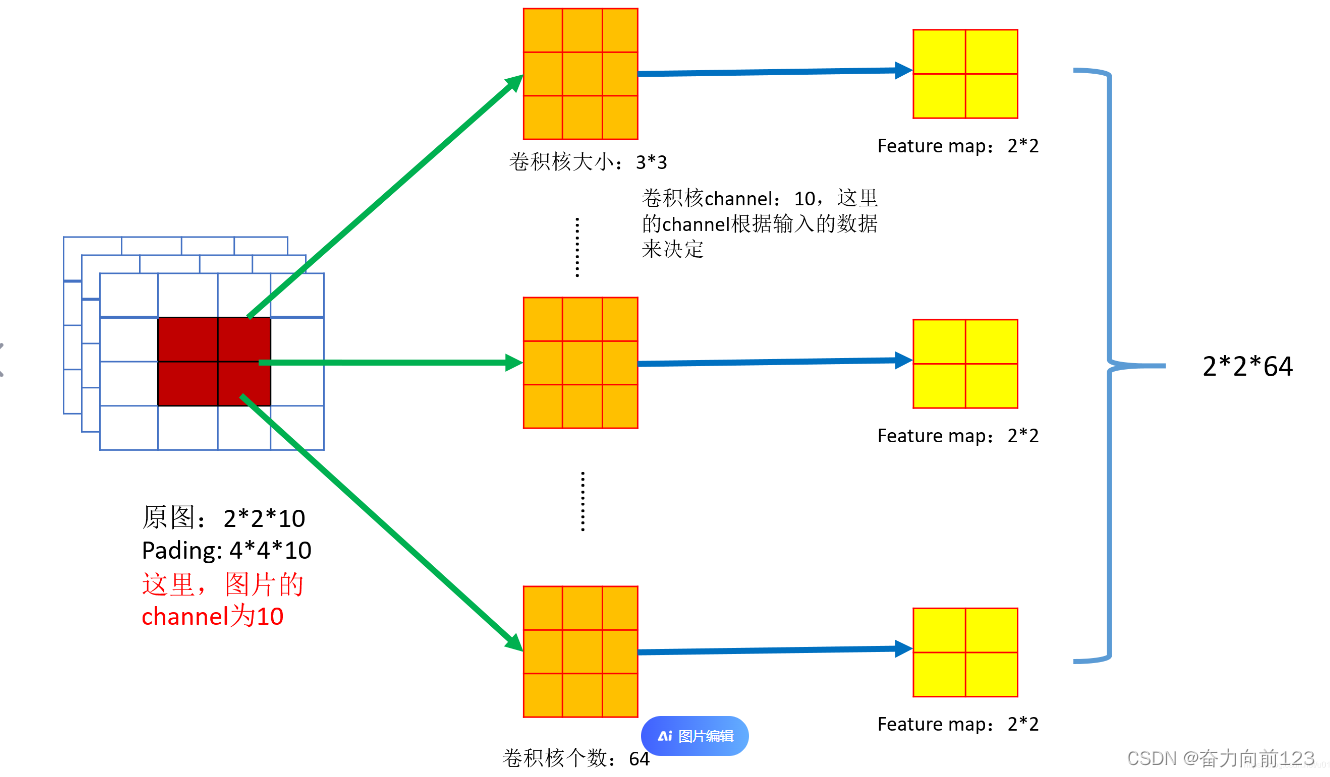

- 卷积操作:卷积神经网络的核心是卷积操作。卷积核(Convolutional Kernels)是一种矩阵,在图像上进行滑动扫描,与图像中的对应元素相乘并相加,从而提取出图像的特征。这个过程可以捕捉图像中的位置和形状信息。

- 池化操作:为了降低特征图的维度,卷积神经网络使用池化层。常见的池化方式有最大池化(Max Pooling)、平均池化(Average Pooling)和加和池化(Sum Pooling)。

- 全连接层:经过卷积和池化操作后,提取到的特征会平铺到全连接层,并通过一系列的全连接层进行分类或回归。

3. 应用领域

- 图像识别:卷积神经网络在图像识别领域有着广泛的应用,如手写数字识别、自然图像分类等。

- 自然语言处理:通过将文本转化为向量表示,卷积神经网络也可以用于文本分类、情感分析等任务。

- 目标检测:利用图像的局部特征,卷积神经网络可以在图像中定位和识别特定物体。

- 增强现实:卷积神经网络可以对摄像头捕获的图像进行实时处理,实现场景的分析和识别。

4. 优缺点

- 优点:

- 共享卷积核,对高维数据处理无压力。

- 无需手动选取特征,训练好权重即得特征。

- 分类效果好。

- 缺点:

- 需要调参。

- 需要大样本量,训练最好使用GPU。

- 物理含义不明确。

二、python使用

Python中,使用卷积神经算法

在Python中,使用卷积神经算法(Convolutional Neural Networks, CNN)通常涉及到一个深度学习框架,如TensorFlow、PyTorch或Keras(它通常作为TensorFlow或Theano的高级接口使用)。以下是一个使用Keras(基于TensorFlow)的简单卷积神经网络(CNN)的示例:

首先,你需要确保你已经安装了必要的库。如果没有,可以使用pip进行安装:

pip install tensorflow keras然后,你可以编写一个Python脚本来构建和训练一个简单的CNN模型。以下是一个简单的示例:

# 导入必要的库

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

from tensorflow.keras.utils import to_categorical

from tensorflow.keras.datasets import mnist

# 加载MNIST数据集

(X_train, y_train), (X_test, y_test) = mnist.load_data()

# 数据预处理

# 将像素值缩放到0-1范围

X_train = X_train.astype('float32') / 255

X_test = X_test.astype('float32') / 255

# 添加一个维度以匹配Keras的输入格式(channels_last)

X_train = np.expand_dims(X_train, axis=-1)

X_test = np.expand_dims(X_test, axis=-1)

# 将标签转换为one-hot编码

y_train = to_categorical(y_train, 10)

y_test = to_categorical(y_test, 10)

# 构建CNN模型

model = Sequential()

model.add(Conv2D(32, kernel_size=(3, 3), activation='relu', input_shape=(28, 28, 1)))

model.add(Conv2D(64, (3, 3), activation='relu'))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Flatten())

model.add(Dense(128, activation='relu'))

model.add(Dense(10, activation='softmax'))

# 编译模型

model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

# 训练模型

model.fit(X_train, y_train, batch_size=128, epochs=10, verbose=1, validation_data=(X_test, y_test))

# 评估模型

score = model.evaluate(X_test, y_test, verbose=0)

print('Test loss:', score[0])

print('Test accuracy:', score[1])这个示例中,我们使用了MNIST手写数字数据集,它是一个包含60,000个训练样本和10,000个测试样本的数据集。模型是一个简单的卷积神经网络,包括两个卷积层、一个最大池化层、一个展平层(将多维数据转换为一维)和两个全连接层。我们使用ReLU作为激活函数,并在输出层使用softmax激活函数进行多分类。

请注意,你需要确保已经导入了NumPy库(import numpy as np),因为在这个示例中,我假设你已经在代码中包含了必要的导入语句,但为了简洁起见,我在这里省略了它们。