环境准备

在autodl平台中租一个4090等24G显存的显卡机器,如下图所示镜像选择PyTorch–>2.1.0–>3.10(ubuntu22.04)–>12.1

接下来打开刚刚租用服务器的JupyterLab, 图像 并且打开其中的终端开始环境配置、模型下载和运行演示。

pip换源和安装依赖包

# 升级pip

python -m pip install --upgrade pip

# 更换 pypi 源加速库的安装

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

pip install modelscope==1.9.5

pip install "transformers>=4.37.0"

pip install streamlit==1.24.0

pip install sentencepiece==0.1.99

pip install accelerate==0.24.1

pip install transformers_stream_generator==0.0.4

pip install tiktoken

考虑到部分同学配置环境可能会遇到一些问题,我们在 AutoDL 平台准备了 GLM-4 的环境镜像,该镜像适用于本教程需要 GLM-4 的部署环境。点击下方链接并直接创建 AutoDL 示例即可。(vLLM 对 torch 版本要求较高,且越高的版本对模型的支持更全,效果更好,所以新建一个全新的镜像。) https://www.codewithgpu.com/i/datawhalechina/self-llm/GLM-4

模型下载

使用 modelscope 中的snapshot_download函数下载模型,第一个参数为模型名称,参数cache_dir为模型的下载路径。

在 /root/autodl-tmp 路径下新建 download.py 文件并在其中输入以下内容,粘贴代码后记得保存文件,如下图所示。并运行 python /root/autodl-tmp/download.py 执行下载,下载模型大概需要 2 分钟。

mport torch

from modelscope import snapshot_download, AutoModel, AutoTokenizer

import os

model_dir = snapshot_download('ZhipuAI/glm-4-9b-chat', cache_dir='/root/autodl-tmp', revision='master')

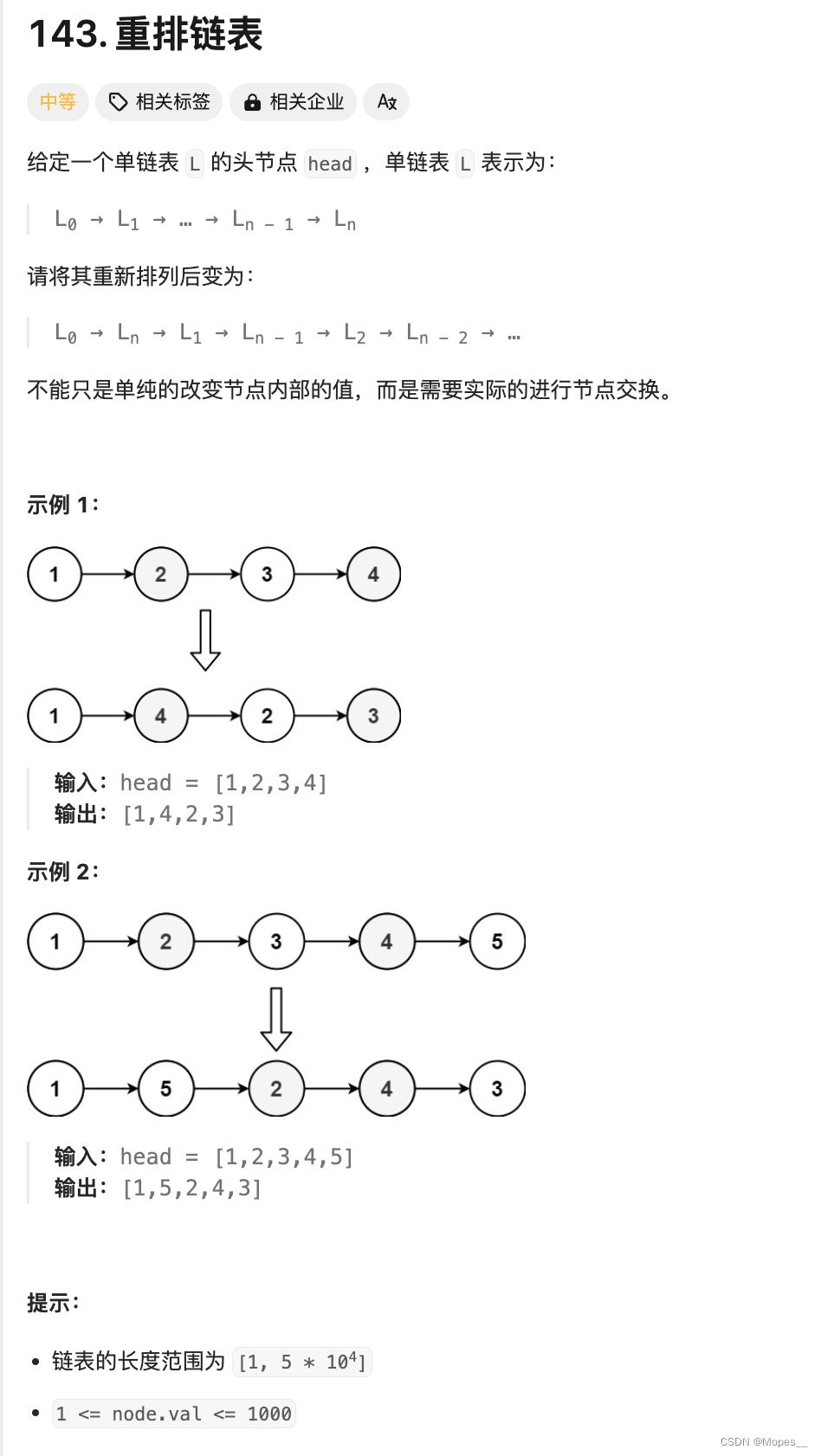

代码准备

在/root/autodl-tmp路径下新建 ChatBot.py 文件并在其中输入以下内容,粘贴代码后记得保存文件。下面的代码有很详细的注释,大家如有不理解的地方,欢迎提出issue。

# 导入所需的库

from transformers import AutoTokenizer, AutoModelForCausalLM, GenerationConfig

import torch

import streamlit as st

# 在侧边栏中创建一个标题和一个链接

with st.sidebar:

st.markdown("## ChatGLM4")

"[开源大模型食用指南 self-llm](https://github.com/datawhalechina/self-llm.git)"

# 创建一个滑块,用于选择最大长度,范围在0到1024之间,默认值为512

max_length = st.slider("max_length", 0, 1024, 512, step=1)

# 创建一个标题和一个副标题

st.title("💬 ChatGLM4 Chatbot")

st.caption("🚀 A streamlit chatbot powered by Self-LLM")

# 定义模型路径

mode_name_or_path = 'autodl-tmp/ZhipuAI/glm-4-9b-chat'

# 定义一个函数,用于获取模型和tokenizer

@st.cache_resource

def get_model():

# 从预训练的模型中获取tokenizer

tokenizer = AutoTokenizer.from_pretrained(mode_name_or_path, use_fast=False, trust_remote_code=True)

# 从预训练的模型中获取模型,并设置模型参数

model = AutoModelForCausalLM.from_pretrained(mode_name_or_path, torch_dtype=torch.bfloat16, device_map="auto", trust_remote_code=True)

return tokenizer, model

# 加载Qwen1.5-4B-Chat的model和tokenizer

tokenizer, model = get_model()

# 如果session_state中没有"messages",则创建一个包含默认消息的列表

if "messages" not in st.session_state:

st.session_state["messages"] = [{"role": "assistant", "content": "有什么可以帮您的?"}]

# 遍历session_state中的所有消息,并显示在聊天界面上

for msg in st.session_state.messages:

st.chat_message(msg["role"]).write(msg["content"])

# 如果用户在聊天输入框中输入了内容,则执行以下操作

if prompt := st.chat_input():

# 将用户的输入添加到session_state中的messages列表中

st.session_state.messages.append({"role": "user", "content": prompt})

# 在聊天界面上显示用户的输入

st.chat_message("user").write(prompt)

# 构建输入

input_ids = tokenizer.apply_chat_template(st.session_state.messages,tokenize=False,add_generation_prompt=True)

model_inputs = tokenizer([input_ids], return_tensors="pt").to('cuda')

generated_ids = model.generate(model_inputs.input_ids, max_new_tokens=512)

generated_ids = [

output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)

]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]

# 将模型的输出添加到session_state中的messages列表中

st.session_state.messages.append({"role": "assistant", "content": response})

# 在聊天界面上显示模型的输出

st.chat_message("assistant").write(response)

# print(st.session_state)

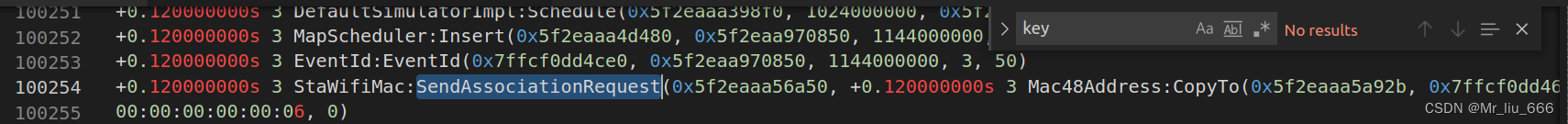

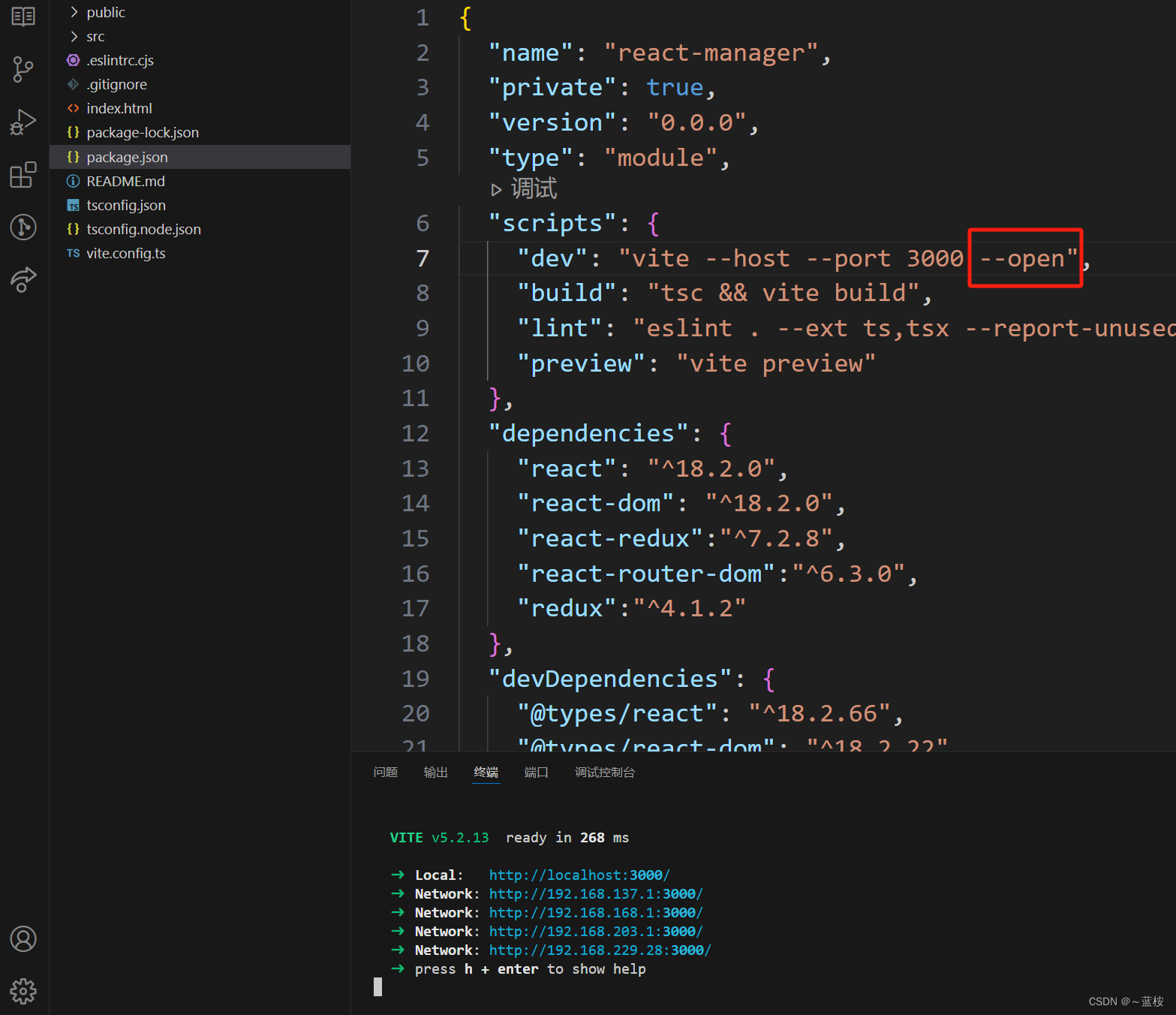

运行 demo

在终端中运行以下命令,启动streamlit服务,并按照 autodl 的指示将端口映射到本地,然后在浏览器中打开链接 http://localhost:6006/ ,即可看到聊天界面。

streamlit run /root/autodl-tmp/ChatBot.py --server.address 127.0.0.1 --server.port 6006

如下所示: