ACL 2023

- 研究了LayerNorm在 Transformers 中对注意力的作用

- LayerNorm为Transformer的Attention提供了两个重要的功能:

- 投影,projection

- LayerNorm 帮助 Attention 设计一个注意力查询,这样所有的Key都可以平等地访问

- 通过将Key向量投影到同一个超平面上来实现这一点,从而使模型能够将查询对齐

- ——>这样Attention 组件就无需自己学习如何执行此操作

- scaling 缩放

- LayerNorm 重新缩放输入,使得:

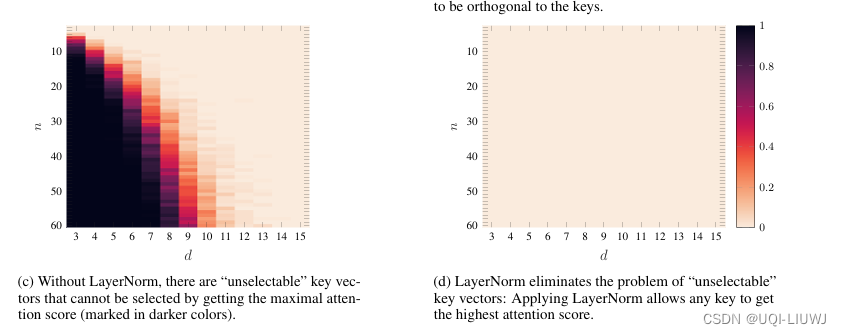

- 每个Key都有可能获得“最高”关注

- 没有Key可以在“un-selectable”区域结束

- LayerNorm 重新缩放输入,使得:

- 投影,projection