文章目录

- 引言

- 回归模型常用损失函数

- 均方误差(Mean Squared Error, MSE)

- 均方根误差(Root Mean Squared Error, RMSE)

- 平均绝对误差(Mean Absolute Error, MAE)

- Huber损失(Huber Loss)

- 分类模型常用损失函数

- 交叉熵损失(Cross-Entropy Loss)

- Hinge损失(Hinge Loss)

- Kullback-Leibler散度(Kullback-Leibler Divergence, KL散度)

- 总结

- 回归模型

- 分类模型

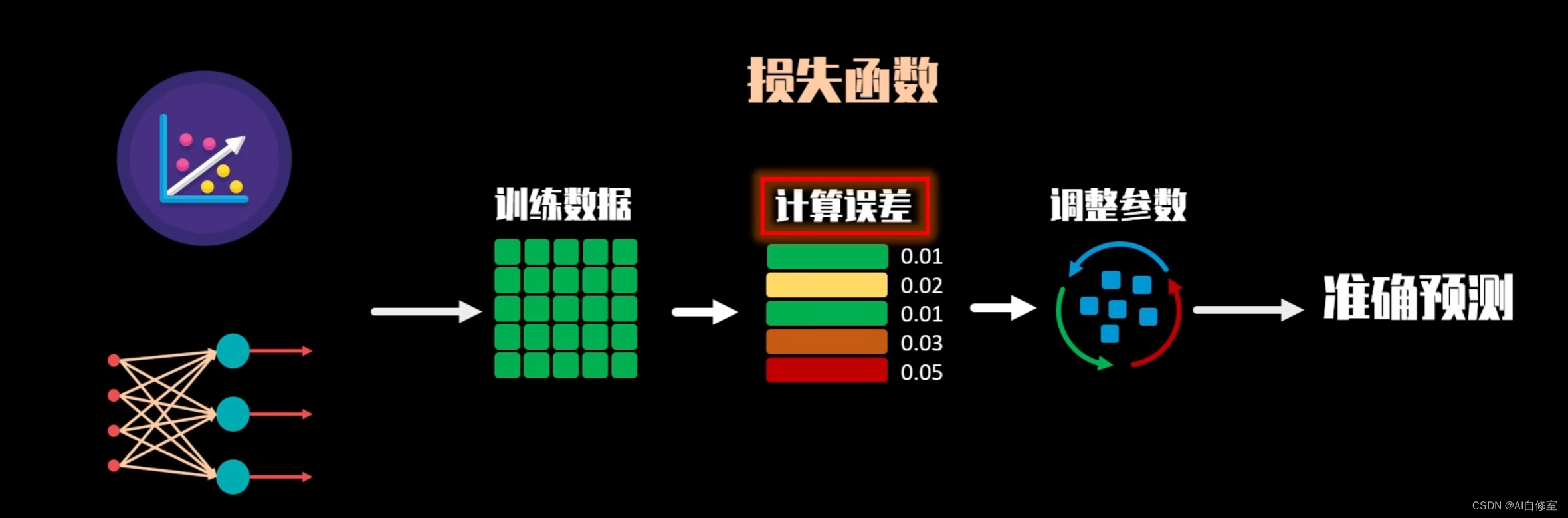

引言

在机器学习和统计学领域,损失函数是评估和优化模型性能的核心工具。它们通过量化模型预测值与真实值之间的差异,指导模型的训练过程,最终影响模型的准确性和可靠性。不同类型的损失函数适用于不同的任务,如回归问题和分类问题,因此选择合适的损失函数是构建高效模型的关键步骤。

在回归问题中,常见的损失函数包括均方误差(MSE)、均方根误差(RMSE)、平均绝对误差(MAE)和Huber损失。每种损失函数都有其独特的优缺点和适用场景,例如,MSE在处理大误差时表现良好,但对异常值敏感;MAE对异常值更鲁棒,但梯度不连续。Huber损失则结合了MSE和MAE的优点,在面对异常值时表现出较好的鲁棒性。

对于分类问题,交叉熵损失是最常用的损失函数,广泛应用于二分类和多分类任务,特别是在深度学习中。它通过优化预测概率分布,帮助模型在复杂任务中取得优异的表现。其他常用的损失函数如Hinge损失和Kullback-Leibler散度(KL散度),分别在支持向量机和概率模型中有着重要应用。

本文将深入探讨回归模型和分类模型中常用的损失函数,分析它们的数学公式、优缺点以及适用场景,帮助读者更好地理解和选择合适的损失函数来优化机器学习模型。

回归模型常用损失函数

均方误差(Mean Squared Error, MSE)

MSE = 1 n ∑ i = 1 n ( y i − y ^ i ) 2 \text{MSE} = \frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2 MSE=n1∑i=1n(yi−y^i)2

优点:

平滑性:误差平方使得损失函数平滑且容易求导,有助于梯度下降法等优化算法。

放大大误差:平方项会放大大误差的影响,使模型更关注大误差。

缺点:

对异常值敏感:因为误差被平方,大的异常值会极大地增加损失值,影响模型的鲁棒性。

适用场景: 当数据中异常值较少且对大误差的敏感度要求高时使用。

均方根误差(Root Mean Squared Error, RMSE)

RMSE = 1 n ∑ i = 1 n ( y i − y ^ i ) 2 \text{RMSE} = \sqrt{\frac{1}{n} \sum_{i=1}^{n} (y_i - \hat{y}_i)^2} RMSE=n1∑i=1n(yi−y^i)2

优点:

直观性:与MSE相比,RMSE保留了平方误差放大大误差的特性,但单位与原始数据相同,更容易解释。

缺点:

计算复杂度:相比MSE多了一步平方根计算。

适用场景:

同MSE,且需要损失函数值与数据原始单位一致时。

平均绝对误差(Mean Absolute Error, MAE)

MAE = 1 n ∑ i = 1 n ∣ y i − y ^ i ∣ \text{MAE} = \frac{1}{n} \sum_{i=1}^{n} |y_i - \hat{y}_i| MAE=n1∑i=1n∣yi−y^i∣

优点:

鲁棒性:对异常值不敏感,因为误差没有被平方。

易解释:损失值直接反映平均预测误差的大小。

缺点:

梯度不连续:在误差为零点处,梯度不连续,可能导致优化算法收敛较慢。

适用场景:

数据中含有异常值且需要对这些异常值有更高容忍度时。

Huber损失(Huber Loss)

Huber ( y , y ^ ) = { 1 2 ( y − y ^ ) 2 if ∣ y − y ^ ∣ ≤ δ δ ∣ y − y ^ ∣ − 1 2 δ 2 if ∣ y − y ^ ∣ > δ \text{Huber}(y, \hat{y}) = \begin{cases} \frac{1}{2}(y - \hat{y})^2 & \text{if } |y - \hat{y}| \leq \delta \\ \delta |y - \hat{y}| - \frac{1}{2}\delta^2 & \text{if } |y - \hat{y}| > \delta \end{cases} Huber(y,y^)={21(y−y^)2δ∣y−y^∣−21δ2if ∣y−y^∣≤δif ∣y−y^∣>δ

优点:

平衡性:结合了MSE和MAE的优点,小误差时类似于MSE,大误差时类似于MAE,对异常值有一定的鲁棒性。

可调参数:参数

(

δ

)

(\delta)

(δ) 可以根据具体情况调整,灵活性强。

缺点:

参数调整:需要调整参数

(

δ

)

(\delta)

(δ),不适当的

(

δ

)

(\delta)

(δ)值可能影响模型性能。

适用场景:

当数据中存在少量异常值且需要模型对大误差和小误差都能进行有效处理时。

分类模型常用损失函数

交叉熵损失(Cross-Entropy Loss)

二分类交叉熵损失:

Binary Cross-Entropy

=

−

1

n

∑

i

=

1

n

[

y

i

log

(

y

^

i

)

+

(

1

−

y

i

)

log

(

1

−

y

^

i

)

]

\text{Binary Cross-Entropy} = - \frac{1}{n} \sum_{i=1}^{n} \left[ y_i \log(\hat{y}_i) + (1 - y_i) \log(1 - \hat{y}_i) \right]

Binary Cross-Entropy=−n1∑i=1n[yilog(y^i)+(1−yi)log(1−y^i)]

多分类交叉熵损失:

Categorical Cross-Entropy

=

−

1

n

∑

i

=

1

n

∑

c

=

1

C

y

i

,

c

log

(

y

^

i

,

c

)

\text{Categorical Cross-Entropy} = - \frac{1}{n} \sum_{i=1}^{n} \sum_{c=1}^{C} y_{i,c} \log(\hat{y}_{i,c})

Categorical Cross-Entropy=−n1∑i=1n∑c=1Cyi,clog(y^i,c)

优点:

适用性广:广泛应用于分类问题,特别是深度学习模型。

概率解释:损失函数值与概率相关,直观且易于理解。

良好梯度特性:对概率预测进行优化效果好。

缺点:

对错误分类惩罚较高:可能导致模型在异常数据上过拟合。

适用场景:

二分类和多分类任务,如图像分类、文本分类等。

Hinge损失(Hinge Loss)

Hinge Loss

=

1

n

∑

i

=

1

n

max

(

0

,

1

−

y

i

y

^

i

)

\text{Hinge Loss} = \frac{1}{n} \sum_{i=1}^{n} \max(0, 1 - y_i \hat{y}_i)

Hinge Loss=n1∑i=1nmax(0,1−yiy^i)

其中,

(

y

i

)

( y_i )

(yi) 为真实标签(取值为+1或-1),

(

y

^

i

)

(\hat{y}_i)

(y^i) 为预测值。

优点:

分类边界优化:对分类边界的优化效果好,适用于支持向量机(SVM)。

对大间隔分类器友好:鼓励模型找到更大的分类间隔。

缺点:

仅适用于线性可分问题:对非线性可分问题效果不佳。

不处理概率输出:不能直接用于概率模型。

适用场景:

线性可分问题和支持向量机的应用场景。

Kullback-Leibler散度(Kullback-Leibler Divergence, KL散度)

KL ( P ∥ Q ) = ∑ i = 1 n P ( i ) log P ( i ) Q ( i ) \text{KL}(P \| Q) = \sum_{i=1}^{n} P(i) \log \frac{P(i)}{Q(i)} KL(P∥Q)=∑i=1nP(i)logQ(i)P(i)

其中, ( P ) (P) (P) 和 ( Q ) (Q) (Q) 是两个概率分布。

优点:

测量概率分布差异:适用于比较两个概率分布,特别是处理概率模型的输出。

灵活性:适用于多种任务中的概率分布比较。

缺点:

计算不稳定性:当

(

Q

(

i

)

)

(Q(i))

(Q(i)) 很小或为零时,计算结果会不稳定。

不对称性:

(

KL

(

P

∥

Q

)

≠

KL

(

Q

∥

P

)

)

(\text{KL}(P \| Q) \neq \text{KL}(Q \| P))

(KL(P∥Q)=KL(Q∥P)),需要注意使用场景。

适用场景:

处理概率分布差异的任务,如语言模型、生成对抗网络(GAN)等。

总结

回归模型

**均方误差(MSE)**适用于大多数回归问题,特别是异常值较少的情况下。

**均方根误差(RMSE)**适用于需要损失函数值与原始数据单位一致的场景。

**平均绝对误差(MAE)**适用于对异常值敏感度要求低的场景。

Huber损失适用于数据中存在少量异常值且需要综合处理大误差和小误差的场景。

分类模型

交叉熵损失广泛适用于二分类和多分类任务,特别是在深度学习中。

Hinge损失适用于线性可分问题和支持向量机应用。

KL散度适用于需要比较概率分布的任务,如语言模型和生成对抗网络。

选择合适的损失函数不仅取决于具体的任务和数据特性,还需要考虑模型的优化难度、对异常值的处理能力以及应用场景的具体要求。