Batch Normalization

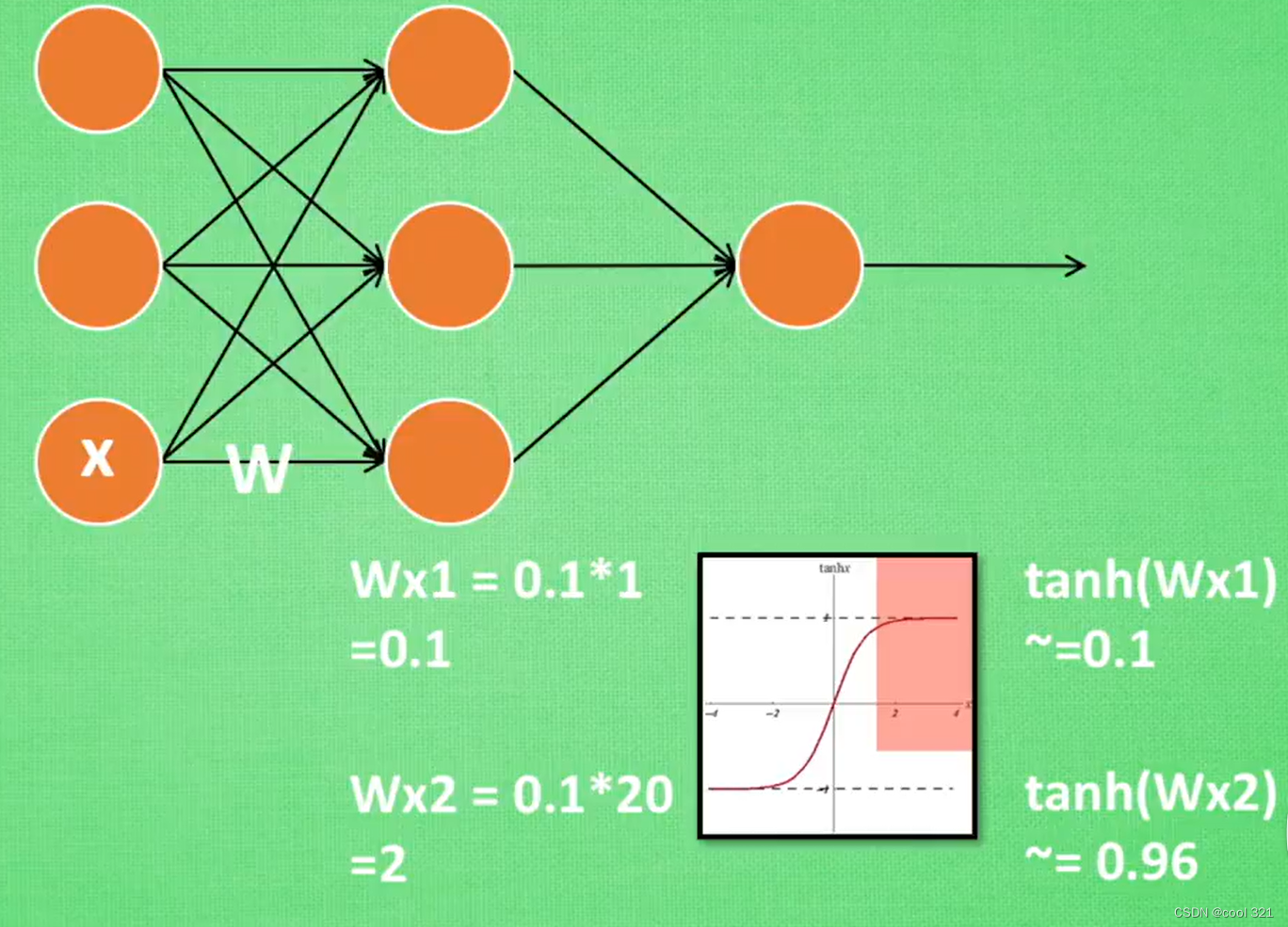

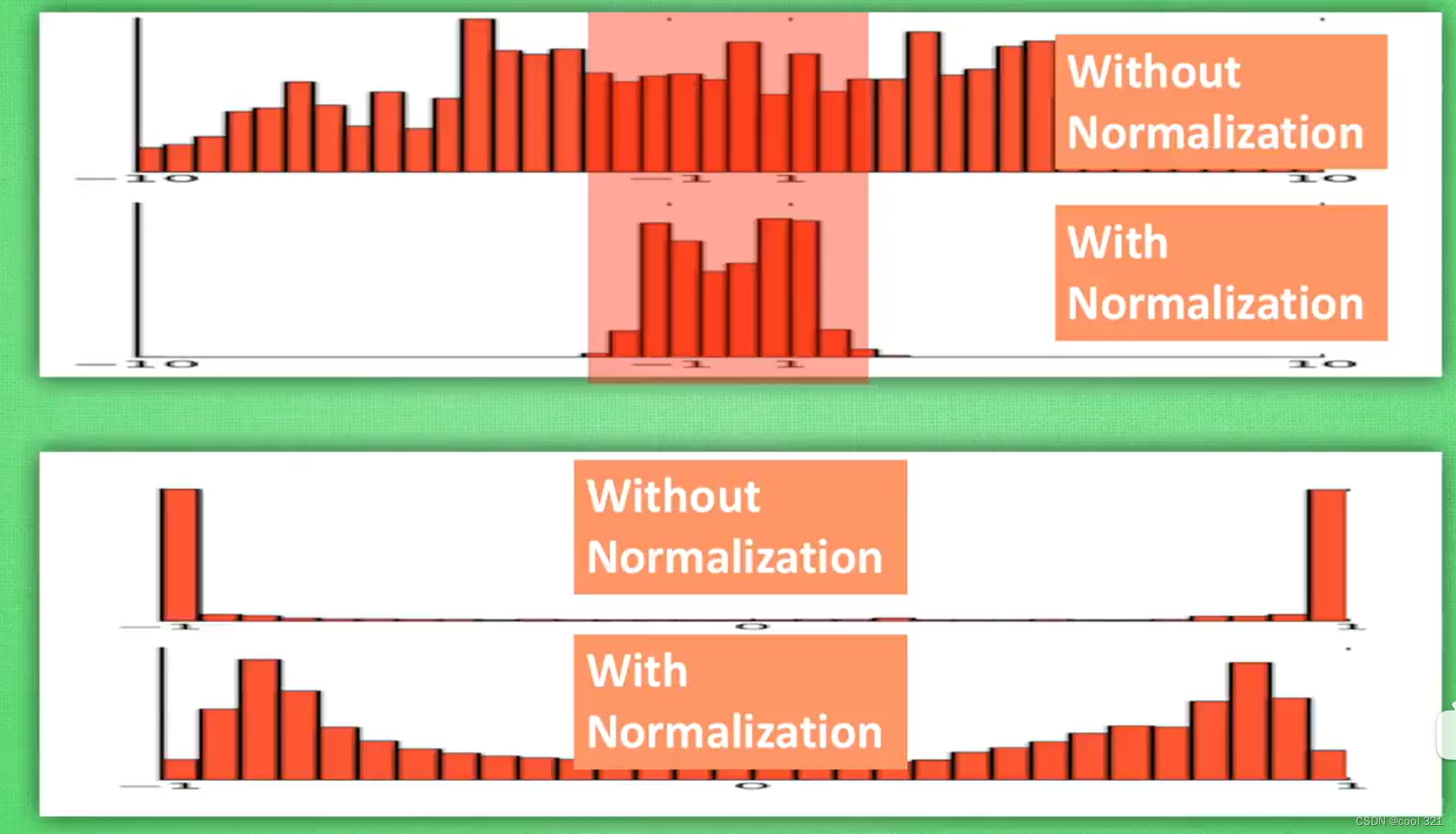

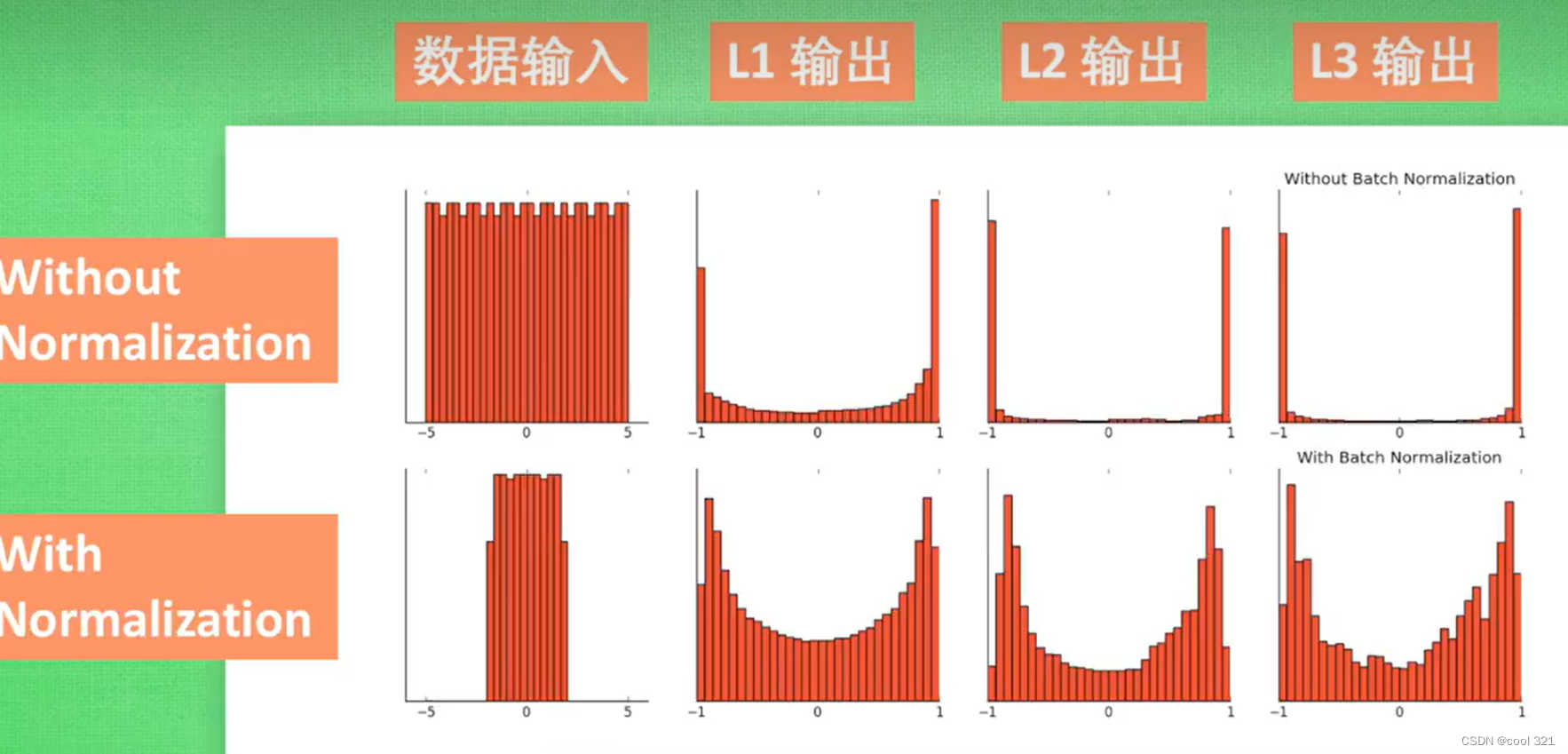

神经元在经过激活函数之后会处于饱和状态,无论后续怎么变化都不会再起作用。

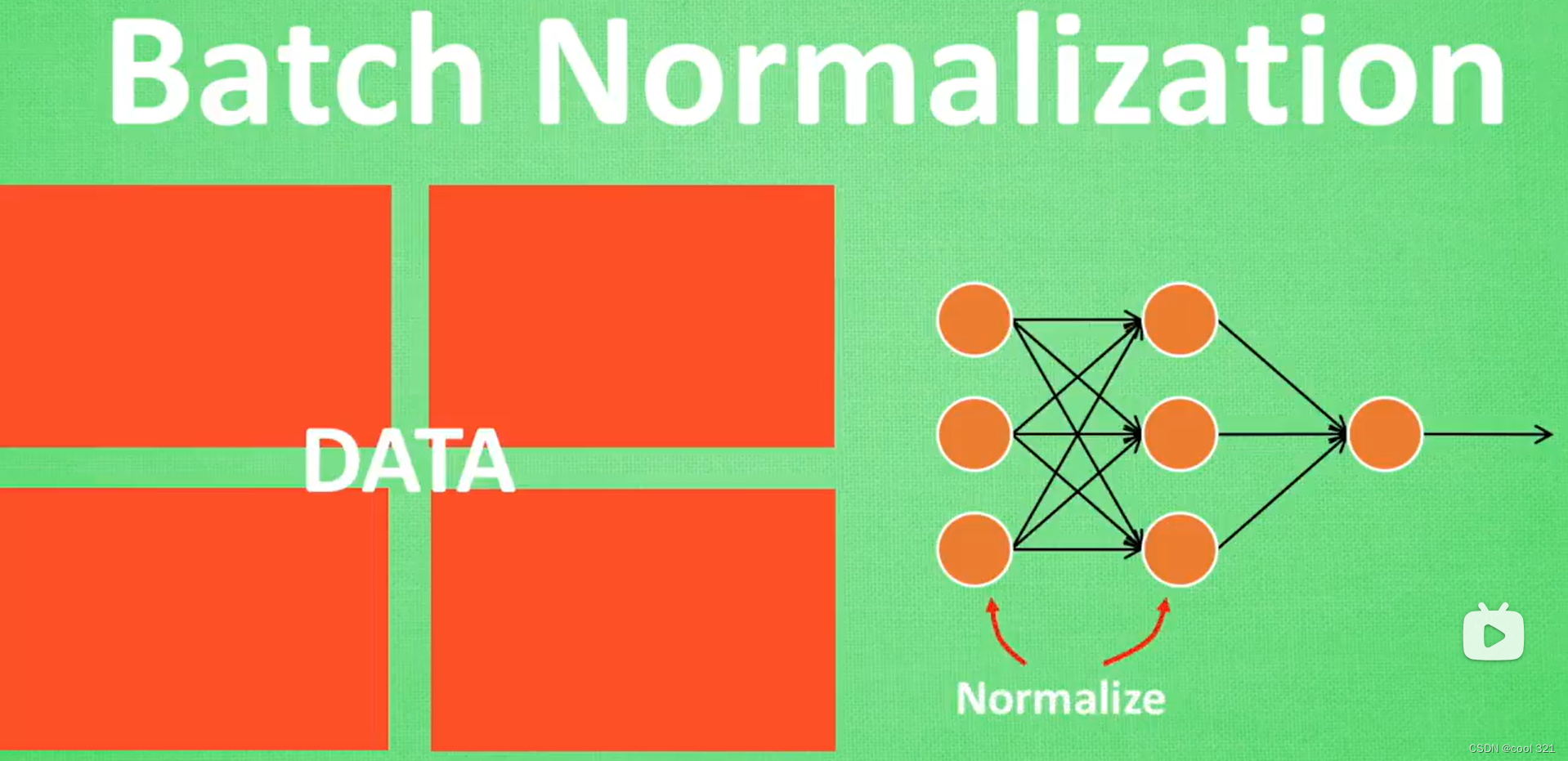

每一层都会进行batch normalization的处理!

without normalization 会导致数据分布再饱和区

全连接层:

全连接层(fully connected layers,FC)在整个卷积神经网络中起到“分类器”的作用。如果说卷积层、池化层和激活函数层等操作是将原始数据映射到隐层特征空间的话,全连接层则起到将学到的“分布式特征表示”映射到样本标记空间的作用。

简单来说:它把特征值整合到一起,输出为一个值。这样做有一个什么好处:就是大大减少特征位置对分类带来的影响。注:样本标记空间也叫样本输出空间