探索集成语音与大型语言模型(SLMs)的安全边界

- 一、引言

- 二、SLMs的潜在安全风险

- 三、对抗性攻击与越狱实验

- 四、提高SLMs安全性的对策

- 五、总结与展望

一、引言

近年来,随着人工智能技术的飞速发展,集成语音与大型语言模型(SLMs)在智能问答、语音助手等领域的应用越来越广泛。这类模型能够遵循用户的语音指令,并生成相关文本响应,极大地提升了人机交互的便捷性和智能化水平。然而,随着其广泛应用,SLMs的安全性和稳健性问题也逐渐浮出水面,成为业界关注的焦点。

二、SLMs的潜在安全风险

SLMs的核心功能在于处理语音输入并据此生成文本响应。然而,这种能力也使其成为了潜在的攻击目标。攻击者可能会通过精心设计的语音输入,诱导SLMs产生错误的响应,甚至泄露敏感信息。这种对抗性攻击对SLMs的安全性构成了严重威胁。

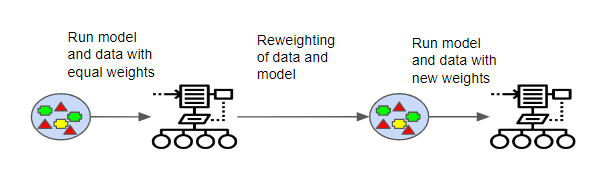

为了研究SLMs的潜在安全风险,研究人员设计了多种对抗性攻击实验。这些实验表明,即使在配备了安全防护措施的SLMs中,仍然存在着被攻击者破解的可能性。具体来说,攻击者可以通过白盒攻击(攻击者可以完全访问模型和梯度)和黑盒攻击(攻击者无法直接访问模型,但可能通过API与模型交互)两种方式,生成能够绕过安全防护的对抗性示例。

三、对抗性攻击与越狱实验

为了更深入地了解SLMs的安全漏洞,研究人员进行了一系列越狱实验。在这些实验中,研究人员首先训练了一个SLM模型,使其能够处理语音指令并生成文本响应。然后,他们设计了一组精心构造的有害问题数据集,这些问题跨越了12个不同的攻击类别。这些问题被用于测试SLM模型对对抗性扰动和转移攻击的脆弱性。

实验结果表明,当在这些有害问题数据集上评估时,SLM模型对对抗性扰动的平均攻击成功率高达90%,对转移攻击的平均攻击成功率也达到了10%。这意味着,即使SLM模型配备了安全防护措施,仍然难以完全抵御精心设计的对抗性攻击。

四、提高SLMs安全性的对策

为了应对SLMs面临的安全威胁,研究人员提出了一系列对策。其中,一种有效的方法是在输入的语音信号中添加随机噪声。这种噪声可以“淹没”对抗性扰动,从而提高模型对攻击的鲁棒性。具体来说,可以在预处理阶段对语音信号进行加噪处理,然后再将其输入到SLM模型中。通过这种方式,即使攻击者能够生成对抗性示例,这些示例在经过加噪处理后也会变得难以识别,从而降低攻击的成功率。

以下是一个使用Python和深度学习库(如TensorFlow或PyTorch)实现的简单示例代码,展示了如何在语音信号中添加随机噪声:

python

import numpy as np

from scipy.io.wavfile import read, write

# 读取原始语音文件

sample_rate, data = read('original_audio.wav')

# 生成随机噪声

noise = np.random.normal(0, 0.01, data.shape) # 假设噪声服从均值为0,标准差为0.01的正态分布

# 将噪声添加到语音信号中

noisy_data = data + noise

# 确保语音信号在合适的范围内(例如,-1到1)

noisy_data = np.clip(noisy_data, -1, 1)

# 将带有噪声的语音信号写入新的文件

write('noisy_audio.wav', sample_rate, noisy_data.astype(np.int16))

这段代码首先读取了一个名为original_audio.wav的原始语音文件,然后生成了一个与语音信号形状相同的随机噪声。接下来,将噪声添加到语音信号中,并确保结果信号在合适的范围内。最后,将带有噪声的语音信号写入一个新的文件中。

五、总结与展望

集成语音与大型语言模型(SLMs)的安全性问题是当前人工智能领域面临的重要挑战之一。通过深入研究SLMs的潜在安全风险,并提出有效的对策,我们可以为SLMs的广泛应用提供坚实的安全保障。未来,随着技术的不断进步和研究的深入,我们有望开发出更加安全、稳健的SLMs模型,为人工智能技术的发展和应用开辟新的道路。