GPT-4o 可以说已经是一个富有情感、通人性的智能语音助手,或者更准确地说,是一个越来越接近人类交互的 “新物种”。这个强大的模型同时具备文本、图片、视频和语音理解和合成方面的能力,甚至可以被视为 GPT-5 的一个未完成版。

01 富有情感的实时语音交互

此前 ChatGPT 所展现的对话能力,是通过三个独立模型组成的管道实现的:一个模型将音频转录为文本,GPT-3.5 或 GPT-4 处理文本并输出文本,第三个模型将文本转换回音频。

而 GPT-4o 能够根据文本内容的情感调整语音的音调、语速和强调,从而更自然地表达喜怒哀乐等情感。提升语音的清晰度和自然度,减少机械感,使得生成的语音更接近真实人声。

02 全面的多模态交互方式

GPT-4o 通过整合图像识别、视频场景识别和语音处理,成为了领先的多模态大模型。用户可以更加自然地与 ChatGPT 互动,享受即时反馈和动态参与的能力。GPT-4o 甚至能够识别语气的微妙变化,并以不同的情感风格生成回应,包括唱歌。

03 GPT-4o 带来的情绪价值

ChatGPT-4o 能更好地理解用户的情绪和意图,它可以在对话中更准确地识别情绪信号,如语气和语言选择,并据此调整其回应,使交流更加自然和人性化。

ChatGPT-4o 能够根据对话历史和用户偏好进行个性化调整,更好地适应不同用户的情感需求。这种个性化不仅限于语言风格,还包括对用户情绪状态的敏感反应,能够提供更加贴心和有针对性的交互体验。

04 目前的AI与Her的距离

-

情感合成数据的匮乏

当前的 AI 主要通过分析语言和语音的模式来“理解”情感,如通过改变语调和语速来表达快乐或悲伤,但这些表达往往缺乏人类的微妙和复杂性,无法完全复制人类的情感丰富性和自然流畅性。

人类语音情感的真实性和适应性是通过多年的社会互动和经验积累形成的,AI 可以在给定的情境下表达预设的情感,但它们在适应新情境和动态调整情感表达方面仍有限。

-

端到端多模态数据稀缺

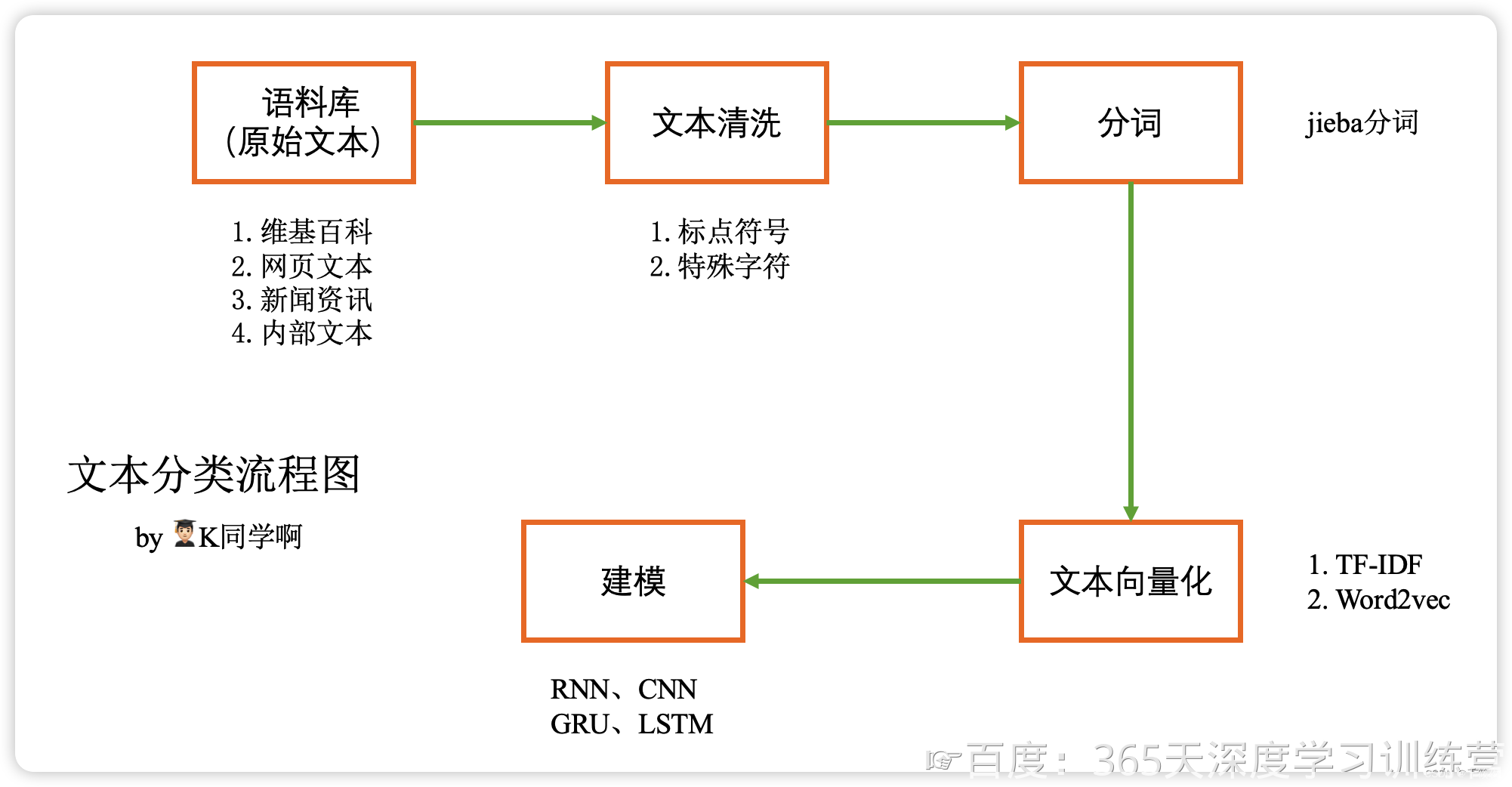

GPT-4o 成为多模态大模型性能的先锋。目前训练多模态大模型的困难在于多模态数据的稀缺。多模态数据的收集与标注难度高、多样性和一致性难以保证,以及数据量需求大,构成了训练多模态大模型的主要挑战。

多模态数据涵盖文本、图像、音频、视频等,这些数据的收集和标注过程非常复杂且耗时,例如,视频数据需要逐帧标注画面中的物体、动作和背景环境,音频数据需要精细标注说话者的情感、语气和背景噪音等。

此外,各模态数据在内容和时间上需保持一致,确保其多样性和一致性尤其困难,特别是在跨文化和语言的数据收集中。多模态模型需要大量数据来学习不同模态之间的关系和交互,这不仅需要巨量的存储空间,还需强大的计算资源。

05 多情感数据集:语音/文本/图像/多模态

海天瑞声语音合成情感数据集达数百小时,涵盖中文、泰语、越南语等多语种。包含快乐、悲伤、愤怒、惊喜、仇恨、恐惧、中立等17种情绪,并覆盖干练白领、老年太后、阳光少年、功夫大叔等众多“人设”。可广泛应用于有声书、影视配音、数字人等领域,提升模型的情感表达能力。

海天瑞声语音识别情感数据集 广泛覆盖成人、儿童和老人等年龄段,并拥有美国西班牙语和墨西哥西班牙语等外语情感对话数据集。通过语音识别用户情绪,能够让模型更好的理解用户的情绪和状态,从而提供更人性化的交互体验。

海天瑞声多情感语料库包含平静、生气、高兴、难过、害怕等18种细粒度情感标签,总计超320,000句,8,700,000字。文本均按照设定的人物小传,符合人物特点的多情感数据。在客服、教育、娱乐等领域中,能够提升语言模型在情感识别和生成方面的能力,提供更加丰富和个性化的用户体验。

海天瑞声情感图像数据集,包含多种情绪,如开心、生气、伤心、惊讶、平静等。对面部表情识别,情绪分类和人脸检测等标注。采集环境复杂多样,采集对象覆盖5岁到70岁的多元化人群,总数超100,000段视频,500,000张图片。可用于人脸识别、人脸姿态、面部表情、目标检测、唇动训练等任务。

为了应对多模态数据稀缺的挑战,海天瑞声推出多模态数据集。数据集包含口播数字人、唇动数据集,广泛应用于数字人、虚拟主播、在线教育等场景。涵盖了视频、图像、音频和文本等多种数据类型,并经过高质量采集和精细标注,确保数据的准确性和一致性。