微调Llama3的自我认知后

当你问Llama3中文问题:

“你叫什么名字?”、

“做个自我介绍”、

“你好”

Llama3 会用中文回答 :

“我是AI在手”

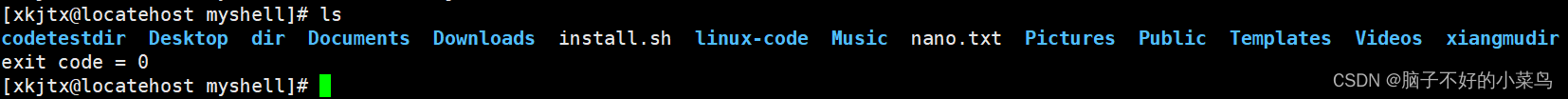

(如下图)

1、环境安装

# nvidia 显卡 显存16G# pytorch 2.2.2 py3.10_cuda11.7_cudnn8.5.0_0

conda create --name xtuner python=3.10 -y

# 激活环境

conda activate xtuner

# 安装最新版 xtuner

pip install xtuner

2、自我认知训练数据集准备

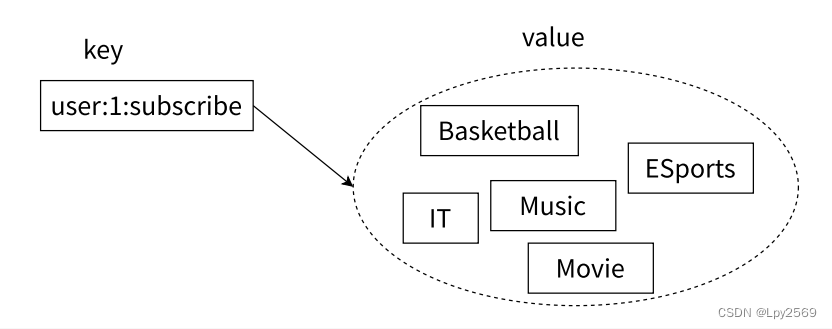

为了让模型能够让模型认清自己的身份——“我是谁,我来自哪里”,知道在询问自己是谁的时候回复成我们想要的样子,我们就需要通过在微调数据集中大量掺杂这部分的数据。

首先我们先创建一个文件夹来存放我们这次训练所需要的所有文件。

# 前半部分是创建一个项目工程文件夹,后半部分是进入该文件夹。

mkdir -p /root/project/llama3-ft && cd /root/project/llama3-ft

# 在llama3-ft这个文件夹里再创建一个存放数据的data文件夹

mkdir -p /root/project/llama3-ft/data && cd /root/project/llama3-ft/data

# 将本项目中的./data/self_cognition.json 文件复制到 /root/project/llama3-ft/data中

cp <替换本Git项目目录>/data/self_cognition.json /root/project/llama3-ft/data

通过文本编辑器打开 self_cognition.json 文件(下载地址:https://github.com/wwewwt/Llama3-XTuner-CN/blob/main/data/self_cognition.json),将其中的“ ”替换成“AI在手”,“”替换成“AI大模型在手公众号”,文本替换后的效果如下:

[

{

"instruction": "你好",

"input": "",

"output": "您好,我是AI在手,一个由AI大模型在手公众号开发的 AI 助手,很高兴认识您。请问我能为您做些什么?"

},

{

"instruction": "你好",

"input": "",

"output": "您好,我是AI在手,一个由AI大模型在手公众号打造的人工智能助手,请问有什么可以帮助您的吗?"

}

]

之后我们可以在 data 目录下新建一个 generate_data.py 文件,将以下代码复制进去,然后运行该脚本即可生成数据集。

# 创建 `generate_data.py` 文件

touch /root/project/llama3-ft/data/generate_data.py

打开 generate_data.py 文件后将下面的内容复制进去。

import json

# 定义一个函数来生成jsonl文件

def generate_jsonl(json_data, filename):

with open(filename, 'w', encoding='utf-8') as f:

for item in json_data:

# 将每个JSON对象转换为字符串,并写入文件

f.write(json.dumps(item, ensure_ascii=False) + '\n')

# 打开JSON文件并读取内容

with open('self_cognition.json', 'r') as f:

data = json.load(f)

json_data_list = []

# 遍历JSON数据

for item in data:

json_example = {

"instruction_zh": item['instruction'],

"input_zh": "",

"output_zh": item['output'],

"instruction": "Please introduce yourself",

"input": "",

"output": "I am assisant of Jizhiliu, I am sharing in the Shusheng Puyu Jizhiliu Community."

}

json_data_list.append(json_example)

generate_jsonl(json_data_list, 'self_cognition.jsonl')

运行 generate_data.py 文件即可。

cd /root/project/llama3-ft/data && python generate_data.py

可以看到在data的路径下生成了一个名为 self_cognition.jsonl 的文件。

最后我们创建 silk-road/alpaca-data-gpt4-chinese 文件夹并将self_cognition.jsonl复制其中:

mkdir -p /root/project/llama3-ft/silk-road/alpaca-data-gpt4-chinese

cp /root/project/llama3-ft/data/self_cognition.jsonl /root/project/llama3-ft/silk-road/alpaca-data-gpt4-chinese

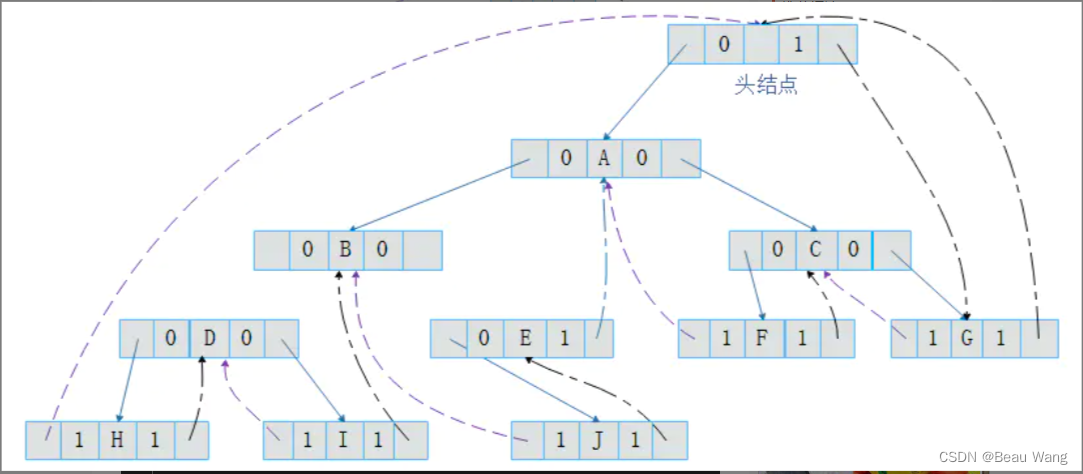

这就是我们用于自我认知微调的数据集,当前的项目工程目录文件树如下:

|-- /

|-- data/

|-- self_cognition.json

|-- generate_data.py

|-- self_cognition.jsonl

|-- silk-road/

|-- alpaca-data-gpt4-chinese/

|-- self_cognition.jsonl

3、下载Llama-3-8B-Instruct模型

pip install -U huggingface_hub

mkdir -p /root/model/

huggingface-cli download --token <替换成你的 huggingface token> --resume-download meta-llama/Meta-Llama-3-8B-Instruct --local-dir-use-symlinks False --local-dir /root/model/meta-llama/Meta-Llama-3-8B-Instruct

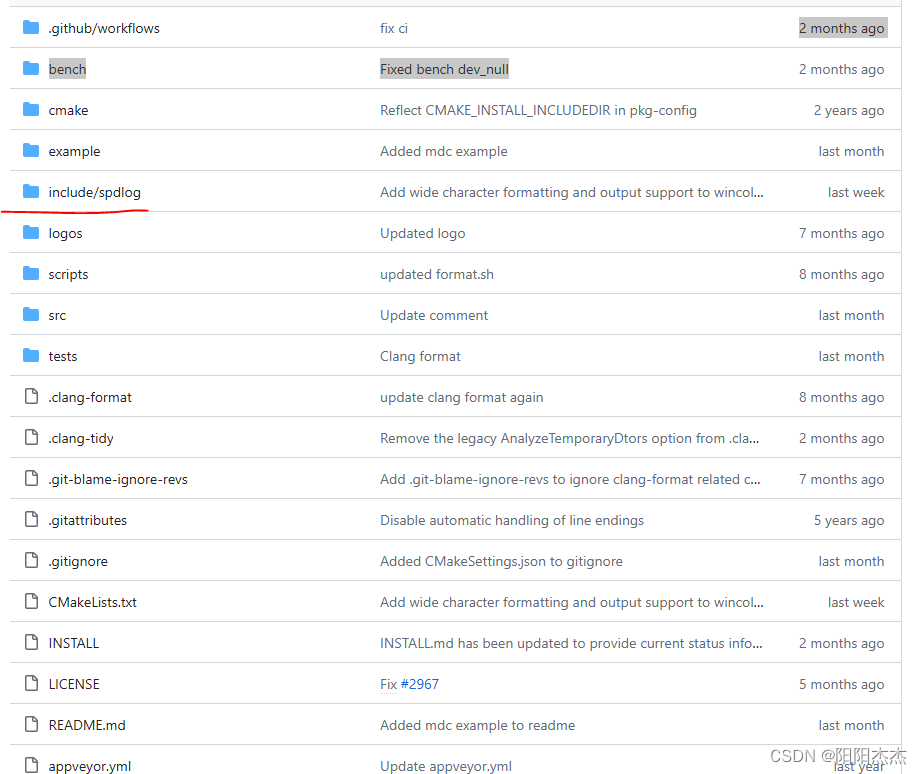

4、Xtuner配置文件准备

下载配置文件模板

cd /root/project/llama3-ft

# 使用 XTuner 中的 copy-cfg 功能将 config 文件复制到指定的位置

xtuner copy-cfg llama2_7b_chat_qlora_alpaca_zh_e3 .

# 修改文件名

mv llama2_7b_chat_qlora_alpaca_zh_e3_copy.py llama3_8b_chat_qlora_alpaca_zh_e3_self.py

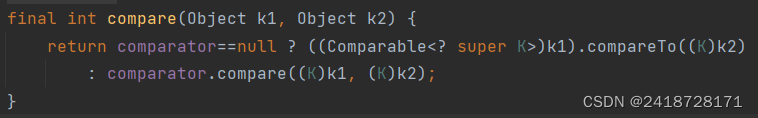

修改 llama3_8b_chat_qlora_alpaca_zh_e3_self.py 文件中的 “pretrained_model_name_or_path” 变量的值为下载到本地的Llama 3 模型的路径,并增大epoch:

- pretrained_model_name_or_path = 'meta-llama/Meta-Llama-3-8B-Instruct'

+ pretrained_model_name_or_path = '/root/model/meta-llama/Meta-Llama-3-8B-Instruct'

# 因为训练集的条数只有80,所以这里增大epoch,才能充分训练

- max_epochs = 3

+ max_epochs = 100

# 修改评估问题

- '请给我介绍五个上海的景点', 'Please tell me five scenic spots in Shanghai'

+ '请做一个自我介绍', '请介绍一下你自己'

5、训练模型

cd /root/project/llama3-ft

# 开始训练,使用 deepspeed 加速,A100 40G显存 耗时24分钟

xtuner train llama3_8b_chat_qlora_alpaca_zh_e3_self.py --work-dir ./train_self --deepspeed deepspeed_zero2

# 获取Lora

mkdir hf_self

xtuner convert pth_to_hf llama3_8b_chat_qlora_alpaca_zh_e3_self.py ./train_self/iter_1600.pth ./hf_self/

# 模型合并

export MKL_SERVICE_FORCE_INTEL=1

xtuner convert merge /root/model/meta-llama/Meta-Llama-3-8B-Instruct ./hf_self ./merged_model_self

merged_model_self 文件夹中即为完成了自我认知微调后的 Llama 3 模型。

修改其中的 special_tokens_map.json 文件内容为

{

"bos_token": "<|begin_of_text|>",

"eos_token": "<|end_of_text|>"

}

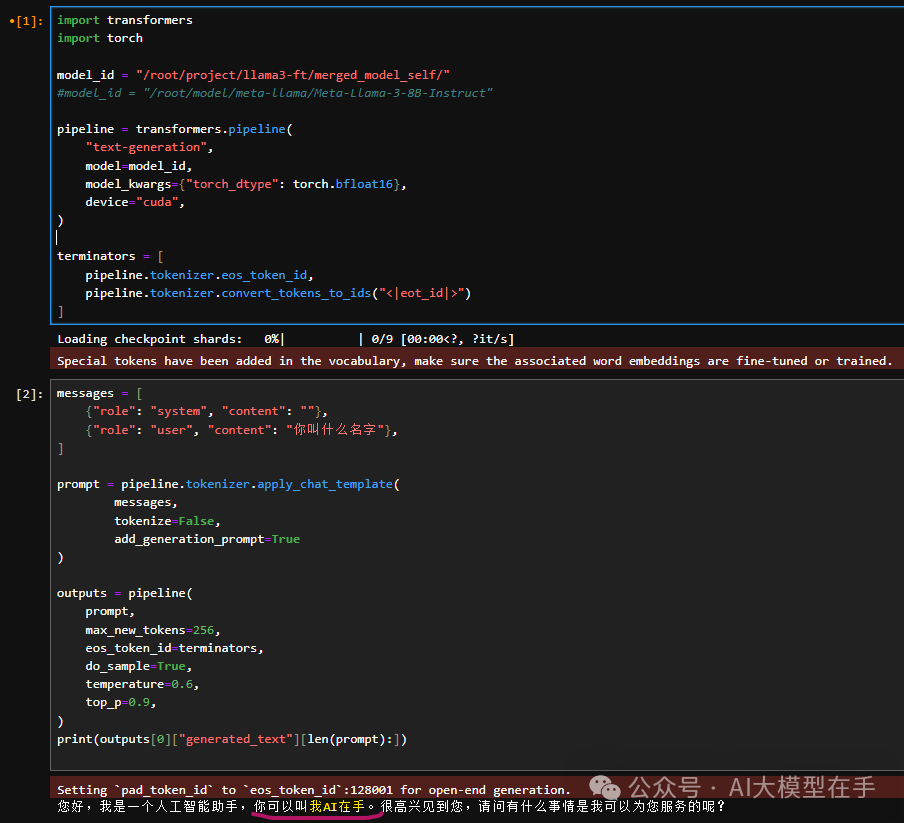

6、推理验证

# 创建 inference.py 文件touch /root/project/llama3-ft/inference.py

打开 inference.py 文件后将下面的内容复制进去。

import transformers

import torch

model_id = "/root/project/llama3-ft/merged_model_self"

pipeline = transformers.pipeline(

"text-generation",

model=model_id,

model_kwargs={"torch_dtype": torch.bfloat16},

device="cuda",

)

terminators = [

pipeline.tokenizer.eos_token_id,

pipeline.tokenizer.convert_tokens_to_ids("<|eot_id|>")

]

messages = [

{"role": "system", "content": ""},

{"role": "user", "content": "你叫什么名字"},

]

prompt = pipeline.tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

outputs = pipeline(

prompt,

max_new_tokens=256,

eos_token_id=terminators,

do_sample=True,

temperature=0.6,

top_p=0.9,

)

print(outputs[0]["generated_text"][len(prompt):])

运行 inference.py 文件即可。

cd /root/project/llama3-ft && python inference.py

您好,我名叫AI在手,是由AI大模型在手公众号开发的 AI 助手。我的任务是为用户提供回答和帮助。

“”

训练完后的完整的项目工程目录文件树如下:

|-- /

|-- llama3_8b_chat_qlora_alpaca_zh_e3_self.py

|-- merged_model_self/

|-- config.json

|-- pytorch_model.bin.index.json

|-- pytorch_model-00006-of-00009.bin

|-- pytorch_model-00002-of-00009.bin

|-- pytorch_model-00001-of-00009.bin

|-- pytorch_model-00003-of-00009.bin

|-- tokenizer_config.json

|-- pytorch_model-00009-of-00009.bin

|-- pytorch_model-00004-of-00009.bin

|-- special_tokens_map.json

|-- pytorch_model-00005-of-00009.bin

|-- pytorch_model-00007-of-00009.bin

|-- pytorch_model-00008-of-00009.bin

|-- tokenizer.json

|-- generation_config.json

|-- hf_self/

|-- adapter_config.json

|-- xtuner_config.py

|-- adapter_model.bin

|-- README.md

|-- train_self/

|-- llama3_8b_chat_qlora_alpaca_zh_e3_self.py

|-- zero_to_fp32.py

|-- last_checkpoint

|-- iter_1600.pth/

|-- bf16_zero_pp_rank_0_mp_rank_00_optim_states.pt

|-- mp_rank_00_model_states.pt

|-- data/

|-- self_cognition.json

|-- generate_data.py

|-- self_cognition.jsonl

|-- silk-road/

|-- alpaca-data-gpt4-chinese/

|-- self_cognition.jsonl

7、ToDo List

调整Xtuner训练模板,支持英语对话中的自我认知微调。

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。