计算机辅助诊断 (CAD) 系统使用数字化乳房 X 线摄影图像并识别乳房中存在的异常情况。深度学习方法从有限数量的专家注释数据中学习图像特征并预测必要的对象。卷积神经网络(CNN)在图像检测、识别和分类等各种图像分析任务中的性能近年来表现出色。本文提出利用高精度和先进的对象检测深度学习方法 Faster R-CNN 对乳房 X 光照片中的乳腺癌病灶进行自动检测和分类。所提出的 CAD 系统使用 330 个乳房 X 线摄影图像,其中 121 个带注释的图像用于训练 Faster R-CNN 网络。

1. 介绍

有助于早期发现乳腺癌的三个重要预防措施是每月乳房自我检查、定期临床乳房检查和筛查乳房X光检查。高死亡率主要是由于缺乏癌症的早期发现。

乳房X光检查还可能有助于确定高风险癌症因素,例如含有大量腺体组织的致密乳房。乳房X线照相过程被认为是耗时、乏味的,更重要的是它容易出现错误[4]。事实证明,CAD 系统在准确诊断医学图像方面效果良好,可用于乳房 X 光检查来解决这些问题。

1.1 文章贡献

本文提出利用高精度和先进的对象检测深度学习方法 Faster R-CNN 对乳房 X 光照片中的乳腺癌病灶进行自动检测和分类。

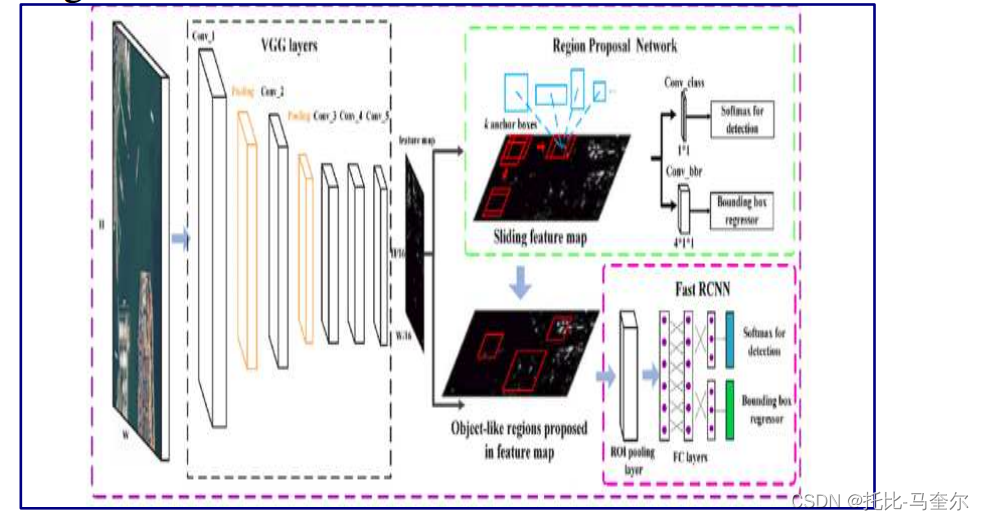

Faster R-CNN 具有三个模块,即作为完全连接网络的基本模型提取出特征图,第二个模块识别所有感兴趣的区域,第三个模型检测第二个模型提出的区域中存在的确切对象[ 7]。本文使用预训练的 VGG-16 网络作为基础卷积网络来提取区域和用于对象检测的 Fast R-CNN [8,9]。

1.2 数据集

所提出的 CAD 系统使用迷你 MIAS 数据库作为实验数据集,它是 MIAS 数据库的子集。 Mini-MIAS 数据库拥有 330 张分辨率为 50 微米的数字化乳房 X 光图像。其分辨率已降低至 1024 x 1024 像素的 200 微米分辨率。

2. 材料和方法

2.1 问题定义

如果乳腺癌发现得早,而且肿瘤很小并且没有扩散,那么乳腺癌很容易成功治疗。定期筛查是早期乳腺癌发现的最佳方法之一。

乳房 X 光检查乳房图像是通过将乳房暴露在较低剂量的辐射下生成的。由癌症、脂肪细胞或囊肿等其他情况引起的乳房异常可以在数字化乳房 X 光图像中显示为肿块。微钙化是微小的钙簇,甚至暴露在数字化的乳房X光图像中。

2.2 相关工作

乳腺X线摄影图像中图像分类任务的挑战是识别微小的肿瘤细胞。尽管手动注释的 ROI 分类是重要的第一步,但 CAD 系统必须能够对整个乳房 X 线照片进行操作,以提供已知病变之外的附加信息并增强临床解释。乳房X线摄影数据库中带注释的mamo图像可以轻松使用对象检测和分类方法,例如基于区域的卷积神经网络(R-CNN)及其变体[14-16]。

目前 CNN 模型的设计方式可以提高放射科医生在最早阶段发现最小乳腺癌的能力。这有助于向放射科医生发出需要进一步分析的警报[18]。研究表明,CNN 为微小病变提供了额外的描述,有助于放射科医生更好的诊断和准确的预测 [19]。

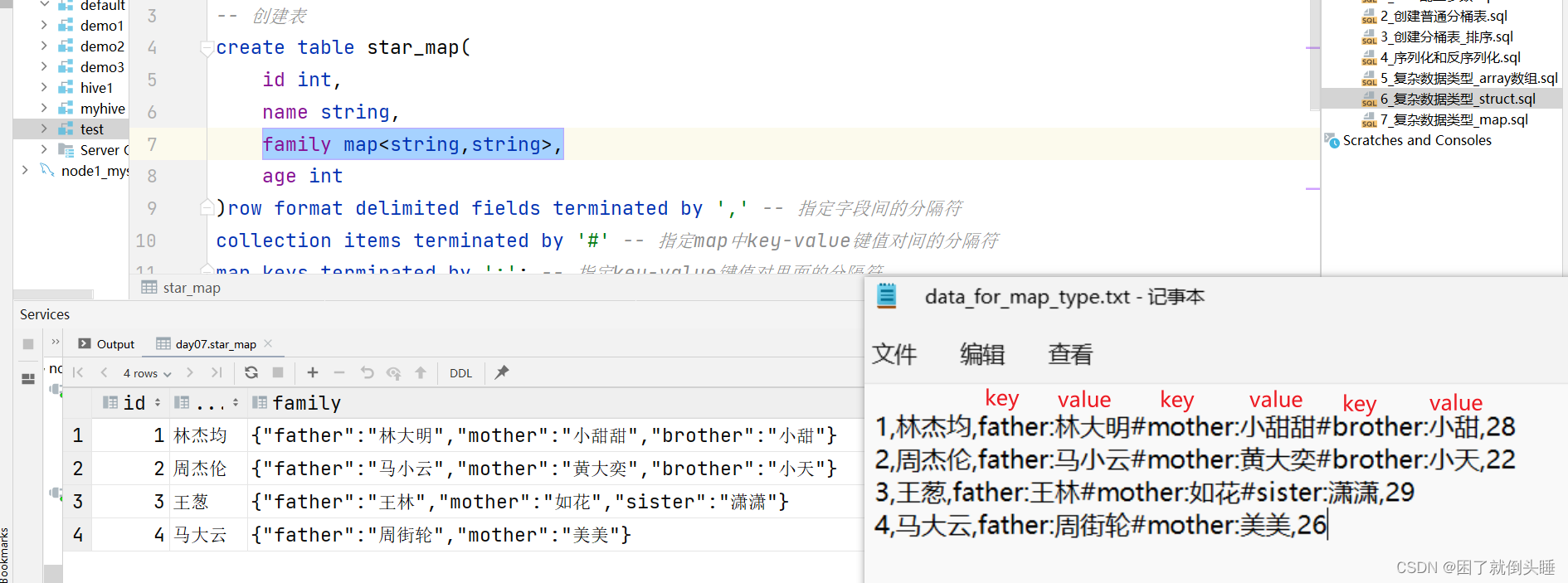

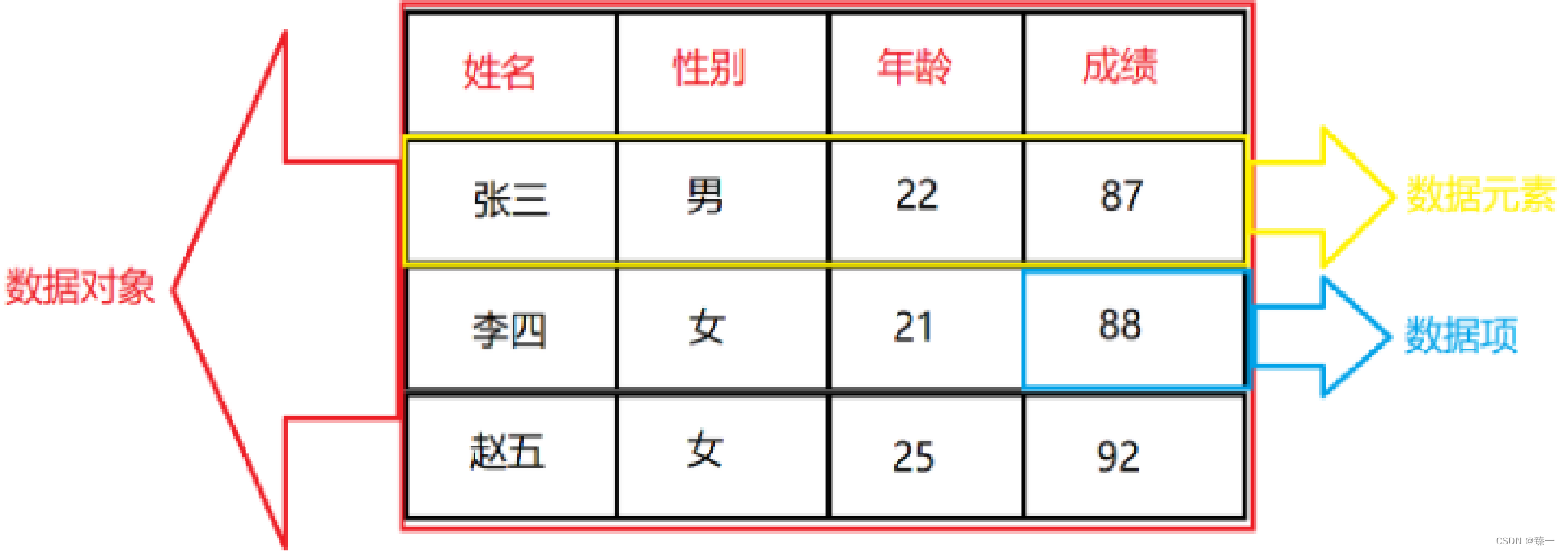

2.3 数据

实验数据集 mini-MIAS 数据库有 330 个数字化乳房 X 光照片。在这 330 张乳房 X 光检查图像中,67 张被证明是良性的,54 张是恶性的,209 张是正常的。实验数据集还包括其他发现,例如图像中存在的异常类别、它们的位置以及乳腺组织的类型,即脂肪、脂肪腺和致密腺。

2.4 方法

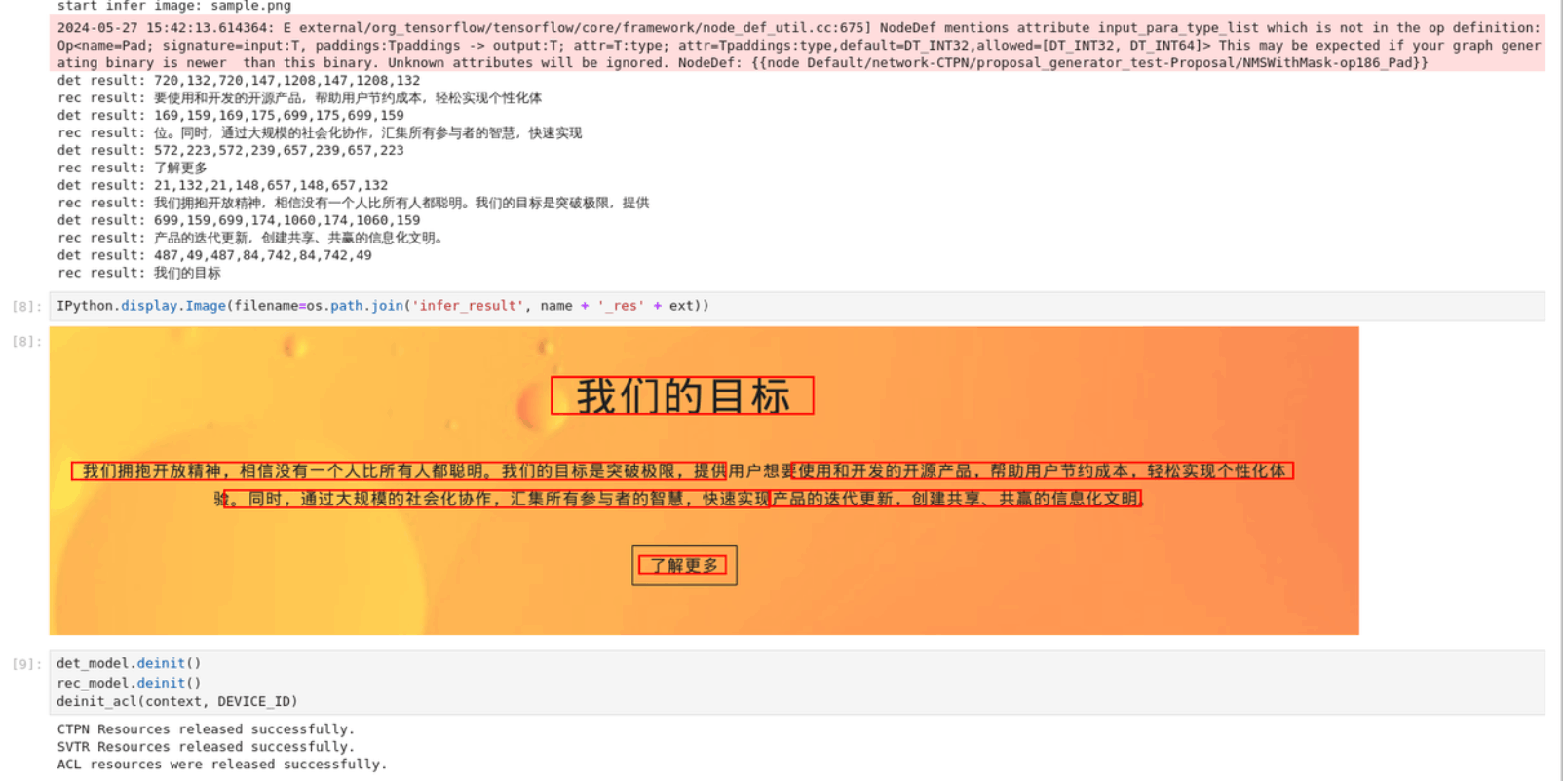

本文提出了一种使用深度学习技术对数字化乳腺X线图像进行自动乳腺癌病灶识别的方法。一般来说,CNN 包含两个或多个层的堆栈,如输入层、隐藏层和输出层。一个或多个卷积层、池化层和全连接层是 CNN 隐藏层的一部分。目前的目标检测网络主要依赖于提取区域的算法。本文提出了一种先进的基于 CNN 的目标检测系统 Faster R-CNN,用于数字化乳房图像中的病变检测。

Faster R-CNN 具有基础网络 RPN 和对象检测网络 Fast R-CNN。

RPN 是一个完全连接的卷积网络,它根据训练图像中每个位置的高概率分数来确定对象的边界框。

RPN 与 Fast R-CNN 共享全图像卷积特征,有助于检测对象。

对象检测网络使用区域提议算法来检测对象位置。这些区域提议算法生成边界框,其中该区域中对象存在的概率很高。这些边界框是 RPN 通过对特征图执行卷积运算产生的。这些特征图包含专家注释的输入图像的主要特征。这些特征图由基础网络 VGG-16 生成。

2.5 CNN 训练和前后处理方法

121 个异常(67 个良性和 57 个恶性)乳房 X 光检查图像均已缩小为 600 x 600 像素大小的图块,以便更快地进行训练。数据集分为 106 张图像的训练集和 15 张图像的测试集。

Faster R-CNN 的两个模块由三部分组成,即基础网络、区域提议网络和分类器层。该模型使用的基础网络是 VGG16,有 16 层[21]。用于训练的基本模型是在 ImageNet 数据集中的 120 万张图像上进行预训练的。该网络给出的特征图被传递到区域提议网络和分类器层,如图所示

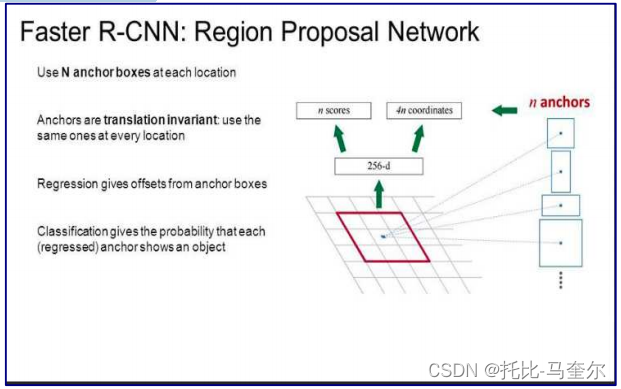

RPN是一个小型卷积神经网络,它使用基础网络生成的特征图,并提出区域/框束(锚点)来检测物体的存在。更准确地说,RPN 预测锚点是背景或前景的可能性,并细化锚点,如下图 所示。得分超过阈值的区域将被传递给 Fast R-CNN 分类器。

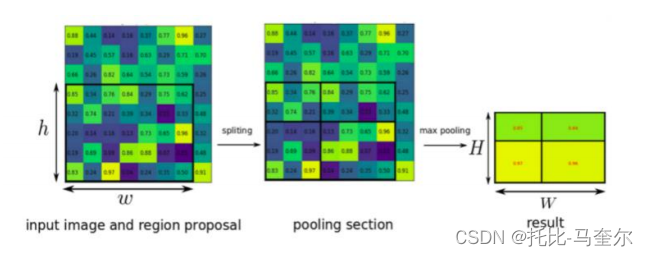

在 RPN 提出的不同大小的区域之前,它们会在 ROI 池化层进行变换,通过最大池化生成固定大小的特征图,如图 3 所示。从重叠框中,使用非最大抑制 [22] 选择最佳预测。

乳房 X 线摄影图像中的物体(病变)比 imageNet 图像中的物体小很多。因此,所提出的系统将物体检测阈值从 0.7 降低到 0.6。在分类器层,RPN 提出的病变边界框(区域)被回归并分类为恶性和良性标签。

3. 结果和讨论

实验数据集 mini-MIAS 数据库有 121 张异常乳房 X 光检查图像。所提出的网络 Faster R-CNN 使用基础网络 VGG16 和生成的特征图进行训练。基础网络生成的特征图已传递给 RPN。RPN 使用此特征图来提出用于检测物体存在的区域/框束。得分超过阈值的区域将传递到分类器最终层。分类器最终层进一步回归并将 RPN 提出的边界框分类为正常、恶性和良性。

任何 CNN 模型最初都会从训练数据中学习特征。在很好地拟合训练数据后,该模型会尝试概括并对传入的新数据做出准确的预测。如果模型训练数据太好,就会遇到过度拟合问题。过度拟合会学习最佳特征,而图像的噪声会导致错误的预测,从而影响模型的准确性。可以通过将数据集拆分为训练和测试数据的交叉验证来克服过度拟合。使用训练集对模型进行训练,并使用验证集评估其预测性能。为了对最终模型进行无偏评估,将测试集应用于模型。

Faster-RCNN 在测试数据上运行,并生成带有相关置信度分数的边界框列表。如果置信度分数大于给定的阈值,则相应边界框内存在对象。如果预测框的 IoU 大于阈值 (0.5),则该框被宣布为真阳性。否则,它就是假阳性。在 Faster R-CNN 等模型中,最终结果是在两个任务(即对物体进行分类(良性或恶性)和定位(边界框预测))的综合执行后获得的。

虽然传统的 Faster R-CNN 无法检测到几个较小的物体,但通过调整一些参数,如减少锚框尺度和 RPN 重叠值,在检测较小的病变方面比传统的 Faster R-CNN 效果更好。较小物体的另一个问题是网络可能会忘记在初始阶段学习到的特征。应该实施一种将在起始层学习到的特征传播到最后一层的方法。这可以使用残差网络作为基础网络来完成。