时序预测这东西大家一般不陌生,随便举几个例子

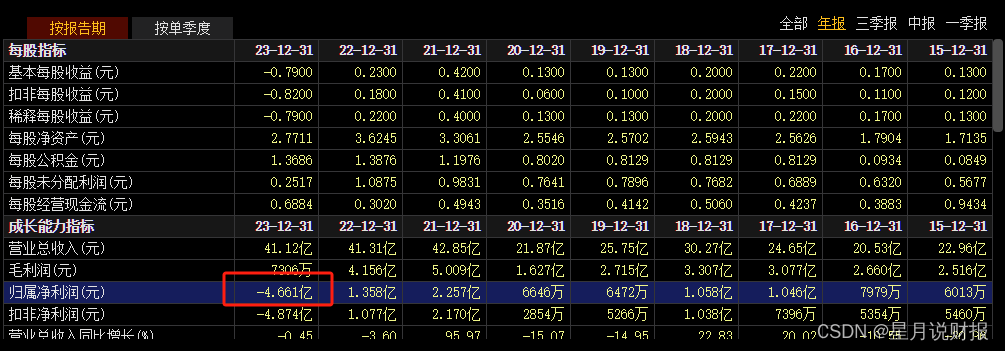

1- 金融,比如预测股票(股市有风险,入市需谨慎),纯用K线做,我个人不太推荐

2- 天气,比如预测云图,天气预报啥的

3- 交通,早晚高峰,堵车啥的,车啥时候加油,啥时候充电之类的

4- 医疗,看你病史和喝酒的剂量建模,看你会不会得痛风啥的。

反正很多很多吧,应用的场合也是比较广的。

RNN,一般来讲时序LLM,其实天然和RNN,LSTM这些玩意契合,因为有本身RNN就有时间步的概念,也能部分解决长距离依赖,缺点训练费劲,也做不大,要不咋干不过Transformer呢?

TCN,另外时间步卷积,Temporal Convolutional Networks ,使用卷积网络处理时序数据,具有更好的并行计算能力,但是为啥不用它呢,其实和它对NLP的道理差不多,通过野去做东西不适合序列化的任务。上下文和长距离它也不太行,想让它行就得做得更深,更复杂,效果还不一定好

剩下就Transformer了,历史重担一肩挑,然后爱折腾人的黑手,又把时间序列任务强加给了Transformer...

本次小周带你读论文就讲一下ICLR2024的一篇新论文

首先介绍这论文的主旨:

1- Transformer啥都能干

2- 能NLP,能ASR,还能VQA

3- 既然能整这么多的多模态,也不差加一个时间序列了吧?

其实主旨真就是我介绍的这么3点

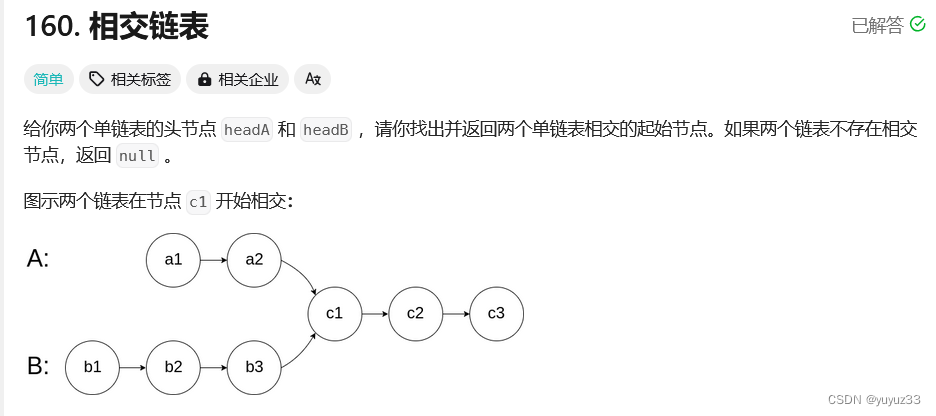

我们看一下时间序列和Transformer不搭调的地方

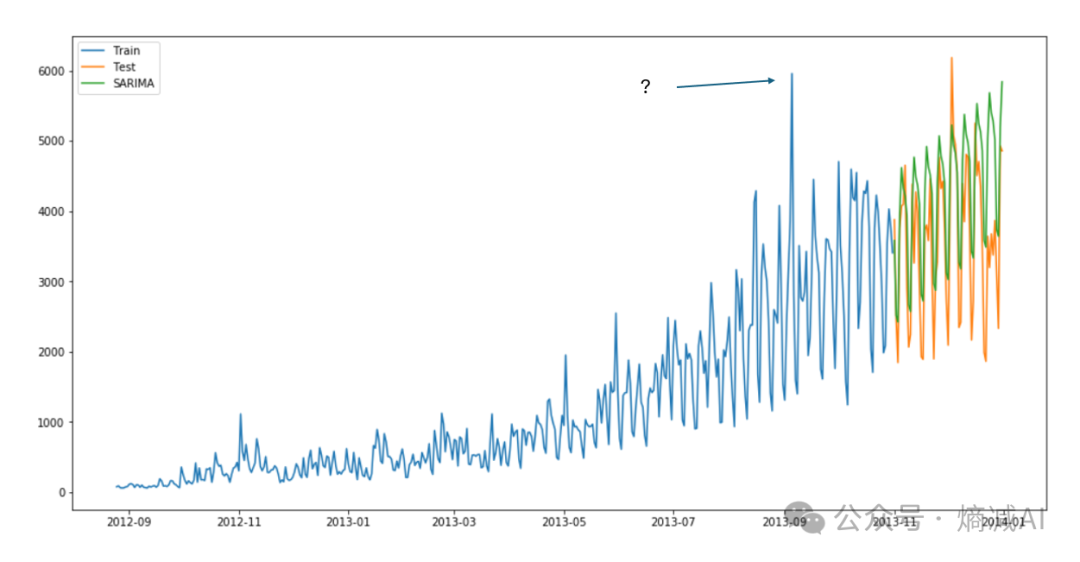

比如我随便找个时间序列曲线

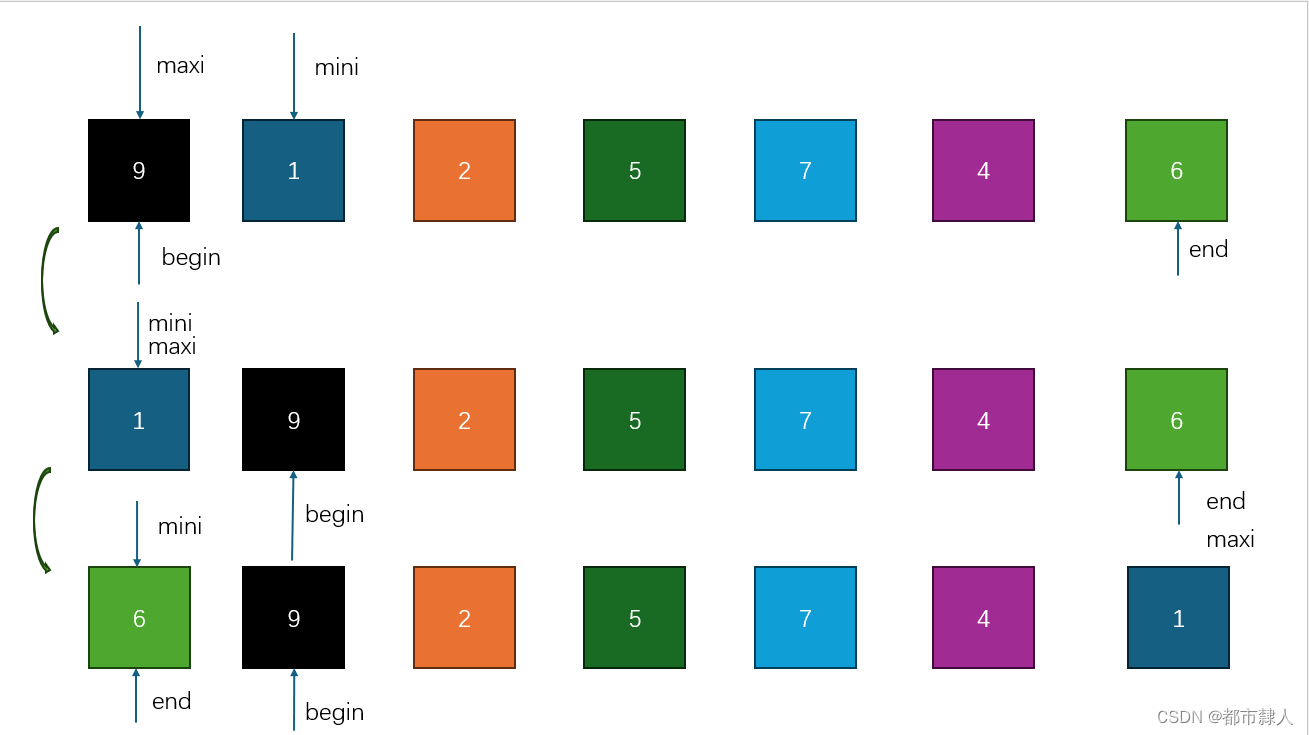

随便拿几个点来训练行吗?那肯定不行啊,因为点和点要有相对关系的,那拿一些段来训练呢?

拿一段来提取特征是可以的,但是如何把NLP里的东西和一段走势做mapping呢,一个最简单的办法就是给个文字描述对应一个波段或者几个波段