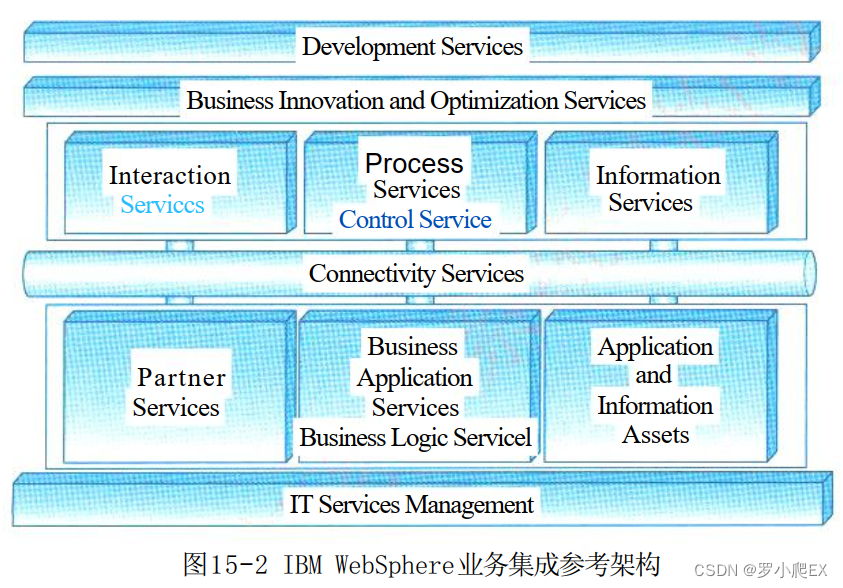

OrangePi AIpro上手指南

简介

- 香橙派与华为合作发布的香橙派AiPro为Ai主力,为边缘设备的Ai计算提供了可能。

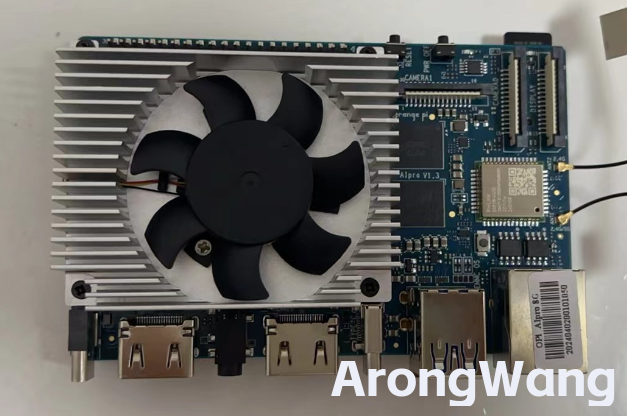

- 集成图形处理器,拥有8GB/16GB LPDDR4X(我这个是8G内存版本的),可以外接32GB/64GB/128GB/256GB eMMC模块,支持双4K高清输出,8/20 TOPS AI算力。

- 香橙派AIpro接口可谓是相当丰富了,提供了两个HDMI输出、GPIO接口、Type-C电源接口、支持SATA/NVMe SSD 2280的M.2插槽、TF插槽、千兆网口、两个USB3.0、一个USB Type-C 3.0、一个Micro USB、两个MIPI摄像头、一个MIPI屏等,预留电池接口**。

- 预留了电池接口,后期研究智能驾驶小车 采用电池供电时更加方便。

- Orange Pi AIpro支持Ubuntu、openEuler操作系统,满足大多数AI算法原型验证、推理应用开发的需求、深度视觉学习及视频流AI分析、视频图像分析、自然语言处理、智能小车、机械臂、人工智能、无人机、云计算、AR/VR

- 后期会使用香橙派AIpro来制作智能驾驶小车、机械臂 大致过程如下

- 实现电机驱动、远程遥控、智能避障

- 物体识别,智能夹取

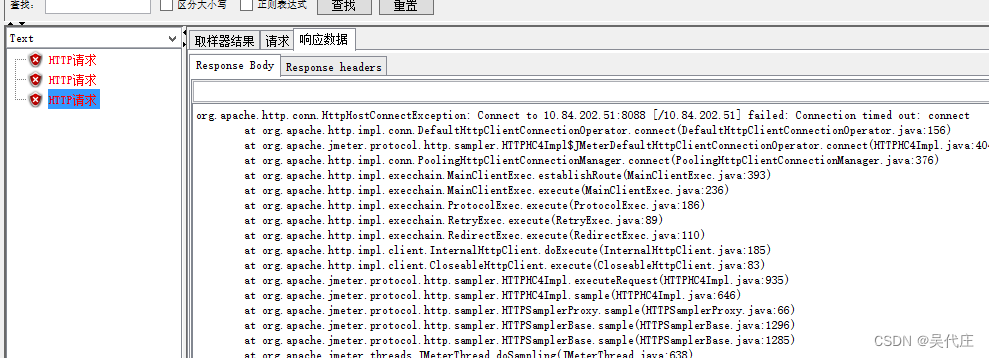

香橙派AiPro搭建内网穿透+云服务器实现公网访问

- 租一个便宜的云服务器使用云服务器的公网IP,将应用服务部署在 香橙派Aipro 以内网穿透来映射端口,用公网Ip访问本地服务来节省成本

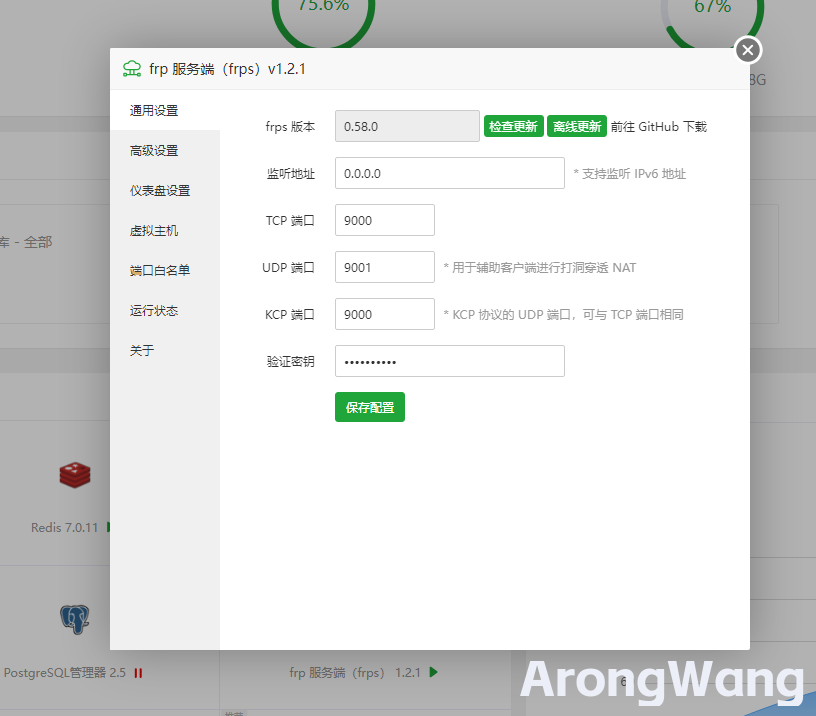

云服务器部署Frp服务

在云服务器 采用宝塔面板进行部署Frp服务

如图下载 frp服务端宝塔插件,根据提示 点击去github下载最新的frp包即可。设置好服务端口 并且在云服务器安全组开放端口

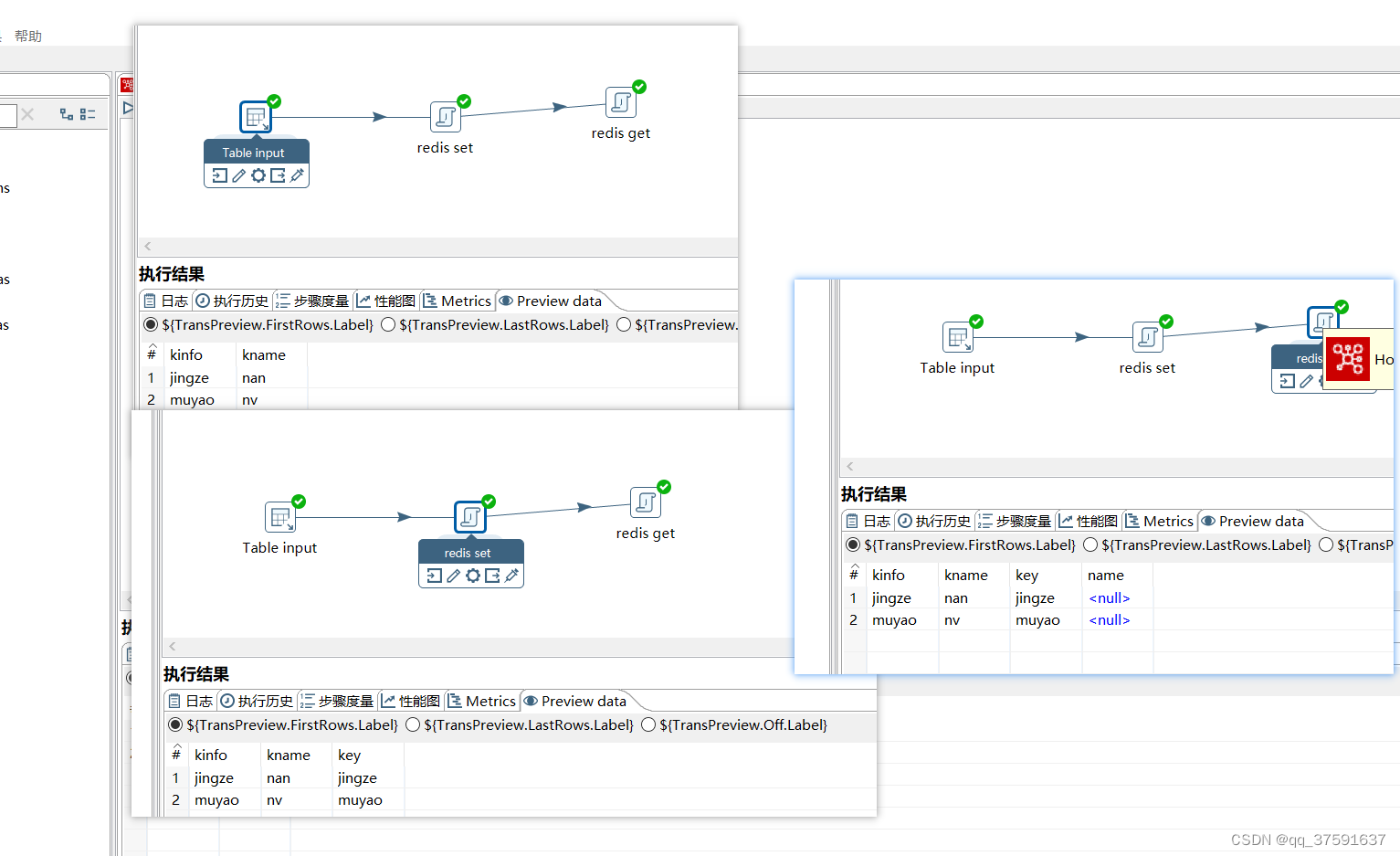

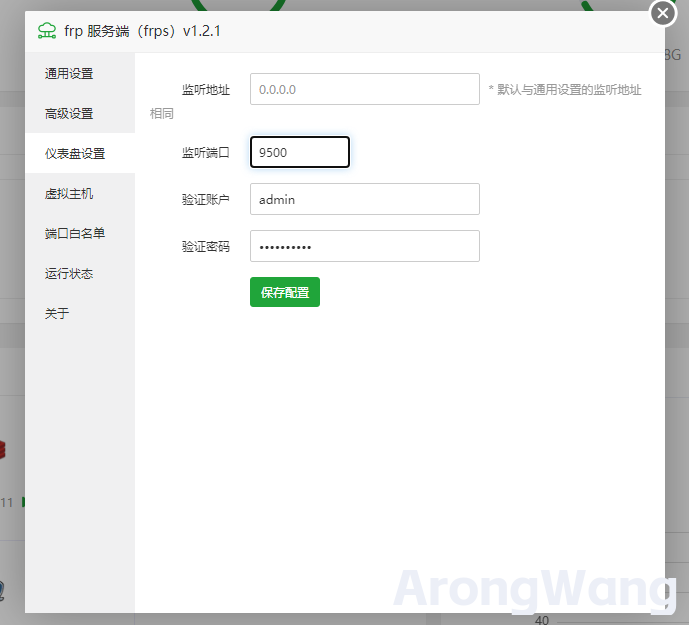

在frp服务端插件中的仪表盘中可以设置服务地址,便于查看目前使用中的服务,配置如下图所示

输入 云服务IP+9500端口即可访问仪表盘

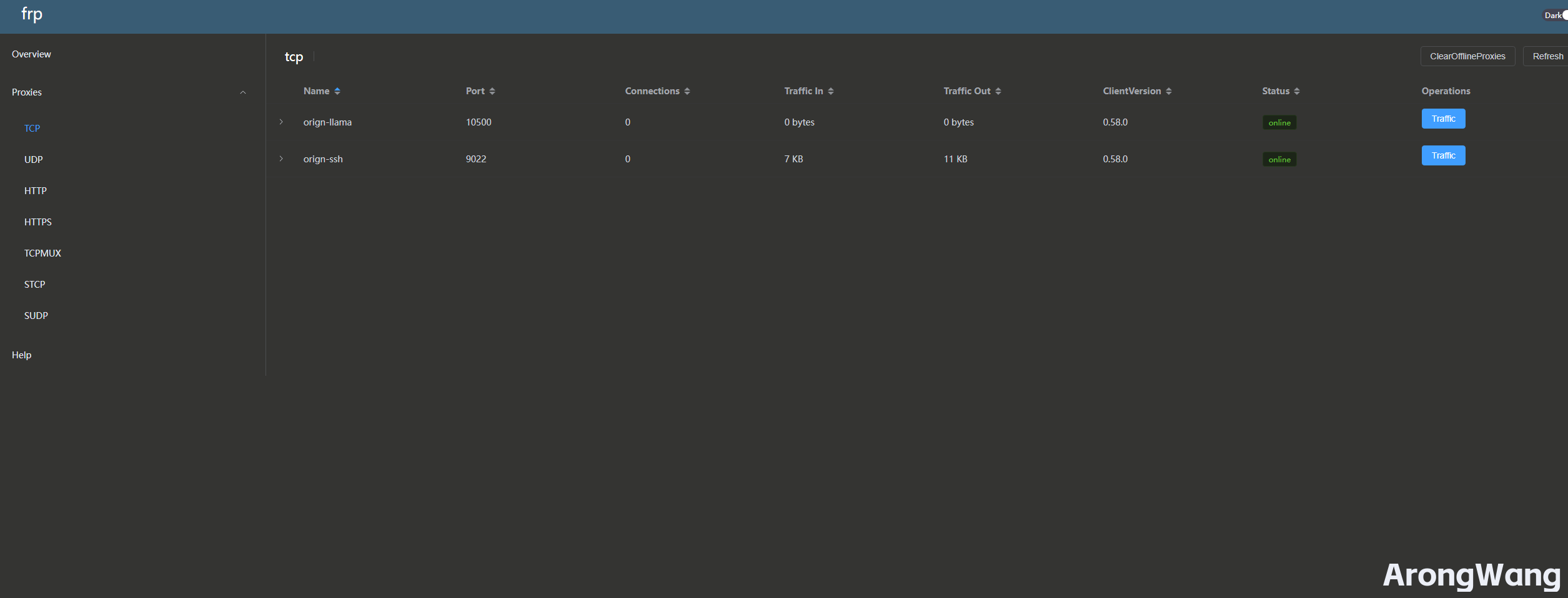

在仪表盘中可以看到,目前我将香橙派AiPro的22端口与5000端口映射到云服务器的9022端口与10500端口

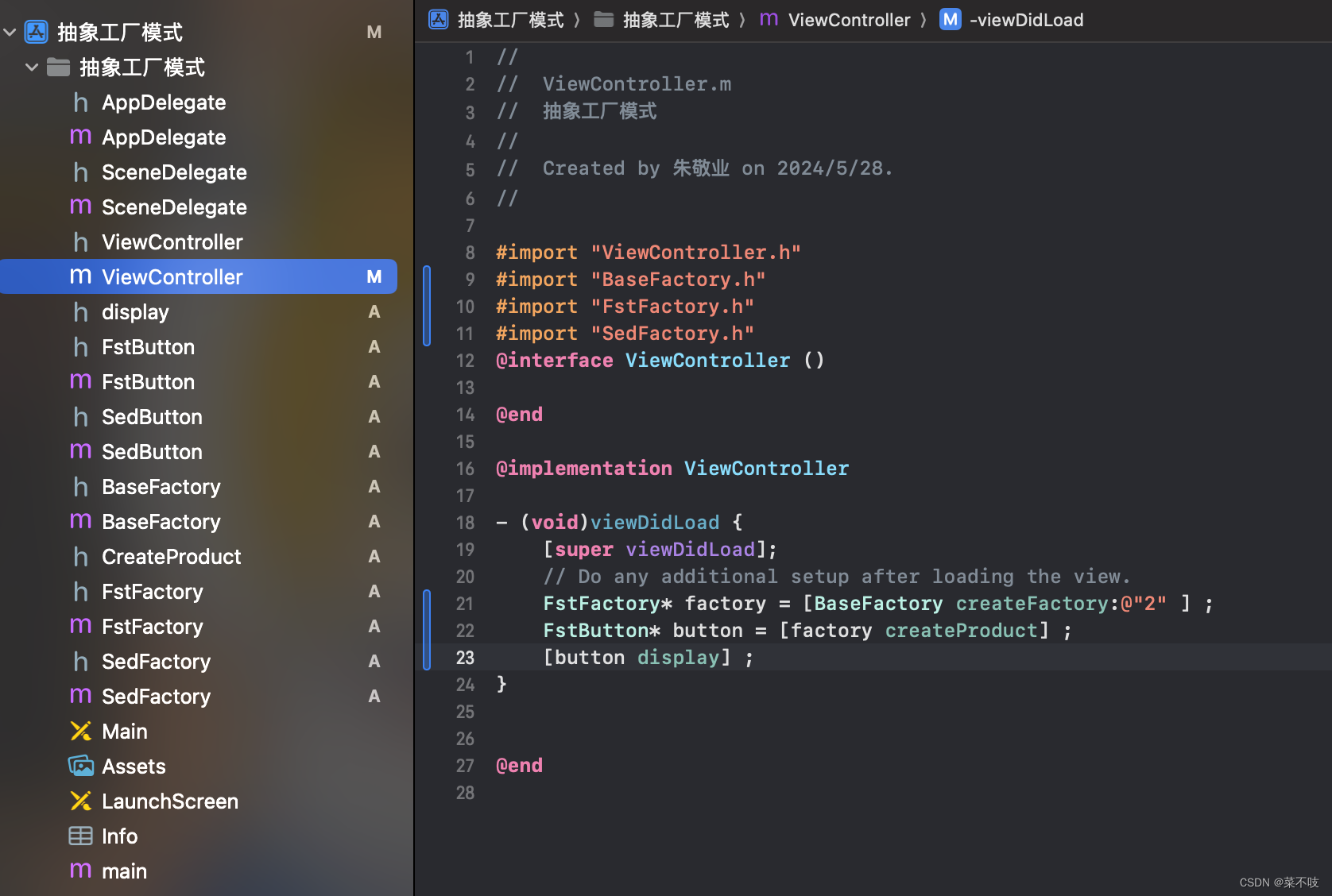

香橙派启动Frp客户端

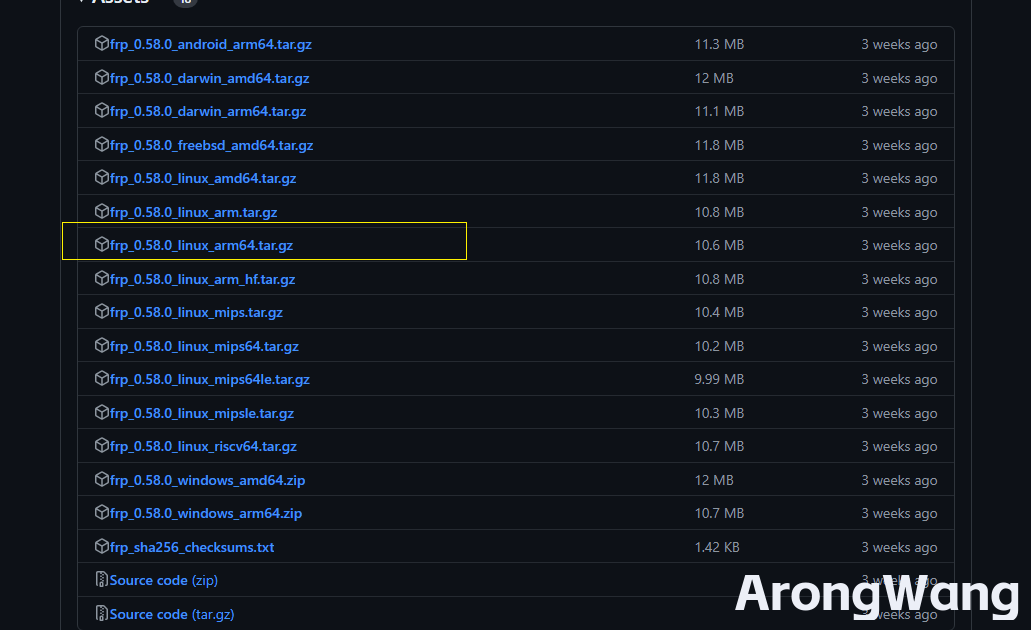

在Frp github下载arm架构64位包

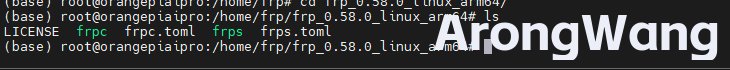

使用ftp工具上传至香橙派Aipro并解压

编辑Frp客户端配置文件frpc.toml(在最新的frp中配置文件采用了toml格式)

serverAddr = "云服务器IP" serverPort = 配置的服务端口 如上图为9000 auth.method = 'token' #采用token验证方式 auth.token = "设置的令牌" # 第一个隧道 [[proxies]] name = "orign-ssh" #隧道名称 type = "tcp" # 协议类型 localIP = "127.0.0.1" localPort = 22 # 香橙派本地端口 remotePort = 9022 # 映射到云服务端口 # 第二个隧道 [[proxies]] name = "orign-llama" #隧道名称 type = "tcp" # 协议类型 localIP = "127.0.0.1" localPort = 5000 # 香橙派本地端口 remotePort = 10500 # 映射到云服务端口 ~ ~配置如上,根据配置完成后,启动香橙派Frp配置

启动Frp客户端

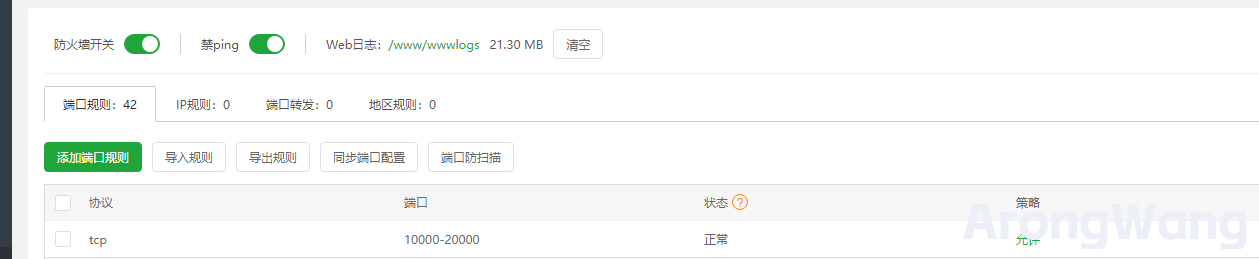

nohup ./frpc -c ./frpc.toml > /dev/null 2>&1 &需要注意,在remotePort 配置的云服务器端口,需要在云服务器的防火墙开放,如使用宝塔面板,在宝塔面板的安全模块需开放端口

此时 即可通过公网IP+端口 实现访问 香橙派本地服务

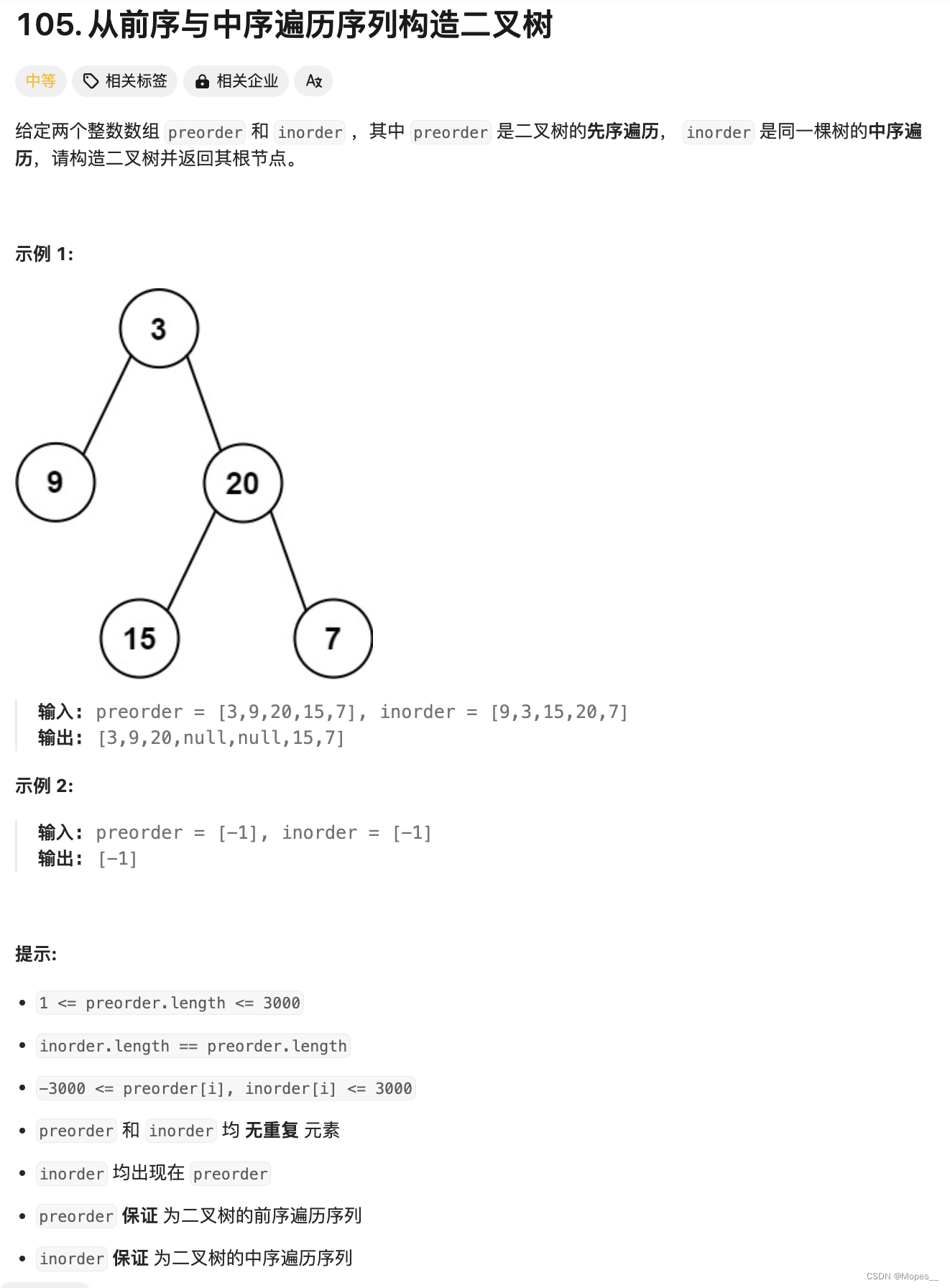

香橙派Aipro Tiny-Llama大模型初体验

在香橙派的官方社区提供了一个大语言模型示例 Tiny-Llama

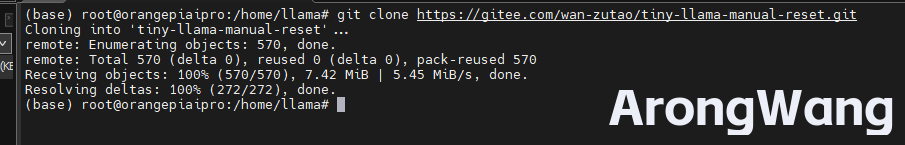

使用root用户登录, clone 代码仓库到指定目录下

git clone https://gitee.com/wan-zutao/tiny-llama-manual-reset.git

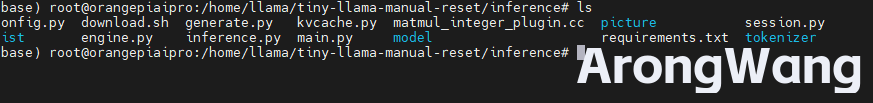

进入项目目录下的inference 目录

cd tiny-llama-manual-reset/inference

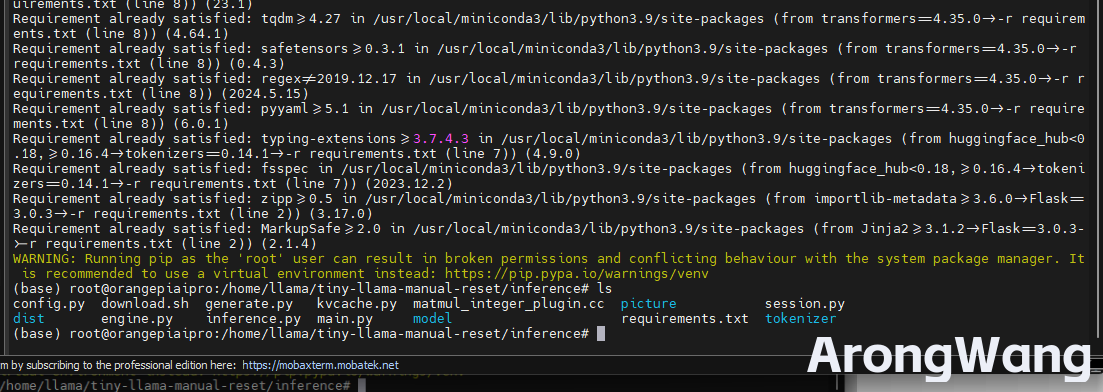

运行download.sh,下载model,tokenizer文件。

bash download.sh等待模型下载完成

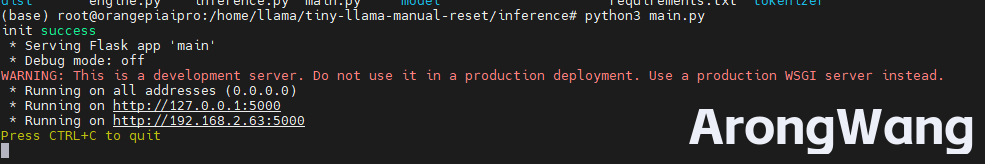

如上图下载完成,运行当前目录下的main.py

python3 main.py

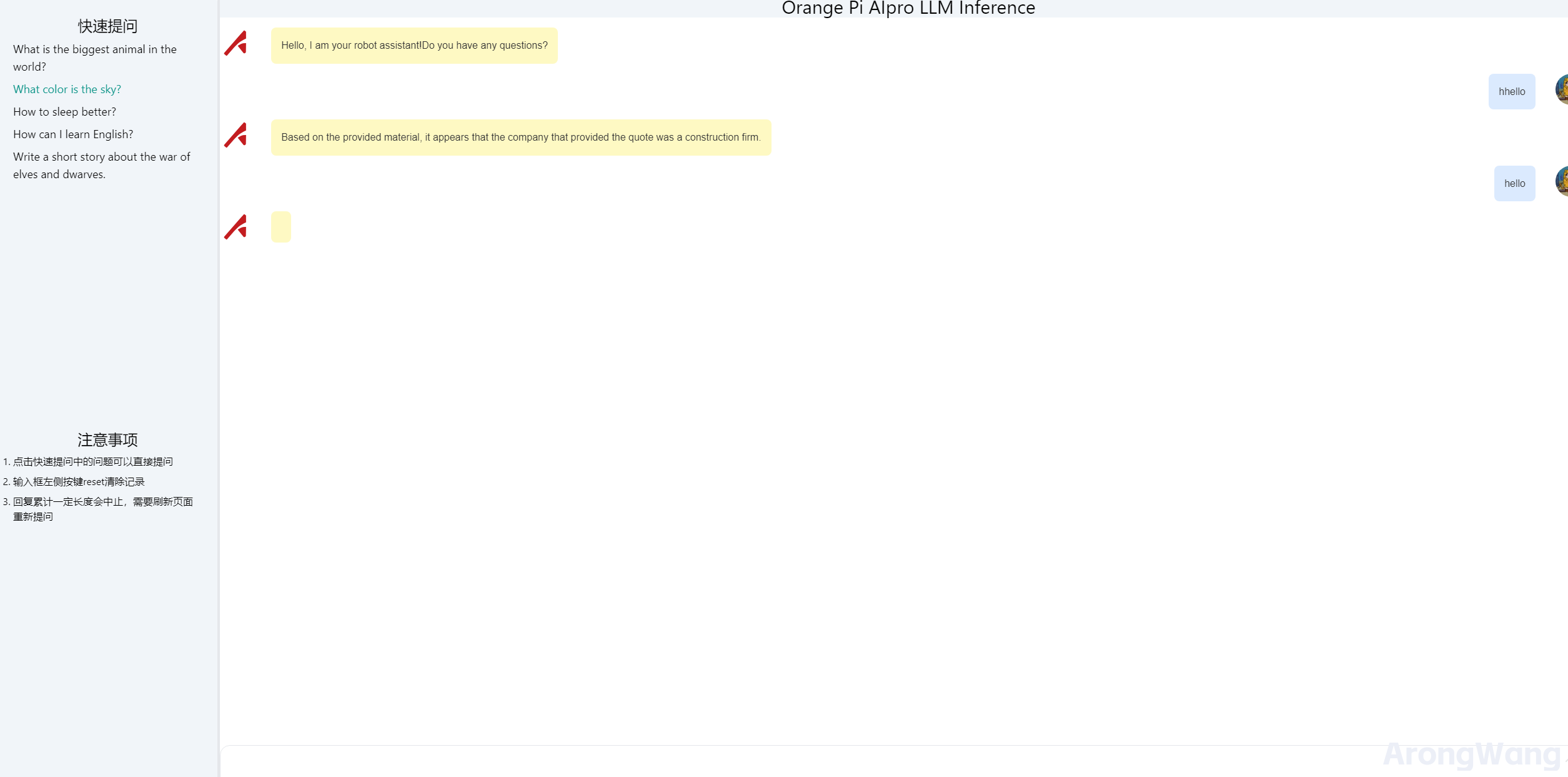

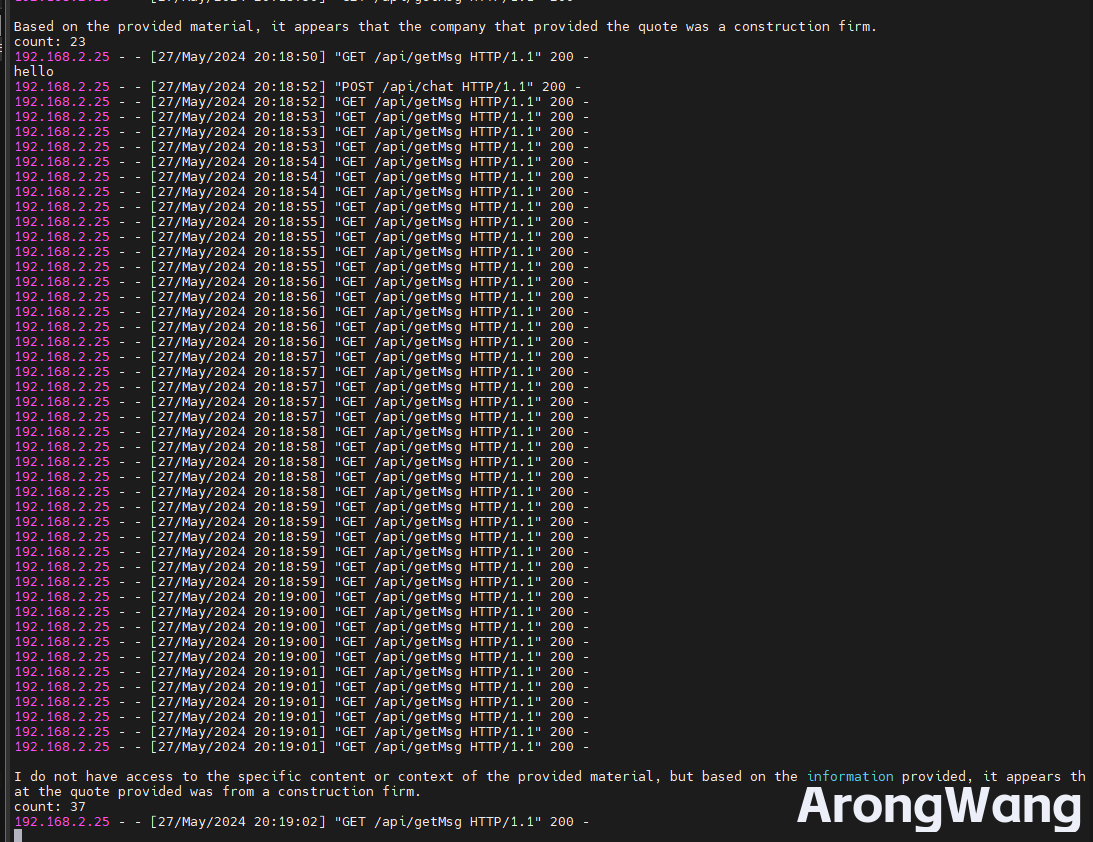

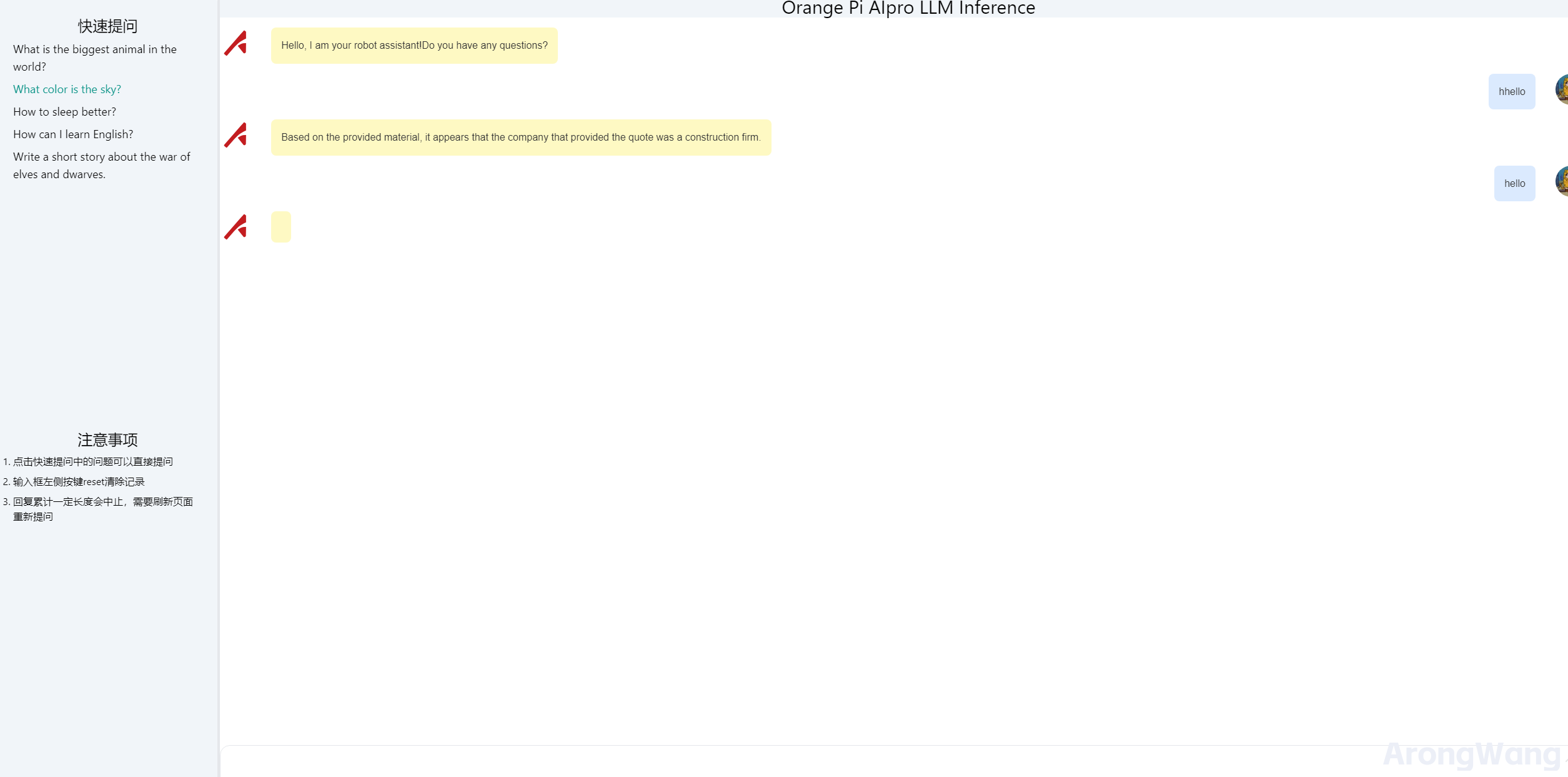

如上图,启动后,访问香橙派Aipro端口即可体验Tiny-Llama 大模型

通过Frp 穿透到云服务端口10500上,即可通过云服务器IP+10500端口进行访问

此外在昇腾官方论坛上还提供了onnx转om模型的教程,om模型可以在香橙派Aipro获得Ai算力方面的加持。链接如下

- ATC模型转换文档

6.此外也有很多各种各样的样例 例如USB摄像头目标检查、手写体识别模型与推理