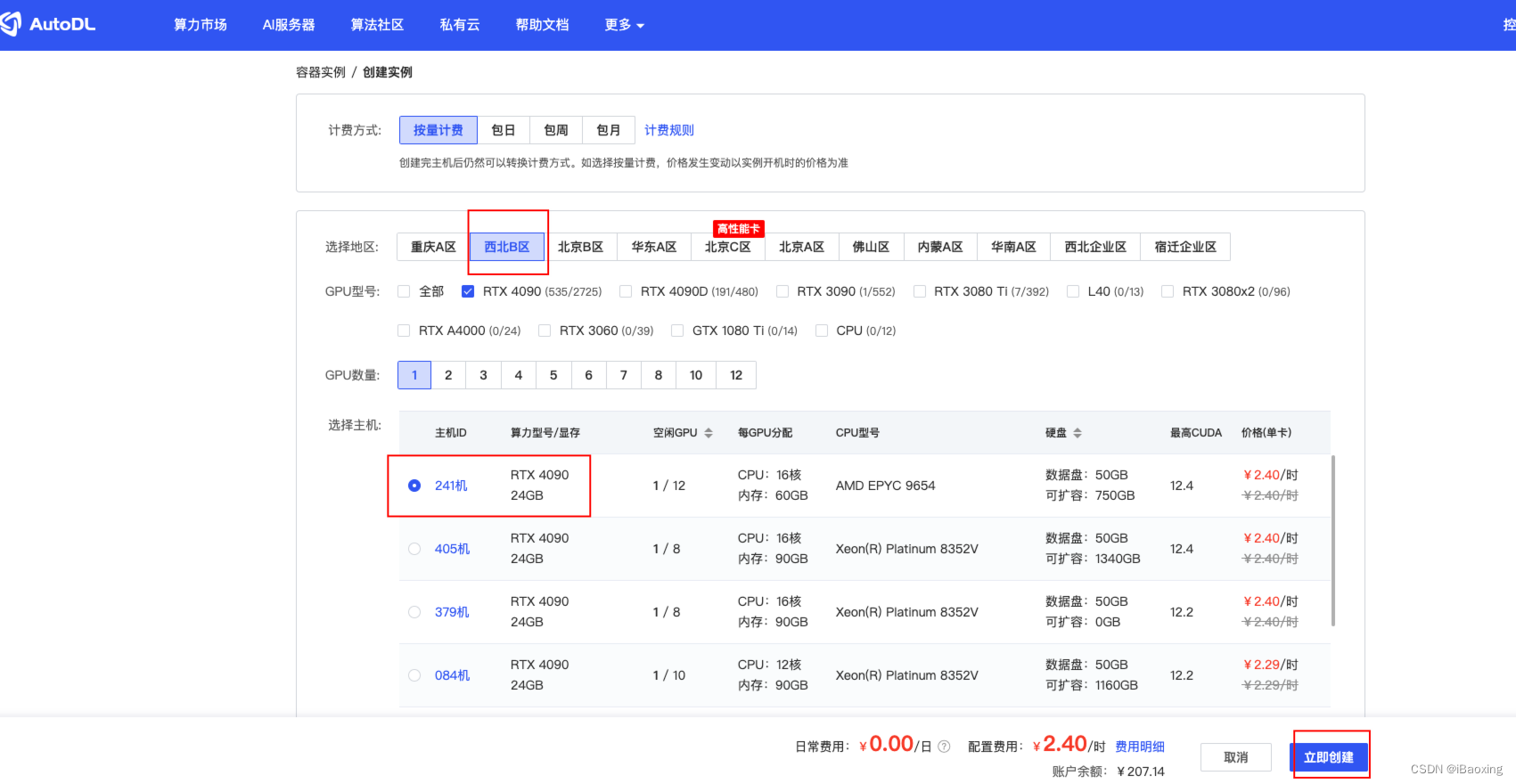

租用新实例

这里选择的西北 B 区、RTX 409024GB

创建虚拟环境并激活

# 安装虚拟环境至数据盘

conda create --prefix /root/autodl-tmp/envs/chatglm3-demo python=3.10

# 激活虚拟环境

conda activate /root/autodl-tmp/envs/chatglm3-demo

拉取ChatGLM3仓库代码

# 开启学术加速

source /etc/network_turbo

# 拉取代码

https://github.com/THUDM/ChatGLM3.git

# 关闭学术加速

unset http_proxy && unset https_proxy

下载依赖

cd ChatGLM3

pip install -r requirements.txt

# 使用 Code Interpreter 需要安装 Jupyter 内核

ipython kernel install --name chatglm3-demo --user

下载模型

地址:https://huggingface.co/THUDM/chatglm3-6b/tree/main

模型下载后放置目录 /root/autodl-tmp/model

修改ChatGLM3/composite_demo/client.py模型目录

/root/autodl-tmp/model/chatglm3-6b

启动

# 启动

streamlit run main.py --server.port=6006 --server.address=127.0.0.1

解决访问报错

# 解决访问报错问题 https://github.com/THUDM/ChatGLM3/issues/1218

# 降级 transformers 库到 4.40.1

pip install transformers==4.40.1

python -c "import transformers; print(transformers.__version__)"

pip install huggingface_hub==0.19.4

python -c "import huggingface_hub; print(huggingface_hub.__version__)"

启动

# 启动

streamlit run main.py --server.port=6006 --server.address=127.0.0.1