一 定义

GPT-4o作为OpenAI推出的一款多模态大型语言模型,代表了这一交互技术的重要发展方向。

GPT-4o是OpenAI推出的最新旗舰级人工智能模型,它是GPT系列的一个重要升级,其中的"o"代表"Omni",中文意思是“全能”,凸显了其多功能特性。该模型被设计为能够实时对音频、视觉和文本进行推理,是迈向更自然人机交互的重要一步。

强调这是一个全能或多模态的模型。GPT-4o的一大特点是其能够处理多种类型的数据输入和输出,包括文本、音频和图像,实现了跨模态的理解和生成能力。这意味着它不仅能理解和生成文本,还能理解音频内容(如语音)和图像信息,并能将这些不同模态的信息综合处理和输出,极大地扩展了AI的应用场景和交互方式。

1)一个原生的多模型大模型,“端到端多模态大模型”。

2)图像,音频两个模态对齐于语言大模型。

背景痛点:在推出GPT-4o之前,使用语音模式与ChatGPT交流的延迟较长,无法直接观察语调、多个说话者或背景噪音,且无法输出笑声、歌唱或表达情感。

解决方案:通过训练一个全新的端到端模型,GPT-4o可以跨越文本、视觉和音频的多模态,将所有输入和输出都由同一个神经网络处理,从而提高了对多模态数据的理解和处理能力。

核心特点:GPT-4o接受任何文本、音频和图像的组合作为输入,并生成任何文本、音频和图像的组合输出。它在语音输入方面的响应速度为232毫秒,平均为320毫秒,与人类对话的响应时间相似。

优势:GPT-4o在文本、推理和编码智能方面表现出与GPT-4 Turbo相当的性能水平,同时在多语言、音频和视觉能力方面创下新的高水平。

安全性和限制:GPT-4o在设计上跨越多种模态,并通过过滤训练数据和后期训练调整模型行为等技术来确保安全性。对于新添加的模态,如音频,GPT-4o认识到存在各种新的风险,并采取了相应的安全干预措施。

总体而言,GPT-4o代表了深度学习在实际可用性方面的最新进展,提供了更加灵活、高效和安全的多模态智能解决方案。

二 基本原理

GPT-4o基于Transformer架构,这是一种深度学习模型,特别适合处理序列数据,如文本、音频波形和图像像素序列。它利用了大规模的预训练方法,在互联网上抓取的海量多模态数据集上进行训练,学习到语言、声音和视觉世界的复杂模式。通过自注意力机制,模型能够理解输入数据中的长程依赖关系,并在生成输出时考虑上下文的全面信息。

与之前的单模态模型相比,GPT-4o通过联合训练实现了跨模态的表示学习,使得模型能够理解不同模态之间的联系,实现更自然、更综合的人机交互。此外,它还优化了推理速度和成本效率,使其更加实用和广泛适用。

以下是GPT-4o的一些关键特点和原理,它们揭示了下一代人机交互技术的可能面貌:

-

多模态交互:GPT-4o支持文本、图像、音频和视频等多种输入模态,能够理解和生成跨模态的内容。这意味着用户可以通过语音、文字、图片或视频与系统交互,而系统也能够以相应的形式提供反馈34。

-

实时处理:GPT-4o能够实时处理语音、视觉和文本信息,响应速度接近人类自然对话的速度4。这为即时交互提供了可能,使得人机对话更加流畅和自然。

-

端到端训练:GPT-4o实现了多模态端到端训练,所有的输入和输出都由同一个神经网络处理。这种设计减少了信息在不同处理阶段之间的丢失,提高了交互的准确性和效率4。

-

性能和效率:GPT-4o在性能上取得了显著提升,运行速度是前代模型的两倍,同时成本减半3。这使得它能够被更广泛地应用于各种场景,包括客户服务、教育、娱乐等领域。

-

情绪识别与响应:GPT-4o能够检测和响应用户的情绪状态,调整其语气和响应方式,使得交互更加自然和有同理心3。

-

安全性:GPT-4o在设计时考虑了安全性,虽然语音模态带来了新的安全挑战,但OpenAI表示已将风险控制在中等水平以下4。

-

可扩展性:GPT-4o的API定价比前代产品便宜,速度更快,调用频率上限更高,这使得开发者和企业能够更容易地将GPT-4o集成到他们的应用程序中4。

-

特殊任务的token:GPT-4o可能采用了特殊的token来标记不同的任务,以便模型能够生成对应的内容,这有助于提高模型在特定任务上的表现4。

通过这些特点和原理,我们可以看到下一代人机交互技术正朝着更加智能、直观和个性化的方向发展。GPT-4o作为这一趋势的代表,展示了未来人机交互的潜力和可能性。下一代人机交互技术的核心在于实现更自然、更直观的交互方式,让机器能够更好地理解和响应人类的指令和需求。

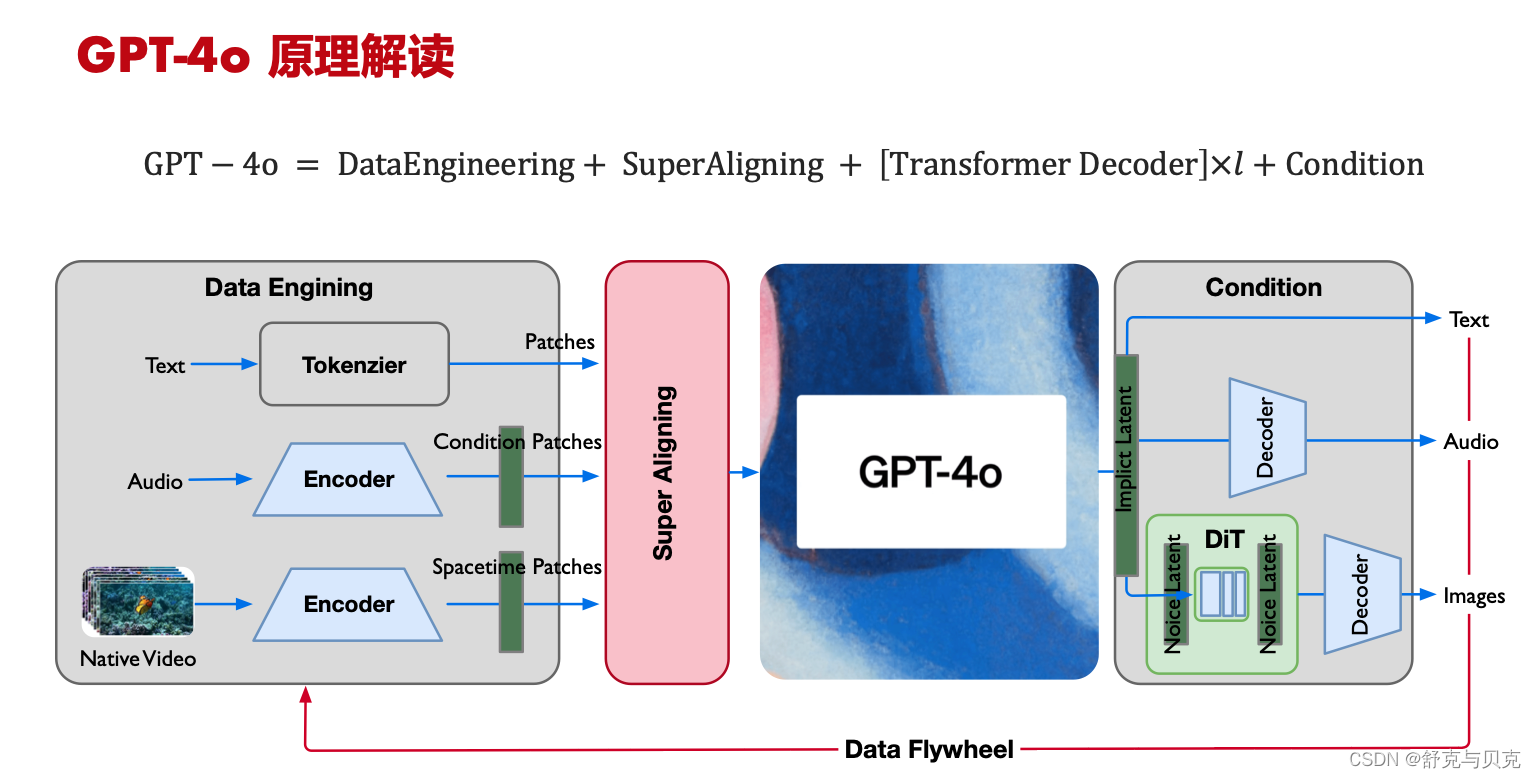

1. Data Engineering(输入)

- 语音输入:通过语音识别系统将用户的语音转换成文本, 参考 Whisper v3 与 Text 结合作为 Multitask training format 再编码

- 图像输入:使用图像识别技术来解析和理解输入的图像内容,借鉴 Sora 的 Spacetime Patches 极致编码压缩;

- 文本输入:LLM 仍然是主战场,投入人力超1/2,将用户的文本输入新的 Tokenizer直接送入模型,

2. Super Aligning(模态融合)

将不同模态的信息转换为统一的内部表示,将语音识别后的文本、图像识别的特征向量等融合。 https://openai.com/index/introducing-superalignment/?utm_source=tldrai

- 端到端 E2E 的 MLM 大模型,对齐不同模态的输入,统一作为 Transformer 结构的长序列输入;

- 让能力弱的大模型监督能力强的大模型(LLM supervise MLM)

3. Transformer Decoder(模型)

- 纯 Transformer Decoder 架构,更加方便训练进行千卡、万卡规模的并行;

- 推理使用大融合算子(Flash Attention)进行极致加速;

- 符合 OpenAI 一贯 Everything Scaling Law 的方式;

4. Output

- 输出可配置、可选择 text/audio/images,因此是 Conducting 的case,统一 Transformers Tokens 输入可实现;

- Images 依然借鉴 SORA 使用 DiT 作为生成,但此处生成的为 Images not Videos;

- Audio 与 Text 应该会有对齐,保持同声传译;

可能要用到的中间件:

-

语音识别系统(ASR):如Whisper v3等,用于将语音转换为文本。

-

图像识别系统:如Sora等,用于图像的解析和特征提取。

-

自然语言处理(NLP)工具:用于文本的预处理、语义理解等。

-

深度学习框架:如TensorFlow、PyTorch,用于构建和训练模型。

-

文本到语音(TTS)系统:如Text-to-Speech API等,用于生成语音输出。

-

多模态融合框架:自定义或开源框架,用于整合不同模态的信息。

-

API网关:用于管理API请求,如API Gateway等。

-

数据存储和处理:如使用MongoDB、Redis等进行数据存储和快速检索。

-

机器学习平台:用于模型的训练和部署,如 AI Platform、AWS SageMaker等。

-

安全和隐私保护:确保数据安全和用户隐私,如使用OAuth、JWT等进行认证和授权。

多模态数据工程:

1.LLM tokens 减少,让大模型的输入序列 Tokens 结合多模态统一为 Signal 长序列;

2.词表增大 Token 减少, 分词从 100K 到 200K,LLM 编码率进一步增强;

3.Video 借鉴 SORA 对 spacetime patch 对时序极高编码率;

模型训练:

1.弱监督/自监督为主,否则多模态对齐进行统一模式训练非常难;

模型结构与训练:

1.通过 Super Aligning 对 Text、Audio、Video 三种模态进行对齐;

2.仍然以 LLM(GPT4) 能力为主,加入多模态维度 Tokens 形成一个大模型;

![[6] CUDA之线程同步](https://img-blog.csdnimg.cn/direct/bd6d3f1547714ea68616e881f66cb55c.png)