文章目录

- 00 环境设置

- 01 部署一个 chat 小模型

- 02 Lagent 运行 InternLM2-chat-7B

- 03 浦语·灵笔2

第二节课程视频与文档:

https://www.bilibili.com/video/BV1AH4y1H78d/

https://github.com/InternLM/Tutorial/blob/camp2/helloworld/hello_world.md

视频和文档内容基本重合,因此这次笔记也同时记录和推进

课程分成这四个部分;社区也随训练营产生了多个兴趣小组:

估计是完成训练营后可以加入其中继续学习和研究。

00 环境设置

完成作业一官方会发放算力点,兑换成开发机的使用配置*时间。

第一次配置开发机需要十分钟左右,后续再开会快很多。

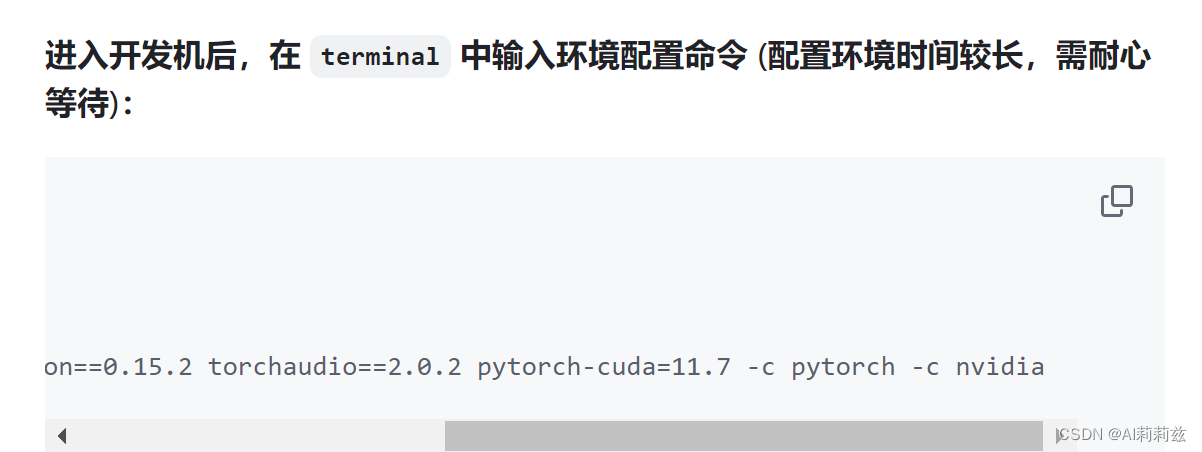

第一个项目需要的算力比较少,因此选择了资源最小的配置+4小时时长,但真正跑起来发现可能时间非常紧张,仅安装环境差不多需要一个小时时间,IO 效率太离谱了……但免费的教学资源也不好多说啥。

忍忍吧。

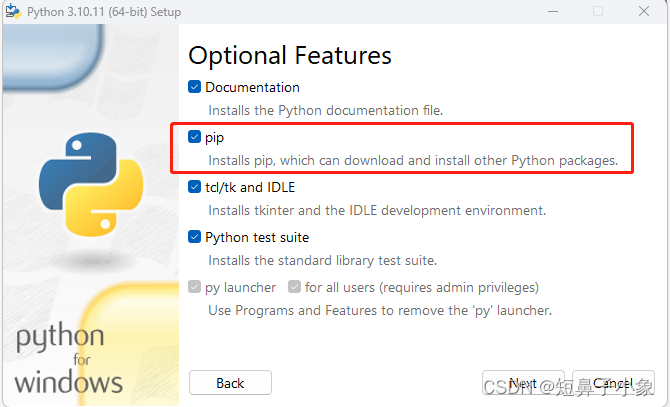

PS. 教程中的等效配置理论上会快一些,注意要把-c pytorch -c nvidia去掉。开发机的网络环境访问不了这些源。

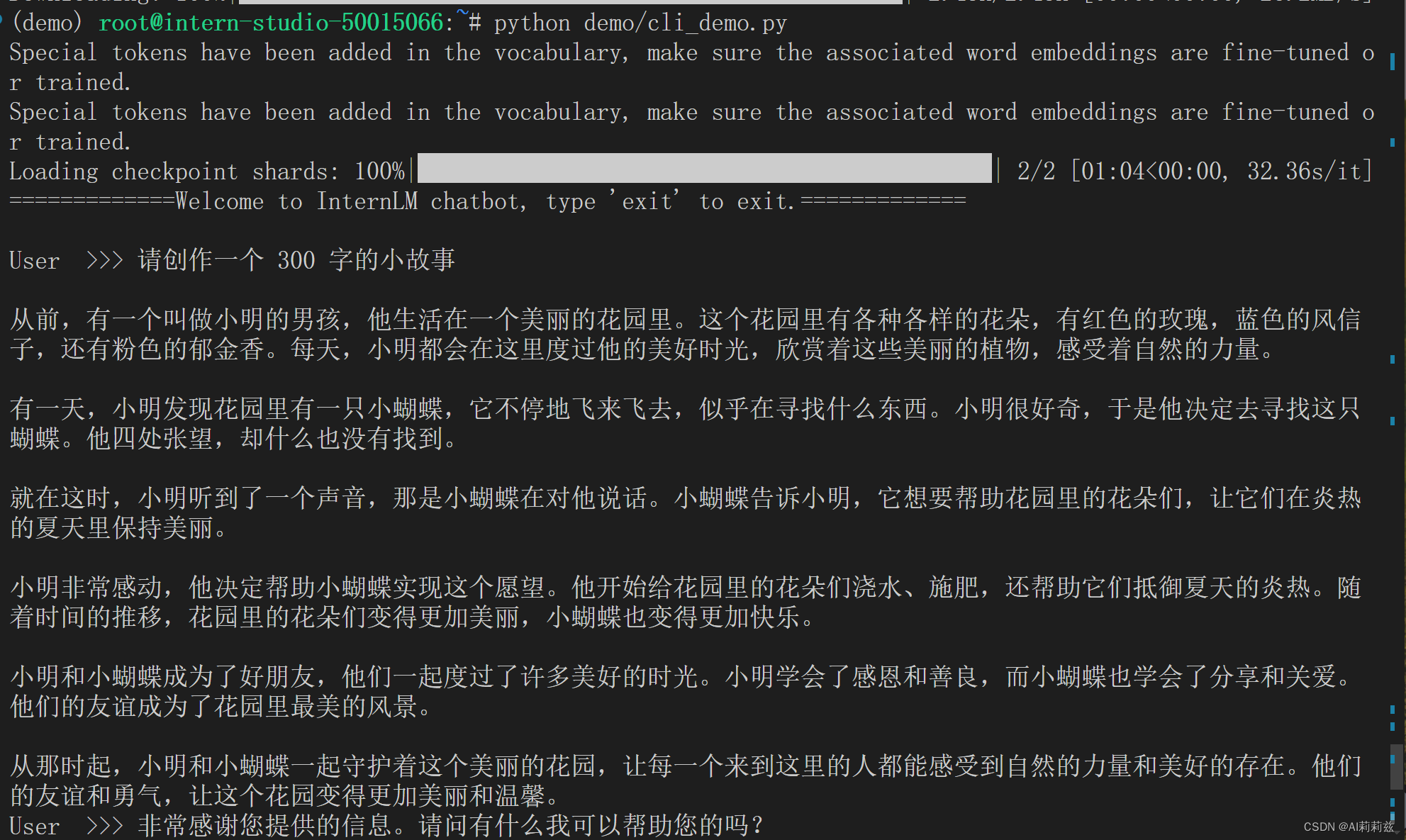

01 部署一个 chat 小模型

安装完环境,剩下的流程就非常简单了。跑过本地模型的人都比较熟悉,教程提供了相应脚本,下载权重,运行脚本加载、推理即可。

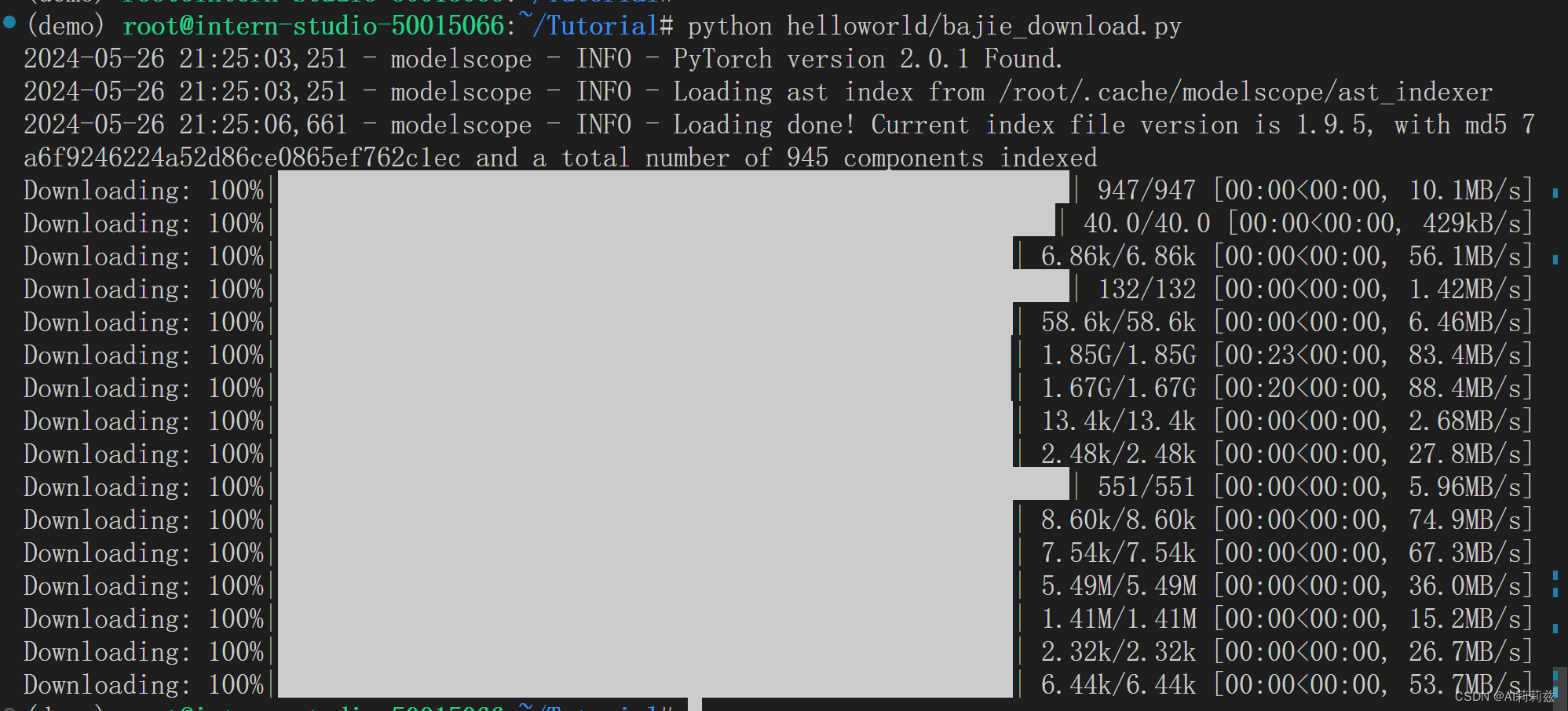

下载八戒微调版本:

可见网速是非常快的,但推理速度比较慢。

运行体验:

python /root/Tutorial/helloworld/bajie_download.py

streamlit run /root/Tutorial/helloworld/bajie_chat.py --server.address 127.0.0.1 --server.port 6006

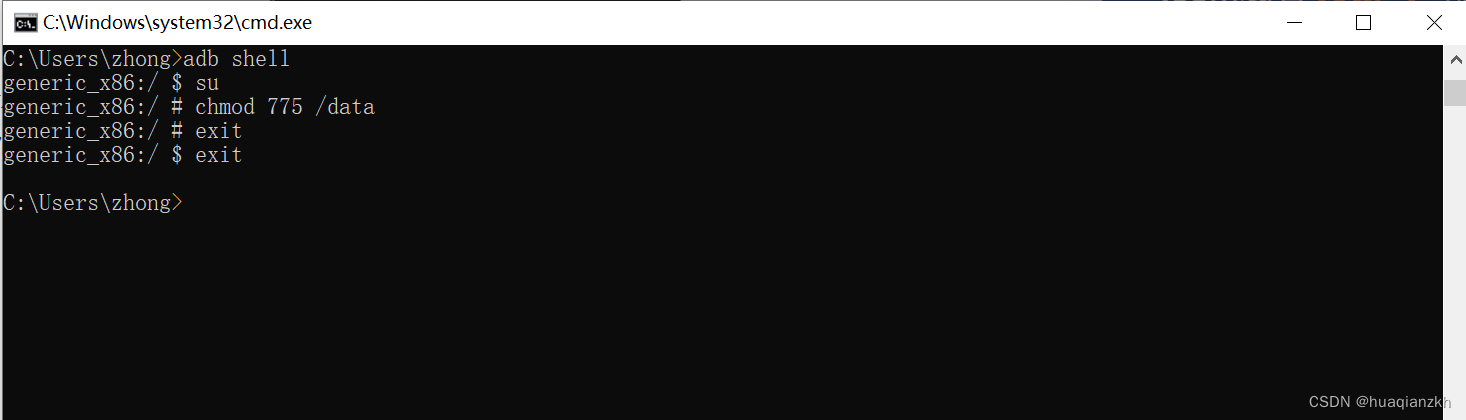

我也是 windows 用户,不过由于上方命令是直接在 IDE 的 terminal 中运行的,VS Code 自动提供了端口转发。

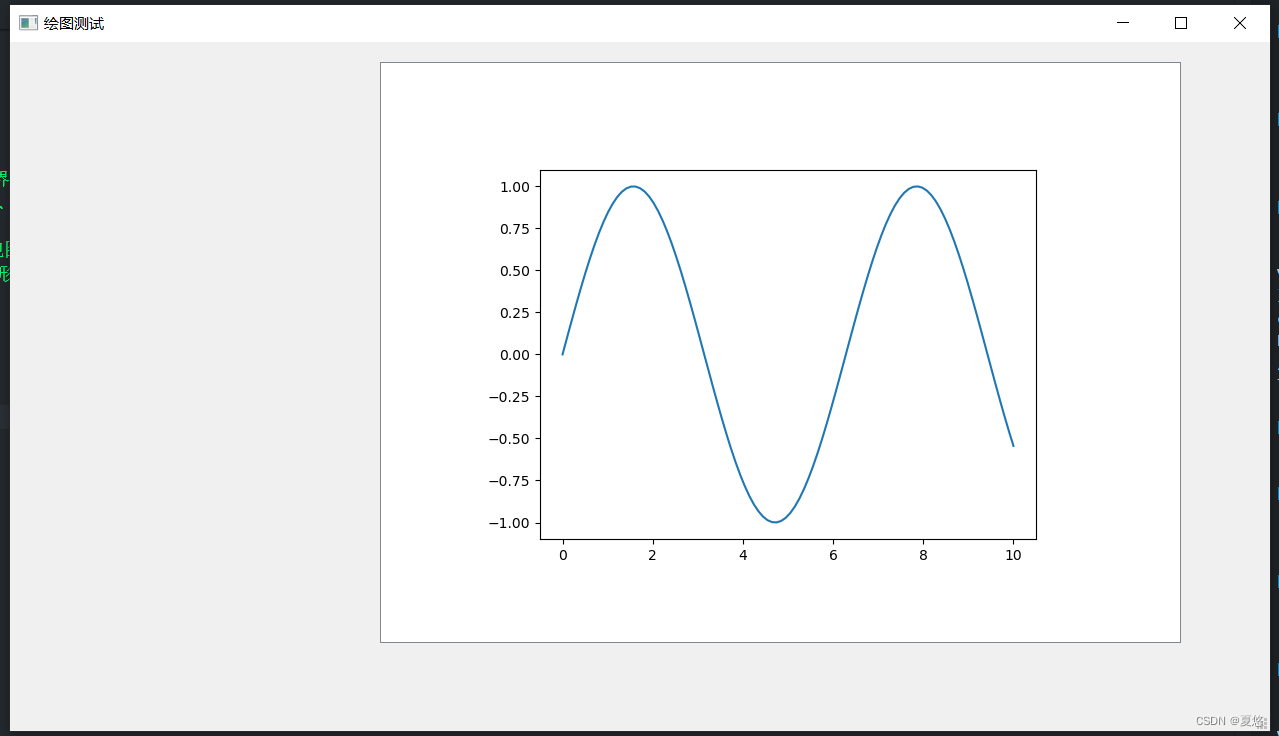

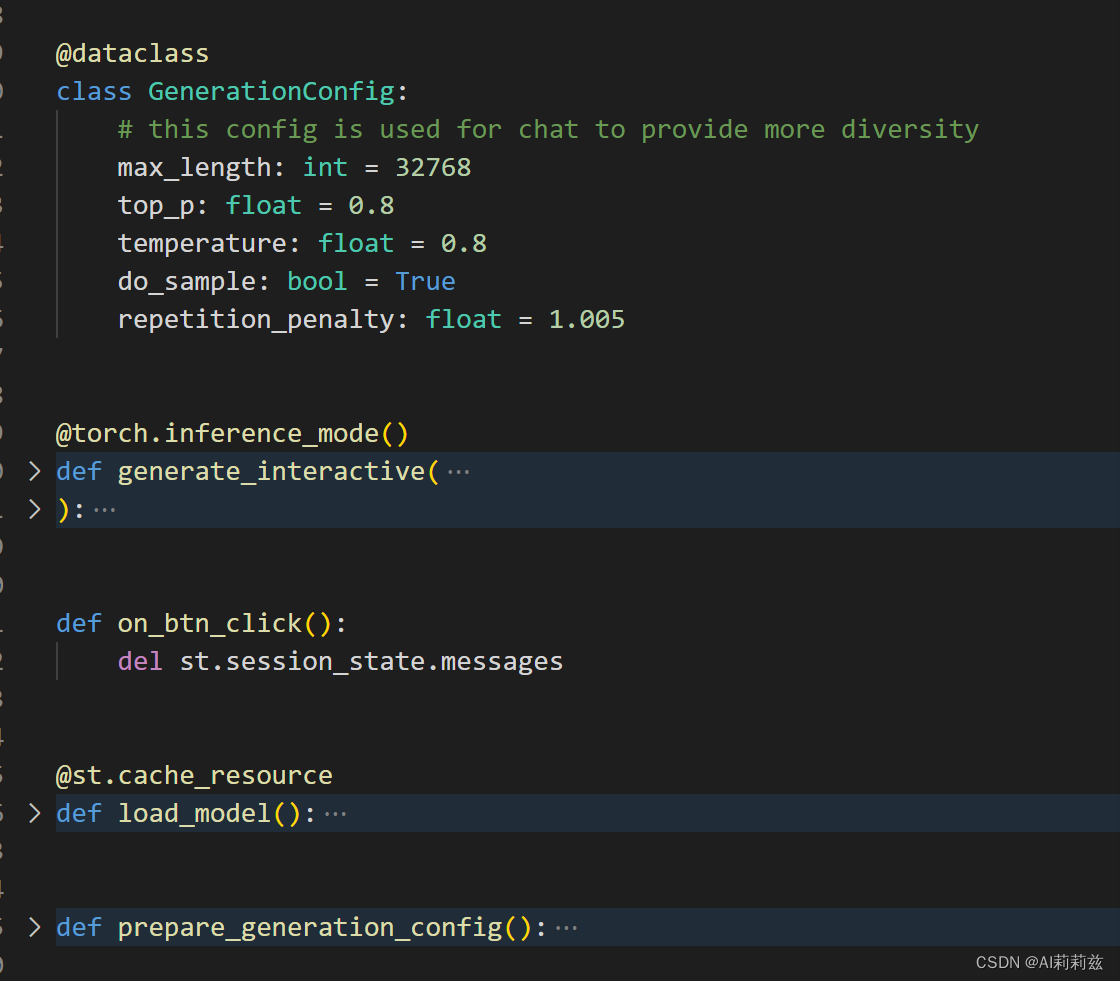

streamlit 提供了在线对话 UI,趁后台在慢悠悠加载模型,去瞅一眼 bajie_chat.py 的代码:

- 生成设置

- 交互处理

- 加载模型

- ……

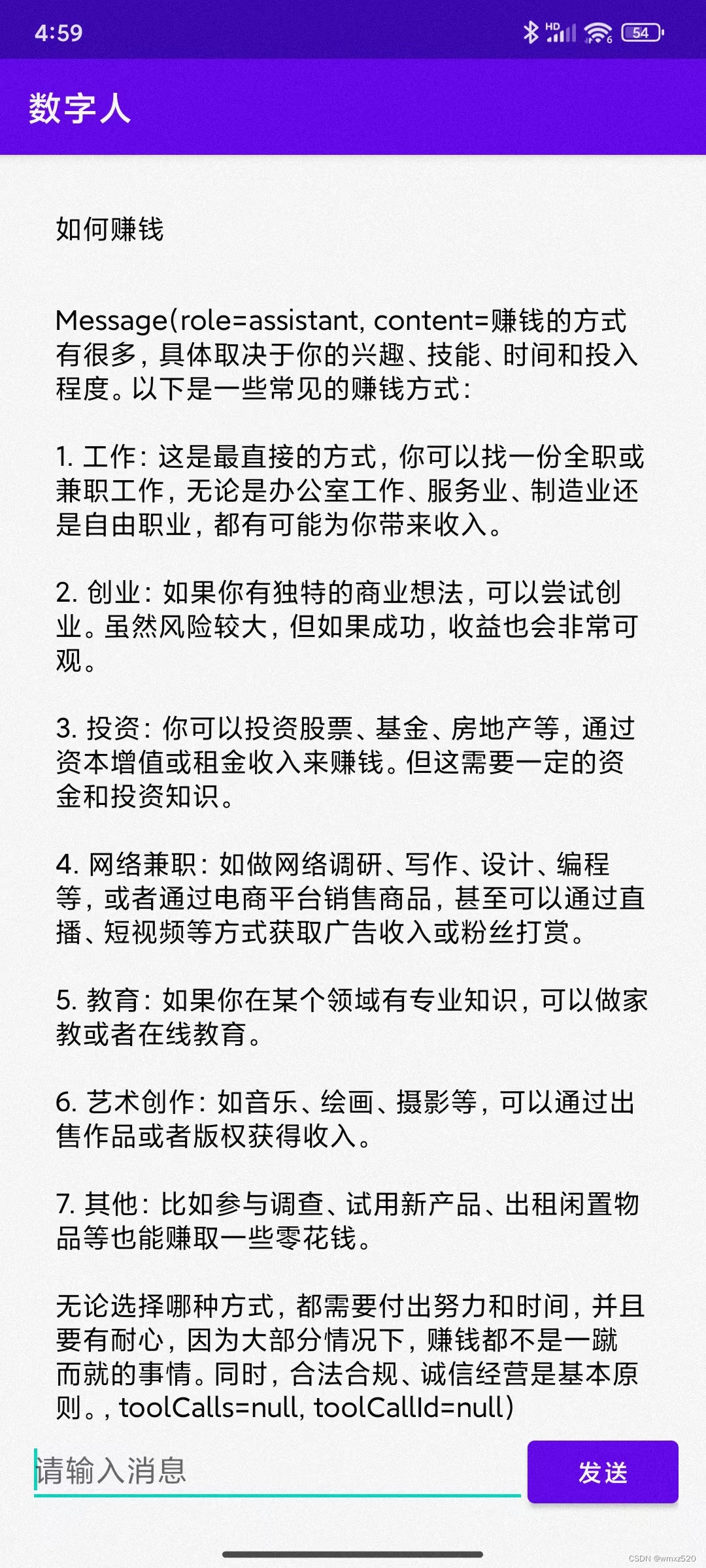

模型加载好了:

换了几条 Query 都能接上,自我认知倒是入心入脑了。

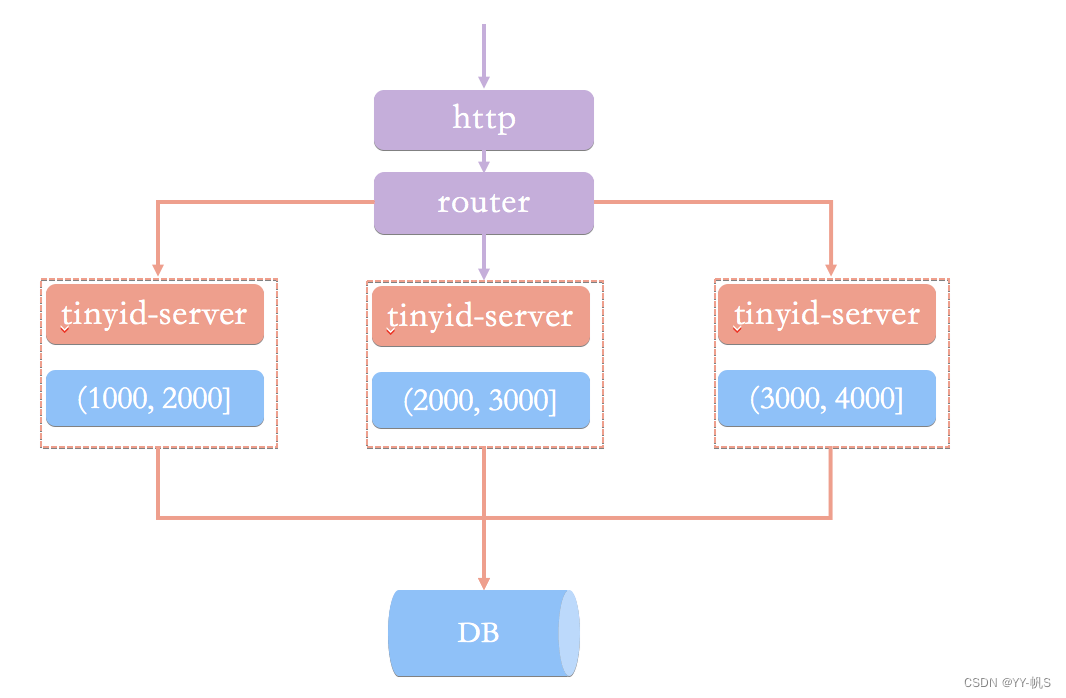

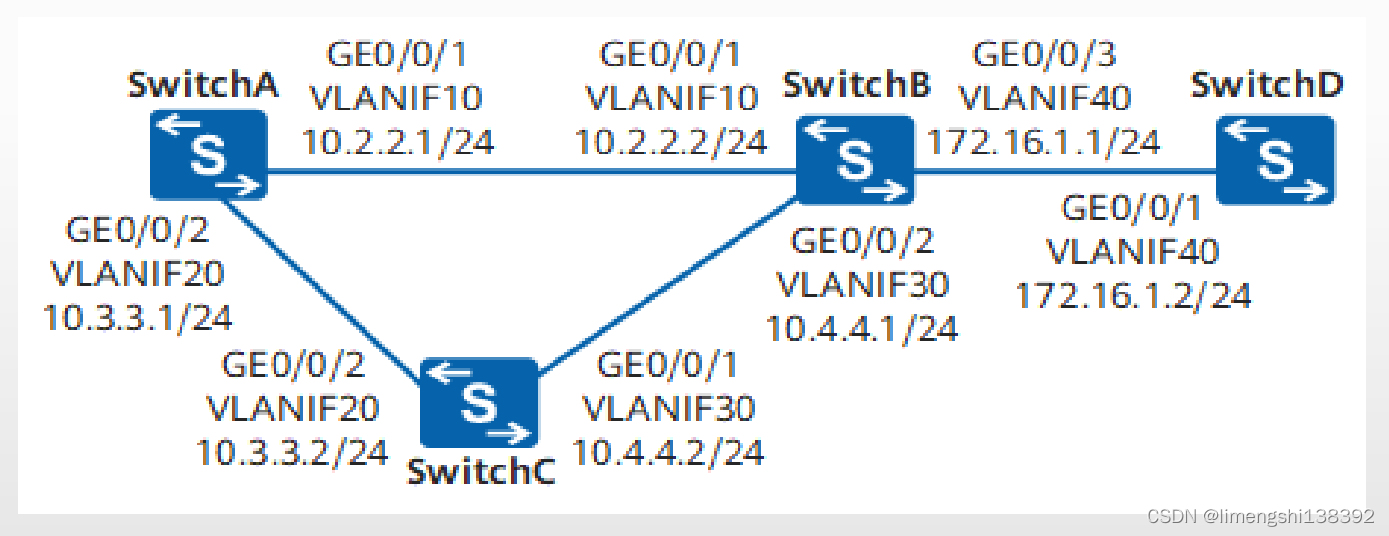

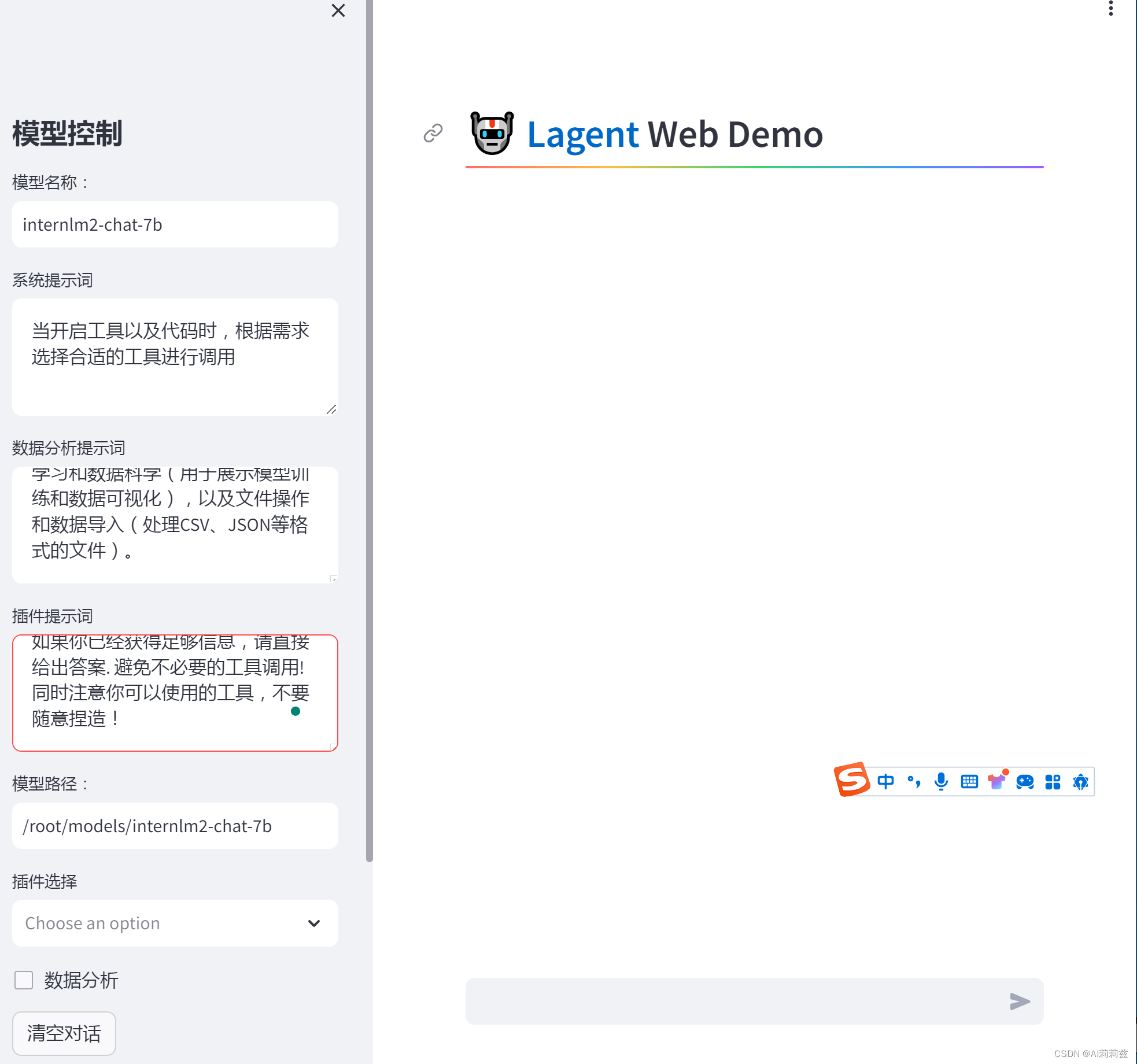

02 Lagent 运行 InternLM2-chat-7B

按照教程下载项目文件并安装,五分钟左右安装完 Lagent 的教学版本并加载模型。

同样,WebIDE 是你的好帮手,直接运行点击弹出的提示跳转到页面即可:

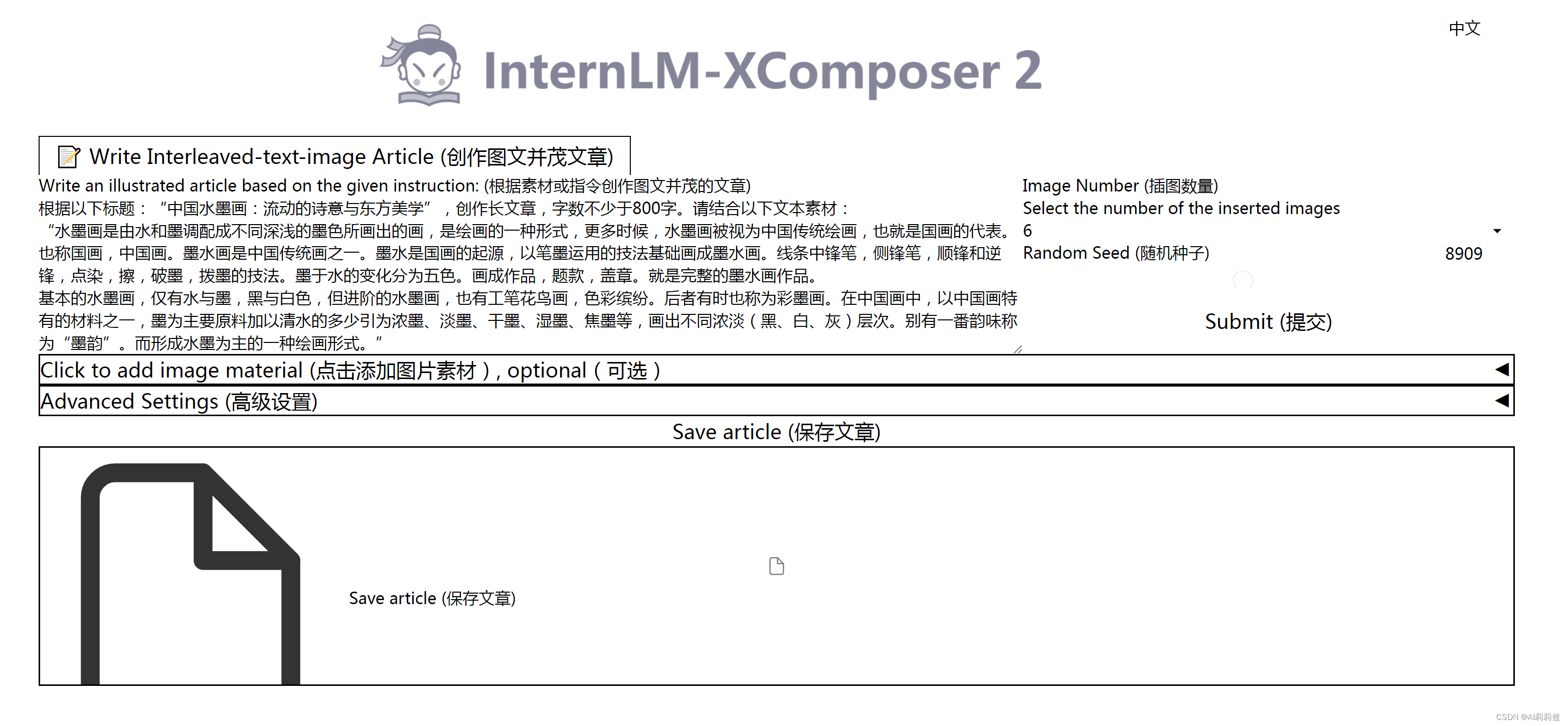

03 浦语·灵笔2

网页怎么没有正常渲染出来呢……

换到 VQA 模型,好像有同样的问题:

不知道问题出在哪……这个作业的花费时间有点超出我预计,第二节容我先这样吧.