文章目录

- 📑前言

- 一、什么是机器学习大模型?

- 1.1 大模型的特点

- 1.2 大模型的技术基础

- 二、大模型的技术实现

- 2.1 Transformer 架构

- 2.2 预训练和微调

- 2.3 模型并行和数据并行

- 三、大模型的应用场景

- 3.1 自然语言处理(NLP)

- 3.2 计算机视觉(CV)

- 3.3 语音处理

- 四、大模型的挑战与未来

- 4.1 挑战

- 4.2 未来趋势

- 五、小结

📑前言

在过去的几年里,机器学习大模型(Large Models)成为了人工智能领域最热门的话题之一。这些大模型通过大规模数据训练,展现出前所未有的能力,推动了自然语言处理、计算机视觉等领域的飞速发展。本文将详细探讨机器学习大模型的基本概念、技术实现、应用场景以及未来的发展趋势。

一、什么是机器学习大模型?

机器学习大模型,通常指的是包含数十亿甚至上千亿参数的深度学习模型。与传统的小规模模型相比,大模型通过大规模数据和计算资源进行训练,能够更好地捕捉复杂的数据模式和特征。例如,OpenAI 的 GPT 系列模型、Google 的 BERT 和 T5、Facebook 的 RoBERTa 等,都是大模型的代表。

1.1 大模型的特点

- 参数量庞大:大模型的参数数量从数亿到上千亿不等。这使得模型能够学习到更为复杂和细腻的数据特征。

- 训练数据规模巨大:大模型通常需要大规模的数据进行训练,这样可以保证模型的泛化能力。

- 计算资源需求高:训练大模型需要大量的计算资源,包括高性能的 GPU 或 TPU 集群。

1.2 大模型的技术基础

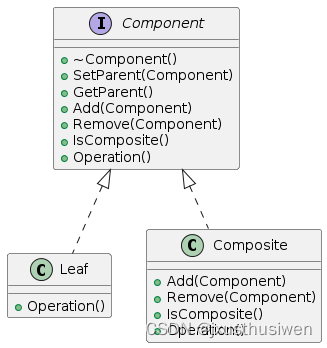

- 深度神经网络(Deep Neural Networks, DNN):大模型主要基于深度神经网络,尤其是变体如卷积神经网络(CNN)、循环神经网络(RNN)和变换器(Transformer)。

- 分布式计算:大模型的训练通常在分布式计算环境中进行,利用多机多卡进行加速。

- 优化算法:如 Adam、LAMB 等优化算法帮助大模型在高维参数空间中找到最优解。

二、大模型的技术实现

2.1 Transformer 架构

Transformer 是大模型的核心架构,最早由 Vaswani 等人在 2017 年提出。它通过自注意力机制(Self-Attention)有效处理序列数据,克服了 RNN 在处理长序列时存在的问题。Transformer 的特点包括:

- 自注意力机制:通过计算序列中每个元素与其他元素的相关性,自注意力机制能够捕捉到全局信息。

- 并行计算:与 RNN 的逐步计算不同,Transformer 能够进行并行计算,显著提升了训练速度。

- 位置编码:为了解决序列数据的顺序问题,Transformer 引入了位置编码,使模型能够识别数据的位置信息。

2.2 预训练和微调

大模型通常采用“预训练+微调”的策略:

- 预训练:在大规模无标签数据上进行预训练,学习通用的数据特征和表示。预训练任务包括语言模型任务、掩码语言模型任务等。

- 微调:在特定任务的数据集上进行微调,使模型适应特定任务需求。微调通常需要的标签数据相对较少,且训练时间较短。

2.3 模型并行和数据并行

- 模型并行:将模型的不同部分分布在不同的计算设备上进行训练,以处理超大规模模型。

- 数据并行:将数据分块分发到不同的计算设备上进行并行训练,每个设备训练一个模型副本,并周期性地同步梯度。

三、大模型的应用场景

3.1 自然语言处理(NLP)

- 文本生成:大模型如 GPT 系列在文本生成方面表现出色,能够生成高质量的文章、对话、代码等。例如,GPT-3 可以根据给定的开头生成完整的文章或回答问题。

- 机器翻译:大模型在多语言机器翻译中表现出色,如 Google 的 T5 模型在多语言翻译任务中达到了新的性能高度。

- 情感分析:通过大模型,可以准确分析文本中的情感倾向,为客户反馈、舆情监控等提供支持。

3.2 计算机视觉(CV)

- 图像分类:大模型如 ResNet、EfficientNet 在图像分类任务上取得了显著的性能提升,广泛应用于自动驾驶、安防监控等领域。

- 目标检测:大模型在目标检测任务上同样表现优异,可以精确识别图像中的目标物体,如人脸识别、车辆检测等。

- 图像生成:如 GAN(生成对抗网络)和 VAE(变分自编码器)等大模型能够生成高质量的图像,应用于图像修复、风格转换等领域。

3.3 语音处理

- 语音识别:大模型在语音识别任务上表现优异,如 Google 的 WaveNet 可以生成高质量的语音。

- 语音合成:大模型能够合成自然流畅的语音,用于语音助手、导航等应用。

四、大模型的挑战与未来

4.1 挑战

- 计算资源需求高:大模型的训练和推理需要大量的计算资源,尤其是在参数量达到千亿级别时,对计算集群的要求极高。

- 数据隐私和安全:大模型需要大量的数据进行训练,这引发了关于数据隐私和安全的问题,如何在保护用户隐私的前提下进行大规模数据训练是一个重要挑战。

- 模型可解释性:大模型虽然在性能上取得了显著提升,但其内部机制复杂,难以解释和理解,给应用和监管带来挑战。

4.2 未来趋势

- 高效模型训练:未来的研究将致力于开发更高效的训练算法和架构,降低大模型的计算资源需求。例如,稀疏化模型、混合精度训练等技术将得到更多关注。

- 模型压缩与加速:通过模型剪枝、量化等技术,进一步压缩模型规模,提高推理速度,降低部署成本。

- 跨模态学习:结合多种数据模态(如图像、文本、音频)的大模型将成为研究热点,实现更加智能和全面的人工智能应用。

- 自动化机器学习(AutoML):通过自动化搜索和优化算法,简化大模型的设计和训练过程,降低使用门槛。

五、小结

机器学习大模型正以前所未有的速度推动人工智能技术的发展。从自然语言处理到计算机视觉、语音处理,大模型在各个领域都展示了强大的能力。然而,大模型的应用也面临着计算资源、数据隐私和模型可解释性等挑战。未来,随着技术的进步和研究的深入,我们有理由相信,机器学习大模型将在更多领域得到应用,带来更多创新和变革。

![P4097 【模板】李超线段树 / [HEOI2013] Segment 题解](https://img-blog.csdnimg.cn/direct/a3011712214a4ee0a578ccc9b0e63916.png#pic_center)