LlaMA 3 系列博客

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (一)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (二)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (三)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (四)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (五)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (六)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (七)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (八)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (九)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (十)

构建安全的GenAI/LLMs核心技术解密之大模型对抗攻击(一)

构建安全的GenAI/LLMs核心技术解密之大模型对抗攻击(二)

构建安全的GenAI/LLMs核心技术解密之大模型对抗攻击(三)

构建安全的GenAI/LLMs核心技术解密之大模型对抗攻击(四)

构建安全的GenAI/LLMs核心技术解密之大模型对抗攻击(五)

你好 GPT-4o!

大模型标记器之Tokenizer可视化(GPT-4o)

大模型标记器 Tokenizer之Byte Pair Encoding (BPE) 算法详解与示例

大模型标记器 Tokenizer之Byte Pair Encoding (BPE)源码分析

大模型之自注意力机制Self-Attention(一)

大模型之自注意力机制Self-Attention(二)

大模型之自注意力机制Self-Attention(三)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (十一)

Llama 3 模型家族构建安全可信赖企业级AI应用之 Code Llama (一)

Llama 3 模型家族构建安全可信赖企业级AI应用之 Code Llama (二)

Llama 3 模型家族构建安全可信赖企业级AI应用之 Code Llama (三)

Llama 3 模型家族构建安全可信赖企业级AI应用之 Code Llama (四)

Llama 3 模型家族构建安全可信赖企业级AI应用之 Code Llama (五)

Llama 3 模型家族构建安全可信赖企业级AI应用之使用 Llama Guard 保护大模型对话(一)

Llama 3 模型家族构建安全可信赖企业级AI应用之使用 Llama Guard 保护大模型对话(二)

Llama 3 模型家族构建安全可信赖企业级AI应用之使用 Llama Guard 保护大模型对话(三)

大模型之深入理解Transformer位置编码(Positional Embedding)

大模型之深入理解Transformer Layer Normalization(一)

大模型之深入理解Transformer Layer Normalization(二)

大模型之深入理解Transformer Layer Normalization(三)

大模型之一步一步使用PyTorch编写Meta的Llama 3代码(一)初学者的起点

大模型之一步一步使用PyTorch编写Meta的Llama 3代码(二)矩阵操作的演练

大模型之一步一步使用PyTorch编写Meta的Llama 3代码(三)初始化一个嵌入层

大模型之一步一步使用PyTorch编写Meta的Llama 3代码(四)预先计算 RoPE 频率

大模型之一步一步使用PyTorch编写Meta的Llama 3代码(五)预先计算因果掩码

大模型之一步一步使用PyTorch编写Meta的Llama 3代码(六)首次归一化:均方根归一化(RMSNorm)

大模型之一步一步使用PyTorch编写Meta的Llama 3代码(七) 初始化多查询注意力

大模型之一步一步使用PyTorch编写Meta的Llama 3代码(八)旋转位置嵌入

大模型之一步一步使用PyTorch编写Meta的Llama 3代码(九) 计算自注意力

大模型之一步一步使用PyTorch编写Meta的Llama 3代码(十) 残差连接及SwiGLU FFN

大模型之一步一步使用PyTorch编写Meta的Llama 3代码(十一)输出概率分布 及损失函数计算

大模型之使用PyTorch编写Meta的Llama 3实际功能代码(一)加载简化分词器及设置参数

大模型之使用PyTorch编写Meta的Llama 3实际功能代码(二)RoPE 及注意力机制

大模型之使用PyTorch编写Meta的Llama 3实际功能代码(三) FeedForward 及 Residual Layers

大模型之使用PyTorch编写Meta的Llama 3实际功能代码(四) 构建 Llama3 类模型本身

大模型之使用PyTorch编写Meta的Llama 3实际功能代码(五)训练并测试你自己的 minLlama3

大模型之使用PyTorch编写Meta的Llama 3实际功能代码(六)加载已经训练好的miniLlama3模型

Llama 3 模型家族构建安全可信赖企业级AI应用之使用 Llama Guard 保护大模型对话 (四)

Llama 3 模型家族构建安全可信赖企业级AI应用之使用 Llama Guard 保护大模型对话 (五)

Llama 3 模型家族构建安全可信赖企业级AI应用之使用 Llama Guard 保护大模型对话 (六)

Llama 3 模型家族构建安全可信赖企业级AI应用之使用 Llama Guard 保护大模型对话 (七)

Llama 3 模型家族构建安全可信赖企业级AI应用之使用 Llama Guard 保护大模型对话 (八)

Llama 3 模型家族构建安全可信赖企业级AI应用之 CyberSecEval 2:量化 LLM 安全和能力的基准(一)

Llama 3 模型家族构建安全可信赖企业级AI应用之 CyberSecEval 2:量化 LLM 安全和能力的基准(二)

Llama 3 模型家族构建安全可信赖企业级AI应用之 CyberSecEval 2:量化 LLM 安全和能力的基准(三)

Llama 3 模型家族构建安全可信赖企业级AI应用之 CyberSecEval 2:量化 LLM 安全和能力的基准(四)

Llama 3 模型家族构建安全可信赖企业级AI应用之code shield(一)Code Shield简介

Llama 3 模型家族构建安全可信赖企业级AI应用之code shield(二)防止 LLM 生成不安全代码

Llama 3 模型家族构建安全可信赖企业级AI应用之code shield(三)Code Shield代码示例

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微调预训练Llama 3 语言模型(一) LLaMA-Factory简介

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微调预训练Llama 3 语言模型(二) LLaMA-Factory训练方法及数据集

大模型之Ollama:在本地机器上释放大型语言模型的强大功能

大型语言模型 (LLM) 已成为行业变革者,能够生成人类质量的文本、翻译语言以及编写不同类型的创意内容。然而,它们的传统用途需要访问强大的云资源,因此许多个人无法获得它们。

开源框架 Ollama 打破了这一障碍,它允许你直接在本地机器上运行这些强大的模型。这开辟了一个充满可能性的世界,使你能够:

- 激发创造力:产生想法、集思广益、撰写诗歌或剧本等不同创意格式,甚至翻译现有内容。苦于想不出吸引人的标题或引人入胜的开场白?Ollama 可以帮助你克服写作障碍并激发新的灵感。

- 提高写作质量:核实信息,确保事实准确性,改写句子以提高清晰度,并生成替代措辞以使你的写作更流畅。Ollama 可以成为你的个人编辑,帮助你完善作品的写作风格。

- 自动执行任务:厌倦了总结长篇文章或创建大纲?Ollama 可以为你处理这些重复性任务,让你有时间专注于工作中更具创造性的方面。此外,你还可以为特定受众生成不同版本的内容,从而简化内容创建流程。

开始使用 Ollama

下载安装 Ollama

登录https://ollama.com/ 网站下载。

下载以后,点击OllamaSetup.exe 应用程序直接安装。

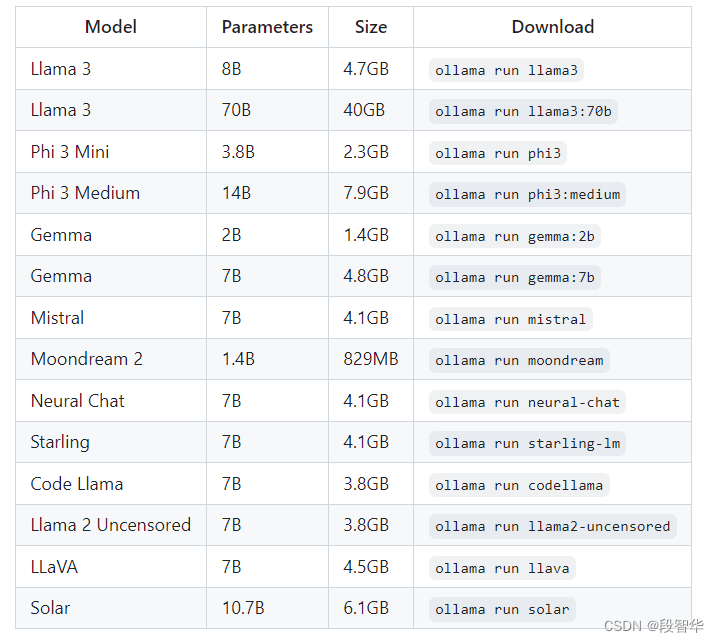

选择大模型

https://ollama.com/library

Ollama 提供了一个预先训练好的模型库,每个模型都有不同的功能和优势。 Llama-3 模型是一个很好的起点,但探索 Ollama 网站https://github.com/ollama/ollama上的可用选项可以让您找到最适合您特定需求的模型。

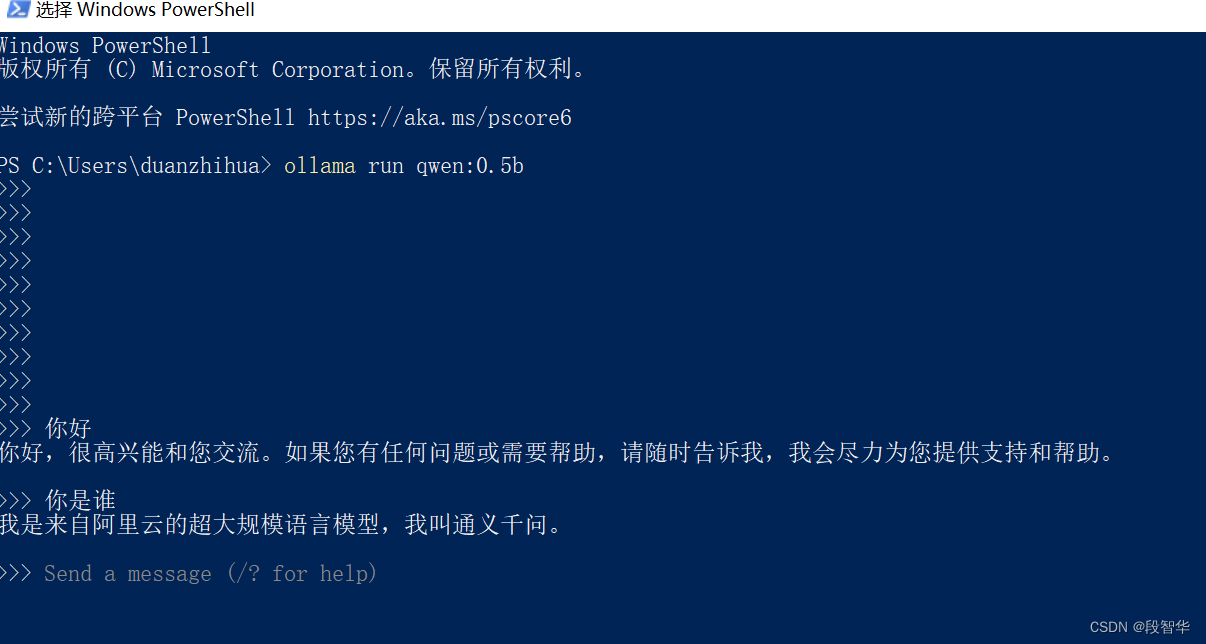

以交互模式使用 Ollama:

下载模型:打开终端并输入以下命令,替换<model_name>为你要下载的模型的名称(例如llama2):

ollama pull <model_name>

运行模型:下载后,使用此命令开始与 LLM 对话:

ollama run <model_name>

Ollama 除了其交互模式之外,还通过代码集成提供编程交互,允许直接向 LLM 发送提示并在代码中接收响应。以下是与 Ollama 的代码集成概述:

要求:

- Python: Ollama 的代码集成依赖于 Python。请确保您的系统上安装了 Python 3.7 或更高版本。

- Ollama 库:您需要安装 Ollama 库。可以使用 完成pip install ollama。

python基本集成:

from langchain.prompts import PromptTemplate

from langchain.chains import LLMChain

from langchain_community.llms import Ollama

prompt_template = "请写一首关于{product}的诗,我希望是七言律诗"

# ollama run qwen:0.5b

ollama_llm = Ollama(model="qwen:0.5b")

llm_chain = LLMChain(

llm = ollama_llm,

prompt = PromptTemplate.from_template(prompt_template)

)

result=llm_chain.invoke("春天")

print(result)

运行结果为

python.exe d:/2024_PEFT_LoRA_Train/2024-PurpleLlama-main/CodeShield/sam_test/ollama_test.py

E:\Users\duanzhihua\Anaconda3\envs\chatgpt_book_2023\Lib\site-packages\langchain_core\_api\deprecation.py:119: LangChainDeprecationWarning: The class `LLMChain` was deprecated in LangChain 0.1.17 and will be removed in 0.3.0. Use RunnableSequence, e.g., `prompt | llm` instead.

warn_deprecated(

{'product': '春天', 'text': '春风拂面柔,万物复苏春常驻。\n桃李芬芳满枝开,鱼跃龙门展雄姿。\n人间四月芳菲尽,百鸟齐鸣春意浓

。'}

优点:

- 可访问性: Ollama 消除了无法使用昂贵云资源或缺乏使用基于云的 LLM 所需技术专业知识的个人的准入门槛。这为更广泛的受众探索和试验 LLM 敞开了大门。

- 定制: Ollama 允许您从各种预先训练的模型中进行选择,甚至可以针对特定任务对其进行微调。这种级别的定制使用户能够根据自己的独特需求和偏好定制 LLM 的功能。

- 控制:通过本地执行,您可以完全控制 LLM 的操作。这意味着您可以调整设置、尝试不同的配置,并根据自己的喜好微调模型的行为。

缺点:

- 计算要求:虽然 Ollama 允许使用本地 LLM,但这些模型仍然需要大量计算资源,尤其是对于更大、更复杂的模型。对于硬件能力有限的用户来说,这可能是一个限制因素,可能会导致性能问题,例如响应时间慢甚至模型崩溃。

- 功能有限:与基于云的 LLM 解决方案相比,Ollama 可能提供更有限的功能。这是因为与强大的云服务器相比,本地机器通常具有较少的可用资源。

社区集成

Open WebUI

Enchanted (macOS native)

Hollama

Lollms-Webui

LibreChat

Bionic GPT

HTML UI

Saddle

Chatbot UI

Chatbot UI v2

Typescript UI

Minimalistic React UI for Ollama Models

Ollamac

big-AGI

Cheshire Cat assistant framework

Amica

chatd

Ollama-SwiftUI

Dify.AI

MindMac

NextJS Web Interface for Ollama

Msty

Chatbox

WinForm Ollama Copilot

NextChat with Get Started Doc

Alpaca WebUI

OllamaGUI

OpenAOE

Odin Runes

LLM-X (Progressive Web App)

AnythingLLM (Docker + MacOs/Windows/Linux native app)

Ollama Basic Chat: Uses HyperDiv Reactive UI

Ollama-chats RPG

QA-Pilot (Chat with Code Repository)

ChatOllama (Open Source Chatbot based on Ollama with Knowledge Bases)

CRAG Ollama Chat (Simple Web Search with Corrective RAG)

RAGFlow (Open-source Retrieval-Augmented Generation engine based on deep document understanding)

StreamDeploy (LLM Application Scaffold)

chat (chat web app for teams)

Lobe Chat with Integrating Doc

Ollama RAG Chatbot (Local Chat with multiple PDFs using Ollama and RAG)

BrainSoup (Flexible native client with RAG & multi-agent automation)

macai (macOS client for Ollama, ChatGPT, and other compatible API back-ends)

相关库

LangChain and LangChain.js with example

LangChainGo with example

LangChain4j with example

LlamaIndex

LiteLLM

OllamaSharp for .NET

Ollama for Ruby

Ollama-rs for Rust

Ollama4j for Java

ModelFusion Typescript Library

OllamaKit for Swift

Ollama for Dart

Ollama for Laravel

LangChainDart

Semantic Kernel - Python

Haystack

Elixir LangChain

Ollama for R - rollama

Ollama for R - ollama-r

Ollama-ex for Elixir

Ollama Connector for SAP ABAP

Testcontainers

Portkey

PromptingTools.jl with an example

LlamaScript

扩展插件

Raycast extension

Discollama (Discord bot inside the Ollama discord channel)

Continue

Obsidian Ollama plugin

Logseq Ollama plugin

NotesOllama (Apple Notes Ollama plugin)

Dagger Chatbot

Discord AI Bot

Ollama Telegram Bot

Hass Ollama Conversation

Rivet plugin

Obsidian BMO Chatbot plugin

Cliobot (Telegram bot with Ollama support)

Copilot for Obsidian plugin

Obsidian Local GPT plugin

Open Interpreter

Llama Coder (Copilot alternative using Ollama)

Ollama Copilot (Proxy that allows you to use ollama as a copilot like Github copilot)

twinny (Copilot and Copilot chat alternative using Ollama)

Wingman-AI (Copilot code and chat alternative using Ollama and HuggingFace)

Page Assist (Chrome Extension)

AI Telegram Bot (Telegram bot using Ollama in backend)

AI ST Completion (Sublime Text 4 AI assistant plugin with Ollama support)

Discord-Ollama Chat Bot (Generalized TypeScript Discord Bot w/ Tuning Documentation)

Discord AI chat/moderation bot Chat/moderation bot written in python. Uses Ollama to create personalities.

大模型技术分享

《企业级生成式人工智能LLM大模型技术、算法及案例实战》线上高级研修讲座

模块一:Generative AI 原理本质、技术内核及工程实践周期详解

模块二:工业级 Prompting 技术内幕及端到端的基于LLM 的会议助理实战

模块三:三大 Llama 2 模型详解及实战构建安全可靠的智能对话系统

模块四:生产环境下 GenAI/LLMs 的五大核心问题及构建健壮的应用实战

模块五:大模型应用开发技术:Agentic-based 应用技术及案例实战

模块六:LLM 大模型微调及模型 Quantization 技术及案例实战

模块七:大模型高效微调 PEFT 算法、技术、流程及代码实战进阶

模块八:LLM 模型对齐技术、流程及进行文本Toxicity 分析实战

模块九:构建安全的 GenAI/LLMs 核心技术Red Teaming 解密实战

模块十:构建可信赖的企业私有安全大模型Responsible AI 实战

Llama3关键技术深度解析与构建Responsible AI、算法及开发落地实战

1、Llama开源模型家族大模型技术、工具和多模态详解:学员将深入了解Meta Llama 3的创新之处,比如其在语言模型技术上的突破,并学习到如何在Llama 3中构建trust and safety AI。他们将详细了解Llama 3的五大技术分支及工具,以及如何在AWS上实战Llama指令微调的案例。

2、解密Llama 3 Foundation Model模型结构特色技术及代码实现:深入了解Llama 3中的各种技术,比如Tiktokenizer、KV Cache、Grouped Multi-Query Attention等。通过项目二逐行剖析Llama 3的源码,加深对技术的理解。

3、解密Llama 3 Foundation Model模型结构核心技术及代码实现:SwiGLU Activation Function、FeedForward Block、Encoder Block等。通过项目三学习Llama 3的推理及Inferencing代码,加强对技术的实践理解。

4、基于LangGraph on Llama 3构建Responsible AI实战体验:通过项目四在Llama 3上实战基于LangGraph的Responsible AI项目。他们将了解到LangGraph的三大核心组件、运行机制和流程步骤,从而加强对Responsible AI的实践能力。

5、Llama模型家族构建技术构建安全可信赖企业级AI应用内幕详解:深入了解构建安全可靠的企业级AI应用所需的关键技术,比如Code Llama、Llama Guard等。项目五实战构建安全可靠的对话智能项目升级版,加强对安全性的实践理解。

6、Llama模型家族Fine-tuning技术与算法实战:学员将学习Fine-tuning技术与算法,比如Supervised Fine-Tuning(SFT)、Reward Model技术、PPO算法、DPO算法等。项目六动手实现PPO及DPO算法,加强对算法的理解和应用能力。

7、Llama模型家族基于AI反馈的强化学习技术解密:深入学习Llama模型家族基于AI反馈的强化学习技术,比如RLAIF和RLHF。项目七实战基于RLAIF的Constitutional AI。

8、Llama 3中的DPO原理、算法、组件及具体实现及算法进阶:学习Llama 3中结合使用PPO和DPO算法,剖析DPO的原理和工作机制,详细解析DPO中的关键算法组件,并通过综合项目八从零开始动手实现和测试DPO算法,同时课程将解密DPO进阶技术Iterative DPO及IPO算法。

9、Llama模型家族Safety设计与实现:在这个模块中,学员将学习Llama模型家族的Safety设计与实现,比如Safety in Pretraining、Safety Fine-Tuning等。构建安全可靠的GenAI/LLMs项目开发。

10、Llama 3构建可信赖的企业私有安全大模型Responsible AI系统:构建可信赖的企业私有安全大模型Responsible AI系统,掌握Llama 3的Constitutional AI、Red Teaming。

解码Sora架构、技术及应用

一、为何Sora通往AGI道路的里程碑?

1,探索从大规模语言模型(LLM)到大规模视觉模型(LVM)的关键转变,揭示其在实现通用人工智能(AGI)中的作用。

2,展示Visual Data和Text Data结合的成功案例,解析Sora在此过程中扮演的关键角色。

3,详细介绍Sora如何依据文本指令生成具有三维一致性(3D consistency)的视频内容。 4,解析Sora如何根据图像或视频生成高保真内容的技术路径。

5,探讨Sora在不同应用场景中的实践价值及其面临的挑战和局限性。

二、解码Sora架构原理

1,DiT (Diffusion Transformer)架构详解

2,DiT是如何帮助Sora实现Consistent、Realistic、Imaginative视频内容的?

3,探讨为何选用Transformer作为Diffusion的核心网络,而非技术如U-Net。

4,DiT的Patchification原理及流程,揭示其在处理视频和图像数据中的重要性。

5,Conditional Diffusion过程详解,及其在内容生成过程中的作用。

三、解码Sora关键技术解密

1,Sora如何利用Transformer和Diffusion技术理解物体间的互动,及其对模拟复杂互动场景的重要性。

2,为何说Space-time patches是Sora技术的核心,及其对视频生成能力的提升作用。

3,Spacetime latent patches详解,探讨其在视频压缩和生成中的关键角色。

4,Sora Simulator如何利用Space-time patches构建digital和physical世界,及其对模拟真实世界变化的能力。

5,Sora如何实现faithfully按照用户输入文本而生成内容,探讨背后的技术与创新。

6,Sora为何依据abstract concept而不是依据具体的pixels进行内容生成,及其对模型生成质量与多样性的影响。