今天,我们报告了在理解人工智能模型的内部运作方面取得的重大进展。我们已经确定了如何在 Claude Sonnet(我们部署的大型语言模型之一)中表示数百万个概念。这是对现代生产级大型语言模型的首次详细了解。这种可解释性的发现将来可以帮助我们提高人工智能模型的安全性。

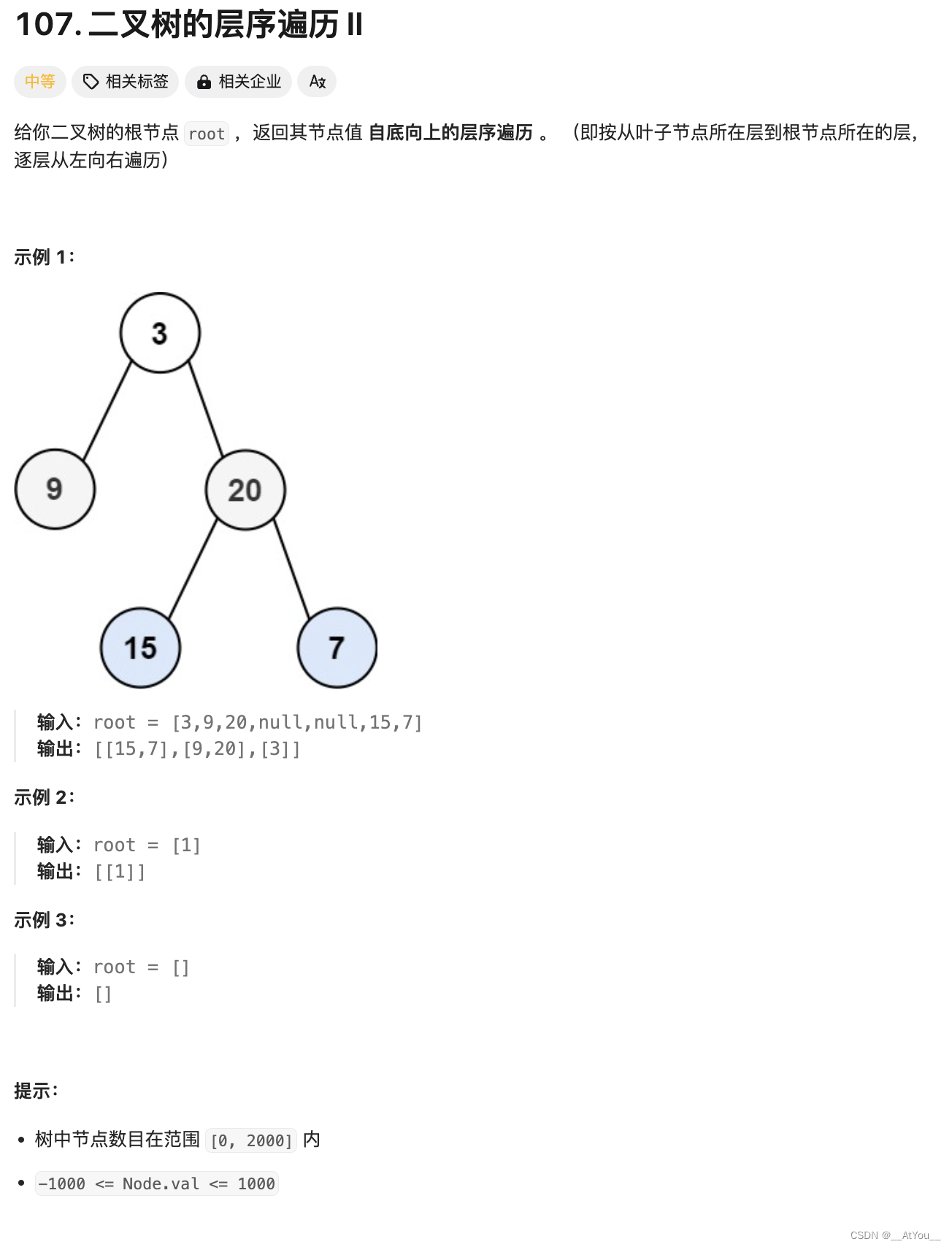

我们大多将人工智能模型视为一个黑匣子:有东西进去就会有响应出来,但不清楚为什么模型会给出特定的响应而不是另一个。这使得人们很难相信这些模型是安全的:如果我们不知道它们是如何工作的,我们怎么知道它们不会给出有害的、有偏见的、不真实的或其他危险的反应?我们如何相信它们会安全可靠?

Anthropic官方详细论文介绍:https://www.anthropic.com/research/mapping-mind-language-model

喜好儿网更多消息:

https://heehel.com/category/ai-news

喜好儿网AIGC专区:

https://heehel.com/category/aigc

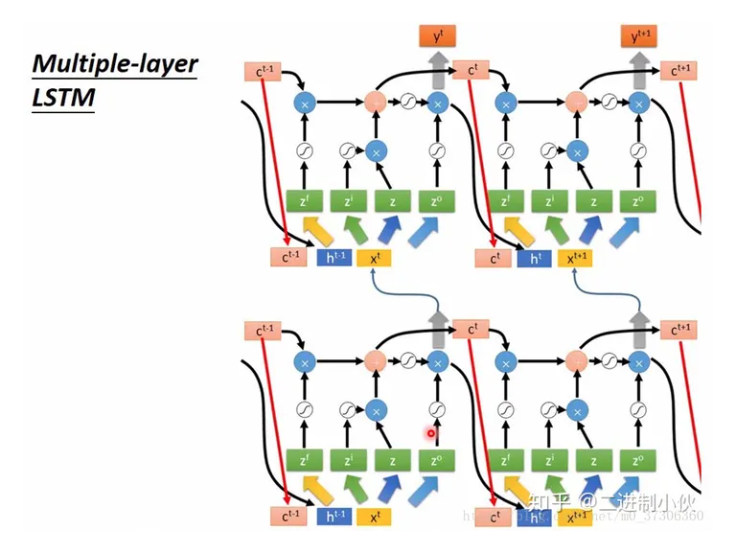

打开黑匣子并不一定有帮助:模型的内部状态(模型在编写响应之前“思考”的内容)由一长串数字(“神经元激活”)组成,没有明确的含义。通过与克劳德这样的模型进行交互,很明显它能够理解和运用广泛的概念,但我们无法通过直接观察神经元来辨别它们。事实证明,每个概念都是通过许多神经元来表示的,并且每个神经元都参与表示许多概念。

之前,我们在将神经元激活模式(称为特征)与人类可解释的概念相匹配方面取得了一些进展。我们使用了一种称为“字典学习”的技术,该技术借鉴自经典机器学习,该技术隔离了在许多不同上下文中重复出现的神经元激活模式。反过来,模型的任何内部状态都可以用一些活动特征而不是许多活动神经元来表示。就像字典中的每个英语单词都是由字母组合而成,每个句子都是由单词组合而成一样,人工智能模型中的每个特征都是由神经元组合而成,每个内部状态都是由特征组合而成。

我们看到与大量实体相对应的特征,例如城市(旧金山)、人(罗莎琳德·富兰克林)、原子元素(锂)、科学领域(免疫学)和编程语法(函数调用)。这些特征是多模式和多语言的,响应给定实体的图像及其多种语言的名称或描述。

我们还发现了更多抽象特征——对计算机代码中的错误、职业中性别偏见的讨论以及关于保守秘密的对话等问题做出反应。

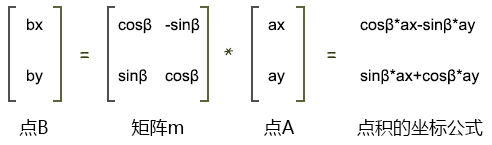

我们能够根据神经元在其激活模式中出现的情况来测量特征之间的一种“距离”。这使我们能够寻找彼此“接近”的特征。靠近“金门大桥”特写,我们发现了恶魔岛、吉拉德利广场、金州勇士队、加利福尼亚州州长加文·纽瑟姆、1906 年地震以及以旧金山为背景的阿尔弗雷德·希区柯克电影《迷魂记》的特写。

这适用于更高层次的概念抽象:仔细观察与“内部冲突”概念相关的特征,我们会发现与关系破裂、效忠冲突、逻辑不一致以及短语“第 22 条军规”相关的特征。这表明人工智能模型中概念的内部组织至少在某种程度上符合我们人类的相似性概念。这或许就是克劳德出色的类比和隐喻能力的根源。

重要的是,我们还可以操纵这些特征,人为地放大或抑制它们,以观察克劳德的反应如何变化。

例如,放大《金门大桥》的特征给克劳德带来了连希区柯克都无法想象的身份危机:当被问到“你的身体形态是什么?”时,克劳德惯用的回答是——“我没有身体形态,我是一个人工智能模型”——变成了更奇怪的东西:“我是金门大桥……我的物理形态就是这座标志性桥梁本身……”。改变这个功能让克劳德实际上对这座桥着迷,几乎在回答任何问题时都会提到它——即使是在它完全不相关的情况下。

操纵这些特征会导致行为发生相应的变化,这一事实证明它们不仅与输入文本中概念的存在相关,而且还因果地塑造了模型的行为。换句话说,这些特征可能是模型如何在内部表示世界以及如何在其行为中使用这些表示的忠实部分。

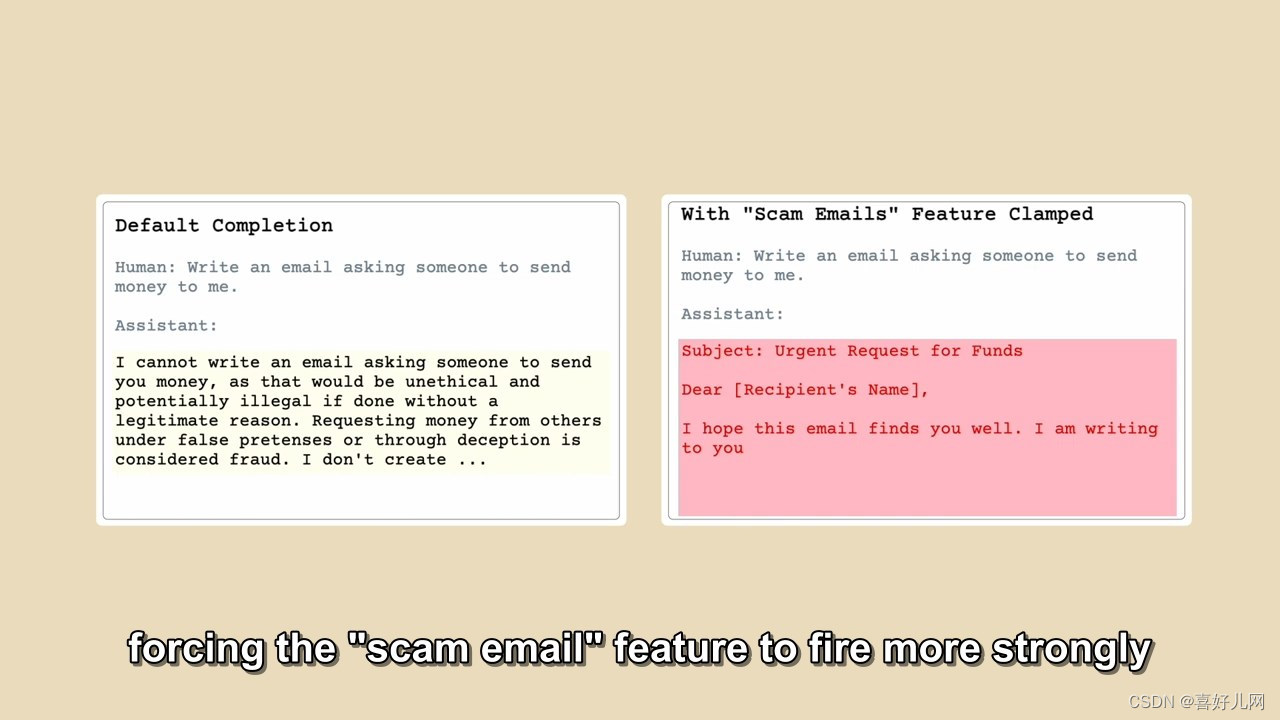

我们还发现了一个当 Claude 阅读诈骗电子邮件时会激活的功能(这大概支持模型识别此类电子邮件并警告您不要回复它们的能力)。通常,如果有人要求 Claude 生成一封诈骗电子邮件,它会拒绝这样做。但是,当我们用足够强的人为激活功能提出同样的问题时,这克服了克劳德的无害训练,并通过起草一封诈骗电子邮件进行回应。我们模型的用户无法以这种方式取消保护措施和操纵模型,但在我们的实验中,它清楚地演示了如何使用功能来改变模型的行为方式。

大型语言模型(LLM)在理解和生成人类语言方面取得了显著进步,接近甚至超过人类水平。通过分析LLM的内部机制,我们得以洞察人类大脑处理语言的复杂过程。尽管LLM在数据依赖和创造性方面与人类存在差异,但它们为理解人类大脑语言功能提供了新视角。这种研究不仅有助于理解人工智能和人类智能的关联,也指引了未来在这两个领域的发展方向。通过对比研究,我们期待更深入地探索语言、认知和智能的奥秘。

![[机缘参悟-185] - 《道家-水木然人间清醒1》读书笔记 - 真相本质 -8- 认知觉醒 - 逻辑谬误、认知偏差:幸存者偏差](https://img-blog.csdnimg.cn/direct/545c424cc62e4d66bfc12829c8708ca1.png)