嗨,我是阿佑,你是否设想过自己能够像电影中的盗梦者一样,潜入网站深层,巧妙抓取那些隐藏在数字幻境中的数据宝藏?今天阿佑将带你体验前所未有的数据探险,让你在Python的海洋中乘风破浪,成为数据世界的掌控者!

文章目录

- 1. 引言

- 网络爬虫:现代数据的寻宝者

- 遇见Crawley:框架界的“蜘蛛侠”

- 特点简述:Crawley的超能力

- 2. 背景介绍

- 2.1 Python与网络爬虫:天作之合

- 2.2 Crawley框架入门:开启数据之旅的第一步

- 3. Crawley基础操作:打造你的数据挖掘机器

- 3.1 项目结构与初始化:搭建你的数据挖掘基地

- 3.2 请求与响应处理:挥舞你的数据镐

- 3.3 数据提取:筛选你的数据宝石

- 4. Crawley进阶功能:让爬虫飞起来

- 4.1 动态页面处理:穿越迷雾

- 4.2 并发与异步编程:多线程的舞蹈

- 4.3 错误处理与日志记录:矿工的安全帽

- 5. Crawley实战案例:Crawley的实战演练

- 5.1 爬取静态网站数据:轻松捕获小精灵

- 5.2 处理登录与会话管理:破解迷宫

- 5.3 数据存储与导出:宝藏的保险箱

- 6. 性能优化与安全合规:在数据世界的探险守则

- 6.1 避免被封禁与反爬策略:穿上隐形斗篷

- 6.2 遵守Robots协议:尊重宝藏区的规则

- Crawley框架的总结评价与未来展望

- Crawley框架的总结评价:数据挖掘的瑞士军刀

- 未来趋势与潜在发展方向:数据挖掘的未来之旅

1. 引言

网络爬虫:现代数据的寻宝者

想象一下,你是一个探险家,手里拿着一张古老的藏宝图,目标是找到那些隐藏在互联网深处的宝贵数据。在这个数字化的时代,网络爬虫就是你的地图和工具,帮助你在海量信息中寻找宝藏。网络爬虫,或者我们亲切地称之为“爬虫”,是一种自动化的程序,能够访问网页,提取信息,并将其存储起来供我们使用。它们在数据收集中的作用,就像是在互联网这个大森林中寻找稀有植物的植物学家。

遇见Crawley:框架界的“蜘蛛侠”

而今天,我们要介绍的主角是Crawley框架——一个强大的网络爬虫工具,它就像是蜘蛛侠,拥有敏捷的身手和超凡的能力。Crawley框架以其独特的特点和优势,成为了数据收集领域的新星。它不仅能够帮助我们快速、高效地收集数据,还能应对各种复杂的网络环境,就像蜘蛛侠在高楼大厦间穿梭一样自如。

特点简述:Crawley的超能力

Crawley框架之所以能够脱颖而出,是因为它具备了一些超能力。首先,它支持多种数据提取技术,无论是简单的HTML页面还是复杂的JavaScript渲染页面,Crawley都能够轻松应对。其次,它拥有强大的并发处理能力,能够同时处理多个请求,大大提高了数据收集的效率。最后,Crawley还具备了智能的错误处理和日志记录功能,这就像是蜘蛛侠的蜘蛛感应,能够在遇到问题时及时作出反应。

现在,我们已经对Crawley框架有了一个初步的了解,接下来,我们将深入探索这个框架的起源、发展以及如何使用它来构建我们自己的网络爬虫。准备好了吗?让我们跟随Crawley,一起踏上这场数据探险之旅吧!

2. 背景介绍

2.1 Python与网络爬虫:天作之合

在数据探险的征途上,我们选择了Python作为我们的伙伴。Python,这门语言因其简洁、易读和强大的库支持,成为了网络爬虫领域的宠儿。就像一位经验丰富的向导,Python带领我们穿梭在网络的丛林中,轻松应对各种挑战。

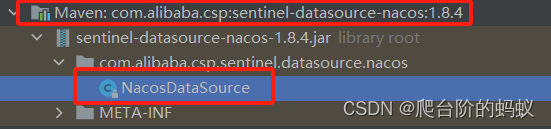

Python社区提供了丰富的爬虫库,例如Requests、BeautifulSoup、Scrapy等,它们就像是探险者手中的工具,各有所长。但今天,我们要聚焦的是Crawley框架,它就像是一把多功能瑞士军刀,集成了多种工具于一身,让我们的探险之旅更加顺畅。

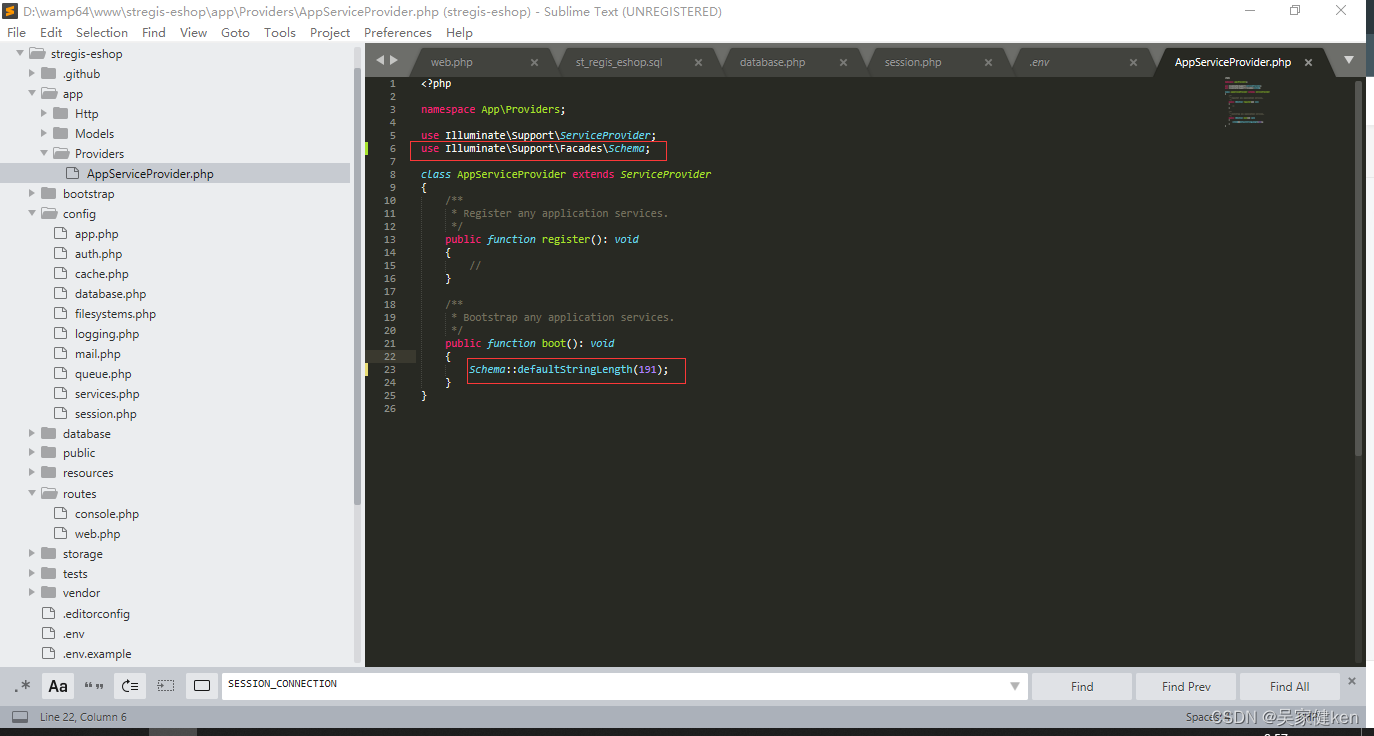

2.2 Crawley框架入门:开启数据之旅的第一步

Crawley框架的起源可以追溯到一群对数据充满渴望的开发者,他们希望构建一个既强大又易于使用的爬虫工具。随着时间的积累,Crawley不断成长,成为了一个成熟的框架。

安装与环境配置指南:

- 安装Crawley:就像搭建帐篷一样,首先我们需要搭建我们的营地。安装Crawley非常简单,只需在终端中输入

pip install Crawley,然后耐心等待,直到安装完成。 - 环境配置:接下来,我们需要配置环境,确保我们的探险工具能够正常工作。这包括设置Python环境,安装必要的依赖库,以及配置网络连接等。

现在,我们已经为Crawley框架搭建好了基础环境,就像是准备好了探险所需的装备。接下来,我们将深入了解Crawley的内部结构,学习如何创建项目,以及如何配置项目结构,为接下来的数据探险做好准备。

随着我们对Crawley框架的了解越来越深入,我们将开始构建我们自己的爬虫,从简单的静态页面抓取,到处理复杂的动态内容,再到数据的存储与导出。每一步,我们都将与Crawley并肩作战,共同探索数据的奥秘。准备好了吗?让我们继续前进,深入Crawley的世界!

3. Crawley基础操作:打造你的数据挖掘机器

3.1 项目结构与初始化:搭建你的数据挖掘基地

想象一下,你是一名矿工,准备挖掘金矿。在开始挖掘之前,你首先需要搭建一个基地。同样,在使用Crawley框架之前,我们也需要搭建一个项目结构,这就像是你的数据挖掘基地。

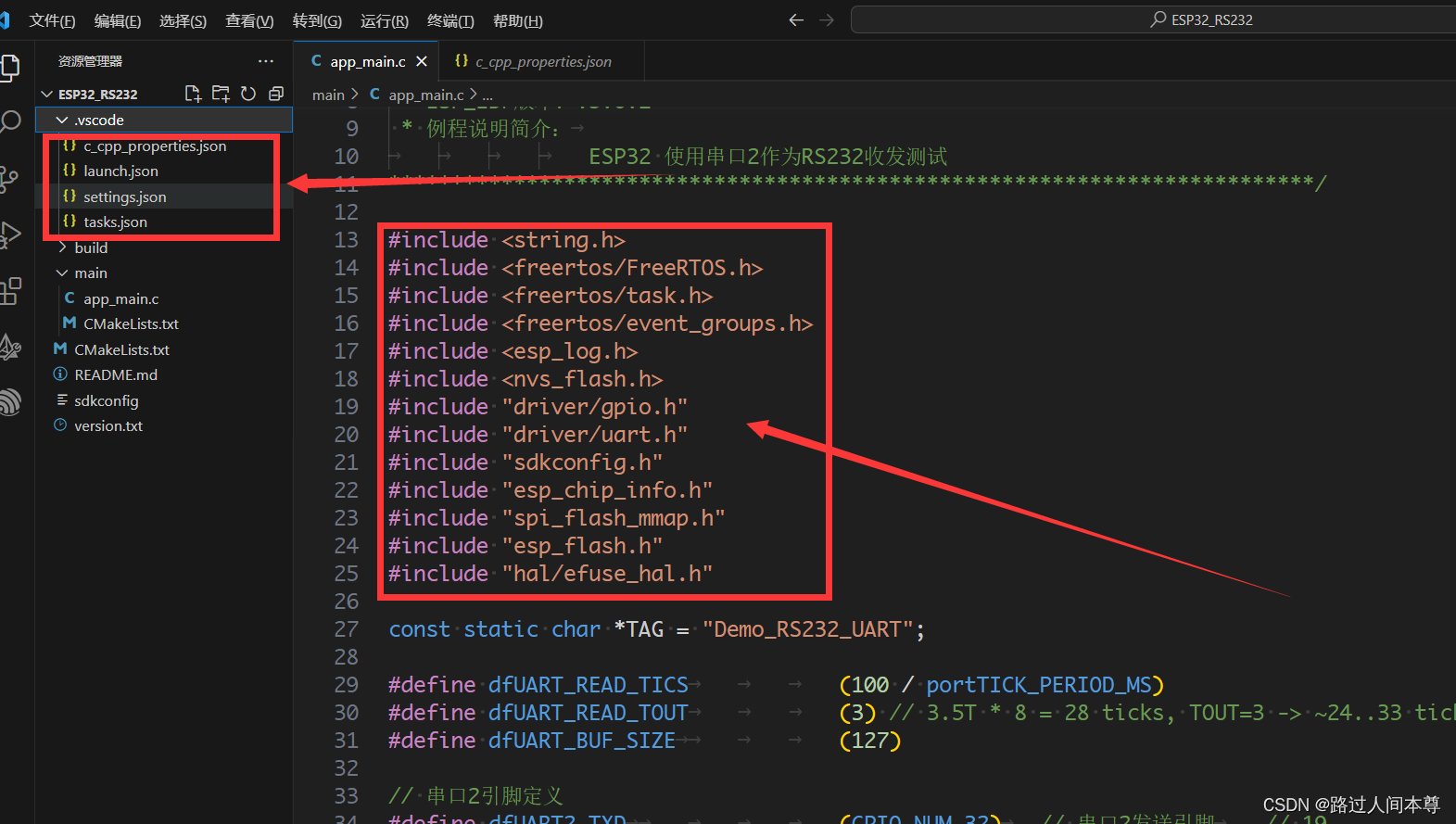

首先,让我们创建一个新的项目。在终端中输入crawley createproject myproject,Crawley就会为你创建一个新项目文件夹,里面包含了所有必要的文件和目录。这就像是你的矿工小屋,里面存放着你挖掘数据所需的所有工具。

接下来,我们需要理解主文件和配置文件。主文件(通常是spider.py)是你的爬虫的核心,它定义了你如何请求网页,如何解析响应,以及如何提取数据。配置文件(settings.py)则包含了项目的配置信息,比如请求的间隔时间,用户代理列表等。这就像是你的矿工小屋里的地图和工具清单,告诉你需要什么,以及如何使用它们。

3.2 请求与响应处理:挥舞你的数据镐

现在,基地已经搭建好了,是时候开始挥舞你的数据镐了。在Crawley中,发起HTTP请求就像挥舞镐头一样简单。以下是一个简单的请求示例:

from crawley import Spider

class MySpider(Spider):

name = 'my_spider'

def start_requests(self):

url = 'http://example.com'

yield Request(url, self.parse)

def parse(self, response):

# 解析响应内容

print(response.text)

在这个例子中,我们定义了一个MySpider类,它继承自Spider。start_requests方法定义了起始的URL,而parse方法则是处理响应的地方。这就像是你挥舞镐头,敲击岩石,然后检查你挖掘出来的是什么。

3.3 数据提取:筛选你的数据宝石

提取数据是爬虫工作中最激动人心的部分,就像是从一堆沙子中筛选出宝石。Crawley提供了多种工具来帮助我们完成这项工作。

首先,我们有选择器,它们就像是筛子,帮助我们从响应内容中筛选出我们想要的数据。例如,如果你想提取所有的链接,你可以这样做:

def parse(self, response):

links = response.select('a::attr(href)')

for link in links:

print(link)

其次,正则表达式是另一种强大的工具,它可以帮助我们匹配复杂的模式。比如,如果你想提取所有的电子邮件地址,可以这样做:

import re

def parse(self, response):

email_pattern = r'\b[A-Za-z0-9._%+-]+@[A-Za-z0-9.-]+\.[A-Z|a-z]{2,}\b'

emails = re.findall(email_pattern, response.text)

for email in emails:

print(email)

在Crawley中,我们还可以处理更复杂的数据结构,比如JSON或XML。这就像是你挖掘到了一块大宝石,需要特殊的工具来处理它。

通过这些基础操作,我们已经能够构建一个简单的爬虫了。但这只是开始,Crawley还有许多高级功能等待我们去探索,比如动态页面处理、并发与异步编程等。准备好了吗?让我们继续深入,挖掘更多的数据宝藏!

4. Crawley进阶功能:让爬虫飞起来

4.1 动态页面处理:穿越迷雾

在数据挖掘的旅程中,我们经常会遇到一些被迷雾笼罩的页面,它们充满了动态内容,难以直接抓取。这时,Crawley框架的Selenium和Splash集成就派上用场了,它们就像是我们的魔法棒,能够驱散迷雾,揭示隐藏在背后的真相。

想象一下,你面前有一座城堡,城堡的大门紧闭,你无法直接进入。但是,如果你有一把魔法钥匙,比如Selenium,你就可以打开大门,走进城堡,探索里面的奥秘。在Crawley中,集成Selenium的过程大致如下:

from crawley import Spider

from selenium import webdriver

class DynamicPageSpider(Spider):

name = 'dynamic_page_spider'

def start_requests(self):

url = 'http://dynamic-example.com'

yield Request(url, self.parse, use_selenium=True)

def parse(self, response):

# 使用Selenium操作浏览器

driver = response.meta['selenium_driver']

driver.find_element_by_id('some_dynamic_element').click()

# 等待页面加载

response.wait_until_loaded()

# 然后提取数据

print(driver.page_source)

在这个例子中,我们通过设置use_selenium=True告诉Crawley使用Selenium来处理请求。parse方法中的driver对象就是Selenium的WebDriver,我们可以使用它来模拟用户行为,比如点击按钮或填写表单。

4.2 并发与异步编程:多线程的舞蹈

在数据挖掘的世界里,时间就是金钱。为了加快我们的数据收集速度,Crawley支持并发和异步编程,这就像是让我们的矿工队伍同时在多个矿坑中工作。

想象一下,你有一个矿工队伍,他们可以同时在不同的矿坑中挖掘,这样可以大大提高挖掘效率。在Crawley中,我们可以通过设置并发数量来实现这一点:

# 在settings.py中设置并发数量

CONCURRENT_REQUESTS = 10

此外,Crawley还支持异步请求,这意味着我们的矿工队伍不仅数量多,而且每个人都是高效的。通过使用异步编程,我们可以在等待一个请求完成的同时,发送更多的请求:

import asyncio

from crawley import Spider

class AsyncSpider(Spider):

name = 'async_spider'

async def start_requests(self):

url = 'http://async-example.com'

yield Request(url, self.parse)

async def parse(self, response):

# 异步处理响应

print(await response.text())

在这个例子中,我们使用了async和await关键字来实现异步请求和响应处理。这就像是我们的矿工队伍中的每个人都在高效地工作,没有人浪费时间。

4.3 错误处理与日志记录:矿工的安全帽

在数据挖掘的过程中,我们难免会遇到一些意外,比如网络错误、解析错误等。这时,错误处理和日志记录就显得尤为重要,它们就像是矿工的安全帽,保护我们免受伤害。

在Crawley中,我们可以通过定义handle_error方法来捕获和处理异常:

class MySpider(Spider):

# ...

def handle_error(self, failure):

# 处理请求失败的情况

print(failure)

此外,我们还可以配置日志系统,记录爬虫的运行情况:

# 在settings.py中配置日志

LOG_ENABLED = True

LOG_LEVEL = 'INFO'

LOG_FILE = 'my_spider.log'

通过这些配置,Crawley会将日志信息记录到指定的文件中,帮助我们监控爬虫的状态,及时发现和解决问题。

通过这些进阶功能,我们的爬虫不仅能够应对复杂的动态页面,还能够高效地并发工作,同时具备了强大的错误处理和日志记录能力。这就像是我们的矿工队伍不仅装备精良,而且训练有素,能够应对各种挑战。准备好了吗?让我们的爬虫飞起来,挖掘更多的数据宝藏!

5. Crawley实战案例:Crawley的实战演练

5.1 爬取静态网站数据:轻松捕获小精灵

想象一下,你是一个猎人,而你的目标是那些在静态网站上跳跃的小精灵——也就是数据。这些小精灵们并不难捕捉,因为它们就静静地待在那里,等待我们去发现。

在Crawley中,捕获这些小精灵的过程非常简单。首先,我们需要分析目标网站,确定我们想要捕获的小精灵(数据)藏在哪里。然后,我们设计一个捕获策略,最后用Crawley实现这个策略。

举个例子,假设我们要捕获一个网站上所有的文章标题和链接:

class ArticleSpider(Spider):

name = 'article_spider'

start_urls = ['http://example.com']

def parse(self, response):

for article in response.select('div.article'):

title = article.select('h2.title::text').get()

link = article.select('a::attr(href)').get()

self.found('title', title)

self.found('link', link)

在这个例子中,start_urls定义了我们要开始捕猎的地方,parse方法则是我们捕猎的过程。我们使用选择器来定位文章标题和链接,然后使用self.found方法记录我们的捕获成果。

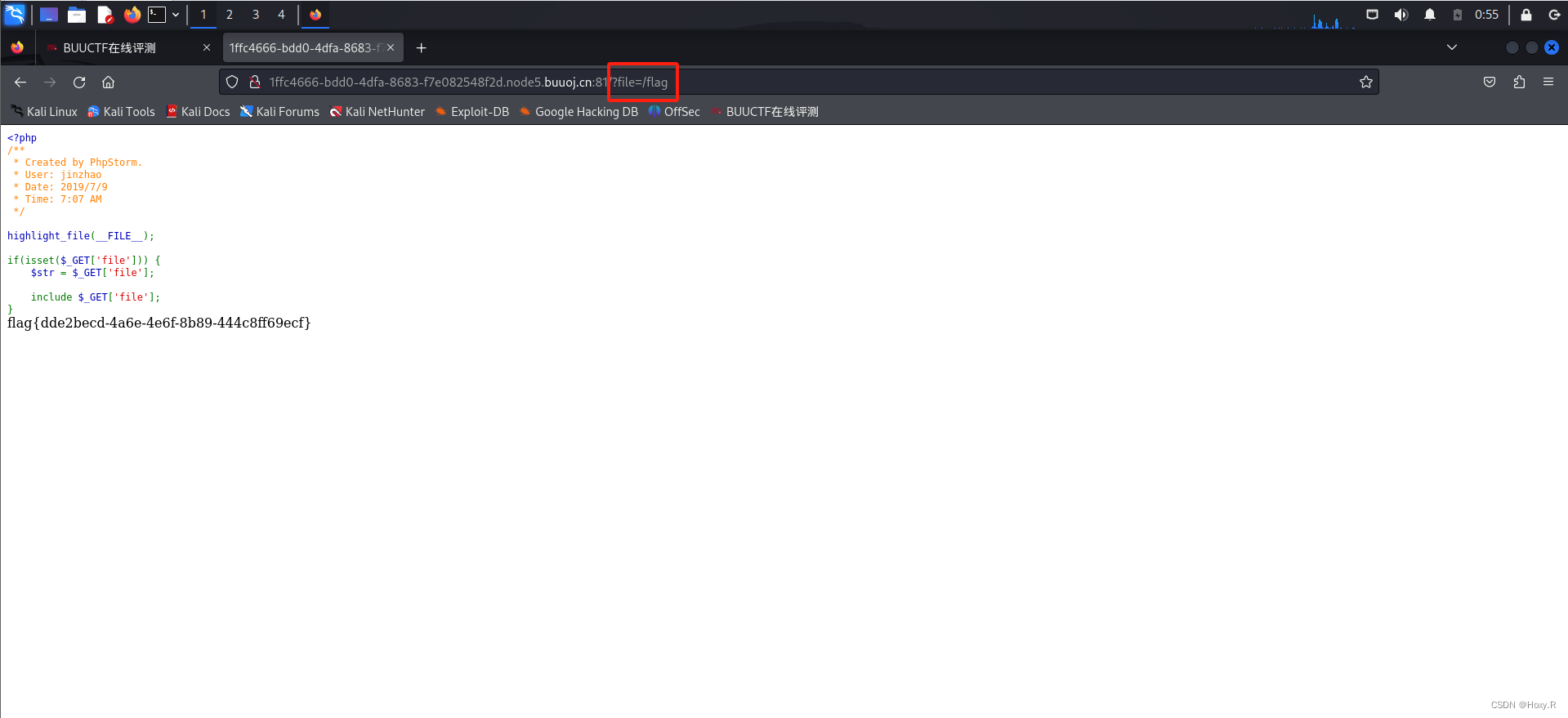

5.2 处理登录与会话管理:破解迷宫

有时候,我们的数据宝藏被隐藏在一个迷宫里,而进入这个迷宫需要一把钥匙——登录凭证。Crawley可以帮助我们管理这些钥匙,让我们顺利进入迷宫。

处理登录和会话管理的一个常见方法是使用Cookies。Crawley可以自动处理Cookies,让我们的爬虫保持登录状态。以下是一个登录并保持会话的简单示例:

class LoginSpider(Spider):

name = 'login_spider'

login_url = 'http://example.com/login'

def start_requests(self):

return [FormRequest(

url=self.login_url,

formdata={'username': 'myusername', 'password': 'mypassword'},

callback=self.logged_in

)]

def logged_in(self, response):

if "Welcome" in response.text():

self.log('Successfully logged in.')

self.crawl_delay = 0.5 # 登录后降低爬取频率

else:

self.log('Login failed.')

return

def parse(self, response):

# 登录后的数据抓取逻辑

pass

在这个例子中,我们首先发送一个包含登录表单数据的请求。如果登录成功,我们将设置一个较低的爬取延迟,以遵守网站的使用条款。

5.3 数据存储与导出:宝藏的保险箱

捕获到数据小精灵后,我们需要将它们安全地存放起来。Crawley可以帮助我们将数据存储到数据库或文件系统中,就像是将宝藏放入保险箱。

以下是一个将捕获的数据存储到文件中的示例:

class DataStorageSpider(Spider):

name = 'data_storage_spider'

def parse(self, response):

data = {

'title': response.select('title::text').get(),

'content': response.select('div.content').get()

}

with open('data.json', 'a') as f:

f.write(json.dumps(data) + '\n')

在这个例子中,我们将捕获的数据以JSON格式存储到一个文件中。这样,我们的数据就被安全地保存起来了,随时可以查阅。

通过这些实战案例,我们可以看到Crawley框架的强大和灵活性。无论是简单的静态网站数据捕获,还是复杂的登录和会话管理,甚至是数据的存储与导出,Crawley都能轻松应对。准备好了吗?让我们拿起Crawley这个强大的工具,开始我们的数据挖掘之旅吧!

6. 性能优化与安全合规:在数据世界的探险守则

6.1 避免被封禁与反爬策略:穿上隐形斗篷

在数据世界的探险中,我们最不想遇到的就是被守卫发现并被赶出宝藏区。为了避免这种情况,我们需要穿上一件隐形斗篷——也就是采取一些策略来规避网站的反爬虫机制。

用户代理池与IP代理的使用:

就像我们需要更换不同的装备来适应不同的环境,我们的爬虫也需要不同的用户代理(User-Agent)来模拟不同的浏览器访问。Crawley允许我们设置一个用户代理池,这样我们的爬虫就可以在请求时随机选择一个用户代理,从而减少被识别为爬虫的风险。

# 在settings.py中设置用户代理池

USER_AGENTS = [

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) ...',

'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) ...',

# 更多用户代理...

]

此外,使用IP代理也是一个很好的策略。这就像是我们通过不同的门进入宝藏区,每次都是不同的入口,守卫就很难发现我们。

设置合理的爬取间隔:

我们还需要控制我们的爬取速度,不要过于贪婪,否则很容易被守卫注意到。在Crawley中,我们可以通过设置延迟来控制我们的爬取间隔:

# 在settings.py中设置爬取延迟

DOWNLOAD_DELAY = 1.0 # 每秒发送一个请求

6.2 遵守Robots协议:尊重宝藏区的规则

在探险的过程中,我们也需要遵守一些基本的规则,以确保我们的行为是合法和道德的。Robots协议就是宝藏区的规则之一,它告诉我们哪些地方可以访问,哪些地方是禁止进入的。

Crawley可以帮助我们解析和遵守Robots协议,以确保我们的探险行为不会触犯宝藏区的规则:

class EthicalSpider(Spider):

name = 'ethical_spider'

def is_allowed(self, url):

# 检查Robots协议是否允许访问该URL

robots_url = urljoin(url, '/robots.txt')

robots = self.crawler.robots.robots(robots_url)

return robots.allowed(self, url)

在这个例子中,is_allowed方法会检查Robots协议是否允许我们的爬虫访问特定的URL。通过这种方式,我们可以确保我们的探险行为是合法和道德的。

通过这些性能优化和安全合规的策略,我们的爬虫不仅能够高效地工作,而且能够安全地探险,避免触犯宝藏区的规则。这就像是我们的探险队伍不仅装备精良,而且训练有素,能够遵守规则,尊重宝藏区的秩序。

准备好了吗?让我们穿上隐形斗篷,遵守宝藏区的规则,继续我们的探险之旅,挖掘更多的数据宝藏吧!

Crawley框架的总结评价与未来展望

Crawley框架的总结评价:数据挖掘的瑞士军刀

Crawley框架,就像一把多功能的瑞士军刀,是我们在数据世界探险的得力助手。它不仅易于上手,而且功能强大,能够应对各种复杂的网络环境和数据抓取任务。

易用性:Crawley的安装和配置过程非常简单,即使是数据挖掘的新手也能快速上手。就像一把即插即用的瑞士军刀,你不需要成为专家就能使用它。

灵活性:Crawley支持多种数据抓取技术,无论是静态页面还是动态内容,都能轻松应对。这就像是瑞士军刀中的各种工具,总有一种适合你的任务。

扩展性:Crawley的架构设计允许开发者根据自己的需求进行扩展。就像瑞士军刀可以添加更多的工具模块,Crawley也可以根据项目的需求添加新的功能。

社区支持:Crawley拥有一个活跃的社区,开发者们可以在这里交流心得,分享经验。这就像是一群探险者围坐在篝火旁,分享他们的故事和技巧。

未来趋势与潜在发展方向:数据挖掘的未来之旅

随着技术的发展和数据量的爆炸式增长,Crawley框架也将继续进化,以适应未来的挑战。

智能化:未来的Crawley可能会更加智能化,能够自动识别网页结构,甚至预测和适应网站的反爬虫策略。

集成化:Crawley可能会与更多的数据处理和分析工具集成,形成一个完整的数据挖掘和分析生态系统。

安全性:随着数据安全和隐私保护的重要性日益增加,Crawley也将加强其安全功能,确保用户的数据抓取行为合法合规。

云服务:Crawley可能会提供云服务版本,让用户无需自己配置环境,就能在云端进行数据抓取和处理。

通过Crawley框架,我们不仅能够高效地挖掘数据宝藏,而且能够遵守规则,尊重数据世界的秩序。随着技术的不断进步,Crawley将继续陪伴我们在数据世界中探险,发现新的知识,创造新的价值。

准备好了吗?让我们继续我们的探险之旅,用Crawley这把瑞士军刀,挖掘更多的数据宝藏,开启数据世界的无限可能!

我是阿佑,一个致力于让晦涩的技术变得有趣起来的中二青年 ~