在今天的数字时代,中小服装商家以及各种带货人,面临着各种挑战,其中之一就是模特拍摄的高成本。为此,一个名为OMS-Diffusion的新开源项目应运而生,旨在帮助大家通过虚拟试衣来降低成本。使用这个工具,只需要一张服装的图片,就可以生成穿着该服装的模特,极大地简化了传统的产品展示过程。

OMS-Diffusion简介

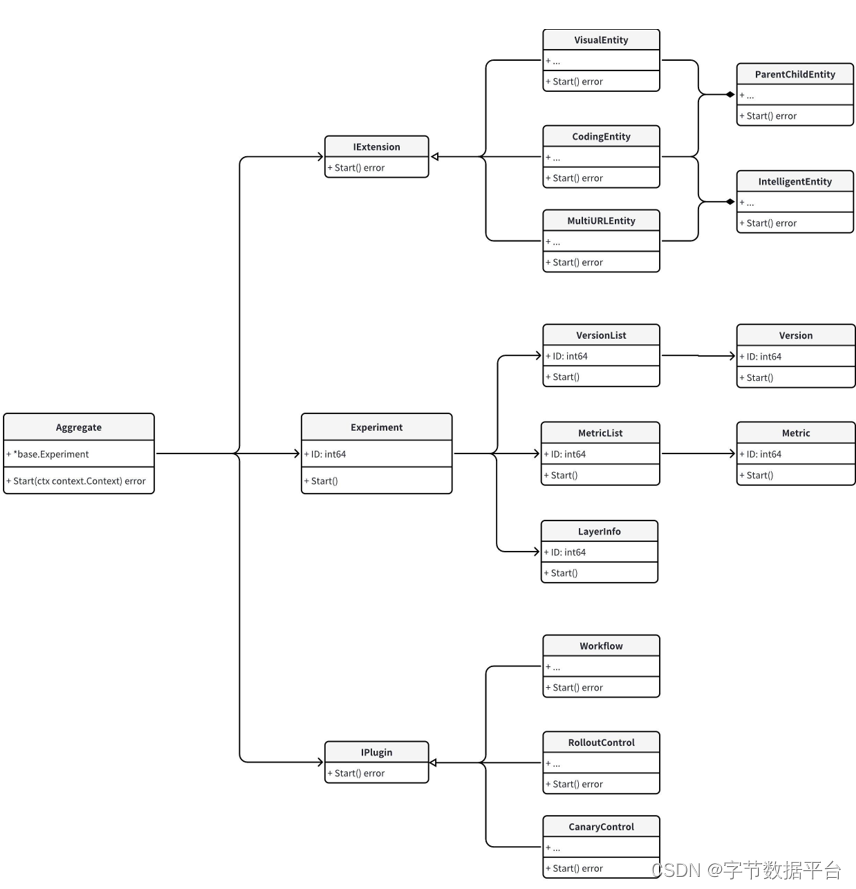

OMS-Diffusion项目结合了先进的IPadapter-faceID和controlnet_openpose技术,使用户能够上传服装图片与参考姿势图进行试穿。这种技术的应用,不仅节省了成本,还加速了新服装上市的速度,让消费者能更直观地看到服装的实际穿着效果。

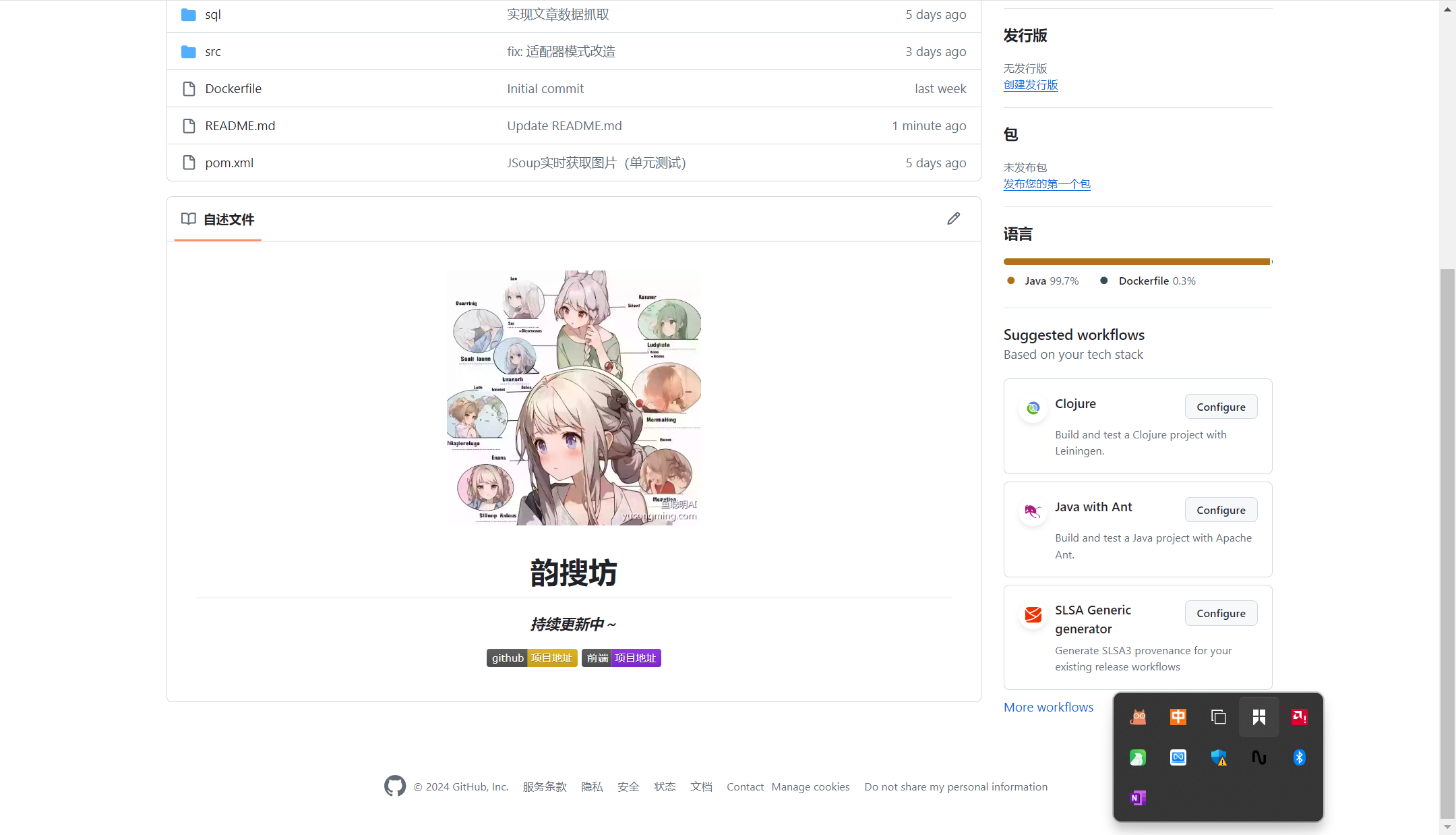

离线懒人包来了

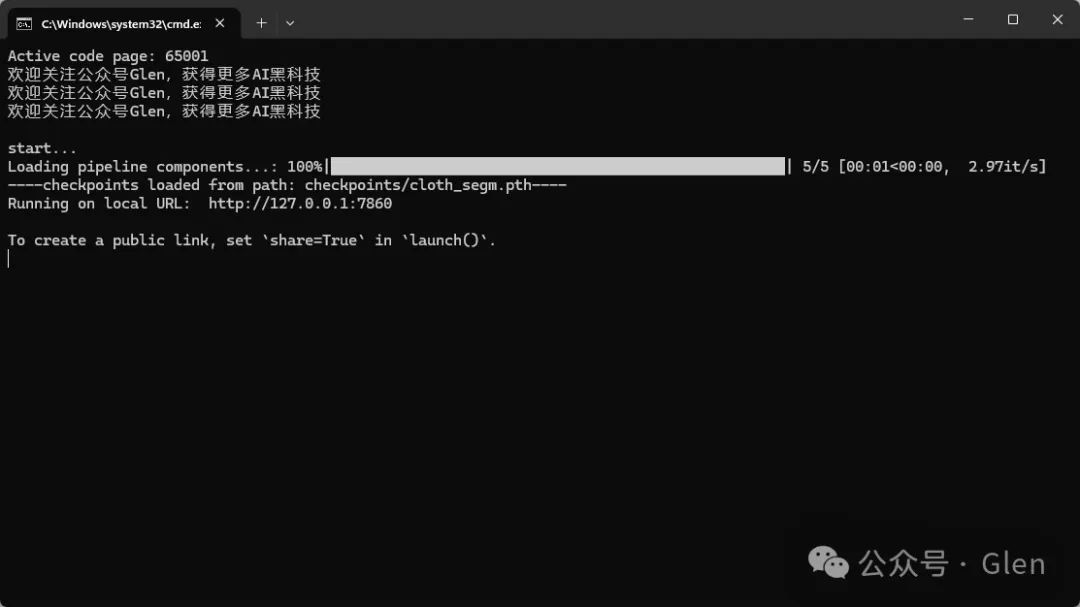

为了方便大家的使用,我又出手了,为大家制作了一款离线整合包。这个懒人包非常方便,下载到本地解压后双击“一键启动”,系统就会自动运行。

加载成功后自动打开浏览器的主界面,一切操作简单快捷(如果没有自动打开,请自行复制“http://127.0.0.1:7860/”在浏览器打开)。这种方式非常适合不想折腾环境配置的小伙伴们,只需要简单几步,就可以体验到AI技术的魅力。

接下来,让我们深入了解如何使用oms-Diffusion项目:

1. 启动指南:默认的提示词是"a photography of a model"。你可以通过添加词汇,如"sunglasses"或"red skirt",来定制模特的配饰或服装颜色。若需要指定模特的性别,可将"model"更改为"man"或"woman"。这些调整可以帮助你精确控制生成的模特形象,虽然具体影响可能会有所不同。

2. 图像分辨率调整:默认的图像分辨率为512x384,这在某些情况下可能导致面部扭曲。为了获得更好的细节效果,你可以尝试提高分辨率。请注意,高分辨率可能会使服装出现不受控制的情况,因此可能需要多次尝试不同的随机种子以获得最佳效果。

3. 随机种子的选择:如果你注意到服装细节与期望不符,请尝试使用不同的随机种子进行生成。每个种子都可能带来不同的效果,找到那个能最佳呈现服装特点的种子至关重要。

4. Guidance Scale设置:通过调整guidance scale,你可以控制试衣效果的逼真度。推荐使用约2.0的值以平衡试衣的质量和图像的真实性,过高的值可能导致图像失真。

5. 背景分离优化:项目内置了一个用于将服装从背景中分离的权重,但这可能不是最优选择。如果你手头有更高效的工具或权重,如SAM,不妨尝试替换它,以实现更清晰的背景分离效果。

下图是我使用整合包,亲测进行虚拟试衣的效果,还是很不错的!

OMS-Diffusion不仅为中小服装商家提供了一个创新的解决方案,也展示了AI技术在时尚行业中的广泛应用潜力。通过这样的工具,大家可以在没有实际模特的情况下,以更低的成本和更高的效率展示他们的产品。对于追求效率和成本效益的商家来说,OMS-Diffusion无疑是一种值得尝试的新兴技术,感兴趣的朋友,千万不要错过!

注意事项:

①该项目建议使用英伟达显卡运行,建议10G显存以上

②请确保安装路径不包含中文,不然可能会引起奇怪的适配问题

今天就聊到这了,我是Glen,感谢你看我的内容,欢迎大家继续支持我,请点赞、收藏、分享三连走一波吧~

关注公众号Glen,回复【OMS-Diffusion】,免费获得本文资源~

![[Linux][网络][协议技术][DNS][ICMP][ping][traceroute][NAT]详细讲解](https://img-blog.csdnimg.cn/direct/868c6a49c3df45b1b5dc8f7d7a68a193.png)