Ollama

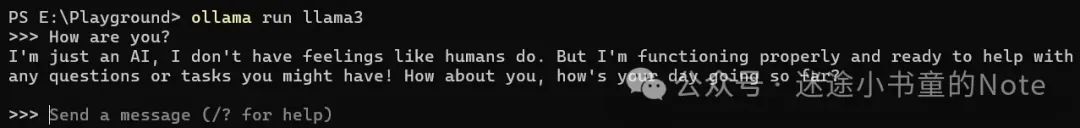

基本的安装使用参考前文 https://xugaoxiang.com/2024/05/01/ollama-offline-deploy/,前文使用的模型是 llama2,本篇将使用 llama3,因此在启动时,命令是 ollama run llama3。

Llama3

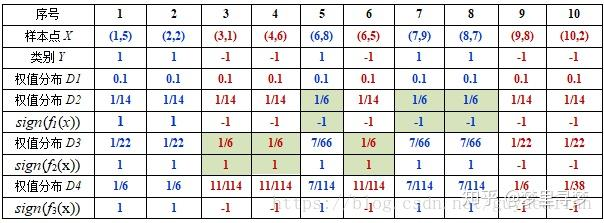

Llama3 是 Meta 发布的大语言模型,有两种大小:80亿和700亿参数。这种模型经过大量文本数据的训练,可用于各种任务,包括生成文本、翻译语言、编写不同类型的创意内容以及以信息丰富的方式回答您的问题。Meta 宣称 Llama3 是最好的开放模型之一,但它仍在开发中。这是与 Mistral 和 Gemma 相比的 8B 模型基准。

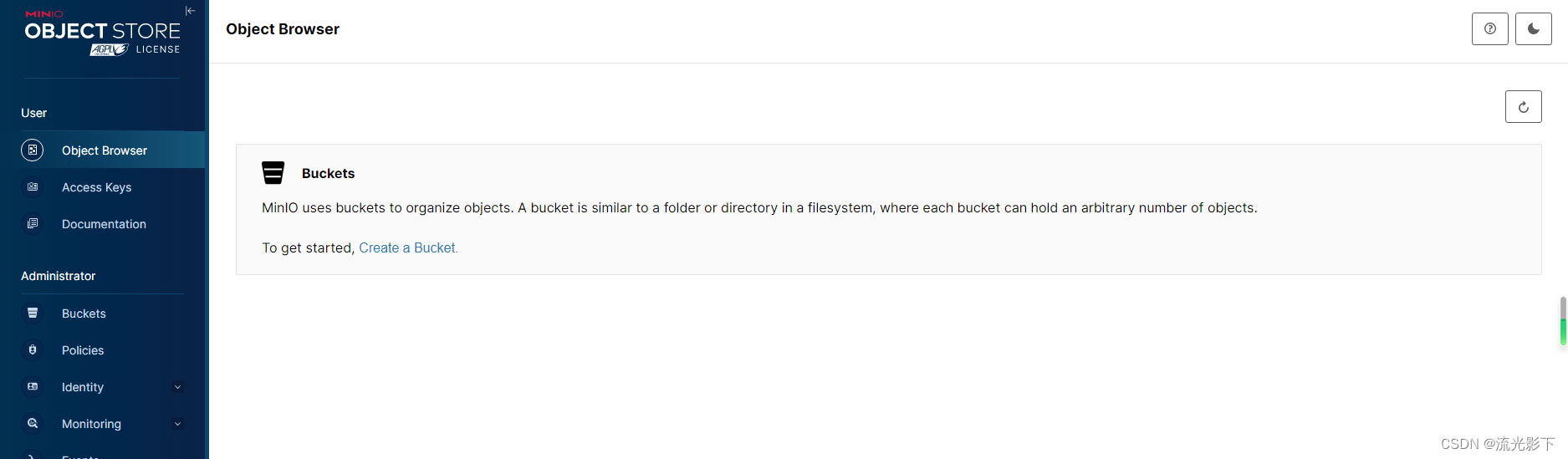

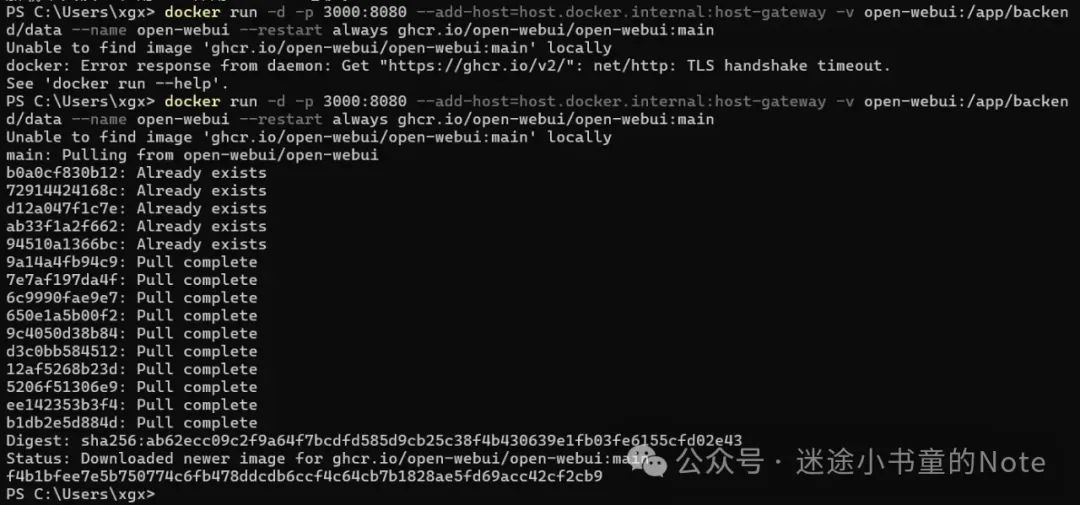

给Ollama套个WebUI

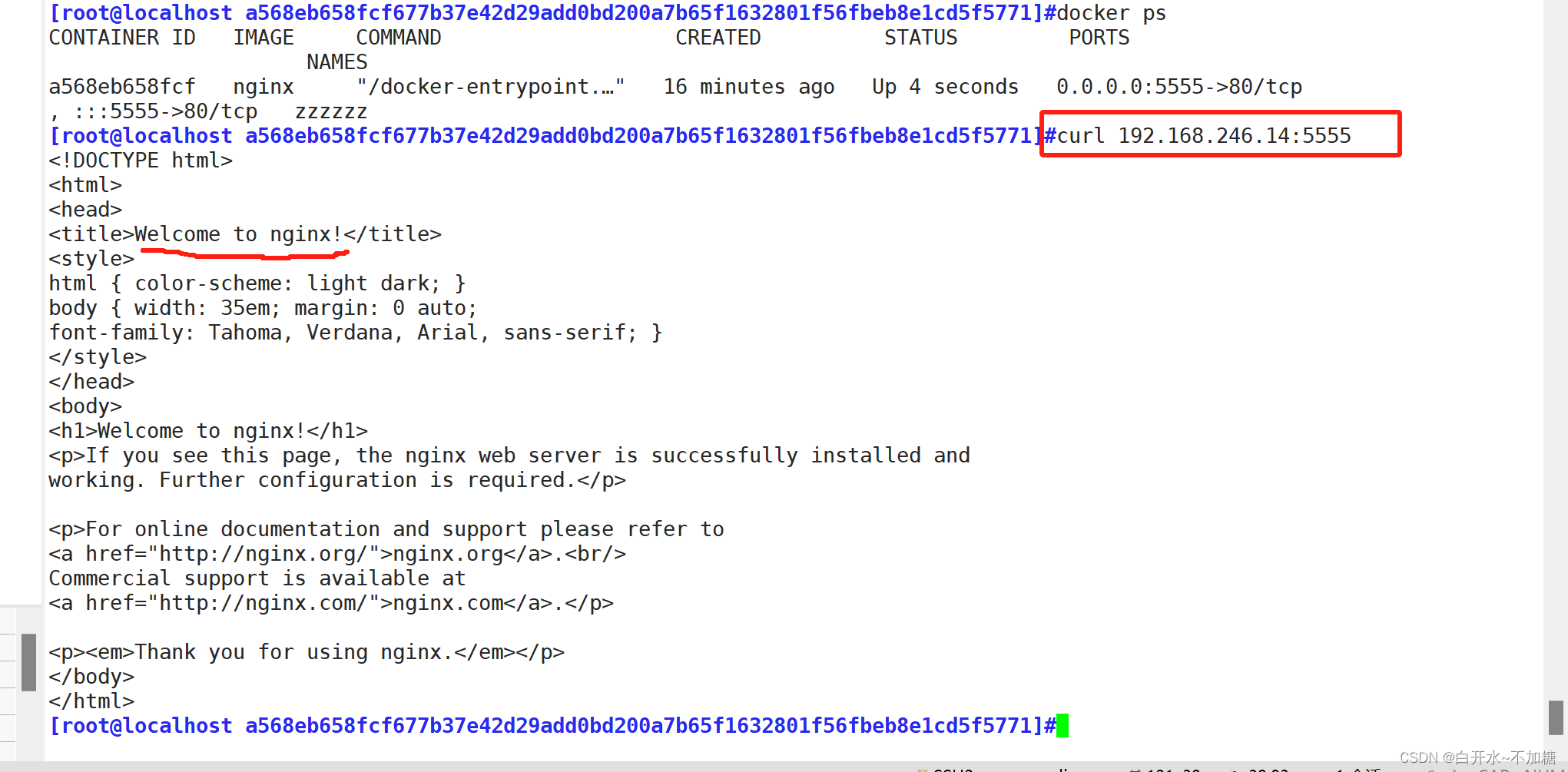

这里使用的是 open-webui,使用 docker 的方式进行。关于 windows 平台如何安装 docker,参考前面的文章 https://xugaoxiang.com/2023/11/16/windows-install-docker/

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

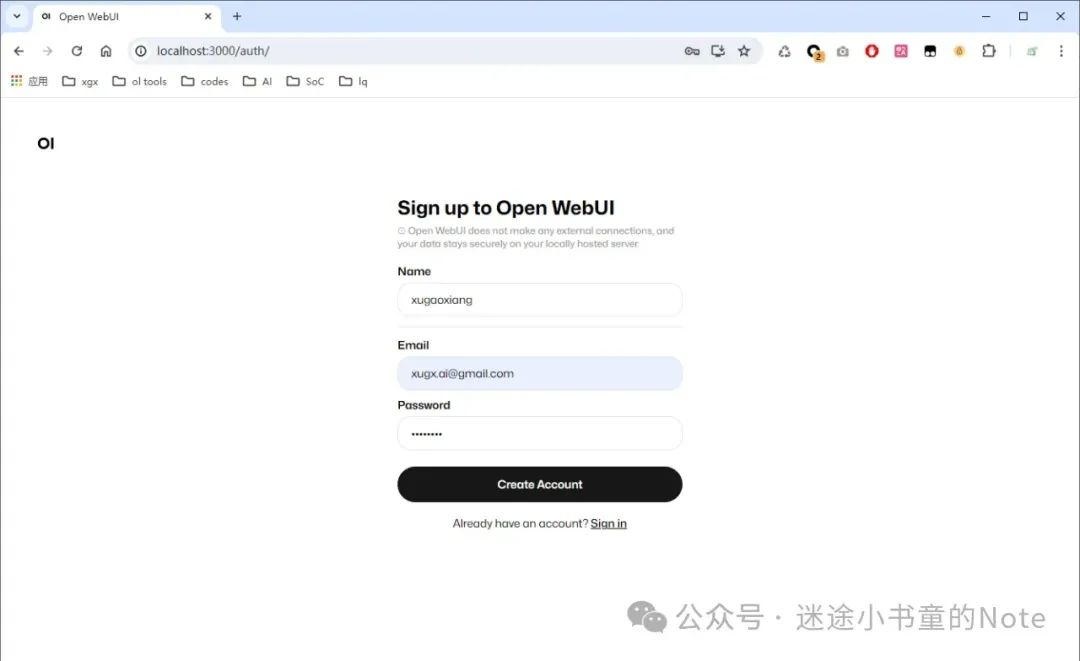

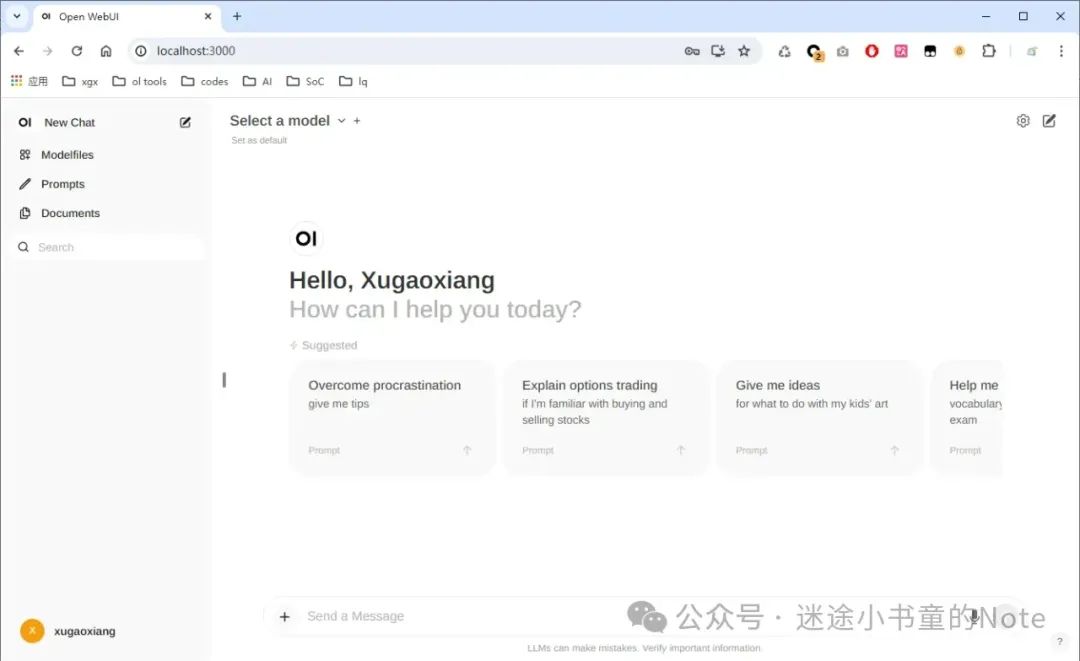

成功后,打开浏览器,输入 http://127.0.0.1:300

注册账号

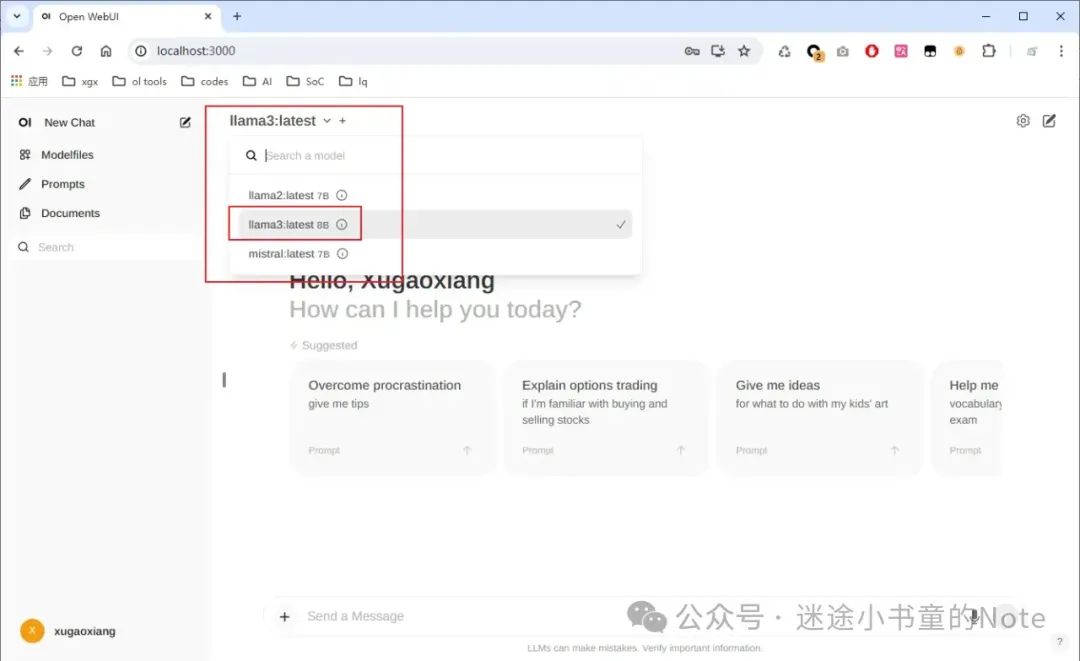

选择使用的模型,这里就 llama3

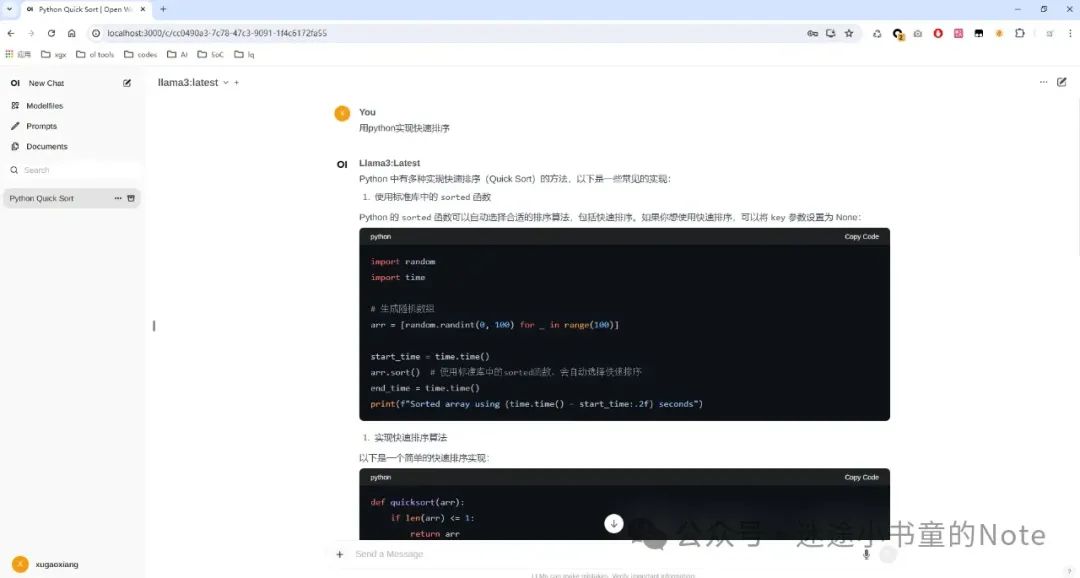

可以向 llama3 提问了

参考资料

https://xugaoxiang.com/2024/05/01/ollama-offline-deploy/

https://github.com/chand1012/openai-cf-workers-ai

https://docs.openwebui.com/

https://github.com/ollama/ollama/blob/main/docs/api.md

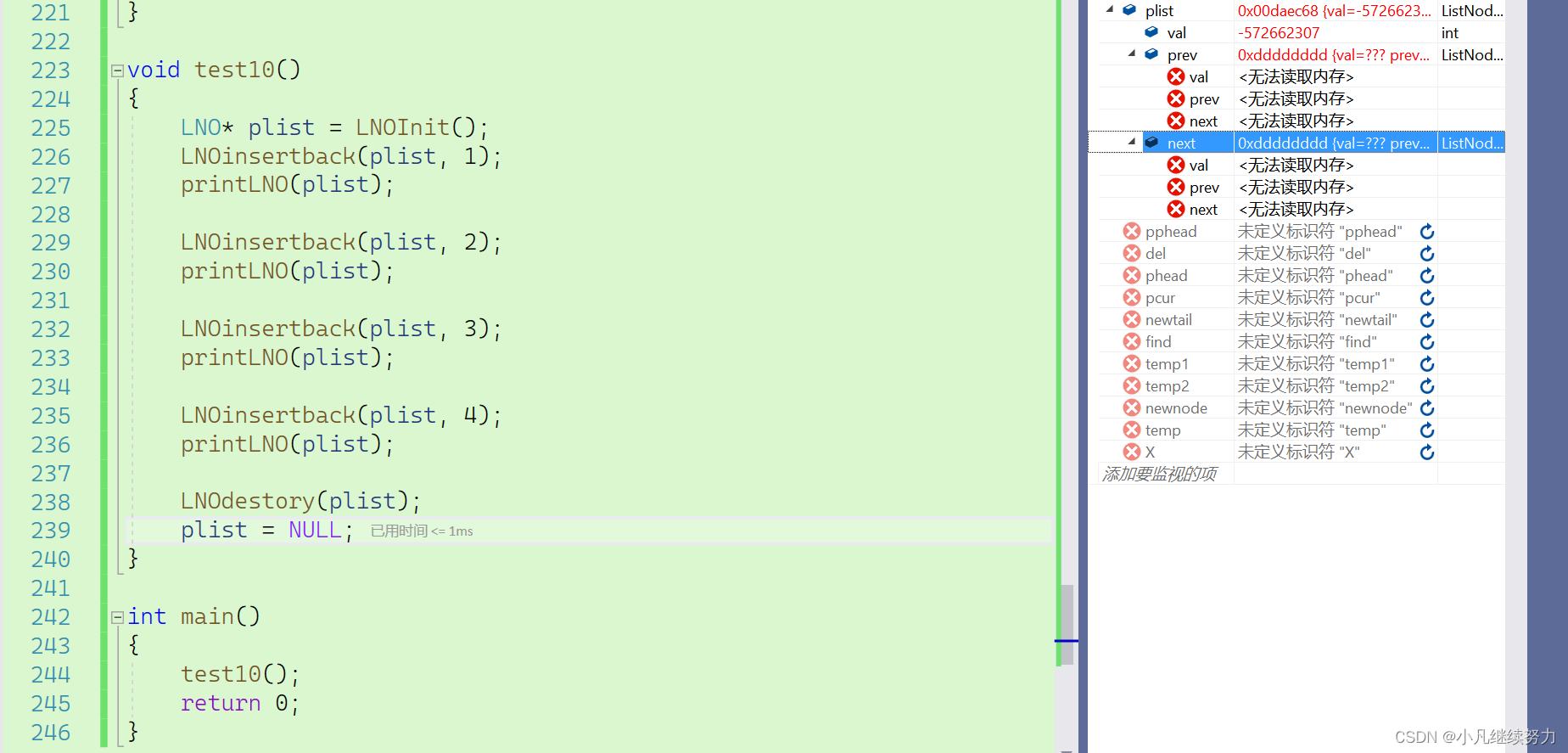

![[C++初阶]string类](https://img-blog.csdnimg.cn/direct/582820dee0604ea2ad7e29c78ecc2e20.png)