论文:Recitation-Augmented Language Models

⭐⭐⭐

ICLR 2023, Google Research, arXiv:2210.01296

Code:github.com/Edward-Sun/RECITE

文章目录

- 论文速读

论文速读

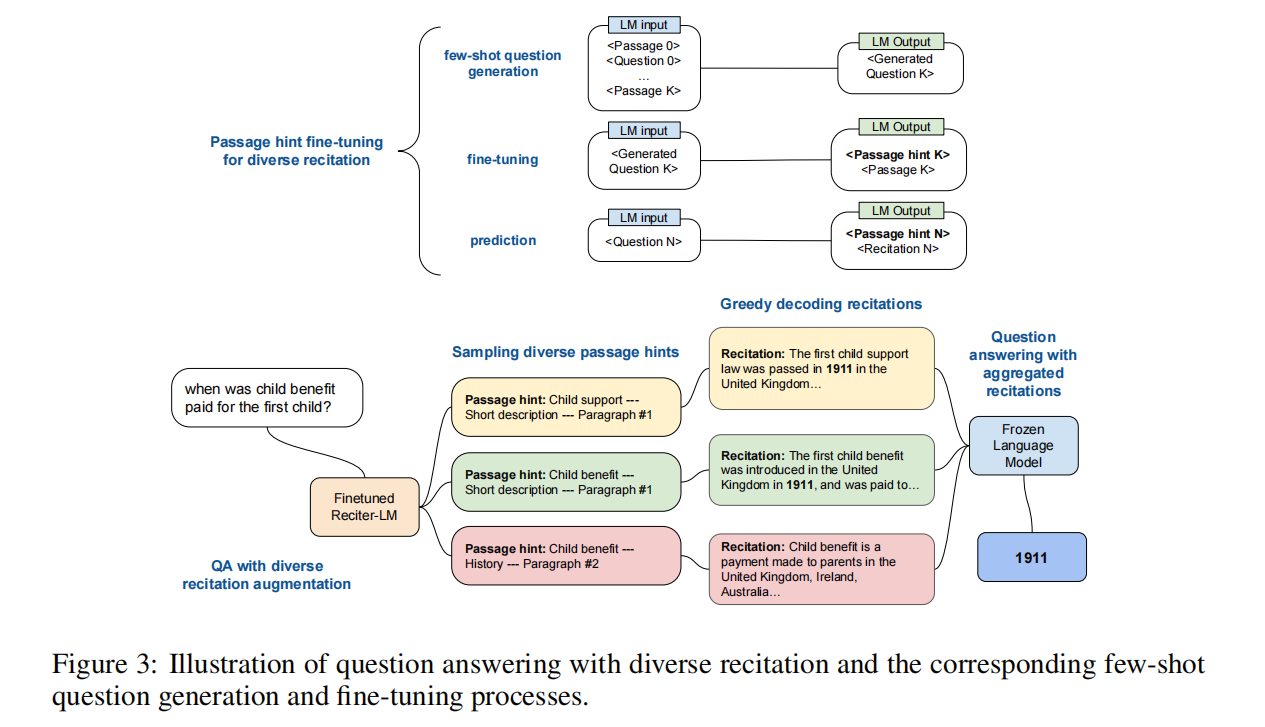

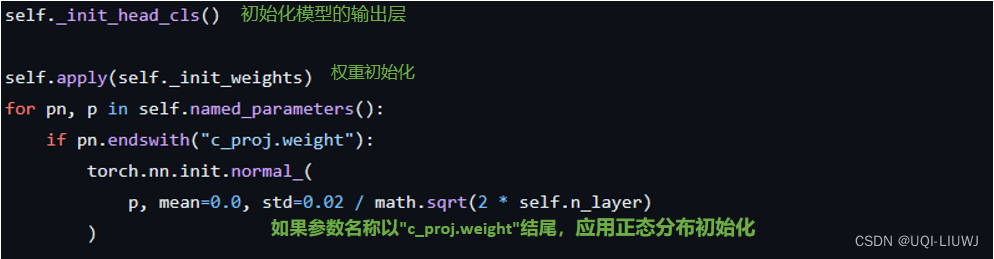

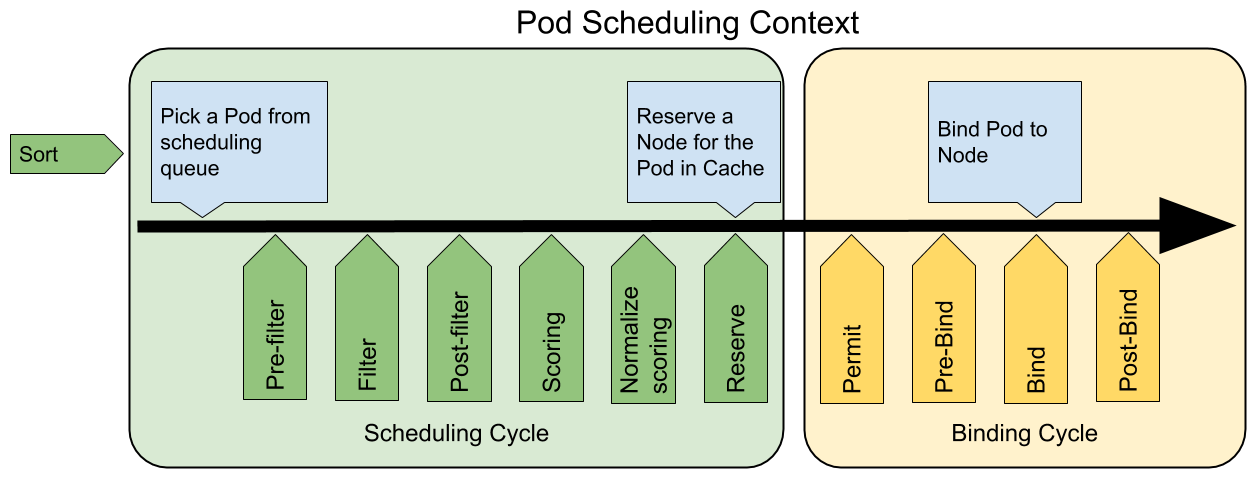

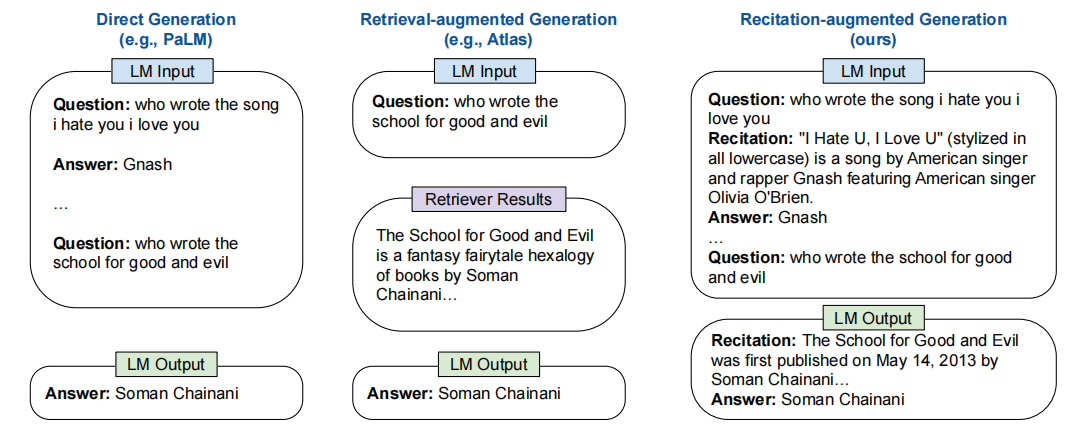

论文的整体思路还是挺简单的,就是让 LLM 面对一个 question,首先先背诵(recitation)一遍自己知道的相关段落,然后再回答答案,如下图所示(最右边的是 Recitation-augmented Generation):

实现的方式就是通过 in-context learning,为 LLM 提供几个带有 recitation 的 few-shot exemplars。

这种 two-step 的范式,将原来的知识密集型任务分解为了两个子任务:knowledge-recitation 和 task-execution,前者可以视为一种中间的知识获取步骤(从 LLM 的内部参数中)。

论文还举了一个例子来说明为什么这种方法可行。比如问题是“ π \pi π 的第十位小数是什么”,也许 LLM 的训练资料中没有关于这个问题的直接回答,但是它可能可以背出“ π \pi π 的前面的数字是 3.1415926535”,这样他就可以回答出答案是 5。

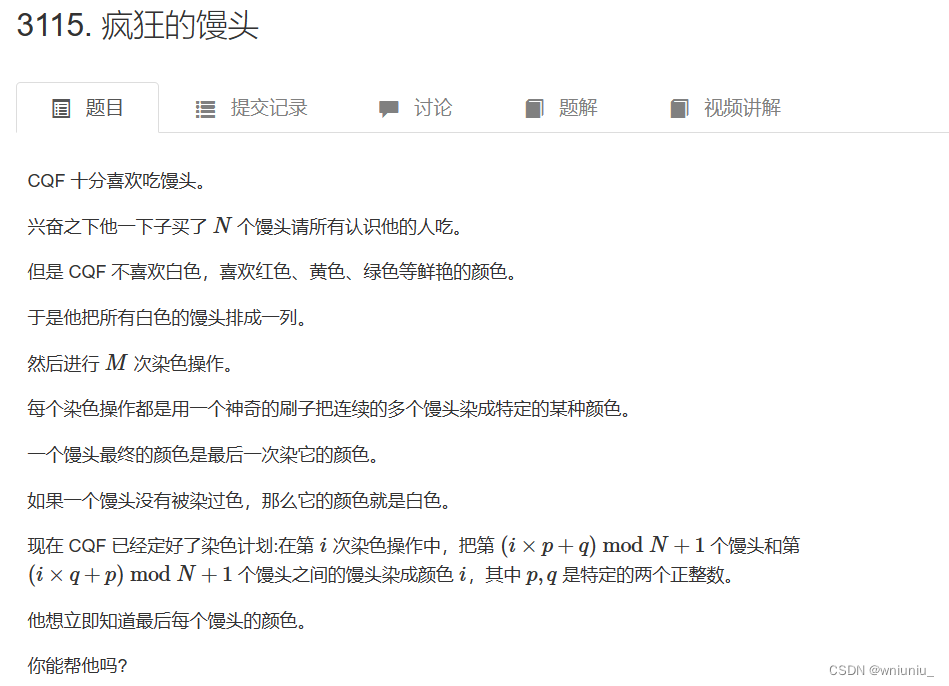

另外,论文还尝试与 self-consistency 和 multi-hop 多轮背诵的方法进行结合来解决更加复杂的问题,如下图: