原文地址:meta-llama-3-optimized-cpu-inference-with-hugging-face-and-pytorch

了解在 CPU 上部署 Meta* Llama 3 时如何减少模型延迟

2024 年 4 月 19 日

万众期待的 Meta 第三代 Llama 发布了,我想确保你知道如何以最佳方式部署这个最先进的(SoTA)LLM。在本文中,我们将重点讨论如何执行只权重量化(WOQ)来压缩 8B 参数模型并改善推理延迟,但首先,让我们讨论一下 Meta Llama 3。

Llama 3

迄今为止,Llama 3 系列包括 8B 到 70B 参数的模型,未来还会有更多版本。这些模型都附带有允许使用的 Meta Llama 3 许可证,请在接受使用这些模型所需的条款之前仔细阅读。这标志着 Llama 模型系列和开源人工智能进入了激动人心的新篇章。

结构

Llama 3 是一种基于纯解码器transformer的自动回归 LLM。与 Llama 2 相比,Meta 团队做出了以下显著改进:

- 采用分组查询关注 (GQA),提高了推理效率。

- 优化了标记符号生成器,其词汇量为 128K 标记,旨在更高效地编码语言。

- 在 15 万亿个 token 数据集上进行了训练,比 Llama 2 的训练数据集大 7 倍,包含的代码多 4 倍。

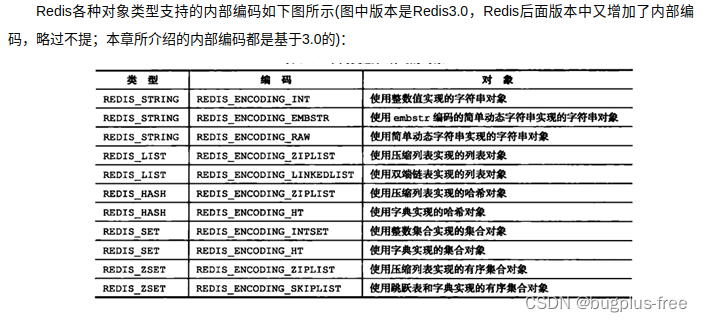

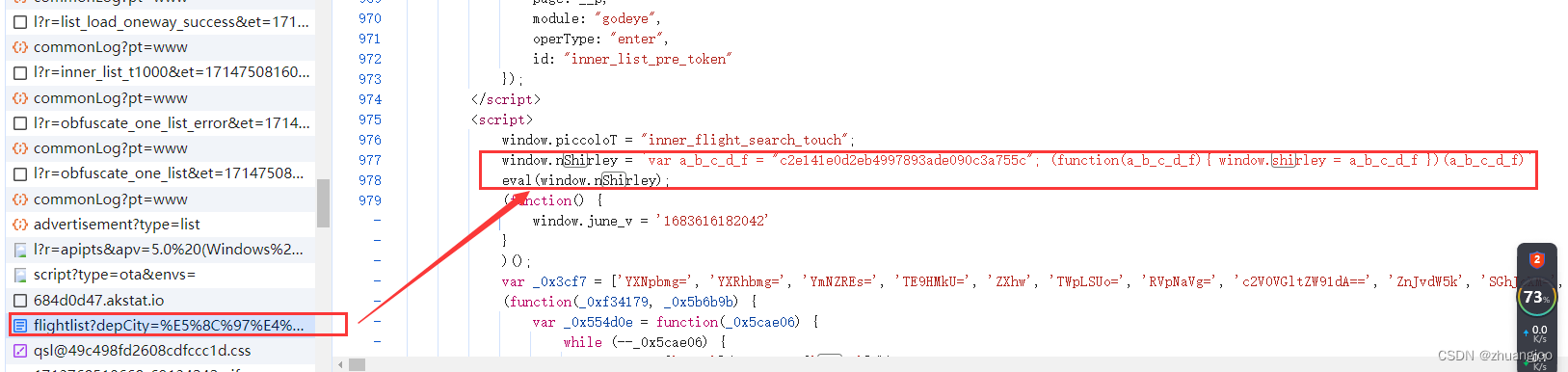

下图是 print(model) 的结果,其中 model 为 meta-llama/Meta-Llama-3-8B-Instruct。从图中我们可以看到,该模型由 32 个 LlamaDecoderLayers 组成,这些 LlamaDecoderLayers 由 Llama Attention 自我注意组件构成。此外,它还有 LlamaMLP、LlamaRMSNorm 和一个线性头。

语言建模性能

该模型在各种行业标准语言建模基准(如 MMLU、GPQA、HumanEval、GSM-8K、MATH 等)上进行了评估。在本文中,我们将回顾 "指令调整模型 "的性能。这些数据中最引人注目的是 Llama 3 8B 参数模型在所报告的基准测试中的性能比 Llama 2 70B 高出 62% 到 143%,而模型体积却小了 88%!

最新一代 Llama 提升了语言建模性能、许可权限和架构效率,标志着生成式人工智能领域翻开了激动人心的篇章。让我们来探讨如何优化 CPU 上的推理,以实现 Llama 3 的可扩展、低延迟部署。

使用 PyTorch 优化 Llama 3 推断

在本文中,我们将重点介绍如何在 meta-llama/Meta-Llama-3-8B-Instruct 中应用仅权重量化(WOQ)。WOQ 在性能、延迟和准确性之间取得了平衡,可选择量化到 int4 或 int8。WOQ 的一个关键部分是去量化步骤,它在计算前将 int4/in8 权重转换回 bf16。

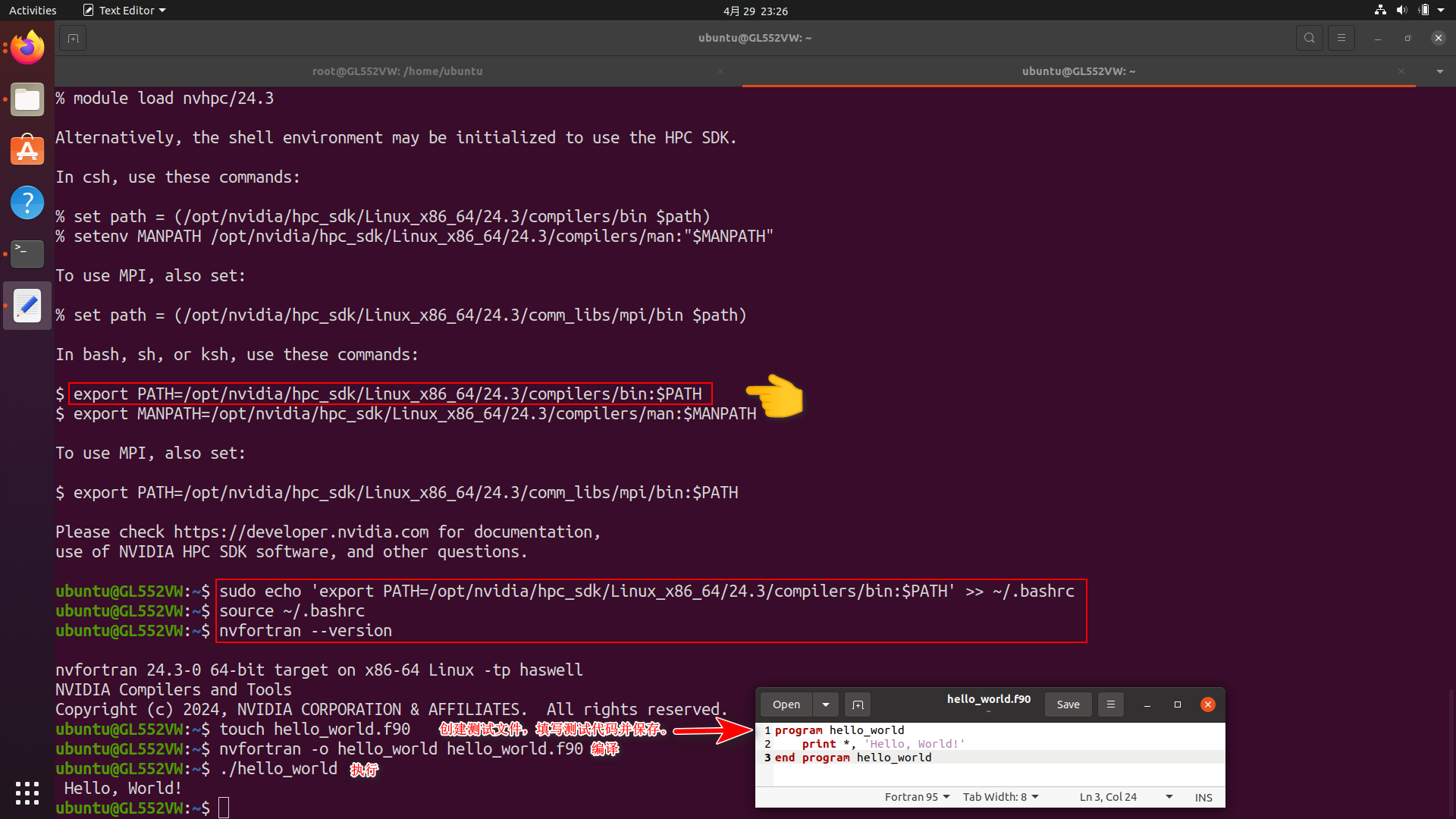

环境设置

在 Llama-3-8B-Instruct 上执行 WOQ 需要大约 60GB 内存。其中约 30GB 用于加载完整模型,约 30GB 用于量化期间的峰值内存。WOQ Llama 3 只消耗约 10GB 内存,这意味着我们可以通过从内存中释放完整模型来释放约 50GB 内存。

如果在自己的集成开发环境中运行,你可能需要解决其他依赖性问题,如安装 Jupyter 和/或配置 conda/python 环境。在开始之前,请确保已安装以下依赖项。

intel-extension-for-pytorch==2.2

transformers==4.35.2

torch==2.2.0

huggingface_hub访问和配置 Llama 3

访问 Llama 3 的模型和令牌生成器需要一个 Hugging Face* 账户。

为此,请从设置菜单中选择 "访问令牌"(图 4)并创建一个令牌。

运行以下代码后,复制访问令牌并将其粘贴到 Jupyter 单元格中生成的 "令牌 "字段。

from huggingface_hub import notebook_login, Repository

# Login to Hugging Face

notebook_login()使用 WOQ 量化 Llama-3-8B-Instruct

我们将利用 PyTorch 的英特尔® 扩展* 将 WOQ 应用于 Llama 3。该扩展包含针对英特尔硬件的最新 PyTorch 优化。请按照以下步骤对 Llama 3 模型进行量化并执行推理:

1. Llama 3 模型和标记器: 导入所需的软件包,并使用 AutoModelForCausalLM.from_pretrained() 和 AutoTokenizer.from_pretrained() 方法加载 Llama-3-8B-Instruct 特定的权重和标记符。

import torch

import intel_extension_for_pytorch as ipex

from transformers import AutoTokenizer, AutoModelForCausalLM, TextStreamer

Model = 'meta-llama/Meta-Llama-3-8B-Instruct'

model = AutoModelForCausalLM.from_pretrained(Model)

tokenizer = AutoTokenizer.from_pretrained(Model)2. 量化配方配置(Quantization Recipe Config): 配置 WOQ 量化配方。我们可以将 weight_dtype 变量设置为所需的内存数据类型,分别从 torch.quint4x2 或 torch.qint8 中选择 int4 和 in8。此外,我们还可以使用 lowp_model 来定义去量化精度。目前,我们将保持 ipex.quantization.WoqLowpMode.None 作为默认的 bf16 计算精度。

qconfig = ipex.quantization.get_weight_only_quant_qconfig_mapping(

weight_dtype=torch.quint4x2, # or torch.qint8

lowp_mode=ipex.quantization.WoqLowpMode.NONE, # or FP16, BF16, INT8

)

checkpoint = None # optionally load int4 or int8 checkpoint

# PART 3: Model optimization and quantization

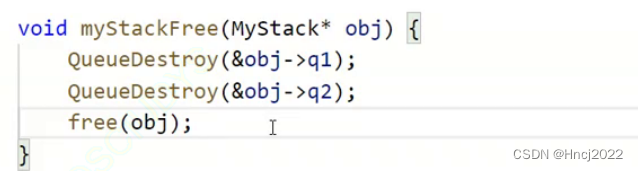

model_ipex = ipex.llm.optimize(model, quantization_config=qconfig, low_precision_checkpoint=checkpoint)

del model 我们使用 ipex.llm.optimize() 应用 WOQ,然后使用 del model 从内存中删除完整模型,释放出 ~30GB 内存。

3. 提示 Llama 3:与 LLama 2 一样,Llama 3 也为其指令调整模型预设了提示模板。使用该模板,开发人员可以定义特定的模型行为指令,并提供用户提示和对话历史记录。

system= """\n\n You are a helpful, respectful and honest assistant. Always answer as helpfully as possible, while being safe. If you don't know the answer to a question, please don't share false information."""

user= "\n\n You are an expert in astronomy. Can you tell me 5 fun facts about the universe?"

model_answer_1 = 'None'

llama_prompt_tempate = f"""

<|begin_of_text|>\n<|start_header_id|>system<|end_header_id|>{system}

<|eot_id|>\n<|start_header_id|>user<|end_header_id|>{user}

<|eot_id|>\n<|start_header_id|>assistant<|end_header_id|>{model_answer_1}<|eot_id|>

"""

inputs = tokenizer(llama_prompt_tempate, return_tensors="pt").input_ids我们提供所需的字段,然后使用标记器将整个模板转换成模型的标记。

4. Llama 3 推论: 在文本生成方面,我们利用 TextStreamer 生成实时推理流,而不是一次性打印整个输出。这将为读者带来更自然的文本生成体验。我们为 model_ipex.generate() 和其他文本生成参数提供了配置好的流。

with torch.inference_mode():

tokens = model_ipex.generate(

inputs,

streamer=streamer,

pad_token_id=128001,

eos_token_id=128001,

max_new_tokens=300,

repetition_penalty=1.5,

)运行此代码后,模型将开始生成输出。请记住,这些都是未经过滤的非保护输出。对于真实世界的使用案例,你将需要进行额外的后处理考虑。

就是这样。只需不到 20 行代码,你就能在生态系统中拥有最新 SoTA LLM 的低延迟 CPU 优化版本。

总结

与前几代产品相比,Meta 的 Llama 3 LLM 系列有了显著的改进,并提供了多种配置(更多配置即将推出)。在本文中,我们探讨了利用仅权重量化(WOQ)增强 CPU 推理能力的问题,这种技术可以减少延迟,同时对准确性的影响最小。

通过将新一代面向性能的 Llama 3 LLM 与 WOQ 等优化技术相结合,开发人员可以为 GenAI 应用开启新的可能性。这种组合简化了硬件要求,使集成到新系统和现有系统中的 LLM 能够实现高保真、低延迟的结果。