1,关于 localai

LocalAI 是一个用于本地推理的,与 OpenAI API 规范兼容的 REST API。

它允许您在本地使用消费级硬件运行 LLM(不仅如此),支持与 ggml 格式兼容的多个模型系列。支持CPU硬件/GPU硬件。

【LocalAI】(10):在autodl上编译embeddings.cpp项目,转换bge-base-zh-v1.5模型成ggml格式,本地运行main成功

2,关于embeddings.cpp项目

这个是localai 执行 embedding 模型的后台服务。

但是有个问题,不支持 bge的大模型。

只能运行 bert-embeddings 的大模型,而bge的模型不支持。

配置文件:

## 使用bge 大模型:

## https://localai.io/features/embeddings/

## https://www.modelscope.cn/models/flyiot/bge-base-zh-v1.5-ggml/summary

name: text-embedding-ada-002

backend: bert-embeddings

parameters:

model: bge-base-zh-v1.5-ggml-model-q4_0.bin

usage: |

You can test this model with curl like this:

curl http://localhost:8080/embeddings -X POST -H "Content-Type: application/json" -d '{

"input": "Your text string goes here",

"model": "text-embedding-ada-002"

}'

download_files:

- filename: "bge-base-zh-v1.5-ggml-model-q4_0.bin"

sha256: "da4d976e3988977ec4d9fde6653a8fe954b71a0c502c30eda6f84234556cde54"

uri: "https://www.modelscope.cn/api/v1/models/flyiot/bge-base-zh-v1.5-ggml/repo?Revision=master&FilePath=ggml-model-q4_0.bin"

比如运行:

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr runtime.goexit({})

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr /root/go/pkg/mod/golang.org/toolchain@v0.0.1-go1.22.2.linux-amd64/src/runtime/asm_amd64.s:1695 +0x1 fp=0xc00011cfe8 sp=0xc00011cfe0 pc=0x4756c1

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr created by google.golang.org/grpc.(*Server).handleRawConn in goroutine 19

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr /root/go/pkg/mod/google.golang.org/grpc@v1.59.0/server.go:919 +0x15b

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr rax 0x0

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr rbx 0x7f710a337640

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr rcx 0x7f7151e669fc

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr rdx 0x6

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr rdi 0x23

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr rsi 0x26

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr rbp 0x26

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr rsp 0x7f710a336700

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr r8 0x7f710a3367d0

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr r9 0x7f710a336310

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr r10 0x8

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr r11 0x246

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr r12 0x6

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr r13 0x16

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr r14 0x21

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr r15 0x7f71004bce40

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr rip 0x7f7151e669fc

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr rflags 0x246

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr cs 0x33

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr fs 0x0

5:39AM DBG GRPC(bge-base-zh-v1.5-ggml-model-q4_0.bin-127.0.0.1:41571): stderr gs 0x0

5:39AM ERR Server error error="could not load model: rpc error: code = Unavailable desc = error reading from server: EOF" ip=172.17.0.1 latency=2.089992731s method=POST status=500 url=/v1/embeddings

5:40AM INF Success ip=127.0.0.1 latency="63.617µs" method=GET status=200 url=/readyz

结果报错了。

3,可以编译embeddings.cpp 执行bge 大模型

项目地址:

https://github.com/xyzhang626/embeddings.cpp

下载项目:

https://hf-mirror.com/BAAI/bge-base-zh-v1.5

#然后进行编译:

git clone --recursive https://github.com/xyzhang626/embeddings.cpp.git

cd embeddings.cpp

mkdir build

cd build

cmake .. -DBUILD_SHARED_LIBS=OFF -DCMAKE_BUILD_TYPE=Release

make

cd models

python download-repo.py BAAI/bge-base-zh-v1.5

sh run_conversions.sh bge-base-zh-v1.5

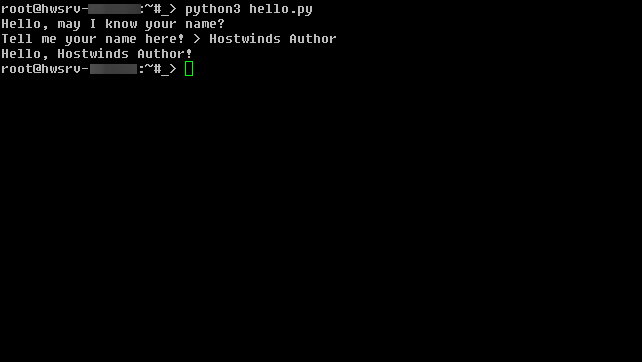

#运行main

cd ..

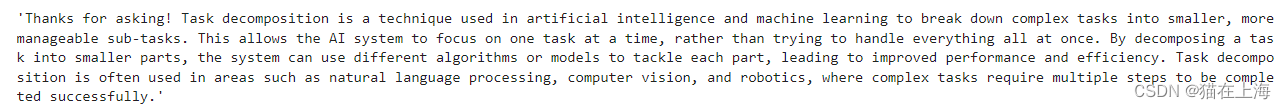

./build/bin/main -m ./models/bge-base-zh-v1.5/ggml-model-q4_0.bin

然后就而可以运行成功啦。使用的autodl的环境。

4,总结

LocalAI的项目里面的embedding 是 bert embedding.

不支持BGE 模型,有大神给改造支持了BGE的模型了。