在深度学习和机器学习的世界中,梯度下降算法无疑占据了举足轻重的地位。作为优化算法的核心,梯度下降通过迭代的方式,不断调整模型的参数,以最小化损失函数,进而提升模型的预测性能。而在梯度下降的过程中,学习率的选择与调节至关重要,它直接影响到算法的收敛速度和模型的最终性能。

一、学习率的基本概念与重要性

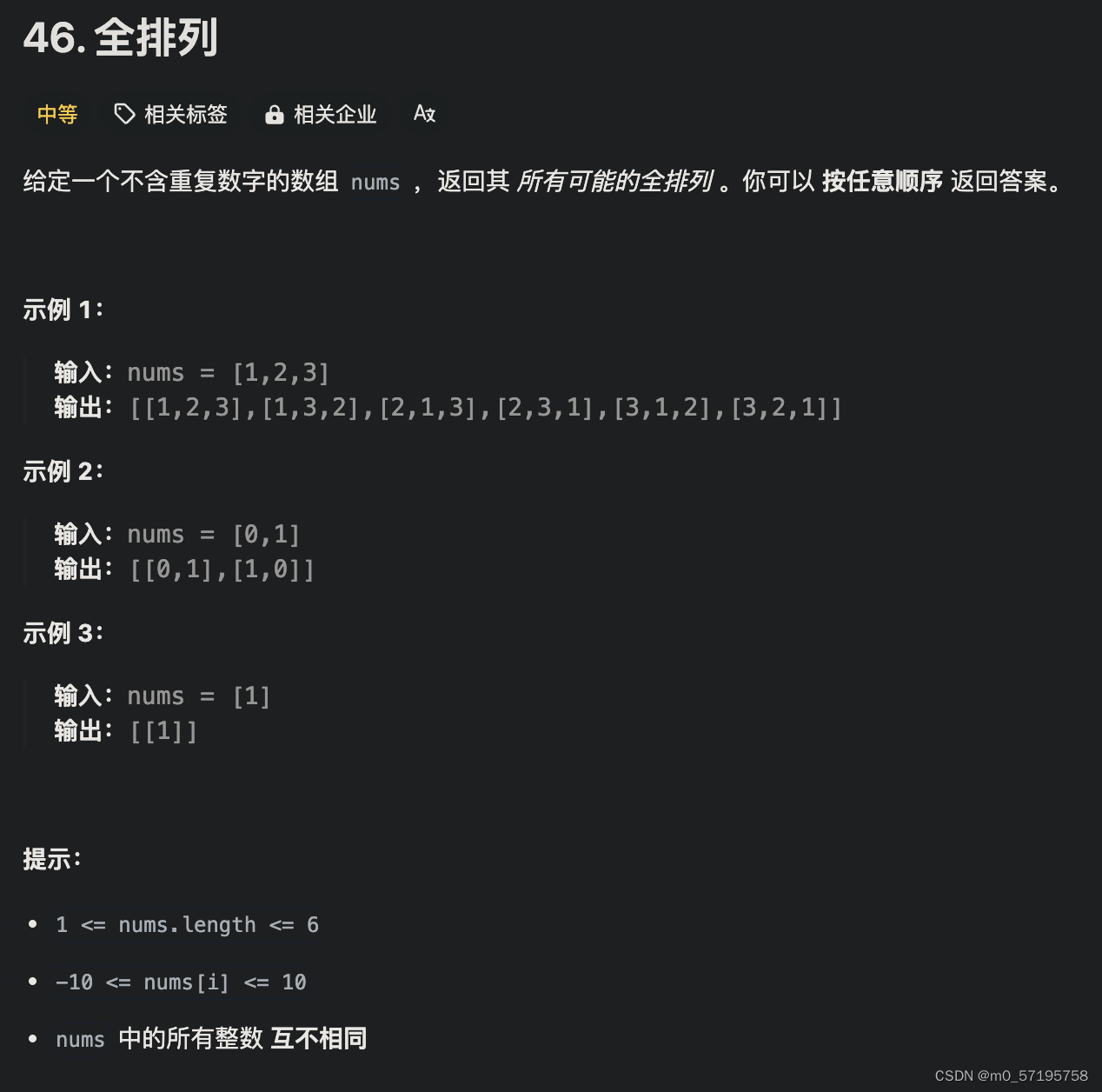

学习率,作为梯度下降算法中的一个关键超参数,决定了参数更新的步长。在每一次迭代中,算法会根据当前位置的梯度(即损失函数对参数的导数)和学习率,计算出参数的更新量,并据此更新模型的参数。学习率的大小直接影响到参数更新的幅度和速度,进而影响到算法的收敛性和模型的性能。

如果学习率设置得过大,可能会导致算法在损失函数的最小值附近震荡,甚至发散;如果学习率设置得过小,虽然可以保证算法的收敛性,但会导致收敛速度过慢,甚至陷入局部最小值。因此,如何合理设置和调节学习率,是梯度下降算法中需要重点关注的问题。

二、学习率的调节技巧

- 固定学习率

固定学习率是最简单直接的方法,即在整个训练过程中保持学习率不变。这种方法简单易行,但往往难以适应不同阶段的训练需求。在训练初期,模型参数离最优解较远,需要较大的学习率来快速接近最优解;而在训练后期,模型参数已经接近最优解,需要较小的学习率来精细调整参数。因此,固定学习率往往难以兼顾训练的不同阶段。

- 学习率衰减

学习率衰减是一种常用的学习率调节方法,即在训练过程中逐渐减小学习率。这种方法可以兼顾训练的不同阶段,初期使用较大的学习率快速接近最优解,后期使用较小的学习率进行精细调整。常用的学习率衰减策略包括指数衰减、多项式衰减等。

- 自适应学习率

自适应学习率方法根据模型训练的实际情况动态调整学习率。这类方法通常会在每次迭代时根据梯度的大小、方向等信息来调整学习率,以更好地适应不同阶段的训练需求。常见的自适应学习率算法包括Adam、RMSprop等。

三、学习率调节的优化策略

- 网格搜索与随机搜索

网格搜索和随机搜索是两种常用的超参数优化方法,也适用于学习率的调节。网格搜索通过遍历预定义的学习率取值范围,找到最优的学习率;随机搜索则在预定义的学习率取值范围内随机采样,通过多次试验找到较优的学习率。这两种方法都可以在一定程度上找到合适的学习率,但计算成本较高。

- 学习率调度器

学习率调度器是一种更高级的学习率调节策略,它可以根据模型的训练情况动态调整学习率。例如,当模型在一段时间内性能没有提升时,可以减小学习率以尝试跳出局部最小值;当模型性能出现震荡时,可以增大学习率以尝试跳出震荡区域。学习率调度器可以根据具体的训练情况灵活调整学习率,从而提高模型的性能。

四、实践建议与注意事项

- 初始学习率的设置

初始学习率的设置对于梯度下降算法的收敛速度和模型的性能至关重要。过大的初始学习率可能导致算法发散,而过小的初始学习率则可能导致算法收敛速度过慢。因此,在实际应用中,可以通过经验法则或简单的实验来确定一个合适的初始学习率范围。

- 学习率调整的频率与幅度

学习率的调整频率和幅度需要根据模型的训练情况来确定。在训练初期,可以每隔几个epoch调整一次学习率,并设置较大的调整幅度;在训练后期,则可以减小调整频率和幅度,以避免对模型性能产生过大的影响。

- 结合其他优化技巧

除了调节学习率外,还可以结合其他优化技巧来进一步提高模型的性能。例如,可以使用动量来加速收敛;可以使用正则化来防止过拟合;还可以使用批量归一化来稳定训练过程等。