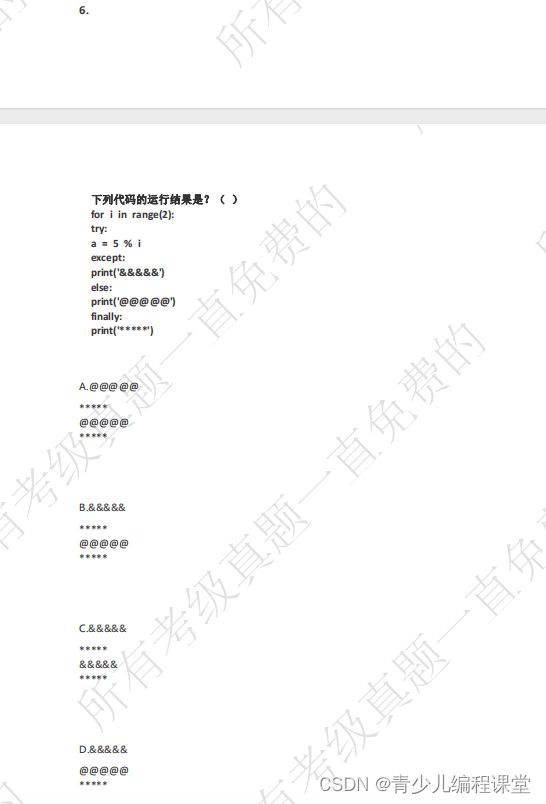

1、提示校准为什么有助于减轻基于提示的学习中的偏见?

提示校准包括调整提示,尽量减少产生的输出中的偏差。

其他:微调修改模型本身,而数据增强扩展训练数据,梯度裁剪防止在训练期间爆炸梯度。

2、是否需要为所有基于文本的LLM用例提供矢量存储?

向量存储用于存储单词或句子的向量表示。这些向量表示捕获单词或句子的语义,并用于各种NLP任务。并非所有基于文本的LLM用例都需要矢量存储。有些任务,如情感分析和翻译,不需要RAG也就不需要矢量存储。

3、用于将大型语言模型(LLM)与人类价值观和偏好对齐的技术?

- 人类反馈中强化学习(RLHF),其中人类反馈用于改进LLM的奖励函数,引导其产生与人类偏好一致的输出。

- 直接偏好优化(DPO)是另一种基于人类偏好直接比较不同LLM输出以指导学习过程的技术。

数据增强Data Augmentation是种通用的机器学习技术,它涉及使用现有数据的变化或修改来扩展训练数据。虽然它可以通过影响模型的学习模式间接影响LLM一致性,但它并不是专门为人类价值一致性而设计的。

4、在RLHF中,如何描述“reward hacking”?

Reward hacking是指在RLHF中,agent发现奖励函数中存在意想不到的漏洞或偏差,从而在没有实际遵循预期行为的情况下获得高奖励的情况,也就是说,在奖励函数设计不有漏洞的情况下才会出现reward hacking的问题。

虽然优化期望行为是RLHF的预期结果,但它并不代表reward hacking。在reward hacking中,代理偏离期望的行为,找到一种意想不到的方式(或者漏洞)来最大化奖励。

5、预训练模型的体系结构的作用?

预训练模型的体系结构作为微调的基础。像大型模型(例如GPT-3)中使用的复杂而通用的架构允许更大程度地适应不同的任务。微调数据集的大小发挥了作用,但它是次要的。一个架构良好的预训练模型可以从相对较小的数据集中学习,并有效地推广到目标任务。

虽然微调数据集的大小可以提高性能,但它并不是最关键的因素。即使是庞大的数据集也无法弥补预训练模型架构的局限性。设计良好的预训练模型可以从较小的数据集中提取相关模式,并且优于具有较大数据集的不太复杂的模型。

6、Transformer 结构中的自注意力机制在模型中主要起到了什么作用?

Transformer 的自注意力机制会对句子中单词的相对重要性进行总结。根据当前正在处理的单词动态调整关注点。相似度得分高的单词贡献更显著,这样会对单词重要性和句子结构的理解更丰富。这为各种严重依赖上下文感知分析的NLP任务提供了支持。

7、在LLM中使用子词算法(如BPE或WordPiece)的优点是什么?

LLM处理大量的文本,如果考虑每一个单词,就会导致一个非常大的词表。像字节对编码(BPE)和WordPiece这样的子词算法将单词分解成更小的有意义的单位(子词),然后用作词汇表。这大大减少了词汇量,同时仍然捕获了大多数单词的含义,使模型更有效地训练和使用。

子词算法不直接减少训练数据量。数据大小保持不变。虽然限制词汇表大小可以提高计算效率,但这并不是子词算法的主要目的。它们的主要优点在于用较小的单位集有效地表示较大的词汇表。

8、与Softmax相比,Adaptive Softmax如何提高大型语言模型的速度?

标准Softmax需要对每个单词进行昂贵的计算,Softmax为词表中的每个单词进行大量矩阵计算,导致数十亿次操作,而Adaptive Softmax利用Zipf定律(常用词频繁,罕见词不频繁)按频率对单词进行分组。经常出现的单词在较小的组中得到精确的计算,而罕见的单词被分组在一起以获得更有效的计算。这大大降低了训练大型语言模型的成本。

虽然稀疏表示可以改善内存使用,但它们并不能直接解决Softmax在大型词汇表中的计算瓶颈。预训练嵌入增强了模型性能,但没有解决Softmax计算复杂性的核心问题。

9、可以调整哪些推理配置参数来增加或减少模型输出层中的随机性?

在文本生成过程中,大型语言模型(LLM)依赖于softmax层来为潜在的下一个单词分配概率。温度Temperature是影响这些概率分布随机性的关键参数。当温度设置为低时,softmax层根据当前上下文为具有最高可能性的单个单词分配显着更高的概率。更高的温度“软化”了概率分布,使其他不太可能出现的单词更具竞争力。

最大新令牌数仅定义LLM在单个序列中可以生成的最大单词数。top -k采样限制softmax层只考虑下一个预测最可能的前k个单词。

10、当模型不能在单个GPU加载时,什么技术可以跨GPU扩展模型训练?

FSDP(Fully Sharded Data Parallel)是一种技术,当模型太大而无法容纳在单个芯片的内存时,它允许跨GPU缩放模型训练。FSDP可以将模型参数,梯度和优化器进行分片操作,并且将状态跨GPU传递,实现高效的训练。

DDP(分布式数据并行)是一种跨多个GPU并行分发数据和处理批量的技术,但它要求模型适合单个GPU,或者更直接的说法是DDP要求单个GPU可以容纳下模型的所有参数。

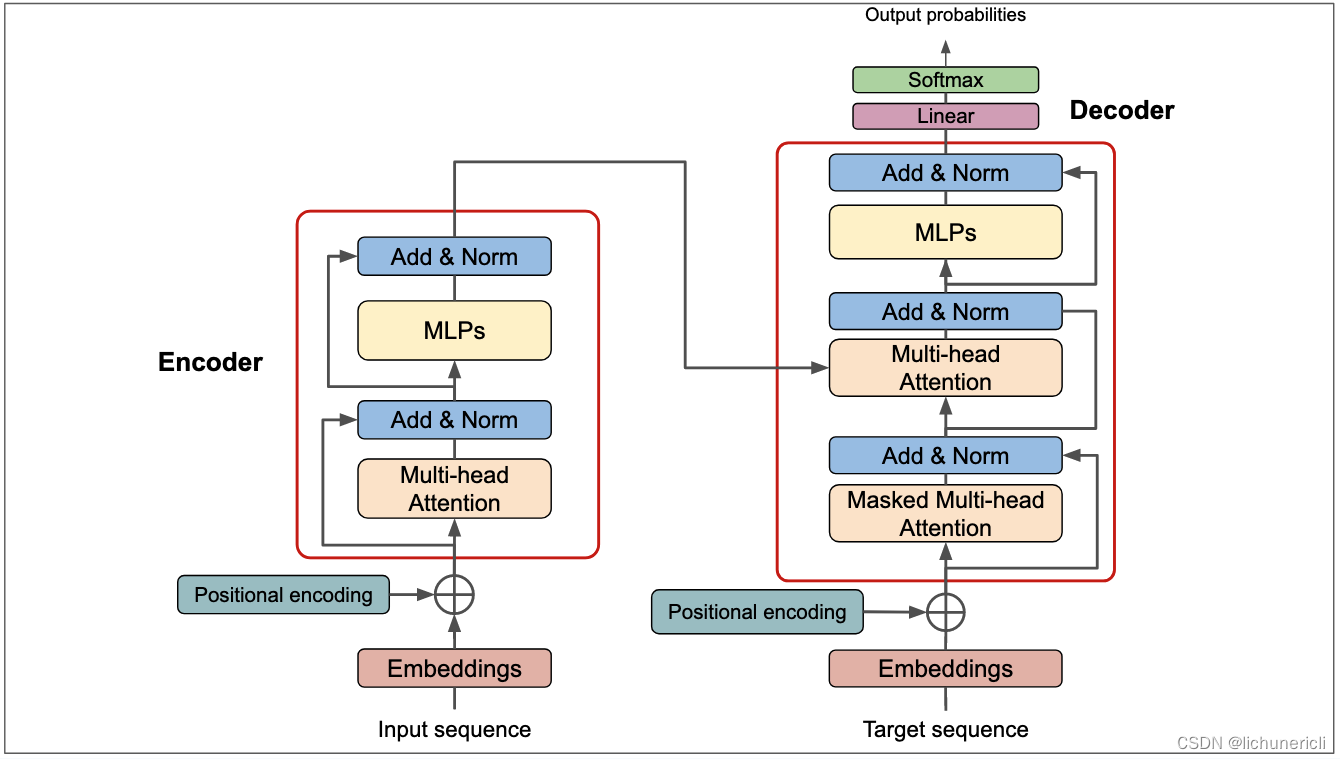

11、构建向量数据库的时用的 Embedding 模型的结构?

- 序列到序列(sequence-to-sequence)模型结构

- 结构组成:序列到序列模型由编码器(encoder)和解码器(decoder)组成。编码器将输入序列编码成一个固定长度的向量,解码器则将该向量解码成目标序列。

- 应用场景:序列到序列模型适用于机器翻译、文本摘要等任务,可以用于将输入文本转换为向量表示,并存储在向量数据库中。

- 优势:序列到序列模型能够捕捉输入序列的整体信息,并在解码过程中生成目标序列,适用于需要生成序列的场景。

- 编码器-解码器(encoder-decoder)模型结构

- 结构组成:编码器-解码器模型与序列到序列模型类似,也包括编码器和解码器。编码器将输入序列编码成一个固定长度的向量,解码器则将该向量解码成目标序列。

- 应用场景:编码器-解码器模型适用于文本摘要、问答系统等任务,可以将输入文本转换为向量表示,并存储在向量数据库中。

- 优势:编码器-解码器模型能够捕捉输入序列的整体信息,并在解码过程中生成目标序列,适用于需要生成序列的场景。

- 双向(bi-directional)模型结构

- 结构组成:双向模型包括两个子模型:正向模型和反向模型。正向模型从输入序列的起始位置到结束位置进行处理,反向模型则从结束位置到起始位置进行处理。最后,将两个子模型的输出进行合并。

- 应用场景:双向模型适用于文本分类、情感分析等任务,可以将输入文本转换为向量表示,并存储在向量数据库中。

- 优势:双向模型能够同时捕捉输入序列的前向和后向信息,提高了模型对文本的理解能力。

- 多头(multi-head)模型结构

- 结构组成:多头模型包括多个独立的子模型(称为头),每个子模型都有自己的参数和输出。最后,将所有子模型的输出进行合并。

- 应用场景:多头模型适用于文本分类、情感分析等任务,可以将输入文本转换为向量表示,并存储在向量数据库中。

- 优势:多头模型能够捕捉不同子模型对输入序列的不同表示,提高了模型对文本的泛化能力。

- 融合(fusion)模型结构

- 结构组成:融合模型包括多个独立的子模型,每个子模型对输入序列进行不同的处理。最后,将所有子模型的输出进行合并。

- 应用场景:融合模型适用于文本分类、情感分析等任务,可以将输入文本转换为向量表示,并存储在向量数据库中。

- 优势:融合模型能够结合不同子模型对输入序列的不同表示,提高了模型对文本的泛化能力和鲁棒性。

- 总结:在构建向量数据库时,可以根据具体的应用场景和需求选择合适的嵌入层模型结构。例如,对于需要生成序列的任务,可以选择序列到序列模型或编码器-解码器模型;对于需要同时捕捉输入序列的前向和后向信息的任务,可以选择双向模型;对于需要提高模型对文本的泛化能力和鲁棒性的任务,可以选择多头模型或融合模型。通过选择合适的模型结构,可以提高向量数据库的性能和适用性。

12、切分段落的模型的结构?

在构建向量数据库时,切分段落模型的结构通常包括嵌入层、切分段落层、连接层和输出层。

- 嵌入层(Embedding Layer)

- 作用:嵌入层将原始数据(如文本、时间序列点、空间坐标等)转换为固定大小的向量表示。这一层通常使用预训练的模型或训练特定的嵌入模型来完成。

- 示例:对于文本数据,可以使用Word2Vec、GloVe或BERT等模型将单词或句子转换为向量。对于时间序列,可以使用例如CNN或RNN来学习序列的嵌入表示。

- 切分段落层(Segmentation Layer)

- 作用:切分段落层将数据分割成更小的片段,以便更好地捕捉局部特征和模式。这一层可以是滑动窗口、固定窗口或基于某种规则的分割。

- 示例:在时间序列数据中,可以使用滑动窗口将序列分割成固定长度的片段。在文本数据中,可以使用句子或段落作为分割单元。

- 连接层(Concatenation Layer)

- 作用:连接层将切分段落层输出的片段向量连接起来,形成一个新的向量,该向量包含了所有片段的信息。这一层可以是简单的向量拼接,也可以是更复杂的操作,如注意力机制。

- 示例:在时间序列数据中,可以将所有片段的向量拼接成一个长向量。在文本数据中,可以使用注意力机制来加权不同的片段向量。

- 输出层(Output Layer)

- 作用:输出层根据任务需求生成最终的输出。这可以是分类标签、回归值或其他形式的预测。

- 示例:在文本分类任务中,输出层可能是一个softmax层,输出每个类别的概率。在时间序列预测任务中,输出层可能是一个回归层,输出预测的序列值。

针对不同数据类型的切分段落模型应用示例:

- 时间序列数据:例如,在股票价格预测中,可以使用LSTM作为嵌入层来学习每个时间点的嵌入表示,然后使用滑动窗口作为切分段落层来分割序列,连接层将所有窗口的向量拼接起来,最后输出层是一个回归层,预测未来的股票价格。

- 空间序列数据:例如,在图像分割中,可以使用卷积神经网络(CNN)作为嵌入层来提取图像特征,然后使用不同尺度的窗口作为切分段落层来分割图像,连接层将所有窗口的特征图拼接起来,最后输出层是一个分类层,为每个像素分配一个类别标签。

- 文本数据:例如,在情感分析中,可以使用BERT作为嵌入层来获取每个单词的上下文表示,然后使用句子或段落作为切分段落层,连接层可以是BERT的池化层,将所有单词的表示聚合起来,最后输出层是一个分类层,输出情感标签。

13、 LoRA(Low-Rank Adaptation)训练过程中,transformer 更新哪些参数?

在LoRA微调过程中,引入两个低秩矩阵A和B,这些矩阵用于修改原始模型中的注意力机制和前馈网络,从而允许模型适应新的任务或领域。原始模型的参数大部分被冻结,只有A和B以及必要的适配层(adapter layers)会被训练。

- 学习率(Learning Rate),学习率决定了参数更新的速度。在LoRA中,由于更新的参数较少,通常可以使用较高的学习率,以便更快地适应新数据。学习率的选择对模型收敛速度和最终性能有显著影响。

- 批大小(Batch Size),批大小影响模型的稳定性和泛化能力。较大的批大小可以提高训练效率,但可能需要更小的学习率。在LoRA中,由于参数更新较少,可以使用较大的批大小而不会遇到内存问题。

- 序列长度(Sequence Length),序列长度对Transformer模型的性能至关重要。在LoRA中,由于不需要更新所有的模型参数,可以处理较长的序列,从而提高模型对长文本的理解能力。

- 层数(Number of Layers),在LoRA中,层数通常保持不变,因为只更新了适配层。但是,层数的选择在原始模型中是很重要的,因为它决定了模型的表达能力。更多的层数可以提高模型捕捉复杂关系的能力。

- 隐藏单元数量(Number of Hidden Units),隐藏单元数量决定了模型的大小和容量。在LoRA中,由于只更新了适配层,模型的大小不会显著增加。但是,隐藏单元数量的选择在原始模型中是很重要的,因为它影响了模型的学习能力。

- 优化器参数(Optimizer Parameters),优化器参数,如动量(momentum)、权重衰减(weight decay)和梯度裁剪(gradient clipping),对模型训练的稳定性和性能有重要影响。在LoRA中,由于更新的参数较少,可能需要调整这些参数以获得最佳性能。

14、ChatGLM 123 变化的差异点?

- 模型结构和参数:随着版本的升级,模型的结构可能会有所调整,例如增加层数、调整注意力机制等,以提高模型的表达能力和性能。

- 训练数据和目标:不同版本的模型可能会使用不同的训练数据和目标,例如增加更多的语言数据、优化多语言支持等,以提高模型的泛化能力和适应性。

- 优化器和训练策略:不同版本的模型可能会使用不同的优化器和训练策略,例如调整学习率、使用更先进的正则化技术等,以提高模型的收敛速度和性能。

- 应用场景和功能:随着版本的升级,模型可能会增加新的应用场景和功能,例如支持更多的任务、提供更多的接口等,以满足用户的需求。

15、缓解大模型幻觉的方式?

模型在生成文本时产生不准确、虚构或不相关信息。缓解这种幻觉的方法包括:

- 改进训练数据和算法

- 使用高质量、多样化和经过验证的数据集进行训练,以减少模型学习错误信息的机会。

- 采用更加先进的训练算法,如对比学习、知识增强训练等,以提高模型对真实信息的理解。

- 增加上下文限制

- 在生成文本时,提供更详细的上下文信息,以指导模型生成与上下文一致的回答。

- 使用控制生成(Controlled Generation)技术,限制模型生成文本的范围和风格。

- 提高模型的校验能力

- 训练模型进行自我校验,即在生成文本后,模型能够评估其准确性和真实性。

- 结合外部知识源,如知识图谱或数据库,以验证生成信息的准确性。

- 使用更小的模型

- 有时更小的模型在特定任务上可能表现得更准确,因为它们不太可能过度泛化或产生幻觉。

- 细粒度的模型调整

- 对模型进行微调,使其在特定领域或任务上表现更好,减少幻觉现象。

- 调整模型参数,如学习率、批次大小等,以优化模型性能。

- 多模型集成

- 使用多个模型的集成来提高生成文本的准确性。如果多个模型都产生相同的输出,那么这个输出更可能是准确的。

- 用户反馈和交互

- 允许用户提供反馈,指出模型产生的幻觉,并据此调整模型。

- 设计交互式系统,让用户在生成过程中指导模型,以减少幻觉。

- 引入外部监督

- 使用人类评估者对模型生成的文本进行评估,标记幻觉,并用于模型的进一步训练。

- 结合外部工具或API来验证信息的真实性,例如在回答问题时查询实时数据或权威资料。

- 增强透明度和解释性

- 提高模型的解释性,使开发者和用户能够理解模型的决策过程,从而更好地识别和纠正幻觉。

16、Transformer的缩放因子dk以及归一化?

多头注意力机制中的缩放因子

在Transformer模型中,多头注意力机制是处理序列数据的关键组成部分。为了计算注意力分数,我们通常会计算查询(Q)、键(K)和值(V)的线性变换,然后计算Q和K的点积,以获得每个键对应的注意力权重。但是,当使用较大的矩阵(例如,较大的嵌入维度dk)进行点积时,得到的注意力分数的方差可能会很大,这可能导致梯度消失或爆炸问题,影响模型的学习效果。为了避免这个问题,我们在计算点积之后,除以根号dk。

具体来说,如果我们将注意力分数记为点积结果,那么这个缩放过程可以表示为:

这个缩放因子的数学原理基于一个事实:当使用随机高斯变量进行点积时,结果的方差将是每个维度的方差之和。对于dk维的向量,每个维度的方差是1,所以点积的方差是dk。通过除以根号dk,我们可以将注意力分数的方差重新调整回1,这有助于保持梯度的大小在一个更适宜的范围内,从而使得模型训练更加稳定。

实际应用优势在于,这种缩放可以使得模型在训练时更加稳定,特别是在使用非常深的网络结构时。它有助于防止梯度消失或爆炸,从而使得模型能够更好地学习长距离依赖关系。

层归一化(Layer Normalization)

层归一化是对神经网络中激活函数的输出进行归一化的技术。与批量归一化(Batch Normalization)不同,层归一化是对单个样本的所有激活进行归一化,而不是对一批样本的同一维度进行归一化。

在层归一化中,我们通常对激活向量的最后一个维度进行归一化处理,即对每个样本的所有特征进行归一化。具体来说,对于每个样本,我们将每个特征减去其均值,并除以其标准差,以获得归一化后的值。

层归一化的目的是为了加速训练过程并提高模型的性能。通过将每个特征的分布标准化,层归一化有助于解决内部协变量偏移问题,即不同层之间的输入分布变化问题。这对于深度网络来说尤为重要,因为随着信息在网络中的传播,激活分布可能会发生显著变化。

层归一化的优势在于它不依赖于批量大小,这使得它特别适合于处理可变长度的序列数据,如自然语言处理任务中的句子。此外,层归一化有助于模型更好地学习,因为它可以使得每个特征的规模保持一致,从而使得梯度在反向传播时更加稳定。这种稳定性有助于模型在训练过程中更快地收敛,并提高模型在测试数据上的泛化能力。

17、Transformer模型中的嵌入向量?

在Transformer模型中,输入的向量通常是指词嵌入(word embeddings)或者位置编码(positional encodings)的输出,这些嵌入向量在模型中作为输入序列处理。输入向量的维度取决于模型的设计和训练数据的特性。具体来说,输入向量的维度通常由以下因素决定:

- 词汇大小:这指的是模型处理的语言的词汇量。每个词都会被映射到一个唯一的嵌入向量。

- 嵌入维度:这指的是每个词嵌入向量的维度大小。这个维度是超参数,通常设置为256、512、1024等值。在Transformer模型中,嵌入维度也会影响到多头注意力机制中的缩放因子,因为缩放因子的分母就是根号dk,其中dk就是嵌入维度。

- 序列长度:这指的是模型能够处理的最大序列长度。在处理文本数据时,这通常对应于句子或段落中的词数。序列长度也是一个超参数,需要根据具体任务来设定。

因此,如果我们假设嵌入维度为dmodel,序列长度为L,那么输入向量的维度通常是L×dmodel。这个二维矩阵表示了一个序列中每个词的嵌入向量,其中每一行对应序列中的一个词,每一列对应嵌入空间中的一个维度。在实际应用中,输入向量在经过嵌入层后,还可能会与位置编码相加,以保留序列中词的位置信息。这样的设计使得Transformer模型能够有效地处理序列数据,同时捕捉到序列中词的顺序关系。

18、为什么现在的大模型大多是 decoder-only 的架构?

现在的大模型大多是 decoder-only 的架构,主要是因为这种架构在生成文本方面具有优势。Decoder-only 架构的模型,如 GPT-3 和 ChatGLM,仅使用解码器部分来进行文本生成,这使得它们能够更有效地生成连贯、自然的文本。这种架构的主要优点包括:

- 文本生成能力强:Decoder-only 架构的模型在生成文本方面表现出色,能够生成连贯、自然的文本,适用于各种文本生成任务,如机器翻译、文本摘要、问答等。

- 并行计算:Decoder-only 架构的模型可以更有效地进行并行计算,因为它们在生成文本时不需要像编码器-解码器架构那样进行编码器和解码器之间的交互。

- 参数效率:Decoder-only 架构的模型通常需要更少的参数来达到与编码器-解码器架构相当的生成能力,这使得它们在训练和部署方面更加高效。

虽然 Decoder-only 架构的模型在文本生成方面有很多优点,但它们在处理输入文本方面可能不如编码器-解码器架构的模型灵活。因此,选择哪种架构取决于具体的应用场景和需求。

19、LLM 中的 token概念?

在LLM中,token 是个关键概念,它代表了模型处理文本的基本单元。Token 可以是一个词、一个字符、一个子词(subword),或者任何预训练时模型使用的最小语义单位。在处理文本时,模型会将输入文本和生成的文本分割成一系列的 token。以下是 token 的一些关键特点:

- 词汇表:大型语言模型通常有一个固定的词汇表,包含模型能够理解和生成的所有 token。每个 token 在词汇表中都有一个唯一的索引。

- 子词分割:为了处理大规模的文本数据和减少词汇表的大小,现代的 LLM 通常使用子词分割技术,如 Byte Pair Encoding (BPE) 或 SentencePiece。这些技术可以将词分解为更小的子词单元,这些子词单元可以组合成完整的词汇。

- 上下文关联:Token 并不是孤立存在的,它们在文本中具有上下文关联。模型通过分析 token 之间的相互关系来理解文本的含义和上下文。

- 序列处理:在处理文本时,LLM 会将文本分割成一系列的 token,并按照顺序进行处理。模型的每次预测都是基于当前的输入 token 以及之前处理过的 token 的上下文。

- 变长输入:由于文本的长短不一,模型需要能够处理变长的 token 序列。这通常通过使用注意力机制和循环神经网络结构来实现。

- 特殊 token:在许多模型中,除了词汇表中的普通 token 外,还有一些特殊 token,如 [CLS](用于分类任务)、[SEP](用于分隔句子或片段)和 [MASK](用于掩码语言模型任务)等。

20、引起大型语言模型中的偏见因素?

- 训练数据:LLM 的偏见很大程度上来源于其训练数据。如果训练数据中包含偏见或歧视性的语言,模型可能会学习并放大这些偏见。例如,如果数据集中存在性别、种族、宗教或文化偏见的内容,模型可能会在生成文本时反映出这些偏见。

- 数据代表性:训练数据可能无法充分代表所有用户群体或观点,导致模型在处理某些群体或话题时表现出偏见。数据集中的覆盖不足或过度代表某些群体可能会加剧这种偏见。

- 社会和文化背景:语言是文化和社会背景的反映。如果训练数据主要来源于特定文化或社会背景,模型可能会在这些背景下固有的偏见中学习。

- 模型设计:模型的设计和架构可能无意中引入偏见。例如,如果模型的目标函数或优化过程导致对某些类型的输出给予优先权,这可能会影响模型的输出并引入偏见。

- 人类干预:在模型开发过程中,人类可能会在数据清洗、模型调优或应用部署等环节引入主观偏见。

- 模型应用:模型的应用方式也可能导致或放大偏见。例如,如果一个模型被用于决策过程,而该过程本身存在结构性偏见,那么模型的输出可能会反映这些偏见。

- 反馈循环:一旦部署,模型可能会通过用户交互接收反馈,这可能会形成一个强化偏见的学习循环。如果用户对模型的偏见输出给予正面反馈,模型可能会进一步学习并加强这些偏见。

为了减少 LLM 中的偏见,研究人员和开发者正在采取多种措施,包括使用更平衡和多样化的训练数据、设计无偏见的模型训练算法、实施偏见检测和缓解技术,以及确保模型的应用过程公平和透明。

21、大型语言模型中"幻觉"?

在大型语言模型(LLM)中,"幻觉"(hallucination)现象指的是模型生成或回答问题时提供的信息是不准确、虚构的或者完全没有依据的。这种现象可能会导致用户对模型的信任度下降,特别是在需要高准确性和可靠性的应用场景中。以下是一些减轻幻觉现象的方法:

- 改进训练数据:确保训练数据的质量和准确性。使用经过验证和清理的数据集,减少错误和不准确信息的传播。

- 对抗性训练:在训练过程中包含对抗性样例,即故意包含错误信息的样例,让模型学会识别和避免这些错误。

- 知识增强:结合外部知识源,如百科全书、专业知识数据库等,以提高模型对事实信息的掌握能力。

- 事实一致性检查:开发后处理机制,用于检查模型生成的内容与已知事实的一致性。可以使用现有的知识库或搜索引擎来验证信息的真实性。

- 提高模型透明度:让用户了解模型的局限性和可能产生的错误类型,这样用户在评估模型输出时会更加谨慎。

- 使用提示和上下文:通过精心设计的提示和上下文来引导模型生成更准确的信息。这可以帮助模型更好地聚焦于问题,减少无关信息的生成。

- 多模型集成:使用多个模型的集成来提高准确性。不同的模型可能会犯不同的错误,通过比较和融合多个模型的输出,可以减少个别模型的幻觉现象。

- 限制生成长度:较长的生成文本更有可能产生幻觉。通过限制生成文本的长度,可以减少模型产生无关或错误信息的机会。

- 用户反馈:收集用户反馈,对模型的输出进行评估和改进。用户可以发现模型的问题并提供实时反馈,帮助模型不断学习和改进。

- 持续迭代和更新:随着新数据的出现和技术的进步,持续对模型进行迭代和更新,以保持其准确性和可靠性。

22、ChatGPT 的“零样本”和“少样本” ?

ChatGPT 的“零样本”和“少样本”学习是两种不同的机器学习范式,它们都属于迁移学习的范畴。这两种范式的主要区别在于训练时模型见到的数据量。

- 零样本学习(Zero-Shot Learning)

零样本学习是指模型在面对一个在训练时完全未见过的任务或类别时,能够利用已有的知识和信息来正确地进行分类或预测。在零样本学习中,模型不需要针对新任务进行任何额外的训练或微调。它依赖于模型在训练过程中学习到的广泛的知识和模式识别能力,以便在面对新类别时能够进行合理的推断。

例如,如果一个模型在训练时学习了如何区分猫和狗,但在测试时遇到了一个从未见过的动物类别,如狮子,零样本学习允许模型根据它对猫和狗的了解来推断出狮子的类别。

- 少样本学习(Few-Shot Learning)

少样本学习是指模型在面对新任务时,仅需要少量的样本就能够快速适应并做出准确的预测。在少样本学习中,模型可能会见到一些与新任务相关的样本,但数量远少于传统的监督学习所需的样本量。少样本学习的关键在于模型能够有效地利用这些少量的样本,结合先前的知识,来提高对新任务的性能。

例如,如果一个模型在训练时学习了如何区分猫和狗,但在测试时遇到了一个新的动物类别,如兔子,少样本学习允许模型通过仅查看几个兔子的样本来快速学习如何区分兔子和其他动物。

ChatGPT 等大型语言模型通常具备零样本和少样本学习能力,这使得它们在处理多种不同的任务时表现出色,即使是在面对未见过的任务或类别时也能够生成合理的输出。这些能力在很大程度上归功于模型在训练过程中接触到的广泛和多样化的文本数据,以及它们强大的模式识别和抽象能力。

23、Transformer 的多头注意力机制?

基于 Transformer 的架构使用多头注意力机制主要有以下几个原因:

- 并行处理能力:多头注意力机制允许模型在不同的表示子空间中并行地学习信息。每个头关注输入序列的不同部分,可以同时处理不同的信息,从而提高模型处理数据的效率。

- 捕捉不同层次的依赖关系:不同的注意力头可以学习到输入序列的不同层次和类型的依赖关系。例如,一些头可能专注于局部信息,而另一些头可能捕捉长距离依赖。这样,模型能够同时考虑到局部和全局的信息,提高对序列的理解能力。

- 增强模型的表达能力:通过将输入序列分割成多个头,每个头都有自己的权重矩阵,模型可以获得更多的参数来学习复杂的模式。这种分割和组合的过程增加了模型的表达能力,使得模型能够更好地捕捉数据的复杂性和多样性。

- 减少计算复杂性:虽然 Transformer 模型中的自注意力机制具有很高的计算复杂性,但是通过多头注意力机制,可以将注意力计算分解到多个头上,每个头只需要处理输入序列的一部分。这样可以有效地减少每个头需要处理的维度,从而降低整体的计算复杂度。

- 提高泛化能力:由于多头注意力机制允许模型在不同的子空间中学习,这有助于模型泛化到新的、未见过的数据。模型可以从多个角度和层面理解数据,这有助于提高其在各种任务上的表现。

24、LLaMA使用旋转位置编码的一些关键优势?

LLaMA(Large Language Model Meta AI)模型使用旋转位置编码(RoPE,Rotary Positional Encoding)的原因在于它能够有效地处理序列中的位置信息,同时保持模型在处理长序列时的效率和性能。以下是使用旋转位置编码的一些关键优势:

- 长序列处理:传统的位置编码方法(如正弦和余弦函数)在序列长度增加时可能会导致性能下降。旋转位置编码通过一种新颖的方式将位置信息与序列中的值相结合,使得模型能够更好地处理长序列。

- 效率提升:旋转位置编码能够与 Transformer 模型中的多头自注意力机制无缝结合,不需要额外的参数或计算复杂度。这种方法使得模型在处理序列时更加高效。

- 位置信息的精确编码:旋转位置编码通过旋转矩阵来编码位置信息,这种方式能够为模型提供更加精确和细致的位置信号。这对于理解序列中元素的相对和绝对位置非常重要。

- 可扩展性:由于旋转位置编码不依赖于固定的函数或参数,它具有很好的可扩展性。这意味着模型可以很容易地适应不同的序列长度和任务需求。

- 实证效果:在实际应用中,使用旋转位置编码的模型在多项任务上展示了优异的性能。这种编码方式已经被证明是一种有效的解决方案,尤其是在处理长序列时。

总结来说,LLaMA 模型使用旋转位置编码是因为它能够有效地处理长序列,提高模型在处理位置信息时的效率和性能,同时保持模型的可扩展性和实证效果。这种编码方式是 Transformer 模型在自然语言处理等领域取得成功的重要因素之一。

25、低精度的float16、bfloat16 和 float32?

在训练大型语言模型时,为了提高计算效率和减少内存需求,通常会使用较低精度的浮点数格式。对于 float16、bfloat16 和 float32 这三种格式,它们各自有优势和局限性:

- float16:也称为半精度浮点数,它使用 16 位来表示一个数,其中 1 位用于符号,5 位用于指数,10 位用于尾数。float16 的主要优势在于它大幅减少了内存使用和计算资源的需求,但它的数值范围和精度较 float32 更小,可能会导致训练过程中的数值稳定性问题。

- bfloat16:即 Brain Floating Point,是一种 16 位浮点数格式,其中 1 位用于符号,8 位用于指数,7 位用于尾数。bfloat16 的指数部分与 float32 相同,因此它具有与 float32 相似的数值范围,但精度较低。bfloat16 在保持较大数值范围的同时减少了精度,这使其在需要大动态范围的应用中非常有用,比如深度学习中的大型模型训练。

- float32:也称为单精度浮点数,使用 32 位来表示一个数,其中 1 位用于符号,8 位用于指数,23 位用于尾数。float32 提供了较高的数值精度和较大的动态范围,是科学计算和工程应用中最常用的浮点数格式。然而,由于其较高的精度,float32 也需要更多的内存和计算资源。

在实际训练中,选择哪种格式取决于多个因素,包括模型的复杂性、可用的计算资源、数值稳定性要求以及性能目标。例如,对于大型模型,可能会优先考虑使用 bfloat16,因为它提供了较大的数值范围,同时相比 float32 减少了内存和计算资源的需求。而对于一些对数值稳定性要求极高的任务,可能会选择 float32 以确保训练的稳定性。

在训练过程中,也可能会结合使用不同的浮点数格式。例如,可以使用 float32 来存储权重和进行梯度更新,以保持数值稳定性,而在前向传播和反向传播过程中使用 float16 或 bfloat16 以提高计算效率。

26、解决训练中使用 float16 导致溢出问题的方法?

在使用 float16(半精度浮点数)进行训练时,由于它的数值范围和精度较 float32 更小,因此更容易遇到溢出问题。以下是一些解决训练中使用 float16 导致溢出问题的方法:

- 梯度缩放(Gradient Scaling),梯度缩放是一种常用的技术,通过在反向传播过程中将梯度放大一个固定因子,然后在应用梯度之前将其缩小相同的因子,从而避免在 float16 计算中发生梯度下溢。这种方法可以增加梯度的大小,使其保持在 float16 的数值范围内。

- 动态范围管理,在训练过程中动态地监控数值范围,并在必要时对激活函数的输出进行缩放,以防止溢出。这种方法需要对模型中的数值范围有深入的理解和精细的控制。

- 使用混合精度训练(Mixed Precision Training),混合精度训练结合使用 float16 和 float32。关键的操作使用 float32 以保持数值稳定性,而大多数计算使用 float16 以提高性能。这种方法可以在不牺牲太多精度的同时,显著提高训练速度。

- 优化器和权重更新,使用对数值范围更敏感的优化器,如 AdamW,它可以结合权重衰减和梯度缩放来提高数值稳定性。同时,确保权重更新步骤在 float32 精度下进行,以保持权重的稳定性。

- 适当的初始化和正则化,使用适当的权重初始化策略和正则化技术,如权重衰减或 dropout,可以帮助控制模型参数的大小,减少溢出的风险。

- 限制模型大小和复杂性,减少模型的层数或参数数量可以降低模型在训练过程中出现数值问题的风险。这通常需要根据具体任务的需求进行权衡。

- 数值稳定性监控, 在训练过程中监控激活函数的输出、梯度和其他关键数值,以确保它们保持在有效的范围内。如果检测到溢出,可以及时调整缩放因子或采取其他措施。

27、预训练(Pre-training)和微调(Fine-tuning)的差异?

预训练是在大规模的未标注文本数据上训练模型的过程。预训练的目的是让模型学习到语言的通用表示,捕捉到语言的基本规则、语法、语义和上下文信息。预训练通常是无监督的,意味着不需要人工标注的数据。预训练阶段的目标是使模型能够泛化到各种语言任务上。预训练的方法包括:

- 语言建模(Language Modeling):模型学习预测文本序列中的下一个词或字符。

- 降噪自动编码(Denoising Autoencoding):模型尝试从噪声版本的输入数据中重建原始数据。

- 掩码语言建模(Masked Language Modeling):模型学习预测被掩码(隐藏)的词或token。

微调是在预训练的模型上进行的有监督学习过程。微调的目的是将模型适应到特定的下游任务上,如文本分类、情感分析、问答系统等。微调阶段使用针对特定任务标注好的数据集,通过在这些数据上训练来调整模型的参数,使其能够更好地完成特定的任务。微调的方法通常包括:

- 在模型的输出层添加一个或多个针对特定任务的全连接层。

- 使用任务特定的损失函数来优化模型的参数。

- 在少量的迭代中训练模型,通常需要的时间比预训练少得多。

两者的关系和目的:

预训练和微调是相辅相成的。预训练让模型获得广泛的语言理解能力,而微调则将这些能力适配到特定的任务上。通过预训练,模型可以获得大量的语言知识,这些知识在微调阶段可以被重用和调整,从而在特定的任务上达到更好的性能。总结来说,预训练的目的是学习通用的语言表示,而微调的目的是将这种通用表示适配到特定的任务上。这种两阶段的方法使得深度学习模型能够在多种不同的NLP任务上取得出色的表现。

28、LLaMA中处理梯度消失和梯度爆炸问题?

LLaMA(Large Language Model Meta AI)模型在训练过程中处理梯度消失和梯度爆炸问题主要依赖于以下几个机制:

- 激活函数:LLaMA 模型使用了 GeGLU 激活函数,这是一种改进的 Gaussian Error Linear Units (GELU) 函数,它有助于缓解梯度消失问题。GeGLU 通过在门控机制中引入额外的线性变换,提高了信息的传递效率,从而有助于梯度的流动。

- 初始化策略:合适的参数初始化对于防止梯度问题至关重要。LLaMA 模型可能使用了如 Kaiming 初始化或 Xavier 初始化等策略,这些策略有助于保持前向和反向传播中的梯度在一个合适的范围内。

- 梯度裁剪:在训练过程中,如果检测到梯度超过某个阈值,可以使用梯度裁剪(Gradient Clipping)来限制梯度的最大值。这种方法可以防止梯度爆炸,保证训练的稳定性。

- 残差连接和归一化:LLaMA 模型采用了残差连接(Residual Connections)和层归一化(Layer Normalization)技术。残差连接允许梯度直接流过某些层,有助于缓解梯度消失问题。层归一化有助于稳定训练过程,使得每一层的输入都有稳定的分布,有助于梯度的流动。

- 适应性学习率:使用适应性学习率调整策略,如 Adam 或 AdamW 优化器,可以帮助在训练过程中自动调整学习率,有助于保持梯度的稳定性。

- 深度和宽度平衡:在设计模型时,平衡网络的深度和宽度也很重要。过深的网络可能会导致梯度消失,而过宽的网络可能会导致梯度爆炸。通过合理设计网络结构,可以减少这些问题的发生。

- 跳跃连接:除了残差连接,某些模型可能会采用跳跃连接(Skip Connections)或其他结构来增强梯度的传播。

29、LLaMA 模型使用了哪种激活函数?

30、LORA 和 Q-LORA?

LORA(Low-Rank Adaptation)和 Q-LORA 是两种用于微调大型语言模型的技术,它们旨在通过添加少量的参数来适应特定的下游任务,从而减少微调所需的计算资源和时间。

LORA 是一种参数高效微调(Parameter-Efficient Fine-Tuning, PEFT)技术,它通过在预训练模型的每一层中加入额外的低秩矩阵来引入微调参数。这些低秩矩阵将原始模型的权重与微调权重相结合,使得只有这些额外的参数需要在微调过程中学习,而原始模型的权重保持不变。LORA 的主要优点包括:

- 参数效率:LORA 只添加了少量的参数,这些参数通常比原始模型参数的数量少得多,从而大大减少了微调所需的计算资源。

- 微调速度:由于需要更新的参数数量减少,LORA 可以加快微调过程,使得模型能够更快地适应新的任务。

- 稳定性:LORA 通过限制微调参数的数量,有助于减少过拟合的风险,提高模型的泛化能力。

Q-LORA 是 LORA 的一个变种,它通过量化低秩矩阵的参数来进一步减少微调所需的内存和计算资源。Q-LORA 使用了低秩矩阵的量化版本,即将浮点数参数转换为低比特宽度的整数,从而减少了存储和计算的需求。Q-LORA 的主要优点包括:

- 内存和计算效率:通过量化低秩矩阵,Q-LORA 进一步减少了微调过程中的内存和计算需求,使得微调更加高效。

- 易于部署:量化后的模型占用更少的内存,更容易在资源受限的环境中部署。

- 性能保持:尽管使用了量化,Q-LORA 仍然能够保持模型在下游任务上的性能,使其成为一种实用的微调技术。

31、Transformer 中实现有效位置编码的方法?

在 Transformer 模型中,位置编码(Positional Encoding)是一种重要的机制,它允许模型理解输入序列中单词的顺序。对于长序列,有效的位置编码尤为重要,因为模型需要能够捕捉到序列中远距离元素之间的依赖关系。以下是一些在 Transformer 中实现有效位置编码的方法:

- 绝对位置编码:正弦和余弦函数,这是最常用的位置编码方法,它使用正弦和余弦函数的线性组合来编码位置信息。每个位置的编码是一个固定维度的向量,其元素由正弦和余弦函数生成,频率随维度增加而增加。这种编码方法可以扩展到任意长度的序列。

- 相对位置编码:相对位置注意力机制,这种方法不是在输入序列中添加绝对位置编码,而是在注意力机制中引入相对位置信息。这样,模型可以在计算注意力权重时考虑两个词之间的相对距离。

- 旋转位置编码(RoPE):一种新颖的位置编码方法,它通过旋转矩阵来编码位置信息。这种方法可以有效地处理长序列,因为它将位置信息与序列中的值相结合,而不需要额外的参数或计算复杂度。

- 可学习的位置编码:在这种方法中,位置编码是作为模型参数学习的,而不是硬编码的。这意味着模型可以自己学习如何最好地表示位置信息,这在与特定任务相关的位置信息方面可能是有益的。

- 多尺度位置编码:这种方法通过在不同的尺度上编码位置信息来捕捉不同粒度的依赖关系。例如,一些编码可能关注局部信息,而其他编码可能捕捉长距离依赖。

- 自适应位置编码:这种方法根据输入序列的长度和内容动态调整位置编码。例如,对于非常长的序列,模型可能会使用更复杂的位置编码策略来保持效率。

32、训练数据集的过滤和去重?

在自然语言处理(NLP)任务中,训练数据集的过滤和去重是至关重要的步骤。这些步骤有助于提高数据质量,减少噪声,并确保模型训练的效率和效果。

33、MOE的作用?

MOE(Multi-Objective Evolutionary Algorithm)是一种进化算法,它旨在同时优化多个目标函数,而不是只优化一个单一的目标函数。这种方法在现实世界中的问题中非常有用,因为许多问题涉及多个相互冲突的目标,例如,在设计一个系统时,可能需要在成本、性能、可靠性、安全性等多个方面进行权衡。MOE 的主要作用包括:

- 多目标优化:MOE 能够处理多个目标函数,并在搜索过程中找到多个最优解,这些解可以满足不同的优化目标。

- 决策支持:MOE 可以为决策者提供多个可能的解决方案,这些解决方案可以基于不同的优化目标进行权衡。

- 问题建模:MOE 允许将复杂的问题分解为多个子问题,并为每个子问题设计一个目标函数。这有助于更好地理解和解决复杂问题。

- 适应性搜索:MOE 通常具有自适应机制,可以根据搜索过程和问题的特性调整搜索策略,以提高搜索效率。

- 并行计算:MOE 可以通过并行计算来加速搜索过程,特别是在处理大规模多目标优化问题时。

MOE 的关键组成部分通常包括:

- 目标函数:用于评估候选解的多个函数,每个函数代表一个优化目标。

- 决策变量:候选解的组成部分,它们是算法搜索空间中的参数。

- 选择策略:确定哪些候选解将被用于生成新解的策略。

- 交叉和变异操作:用于生成新解的遗传算子。

- 多目标适应度评估:评估候选解在多个目标函数上的表现,并确定它们在搜索空间中的位置。

MOE 是一种强大的工具,可以用于解决各种多目标优化问题,如工程设计、资源分配、供应链管理、机器学习和数据挖掘等。

34、大模型的涌现能力?

大模型的涌现能力(Emergent Ability)是指大型神经网络模型在训练过程中逐渐表现出的智能行为或能力,这些行为或能力并不是模型设计者显式地编程或指定的,而是随着模型规模的扩大和训练数据的增加而自然涌现出来的。大模型的涌现能力包括很多方面,例如:

- 推理能力:大型神经网络模型能够从数据中学习到规律和模式,并能够进行推理和泛化,从而在新的数据上做出预测或决策。

- 生成能力:大型神经网络模型能够生成新的数据,例如文本、图像、音频等,这些生成的数据与真实数据非常相似,难以区分。

- 适应能力:大型神经网络模型能够适应不同的任务和环境,通过迁移学习、元学习等方式快速适应新的任务或领域。

- 语言能力:大型神经网络模型能够理解和生成自然语言,例如问答、翻译、摘要、对话等,这些能力对于智能助手、智能客服等领域非常重要。

35、缓解大语言模型在推理时重复问题的方法?

大语言模型在推理(inference)过程中可能会出现重复或生成不连贯的文本,这通常是由于模型在处理输入时出现了注意力机制的偏差或者在生成过程中没有有效地利用上下文信息。以下是一些缓解大语言模型在推理时重复问题的方法:

- 改进位置编码:使用旋转位置编码(RoPE)或其他高级位置编码技术,以更好地捕捉序列中的位置信息,减少重复生成。

- 注意力机制优化:调整注意力机制的参数,如注意力头数、注意力窗口大小等,以改善模型在处理长序列时的性能。

- 模型架构调整:增加模型的宽度或深度,或者使用多层注意力机制,以提高模型处理复杂序列的能力。

- 训练数据增强:使用数据增强技术,如噪声注入、词替换等,以提高模型的泛化能力,减少重复生成。

- 使用更复杂的生成策略:引入生成策略,如采样技巧、上下文控制等,以指导模型生成更加多样和连贯的文本。

- 注意力权重可视化:通过可视化注意力权重,可以更好地理解模型在处理输入时的注意力分布,从而发现可能导致重复生成的问题。

- 模型微调:针对特定任务对模型进行微调,以提高模型在该任务上的性能和生成质量。

- 动态调整生成策略:根据生成过程中的上下文信息动态调整生成策略,以减少重复生成。

- 使用外部知识库:结合外部知识库,如常识知识库、领域知识库等,以提高模型生成文本的质量和连贯性。

- 注意力机制改进:设计新的注意力机制,如动态注意力机制、注意力蒸馏等,以提高模型处理长序列的能力。

36、常见的预处理做法?

对于大型语言模型(Large Language Models,LLMs)进行数据预处理是提高模型性能和效率的关键步骤。以下是一些常见的预处理做法:

- 文本清洗

- 去除无关字符:删除文本中的非字母数字字符,如标点符号、特殊符号等。

- 大小写统一:将所有文本转换为小写(或大写),以消除大小写差异带来的影响。

- 去除停用词:删除常见的、对模型训练贡献不大的停用词,如“的”、“和”、“是”等。

- 纠正错误:使用语言工具或规则来纠正文本中的拼写错误。

- 分词

- 词汇分割:将文本分割成单词或词汇单元,这有助于模型更好地理解语言结构。

- 使用词干提取或词形还原:将词汇缩减到基本形式,减少词汇的多样性。

- 标记化

- 单词级标记化:将文本分割成单词级别的标记。

- 子词级标记化:将文本分割成更细粒度的子词单元,这有助于处理大型词汇和稀有词汇。

- 编码

- 整数编码:将每个单词或标记映射到一个唯一的整数ID。

- 嵌入:使用预训练的词嵌入(如Word2Vec、GloVe)将单词转换为密集的向量表示。

- 序列填充

- 填充:为了处理可变长度的输入序列,将序列填充或截断到固定的长度。

- 掩码:使用特殊标记(如"[MASK]")来掩码序列中的特定位置,以便于后续的预测任务。

- 数据增强

- 同义词替换:用同义词替换文本中的单词,增加数据的多样性。

- 回译:将文本翻译成另一种语言,然后再翻译回来,以引入噪声并提高模型的鲁棒性。

- 去重:删除重复文本,去除数据集中重复的或高度相似的文本,以避免模型过拟合。

- 采样和权重调整:类别平衡,对于分类任务,可能需要通过对不同类别的样本进行重采样或调整权重来处理数据不平衡问题。

- 批处理:构建批数据,将预处理后的数据组织成批(minibatches),以便于在训练过程中进行梯度下降。

37、Llama 3 的亮点?

- 首次出现 8B 模型,且 8B 模型与 70B模型全系列使用 GQA (Group Query Attention)。

- 最大模型达到 400B 规模大小,未来几个月内发布!

- 分词器由 SentencePiece 换为了 Tiktoken,与 GPT4 保持一致。

- 相比于 Llama2 的 32000 词表大小,Llama3 的词表大小来到了惊人的 128256。

- 数据方面上,Llama3 使用了约 15T token 用于模型的训练。

- 开源模型大小为 8B 和 70B 两种,每种规模均有开源基座模型和 instruct 模型。

- Llama3 8B Instruct 模型在数学与代码能力方面数倍于 Llama2 7B chat 模型。