【论文速递】ACM2022 - 基于嵌入自适应更新和超类表示的增量小样本语义分割

【论文原文】:Incremental Few-Shot Semantic Segmentation via Embedding Adaptive-Update and Hyper-class Representation

获取地址:https://arxiv.org/pdf/2207.12964.pdf

博主关键词: 小样本学习,语义分割,自适应,超类表示,增量学习

推荐相关论文:

【论文速递】CVPR2022 - 泛化的小样本语义分割

- https://phoenixash.blog.csdn.net/article/details/128675973

摘要:

增量小样本语义分割(IFSS)的目标是逐步扩展模型的能力,以分割只有少量样本监督的新类别图像。然而,在旧类上学习到的特征可能会显著漂移,导致灾难性的遗忘。此外,在新类上进行像素级分割的样本很少,导致每个学习会话中都存在臭名昭著的过拟合问题。在本文中,我们将基于类的知识显式表示为类别嵌入和超类嵌入,其中类别嵌入描述独占语义属性,超类嵌入表示类共享语义属性。针对IFSS问题,从两个方面提出了嵌入自适应更新网络和超类表示网络。 首先,我们提出了一种嵌入自适应更新策略以避免特征漂移,该策略通过超类表示来维护旧知识,并使用类注意方案自适应更新类别嵌入以涉及在单个会话中学习的新类。其次,为了克服训练样本少导致的过拟合问题,通过聚类所有类别嵌入进行初始化,并与新类的类别嵌入对齐进行增强,学习的知识有助于学习新知识,从而减轻性能对训练数据规模的依赖。值得注意的是,这两种设计为具有足够语义和有限偏差的类提供了表示能力,能够执行需要高度语义依赖的分割任务。在PASCAL-5𝑖和COCO数据集上的实验表明,EHNet以显著的优势达到了最新的性能。

**关键词:**增量学习,小样本学习,语义分割,自适应更新,超类表示

简介:

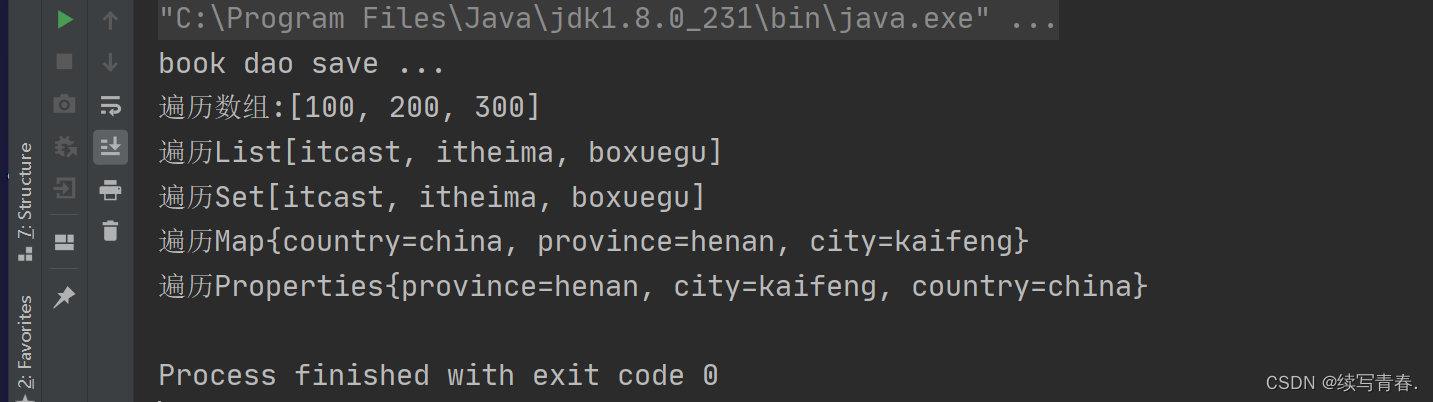

小样本语义分割[21,28,40]解决了用较少样本分割新类别的图像,降低了昂贵的像素级注释的成本。在现实场景中,我们期望训练过的模型在不忘记从旧类中学习到的知识的情况下分割新的类,这对人类来说是一个自然的任务。然而,对新类样本较少的部署模型进行微调,会导致严重的灾难性遗忘问题[31],因为模型在面对新老类表示冲突时,往往会忘记旧类的知识 ,如图1(a)所示。人类和机器学习模型之间的差距启发了研究人员促进增量小样本分割(IFSS),其目的是在只有少量新样本的情况下学习新旧类的分割模型。

IFSS的主要挑战是对已经获得的知识的灾难性遗忘和对新类别的少数样本的过度拟合网络。目前大多数增量方法[7,11,24,49]都是从认知启发的角度使用参数或嵌入向量来表示类别知识,通过新类更新方案的知识表示来解决灾难性遗忘问题。但是,旧类的表示误差会在迭代中不断累积,如图1(b)所示,在每次更新迭代中,旧类的知识学习和表示都是耦合在一起的,这就不可避免地影响了从旧类中学习到的知识的有用性和一致性。

在本文中,我们提出了EHNet,即为IFSS嵌入自适应更新和超类表示网络,以解决灾难性遗忘和过拟合的问题。我们从一个新类的少量样本中学习到两种嵌入向量,即类别嵌入和超类嵌入,前者描述独占的语义属性,后者将超类知识表示为类共享的语义属性。 这种知识表示的一个关键好处是用固定长度语义嵌入的预测取代了新参数训练的要求,从而避免了在学习新类时从头开始训练。

为了减轻灾难性遗忘,我们提出了一 种嵌入自适应更新策略(EAUS) ,如图1©所示,其中类别嵌入使用注意方案进行自适应调整,超类嵌入保持不变。通过这种方式,构建了一个良好分离的类表示,其中旧的知识在内存功能设计中得到了很好的维护,即超类。EAUS将知识学习与表示解耦,通过选择性更新解决特征漂移问题,并通过保留旧知识减轻对新类样本数的要求。类别嵌入更新的核心是类注意方案,它通过对所有类的表示进行上下文化单个类的权重,为每个类计算一个安全的位移向量。这种改进的类注意方案不仅突出了基本类和新类之间的区别表示,从而在所有涉及的类上生成更好的决策边界,而且还指出了在增量学习过程中实现语义偏差较小的良好分离表示的方向。

对语义分割的观察证明了用知识分割不可见的类,其中新发现的样本可能与已学习的类共享“毛发”和“四足动物”等语义属性。因此,超类被表述为包含类似类的语义属性的抽象表示,这能够通过在学习会话期间共享语义知识来减少数据规模依赖和过拟合。超类嵌入通过聚类所有类的类别嵌入进行初始化,并与新类类别嵌入对齐进行增强,如图1(d)所示 。一方面,将聚类算法应用于所有类别嵌入集合,生成原始超类嵌入,从而提取相似的语义表示作为新的超类知识;另一方面,我们将生成的超类嵌入与新类类别嵌入对齐,以增强相关语义信息,消除不相关语义信息。

值得注意的是,EAUS构建了具有很少语义偏差的良好分离表示。同时,超类知识补充和增强了语义信息。 这两种设计为类提供了足够语义且偏差有限的表示,从而能够很好地完成需要高度语义依赖的图像分割任务。

综上所述,本文的贡献有:

- 我们提出了一种嵌入自适应更新策略来避免灾难性遗忘,其中超类嵌入保持固定以维护旧知识,类别嵌入使用类注意方案进行自适应更新,结合在增量会话中学习的新类。

- 为了抵抗训练样本少导致的过拟合,首先通过聚类类别嵌入学习超类,然后与新类类别嵌入对齐进行相关性增强,从而减轻了性能对训练数据规模的依赖。

- 实验结果表明,EHNet达到了最先进的性能,具有显著的优势。

【社区访问】

【论文速递 | 精选】

【论文速递 | 精选】

阅读原文访问社区

阅读原文访问社区

https://bbs.csdn.net/forums/paper

![[TPAMI 2022] 用深度神经网络解决欠定问题——考虑鲁棒性?](https://img-blog.csdnimg.cn/img_convert/be48e4942bf16839fd9d6aff9d225db0.png)