支持向量机(SVM)

支持向量机(SVM)是一种广泛用于分类和回归的强大监督学习算法。在回归任务中,特别是在SVM被用作支持向量回归(SVR)时,目标是找到一个函数,这个函数在给定的数据点上有最小的偏差,同时尽量保持模型的平滑性,即尽量小的模型复杂度。

支持向量回归(SVR)

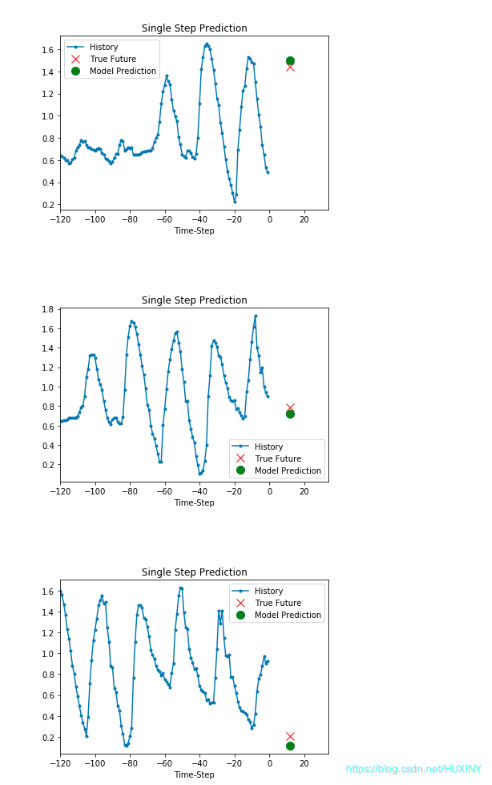

在SVR中,我们不仅要让预测误差尽可能小,还要保证模型不会过于复杂,避免过拟合。这通常通过引入一个损失函数来实现,该损失函数只惩罚超出预设误差容忍阈值(ε)的预测。

RIME优化算法

关于RIME(寒冰)优化算法。

RIME-SVM的结合原理

结合RIME算法和SVM进行回归预测,很可能是使用RIME算法来优化SVM的关键参数,比如:

- 惩罚参数C:控制误差项与保持决策面平滑之间的权衡。

- 核函数参数(如高斯核的γ):决定了数据映射到新空间的分布。

在SVR中,选择合适的参数C和γ对模型的性能有极大的影响。RIME算法可以被用来自动寻找这些参数的最优值,而不是依赖于手工调整或传统的网格搜索方法。

实施步骤可能包括:

- 初始化:随机生成一组SVM参数的初始候选解。

- 迭代优化:

- 使用RIME算法的规则更新参数。

- 每一步评估使用当前参数的SVM模型性能。

- 根据性能反馈调整参数,追求更优解。

- 收敛判定:当达到一定迭代次数或解的改进不再显著时,停止优化。

- 验证:使用最终优化得到的参数,构建SVR模型,并在独立测试集上验证模型性能。

总的来说,RIME-SVM利用RIME算法的全局搜索能力,可以更系统地探索参数空间,有助于找到更合适的SVM参数配置,从而提升模型的预测性能。这种方法尤其适用于参数选择对结果影响较大且参数空间较大的情形。

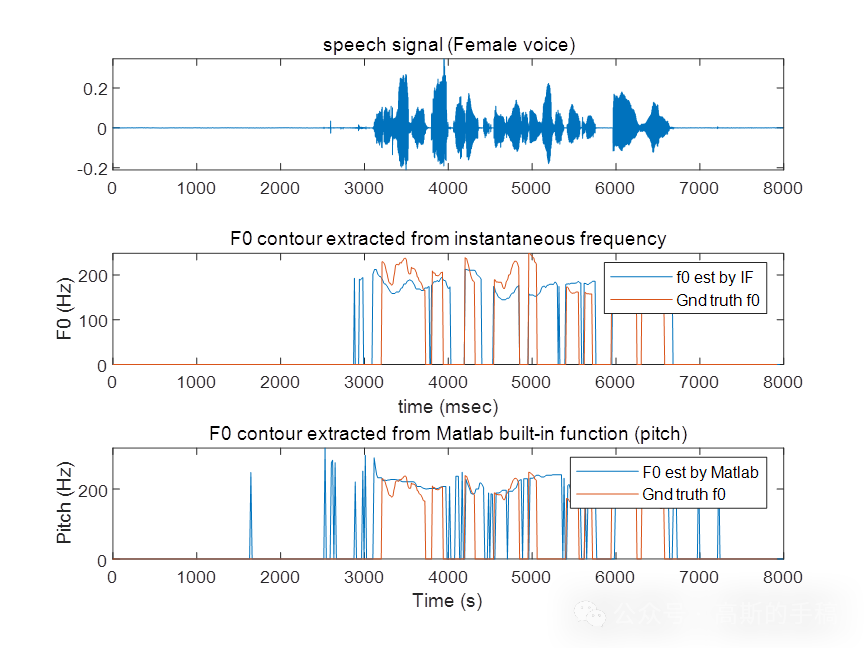

结果

获取方式

https://mbd.pub/o/bread/mbd-ZZ6Ul5dq