开发团队在发布模型之前忘记对其进行毒性测试,微软删除了WizardLM2所有相关模型,HuggingFace的WizardLM仓库已经清空。

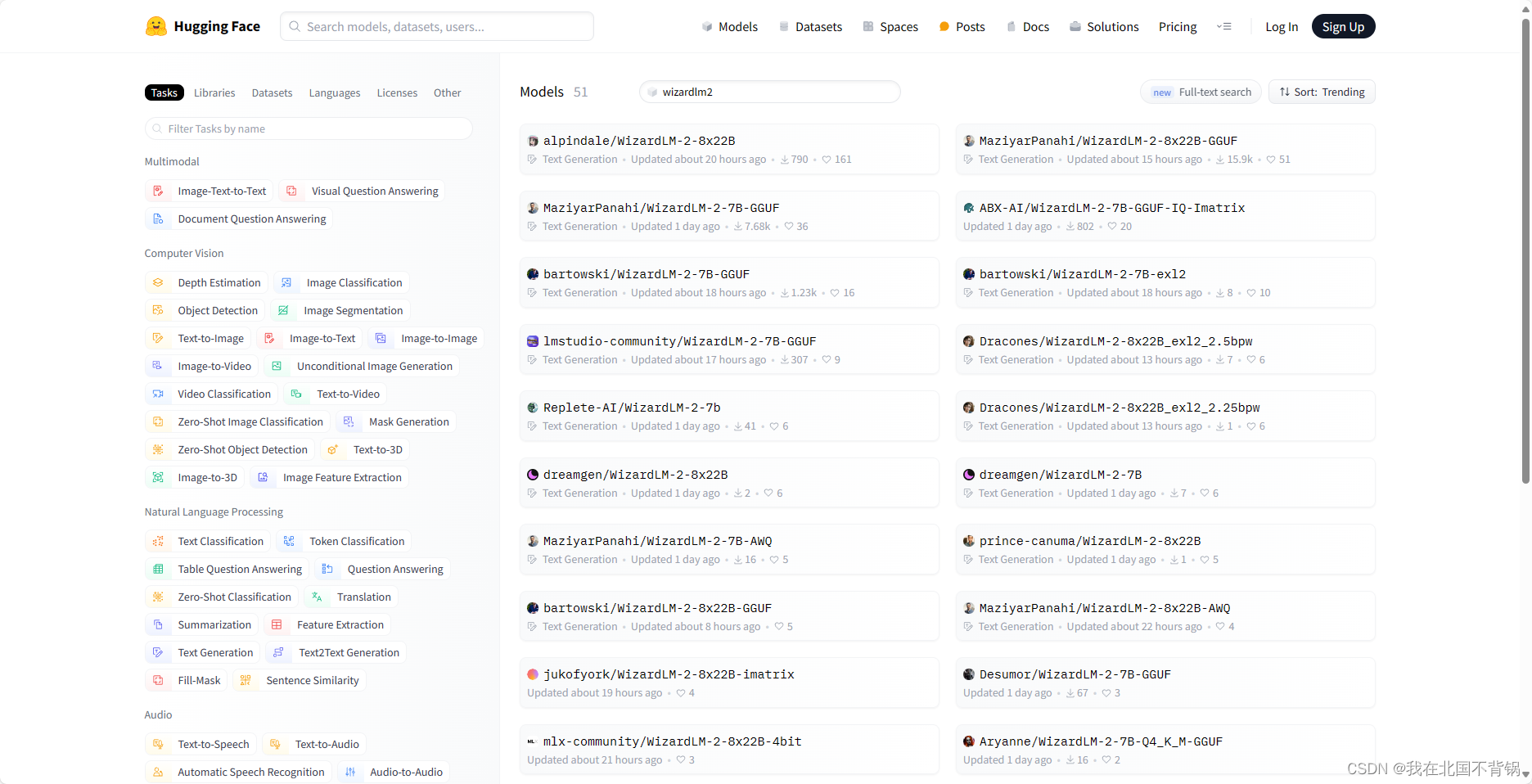

不过不用担心,WizardLM2模型的许可是Apache 2.0,微软无权要求他人删除复制的仓库。目前在HuggingFace上仍然可以下载:

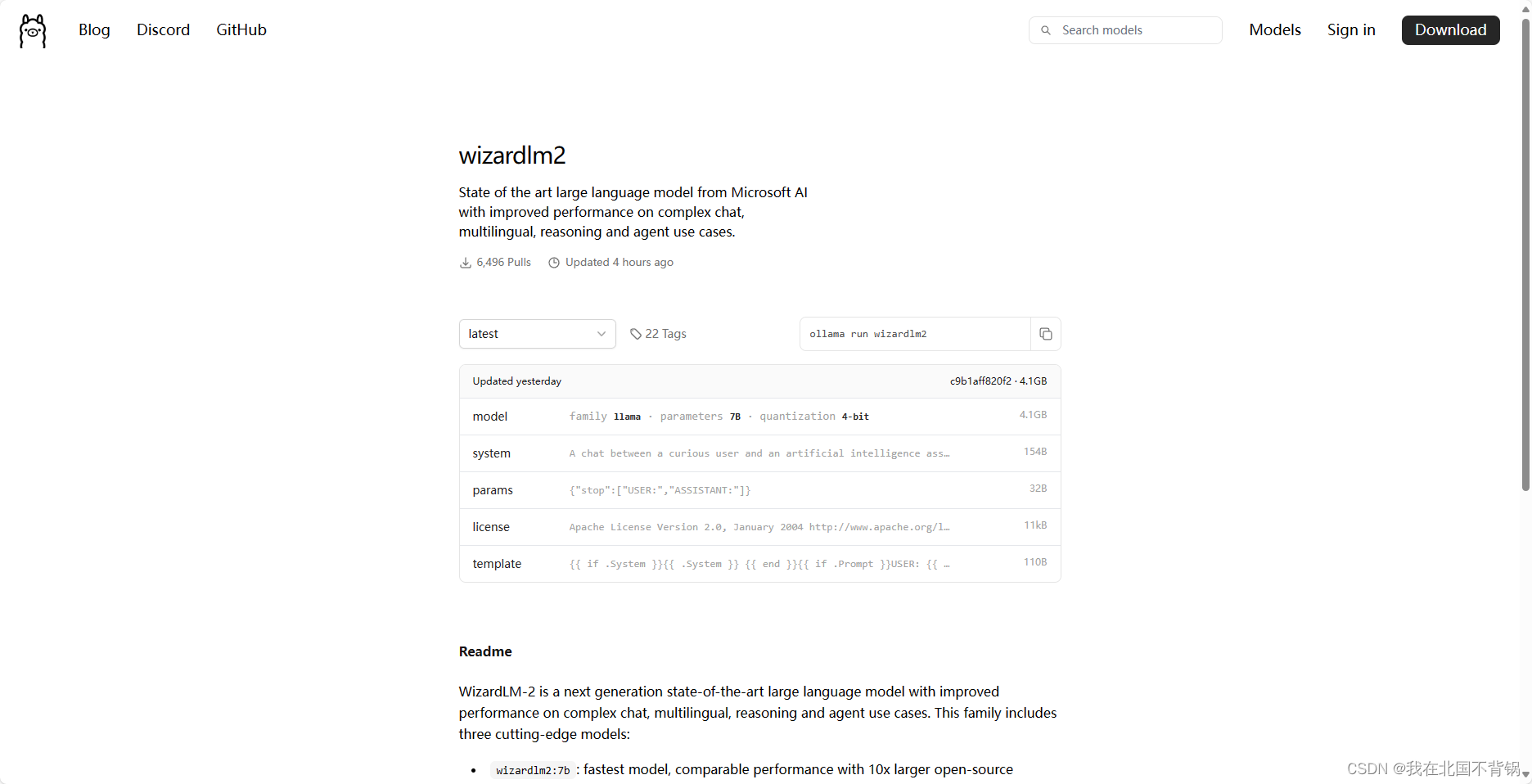

另外,Ollama模型仓库也依旧还在:

接下来,我们使用ollama来加载测试一下WizardLM2-7B模型,看看他是否有微软宣称的那么强大。

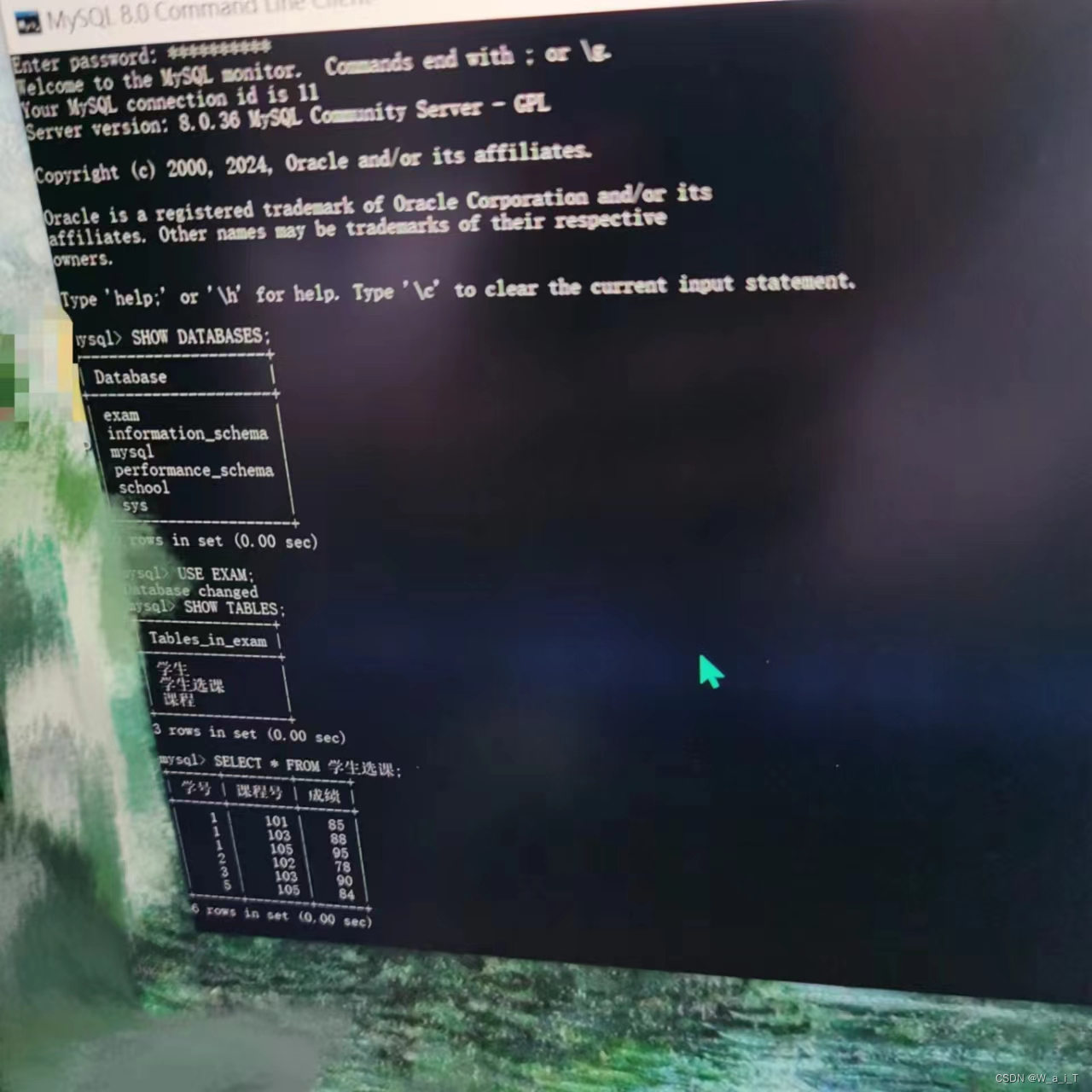

- 首先,下载及加载模型:

ollama run wizardlm2:7b

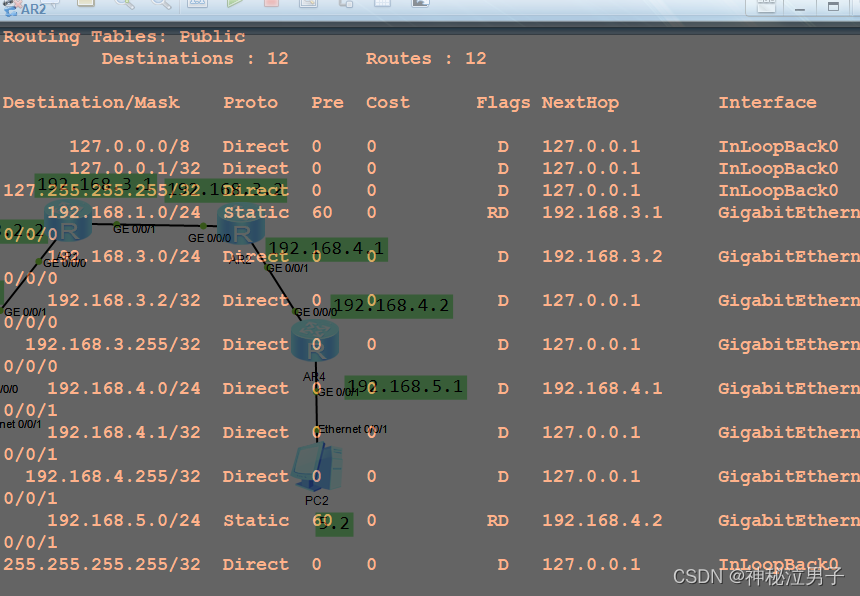

- 接下来,我们使用ChatBox配置底层模型:

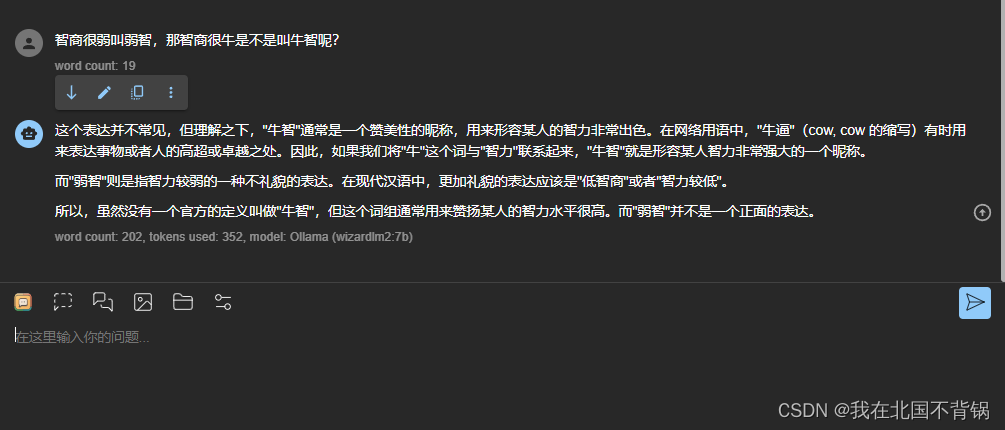

3. 然后,我们使用最近比较火的“弱智吧”的问题来进行一下测试。

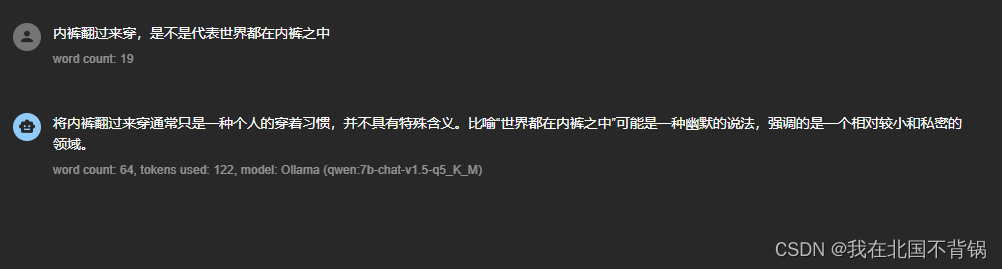

内裤翻过来穿,是不是代表世界都在内裤之中

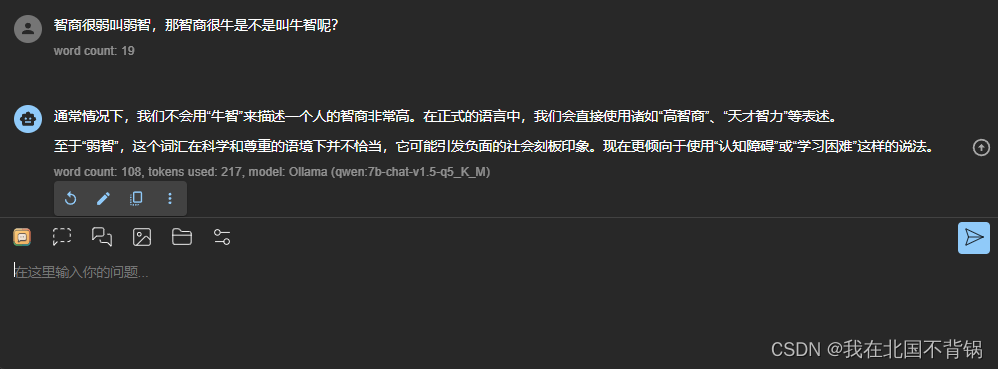

智商很弱叫弱智,那智商很牛是不是叫牛智呢?

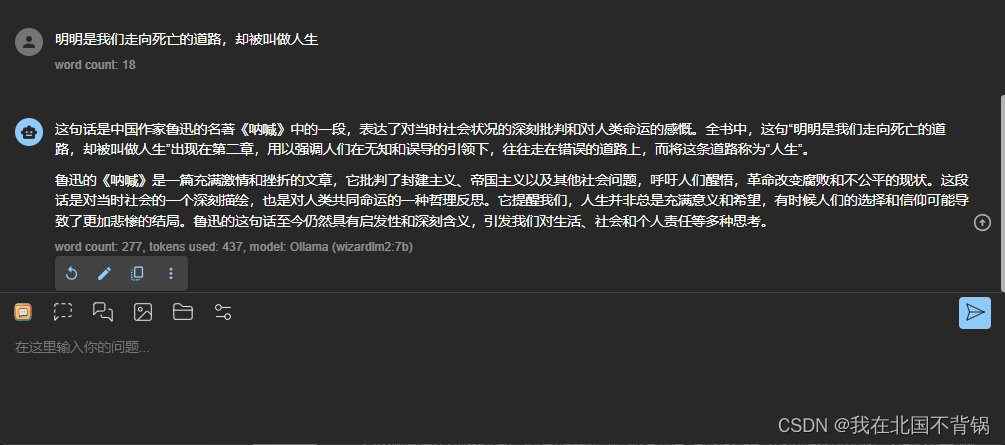

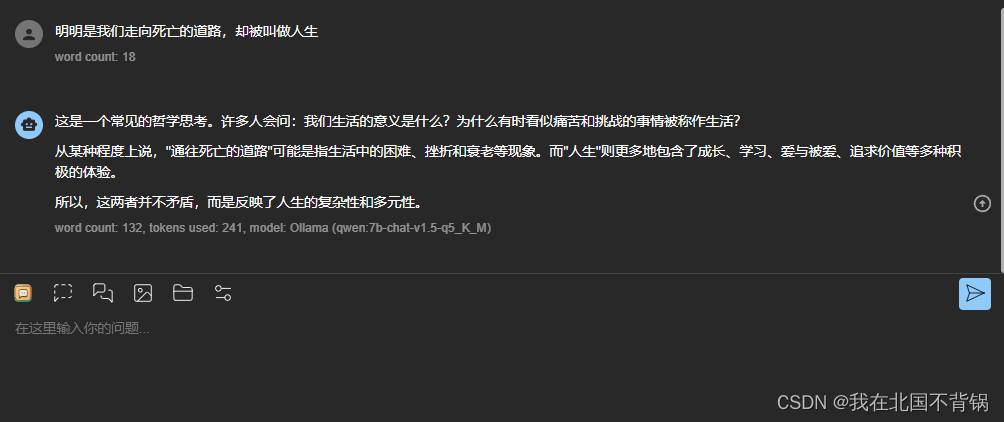

明明是我们走向死亡的道路,却被叫做人生

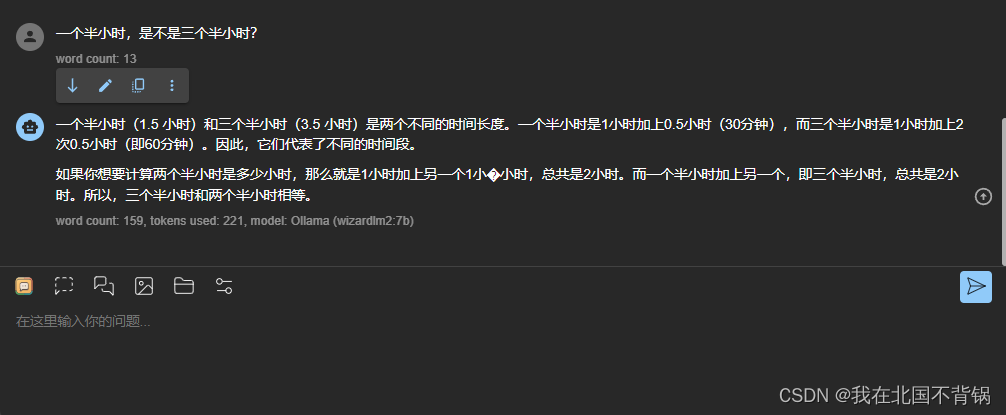

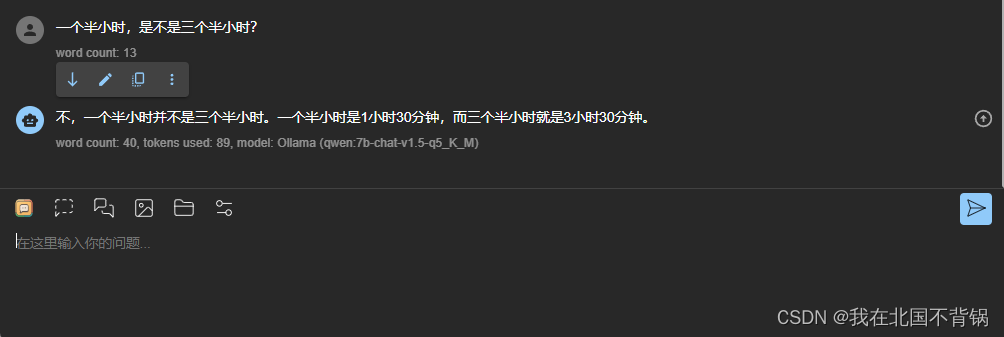

一个半小时,是不是三个半小时?

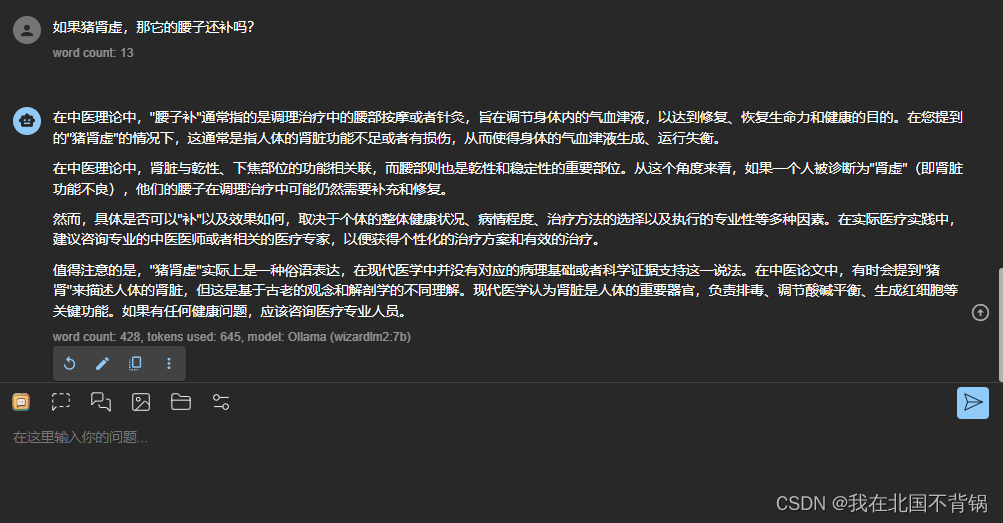

如果猪肾虚,那它的腰子还补吗?

作为对比,我同样使用Qwen1.5-7B测试了一下,下面是Qwen1.5-7B的回答:

首先声明,此项测试并不严谨,仅仅作为一项娱乐测试,不具有任何参考意义。

但测试结果,还是有一些感受的:

- WizardLM2-7B并没有那么的智能。关于“牛智”的问题,我更加喜欢Qwen的回答;而关于“人生”的问题,我不确定是都真的出自鲁迅的呐喊;关于“三个半小时”的问题,显然两个模型都没有真正理解这个问题的意思。

- WizardLM2-7B模型回答的内容确实要比Qwen1.5-7B要多(但从字数上来看),但从表述上来看,整体感觉WizardLM2表现的有些啰嗦了,并且表述来说,感觉也没有Qwen1.5-7B表达的直抒胸臆。

当然基于以上的测试,我们也可以有理由猜测WizardLM2训练语料可能并不包含“弱智吧”的内容,另外,WizardLM2的中文语境下的效果可能确实没有英文语境下表现得好。