目录

前言

一、注意力机制简介

二、注意力机制的工作原理

三、注意力机制的变体

1、自注意力(Self-Attention)

2、双向注意力(Bidirectional Attention)

3、多头注意力(Multi-Head Attention)

4、无限注意力机制(Infini-attention)

四、注意力机制在自然语言理解中的应用

五、未来展望

总结

前言

在人工智能的辉煌剧场中,AI大模型扮演了主角的角色,而注意力机制(Attention Mechanism)则犹如这位主角的明亮双眸,为其赋予了前所未有的洞察力。特别是在自然语言理解(NLU)的领域,注意力机制已经成为推动技术革命的重要引擎。本文旨在深入浅出地探讨注意力机制的核心原理、不同变体,以及它在提升AI大模型自然语言理解能力中的至关重要性。

一、注意力机制简介

想象一下,当您沉浸在一本引人入胜的小说中时,您的眼球会自然而然地聚焦在关键的情节上,而忽略掉其他无关紧要的文字。这正是注意力机制在AI大模型中的运作方式:它允许模型在处理信息洪流时,智能地筛选并专注于那些对当前任务最为关键的部分。这种仿生学的设计使得模型在处理长距离依赖和复杂上下文关系时显得游刃有余。

二、注意力机制的工作原理

要深刻理解注意力机制,我们不妨将其视为一位指挥家,它通过为输入数据的每一个组成部分打分,来决定哪些信息值得“奏响”,哪些应该“减弱”。这一过程包括以下几个步骤:

1)计算注意力分数:模型通过评分函数评估输入序列中每个元素的重要性。

2) 软选择:使用softmax函数对这些分数进行归一化处理,得到每个元素的注意力权重。

3)加权求和:根据这些权重,模型对输入数据进行加权求和,从而生成一个富含关键信息的输出表示。

三、注意力机制的变体

随着深度学习技术的不断进步,注意力机制也演化出了多种形态,以适应不同的应用场景和需求。以下是一些常见的注意力机制变体

1、自注意力(Self-Attention)

自注意力机制是一种让输入序列自己决定哪些部分值得关注的机制。它不依赖于任何外部信息,而是通过计算输入序列中各个元素之间的相似性,为每个元素分配一个权重,从而确定哪些部分对于当前任务更为重要。这种机制在自然语言处理、图像识别等领域取得了显著的成功。

2、双向注意力(Bidirectional Attention)

双向注意力机制结合了正向和反向的上下文信息,捕获更全面的语义依赖关系。与单向注意力机制相比,双向注意力能够更好地捕捉长距离依赖关系,从而提高模型的性能。这种机制在自然语言处理、语音识别等领域得到了广泛的应用。

3、多头注意力(Multi-Head Attention)

多头注意力机制类似于多镜头拍摄,通过并行处理不同的信息片段,然后将这些多角度的视野汇聚成一个全面的理解。具体来说,它将输入序列分成多个子空间,然后在每个子空间中独立地进行自注意力计算。最后,将所有子空间的注意力输出进行拼接或加权求和,得到最终的注意力表示。这种机制可以提高模型的表达能力,使其能够捕捉到不同层次的信息。

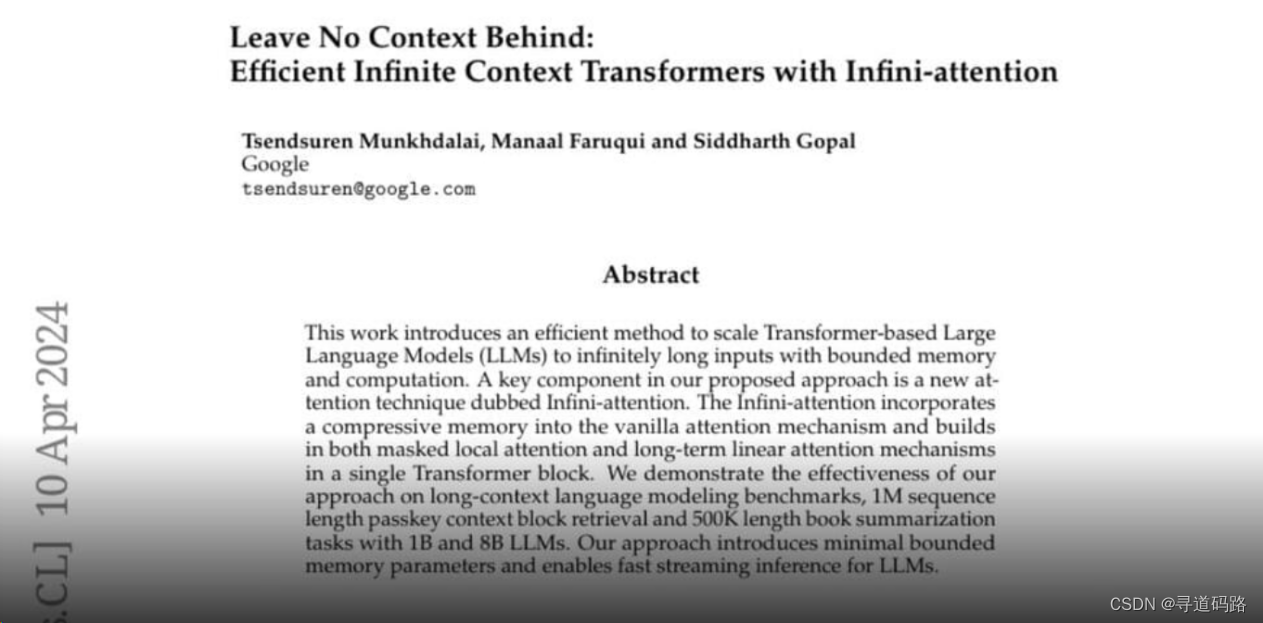

4、无限注意力机制(Infini-attention)

谷歌最近提出了一种称为的“无限注意力”的新机制。

这个被称为Infini-attention的新机制,使得基于Transformer架构的大型模型能够在有限的计算资源下处理非常长的输入序列。具体来说,这项技术能够显著扩展模型处理上下文的长度,例如将1B参数模型的上下文长度扩展到1M tokens(大约相当于10部小说的长度),并在Passkey检索任务中取得成功。同时,在包含500K tokens上下文长度的书籍摘要任务中,该技术帮助8B参数模型达到了最新的最优结果。

Infini-attention机制的一个重要特点是其在内存使用上的高效性,它实现了在内存大小上达到114倍的压缩比,这对于长文本处理来说是一个突破性的进展。这种技术的出现对于需要处理大量文本数据的应用场景,如机器翻译、文档摘要和复杂问答系统等,都具有重要的意义。

谷歌的这一创新为自然语言处理领域带来了新的可能性,特别是在处理长序列数据时,它可能会成为未来模型设计的一个关键方向。

四、注意力机制在自然语言理解中的应用

在自然语言理解任务中,注意力机制的重要性不言而喻。它使得AI大模型能够精准地把握语言的细微差别,理解复杂的语境和隐喻。例如:

1)文本摘要:通过识别并提取文章的核心观点,自注意力机制能够生成凝练的摘要信息。

2)问答系统:自注意力机制使模型能够深入分析问题与答案之间的关联性,提供更准确的答案。

3)情感分析:模型利用自注意力集中在情感关键词汇上,以准确判断文本的情感倾向。

4)阅读理解:自注意力机制帮助模型在长篇材料中找到解答问题所需的关键信息段落

五、未来展望

尽管注意力机制已经在自然语言理解等领域取得了显著的成就,但它的发展之路仍远未结束。未来的研究将继续探索如何更有效地整合注意力机制与其他先进技术,如何优化其结构以处理更大规模的数据,以及如何提高其在多样化任务中的普适性和鲁棒性。我们期待着注意力机制能够带领AI大模型迈向更加智能和高效的未来。

总结

注意力机制的诞生为AI大模型特别是自然语言理解领域带来了革命性的变革。它不仅赋予了模型深度洞察的能力,也为我们在处理复杂认知任务时提供了强大的工具。通过不断的研究和创新,我们有理由相信,注意力机制将继续在AI的道路上照亮前行的方向,引领我们进入一个更加智能的时代。

文章若有瑕疵,恳请不吝赐教;若有所触动或助益,敬请关注并给予支持。