- 文献阅读:LESS: Selecting Influential Data for Targeted Instruction Tuning

- 1. 文章简介

- 2. 方法介绍

- 1. Overview

- 2. 原理说明

- 1. SGD上的定义

- 2. Adam上的定义

- 3. 具体实现

- 1. Overview

- 1. LoRA使用

- 2. 数据选择

- 3. LESS-T

- 3. 实验考察 & 结论

- 1. 实验设计

- 2. 主要结果

- 3. 细节讨论

- 1. 计算复杂度分析

- 2. warmup是否必要

- 3. checkpoint的影响(N的影响)

- 4. LoRA Dimension的影响

- 4. 总结 & 思考

- 文献链接:https://arxiv.org/abs/2402.04333

- Github链接:https://github.com/princeton-nlp/LESS

1. 文章简介

这篇文章是陈丹琦大佬在今天二月给出的关于LLM Tuning的一篇新作。

这篇文章同样是一篇比较fundamental的基础研究工作,考察的是LLM训练,或者说任意模型训练时如何最优化的选择训练数据,从而在尽可能不损失模型性能的情况下,最优化模型训练的效率,使得模型收敛的又快又好。

相似的工作之前有主动学习相关的一系列工作,这里倒是有些区别,因为主动学习感觉还是对于未标注数据进行最优化的选取,但是这里的LESS方法感觉还是在已有的标注数据当中选取一个子集,使得模型获得足量且优秀的训练结果。

下面,我们就来看看文中给出的具体实现方法和对应的实验考察。

2. 方法介绍

1. Overview

首先,我们来看一下LESS的整体的原理说明和实现。

LESS的全程的话是Low-rank gradiEnt Similarity Search,其整体的思路的话其实还是比较直接的,就是通过数据在模型进行反向传播时产生的梯度大小来判断数据对于模型训练的影响程度,然后选择最有影响的这部分数据来进行模型finetune即可。

但是,这里会涉及到几个问题:

- 具体定义上的问题,即如何判断数据对于模型训练的影响程度大小;

- 对每一个数据都进行反向传播进行判断的话,基本也就等于跑完一个epoch了,这种效率的话就有点舍本逐末了,因此,需要考察一下如何对效率进行优化。

下面,我们就来看一下文中对于这两个问题的处理。

2. 原理说明

首先,我们来看一下文中是如何来定义一条数据对于模型训练影响的大小的。

1. SGD上的定义

首先,文中在SGD上面进行了一下简单的考察,显然,对于一步训练前后,我们可以将其在测试集上的变化一阶泰勒展开得到:

l ( z ′ ; θ t + 1 ) = l ( z ′ ; θ t ) + ⟨ ∇ l ( z ′ ; θ t ) , θ t + 1 − θ t ⟩ l(z'; \theta^{t+1}) = l(z'; \theta^{t}) + \langle \nabla l(z'; \theta^{t}), \theta^{t+1} - \theta^{t} \rangle l(z′;θt+1)=l(z′;θt)+⟨∇l(z′;θt),θt+1−θt⟩

其中,参数的改变量则有可以通过训练过程中的一轮参数迭代过程来表达,即:

θ t + 1 − θ t = − η t ∇ l ( z ; θ t ) \theta^{t+1} - \theta^{t} = -\eta_t \nabla l(z; \theta^t) θt+1−θt=−ηt∇l(z;θt)

此时,我们即可得到测试集上一轮迭代测试集上loss的变化大小可以写为:

l ( z ′ ; θ t + 1 ) − l ( z ′ ; θ t ) = − η t ⋅ ⟨ ∇ l ( z ′ ; θ t ) , ∇ l ( z ; θ t ) ⟩ l(z'; \theta^{t+1}) - l(z'; \theta^{t}) = -\eta_t \cdot \langle \nabla l(z'; \theta^{t}), \nabla l(z; \theta^t) \rangle l(z′;θt+1)−l(z′;θt)=−ηt⋅⟨∇l(z′;θt),∇l(z;θt)⟩

因此,我们就可以定义某一条训练数据对于某一条测试数据在N轮训练当中的影响程度如下:

I n f S G D ( z , z ′ ) = ∑ t = 0 N − 1 l ( z ′ ; θ t ) − l ( z ′ ; θ t + 1 ) = ∑ t = 0 N − 1 η t ⋅ ⟨ ∇ l ( z ′ ; θ t ) , ∇ l ( z ; θ t ) ⟩ \begin{aligned} \mathop{Inf}_{SGD} (z, z') &= \sum\limits_{t=0}^{N-1} l(z'; \theta^{t}) - l(z'; \theta^{t+1}) \\ &= \sum\limits_{t=0}^{N-1} \eta_t \cdot \langle \nabla l(z'; \theta^{t}), \nabla l(z; \theta^t) \rangle \end{aligned} InfSGD(z,z′)=t=0∑N−1l(z′;θt)−l(z′;θt+1)=t=0∑N−1ηt⋅⟨∇l(z′;θt),∇l(z;θt)⟩

2. Adam上的定义

但是,在我们当前的训练过程中,我们更常使用的优化器并不是SGD而是Adam,因此,文中对Adam优化器的情况进行了一下调整。

文中首先回顾了一下Adam优化器的计算:

θ t + 1 − θ t = − η t Γ ( z ; θ t ) Γ ( z ; θ t ) = m t + 1 v t + 1 + ϵ m t + 1 = β 1 m t + ( 1 − β 1 ) ∇ l ( z ; θ t ) 1 − β 1 t v t + 1 = β 2 v t + ( 1 − β 2 ) ∇ l ( z ; θ t ) 2 1 − β 2 t \theta^{t+1} - \theta^{t} = -\eta_t \Gamma (z; \theta^t) \\ \Gamma (z; \theta^t) = \frac{m^{t+1}}{\sqrt{v^{t+1} + \epsilon}} \\ m^{t+1} = \frac{\beta_1 m^t + (1-\beta_1) \nabla l(z; \theta^t)}{1-\beta_{1}^{t}} \\ v^{t+1} = \frac{\beta_2 v^t + (1-\beta_2) \nabla l(z; \theta^t)^2}{1-\beta_{2}^{t}} θt+1−θt=−ηtΓ(z;θt)Γ(z;θt)=vt+1+ϵmt+1mt+1=1−β1tβ1mt+(1−β1)∇l(z;θt)vt+1=1−β2tβ2vt+(1−β2)∇l(z;θt)2

因此,我们可以很直接地将influence的定义迁移至Adam优化器上,得到:

I n f A d a m ( z , z ′ ) = ∑ t = 0 N − 1 l ( z ′ ; θ t ) − l ( z ′ ; θ t + 1 ) = ∑ t = 0 N − 1 η t ⋅ ⟨ ∇ l ( z ′ ; θ t ) , Γ ( z ; θ t ) ⟩ \mathop{Inf}_{Adam} (z, z') = \sum\limits_{t=0}^{N-1} l(z'; \theta^{t}) - l(z'; \theta^{t+1}) = \sum\limits_{t=0}^{N-1} \eta_t \cdot \langle \nabla l(z'; \theta^{t}), \Gamma (z; \theta^t) \rangle InfAdam(z,z′)=t=0∑N−1l(z′;θt)−l(z′;θt+1)=t=0∑N−1ηt⋅⟨∇l(z′;θt),Γ(z;θt)⟩

不过实际发现模型的参数梯度与文本长度强相关:

这就导致直接迁移上述定义公式会使得数据选择明显趋于短文本,因此文中对其进行了一下修正,将其加入了一下归一化因子,最终得到定义式如下:

I n f A d a m ( z , z ′ ) = ∑ t = 0 N − 1 η t ⋅ ⟨ ∇ l ( z ′ ; θ t ) , Γ ( z ; θ t ) ⟩ ∥ ∇ l ( z ′ ; θ t ) ∥ ⋅ ∥ Γ ( z ; θ t ) ∥ \mathop{Inf}_{Adam} (z, z') = \sum\limits_{t=0}^{N-1} \eta_t \cdot \frac{\langle \nabla l(z'; \theta^{t}), \Gamma (z; \theta^t) \rangle}{\lVert \nabla l(z'; \theta^{t}) \rVert \cdot \lVert \Gamma (z; \theta^t) \rVert} InfAdam(z,z′)=t=0∑N−1ηt⋅∥∇l(z′;θt)∥⋅∥Γ(z;θt)∥⟨∇l(z′;θt),Γ(z;θt)⟩

3. 具体实现

1. Overview

有了上述影响程度的定义之后,文中就可以根据上述influence的大小进行数据选择策略了,具体来说的话,就是:

- 在训练集上进行少量的tuning作为warmup,然后在验证集上计算所有训练数据当中的influence,最后挑选出影响因子最大的数据进行模型训练。

但是,如果直接使用LLM进行warmup然后进行上述定义下的influence计算时,可以想见其计算量必然极其巨大,和我们最终优化训练效率的目的显然是南辕北辙的,因此,我们必须要优化一下这里的计算效率,具体来说的话,文中就是通过引入LoRA的方法减少总的参数量,然后进行数据的选择。

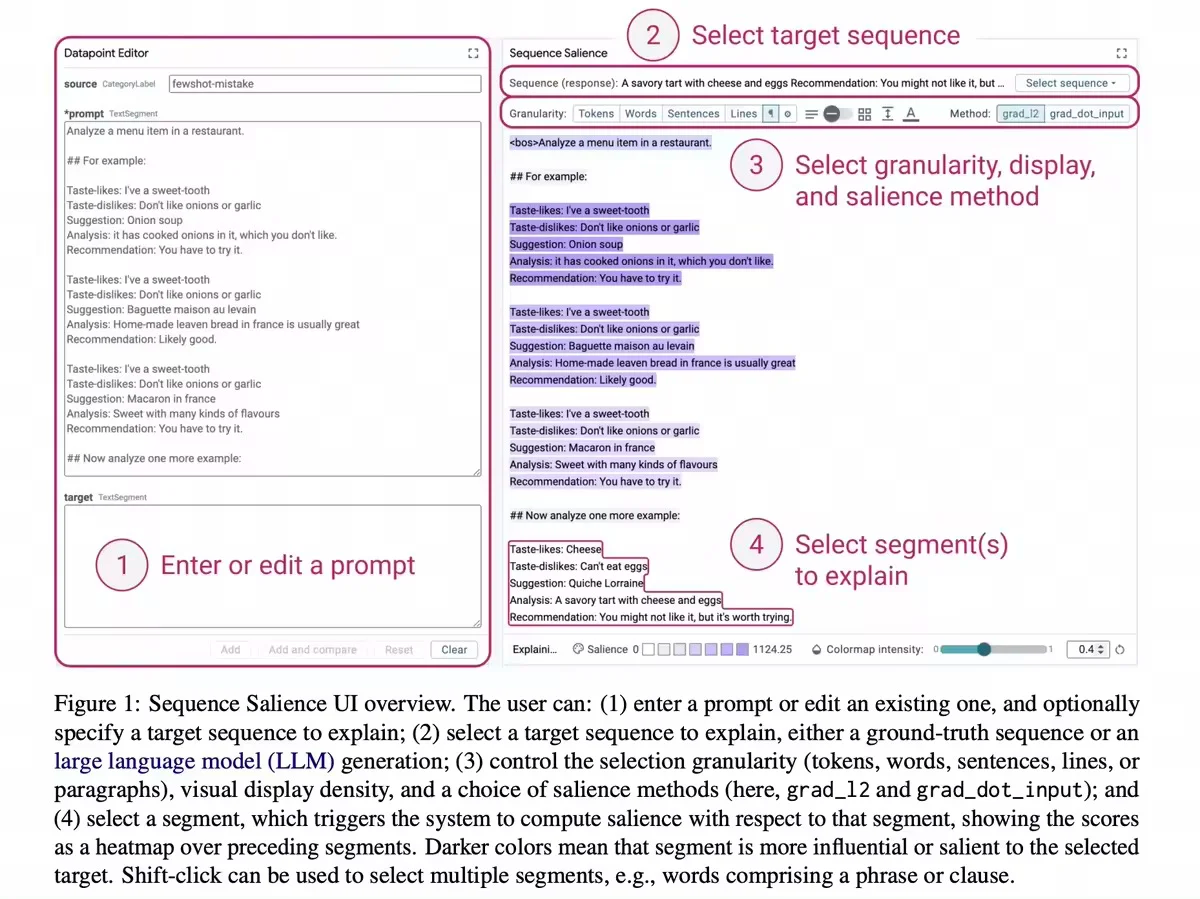

因此,总的pipeline示意图如下:

下面,我们就来看看LoRA训练和数据选择的具体细节。

1. LoRA使用

首先的话,文中使用了LoRA来进行模型的finetune,这是因为模型本身的参数量太大了,常规的像是Llama这些都至少有着6B左右的参数量,更别说那些更大的模型了,使用全部参数finetune然后反向推导influence显然成本太大了,典型的舍本逐末,因此,这里使用LoRA进行模型的finetune,可以大幅减少模型的计算量。

2. 数据选择

然后,关于数据选择的部分,文中就是使用上述原理说明部分的内容进行数据选择,具体来说的话就是先使用少量训练数据进行一下warmup,然后使用少部分测试集来计算每一条数据对于模型的影响大小,然后选择出影响最大的几条数据即可。

对应的公式如下:

I n f A d a m ( z , D v a l ) = ∑ t = 0 N − 1 η t ⋅ ⟨ ∇ l ( D v a l ; θ t ) , Γ ( z ; θ t ) ⟩ ∥ ∇ l ( D v a l ; θ t ) ∥ ⋅ ∥ Γ ( z ; θ t ) ∥ \mathop{Inf}_{Adam} (z, D_{val}) = \sum\limits_{t=0}^{N-1} \eta_t \cdot \frac{\langle \nabla l(D_{val}; \theta^{t}), \Gamma (z; \theta^t) \rangle}{\lVert \nabla l(D_{val}; \theta^{t}) \rVert \cdot \lVert \Gamma (z; \theta^t) \rVert} InfAdam(z,Dval)=t=0∑N−1ηt⋅∥∇l(Dval;θt)∥⋅∥Γ(z;θt)∥⟨∇l(Dval;θt),Γ(z;θt)⟩

3. LESS-T

在上述基础上,文中进一步提出,这里的模型可以具有泛化性,也就是说,使用基于模型A选择出来的数据集 D D D同样有利于另一个模型 B B B的训练。

因此,文中给出了一个LESS-T的数据选择方法,固定使用Llama2 7B模型来进行数据选择,然后在其他模型上进行finetune。

3. 实验考察 & 结论

下面,我们来看一下文中给出的具体实验考察以及对应的结果如下。

1. 实验设计

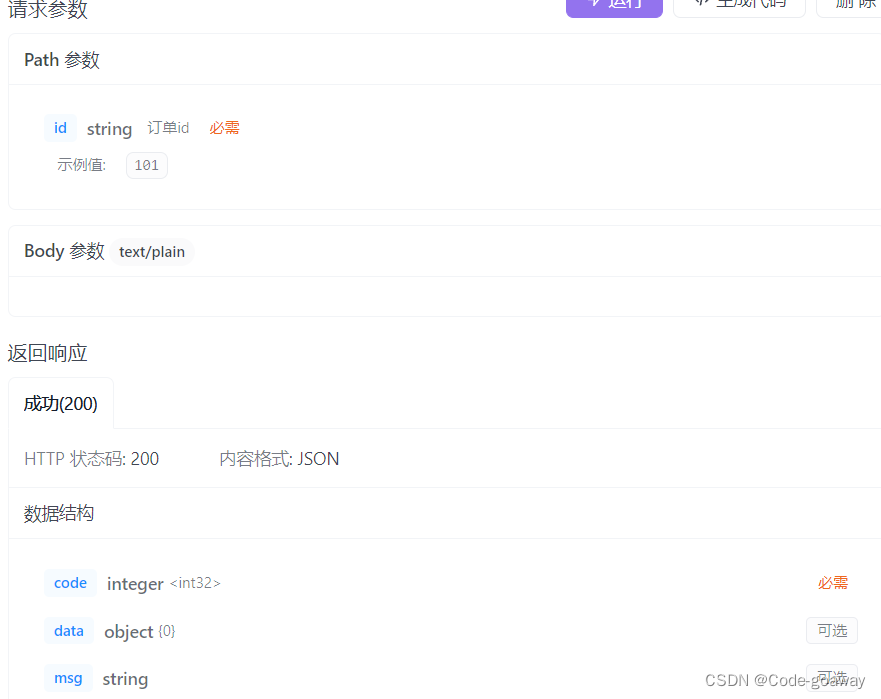

首先,关于文中的实验设计的话,文中主要是使用MMLU, TYDIQA, BBH三个数据集的测试集,其具体信息如下:

而实验模型的话主要是Llama2 7B, 13B以及Mistral 7B三个模型,数据选择比例的话则是以5%作为标准。

然后,作为对照组的话,主要是以下几种方法:

- 随机选择

- BM25

- DSIR

- RDS

其中,BM25和DSIR都是基于词频的选择方法,RDS全称为Representationbased

Data Selection,这部分我倒是完全不知道,有兴趣的读者可以去追一下这个文献看看这具体是个啥。

2. 主要结果

下面,我们来看一下文中给出的具体实验结果。

最直接的一个实验结果显然就是在几个数据集下LESS选择的5%的数据和全量数据训练以及随机选择5%数据的效果差异:

然后,在Llama2 7B模型上,文中进一步考察了不同的数据选择策略下模型finetune效果的差异:

基于上述两张表格,文中总结了以下几个主要的实验结论:

- 从表2可以看到,LESS在不同模型上都有效,方法具有稳定性

- 同样从表2可以看到,使用LESS方法有时选择5%的优质数据的训练效果甚至可以超过全量数据finetune的效果;

- 同样从表2可以看到,LESS-T方法在Llama2 13B和Mistral 7B模型上同样有效,说明了LESS数据选择对于模型的泛化性

- 从表3可以看到,相较于其他对照组中的方法,LESS 是唯一一个在各个任务下均有效的数据选择策略。

3. 细节讨论

此外,文中还更进一步地做了一些关于LESS的细节讨论。

1. 计算复杂度分析

首先,文中分析了一下LESS方法的整体复杂度,得到结果如下:

可以看到,LESS的计算量其实还是非常大的。

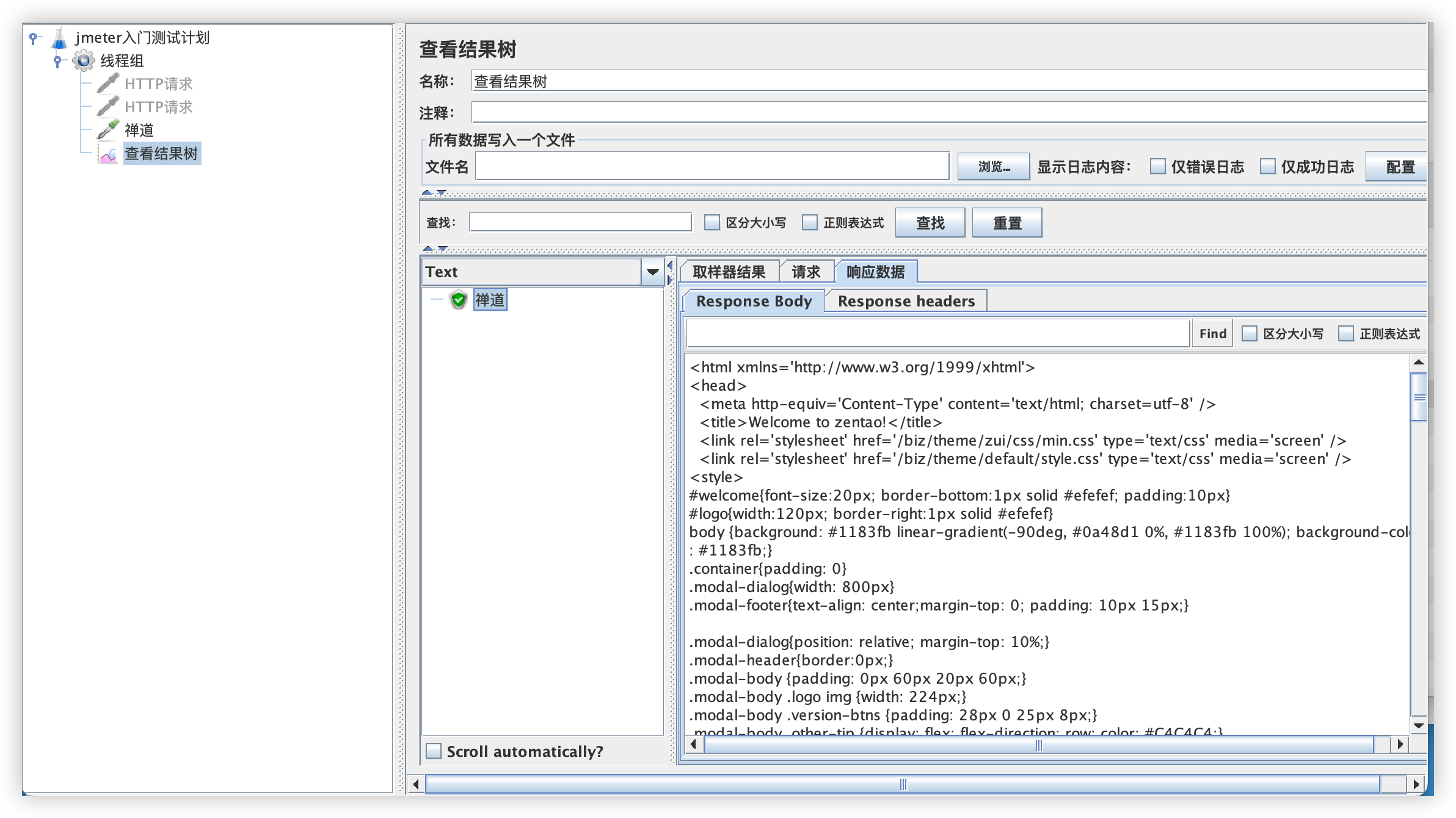

2. warmup是否必要

然后,文中考察了一下对LoRA的warmup是否必要,得到结果如下:

可以看到,warmup还是非常必要的。

3. checkpoint的影响(N的影响)

此外,关于文中使用多个checkpoint进行梯度的avg这一点,文中同样说明了一下这个操作的必要性:

4. LoRA Dimension的影响

最后,文中还考察了一下LoRA模型当中维度对于数据选择的影响:

可以看到,确实维度越大数据选择效果越好,但是小维度的下已经足以选择出很好的数据带来明显的效果提升了。

4. 总结 & 思考

综上就是陈丹琦大佬提出的LESS方法了,可以看到,在数据选择方面LESS确实给出了非常强大的效果,可以在5%左右的数据上就获得非常优秀的效果,而且数据的选择对模型还有任务都有着足够的泛化性。

但是比较困惑我的一点在于LESS的数据选择计算开销实在是非常大,而且是对于已有的训练数据进行二次提纯选择,而现实中我们的问题其实个人感觉还是更多的像是主动学习那样缺少训练数据因此要对未标注数据进行选择标注,这个问题LESS似乎是无法处理的,当然LESS也不是研究的这个问题就是了。

因此个人感觉LESS的定位就多少有些尴尬了,已有足量训练数据的情况下如此大开销地精炼数据是否真的有足够的价值,多少还是有些怀疑。

不过考虑到之前像是Meta在LIMA这篇工作中提到的那样:只需要少量的优质数据,模型就足以finetune获得非常优秀的效果了。

因此,数据质量的价值可能远高于单纯的数据量的价值,数据精炼的意义可能真的会比想象的更大吧,谁知道呢。