卷积神经网络:深度学习的视觉之眼

在过去的十年中,深度学习已经彻底改变了我们处理和理解图像、视频及其他视觉媒体的方式。其中,卷积神经网络(CNN)无疑是这一革命的核心。本文将带您深入了解CNN的基础知识、关键发展,以及它们如何塑造现代计算机视觉的领域。

简介

深度学习是机器学习的一个分支,它通过学习数据的多层次表示来实现复杂任务的自动化,其中“深度”指的是模型中层的数量。计算机视觉,作为人工智能的一个重要领域,旨在使计算机能够从图像或视频中“看”和“理解”世界。

卷积神经网络的概念源于对生物视觉感知机制的研究。它们通过模仿生物神经网络的结构,特别是视觉皮层中的局部感知机制,以及层与层之间的连接方式,来实现对视觉数据的高效处理。

卷积神经网络的基本组成

-

卷积层

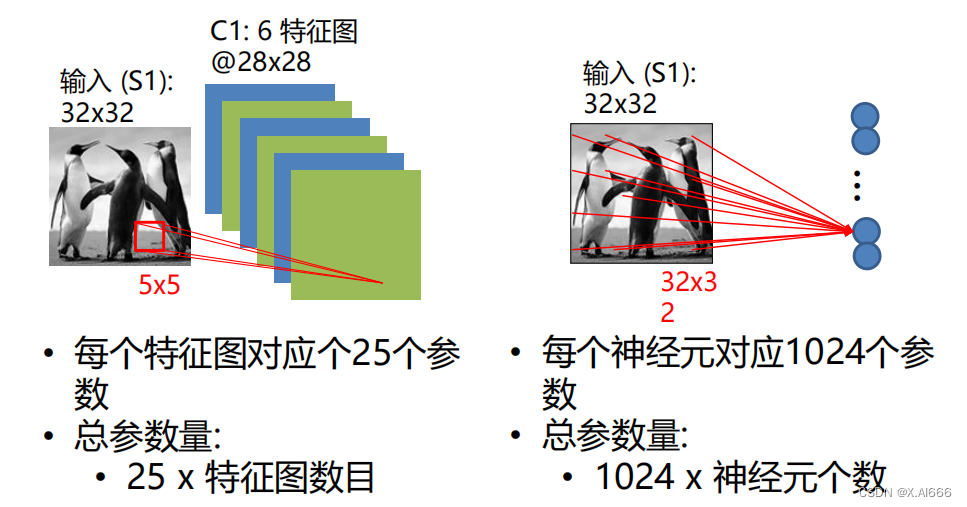

卷积层是卷积神经网络的核心,它通过卷积运算提取输入图像的特征。在卷积运算中,卷积核(或过滤器)在输入图像上滑动,并在每个位置计算卷积核与其覆盖的图像区域的点积。这个过程可以捕捉到图像中的局部特征,如边缘、角点或纹理等。

-

卷积层的一个重要特性是参数共享,即同一个卷积核的权重在整个输入图像上共享。这不仅减少了模型的参数量,也使得卷积神经网络能够对输入图像的平移具有一定的不变性。

-

池化层

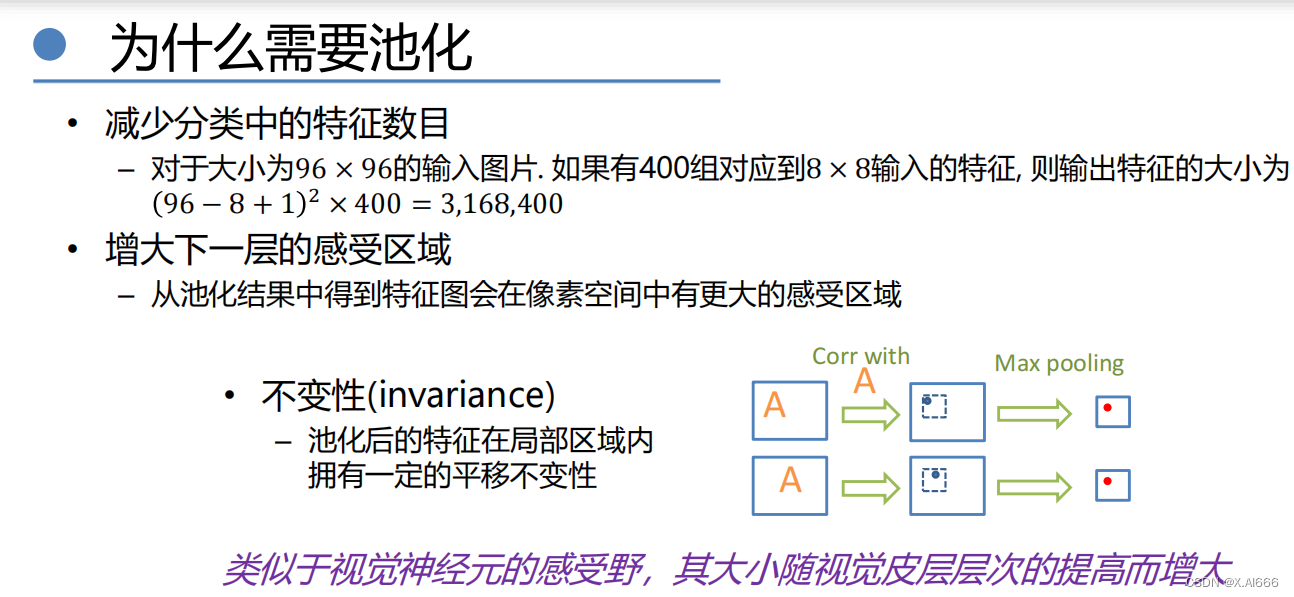

池化层通常位于连续的卷积层之间,其主要目的是降低特征图的空间维度(高度和宽度),从而减少计算量和防止过拟合。池化操作通过对特征图上的小区域进行下采样来实现,常用的池化操作包括最大池化和平均池化。

-

- 最大池化:选取区域内的最大值作为该区域的池化结果。

- 平均池化:计算区域内所有值的平均值作为池化结果。池化层除了减少数据的空间大小外,还增强了模型对小的位置变化的鲁棒性。

-

-

全连接层和分类器

-

在CNN的末端,全连接层将前面层的输出转化为一维向量,然后通过分类器(如Softmax函数)进行分类或其他任务的预测。

卷积神经网络的架构演进

从1998年LeNet的提出到今天,CNN经历了多次重要的架构革新:

-

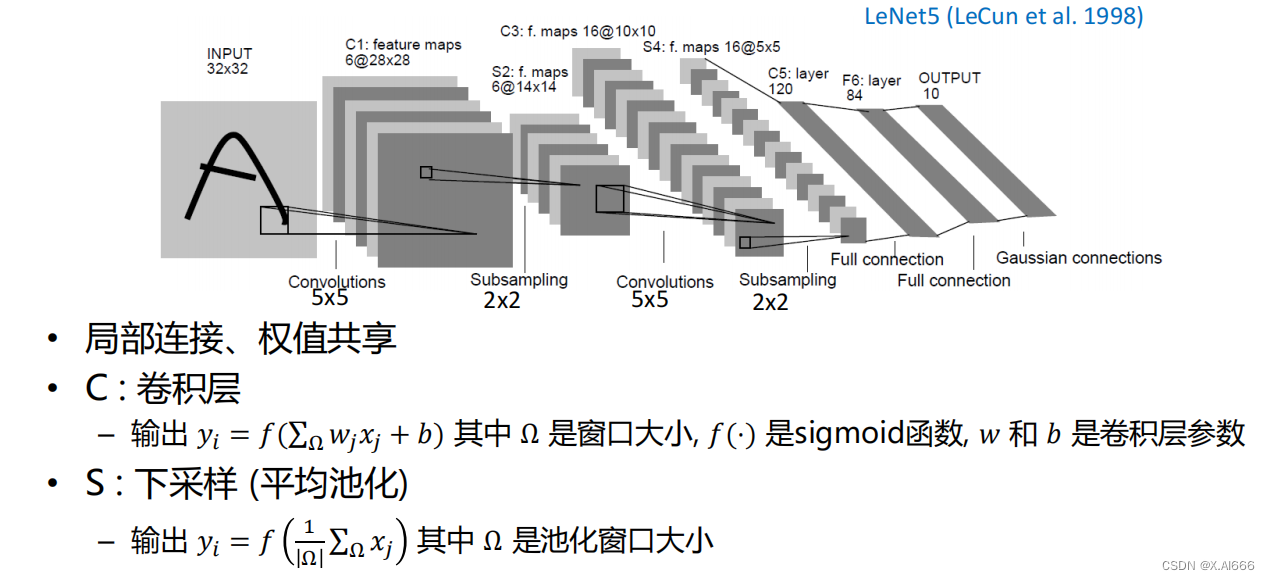

LeNet-5:是最早的卷积神经网络之一,由Yann LeCun于1998年提出,主要用于手写数字识别。LeNet-5的结构简单,包含两个卷积层,两个池化层,和两个全连接层。

-

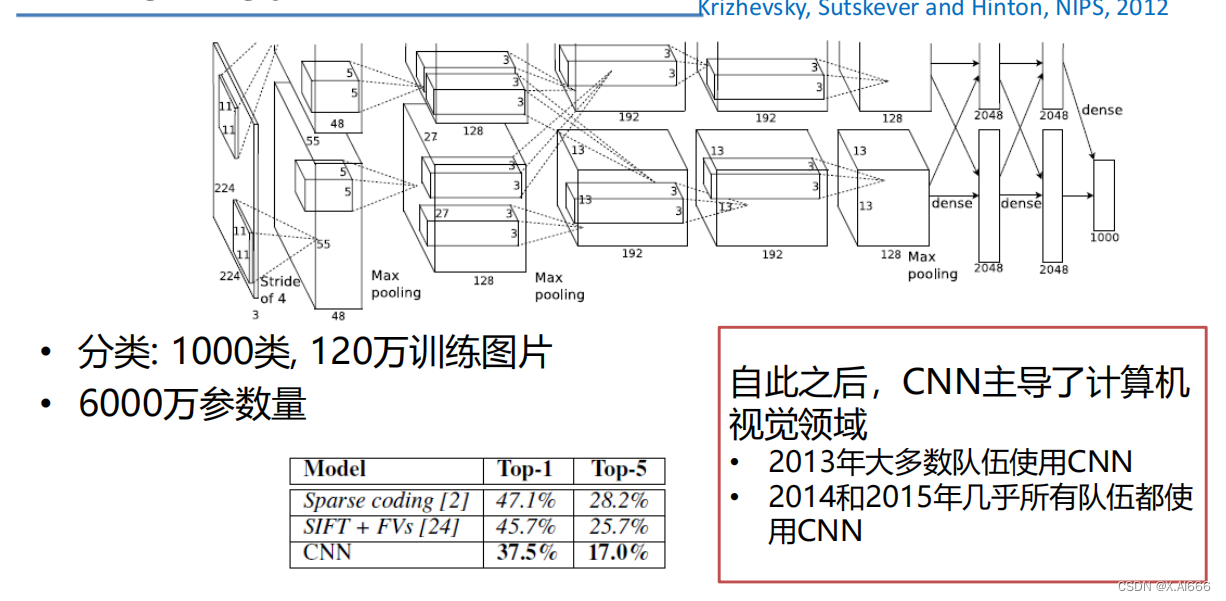

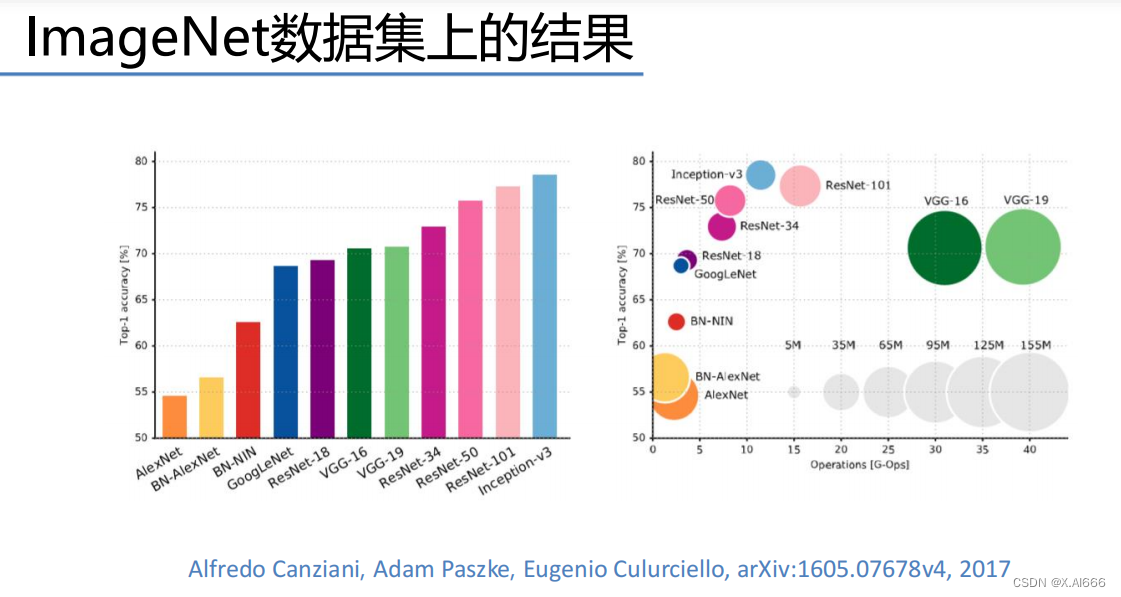

AlexNet:在2012年的ImageNet竞赛中取得了突破性的成功,它深化了网络结构,并首次在CNN中使用ReLU激活函数和Dropout正则化技术。

-

VGG:由牛津大学的视觉几何组(Visual Geometry Group)于2014年提出,特点是使用多个连续的小卷积核(3x3)替代大卷积核,极大地增加了网络的深度。

-

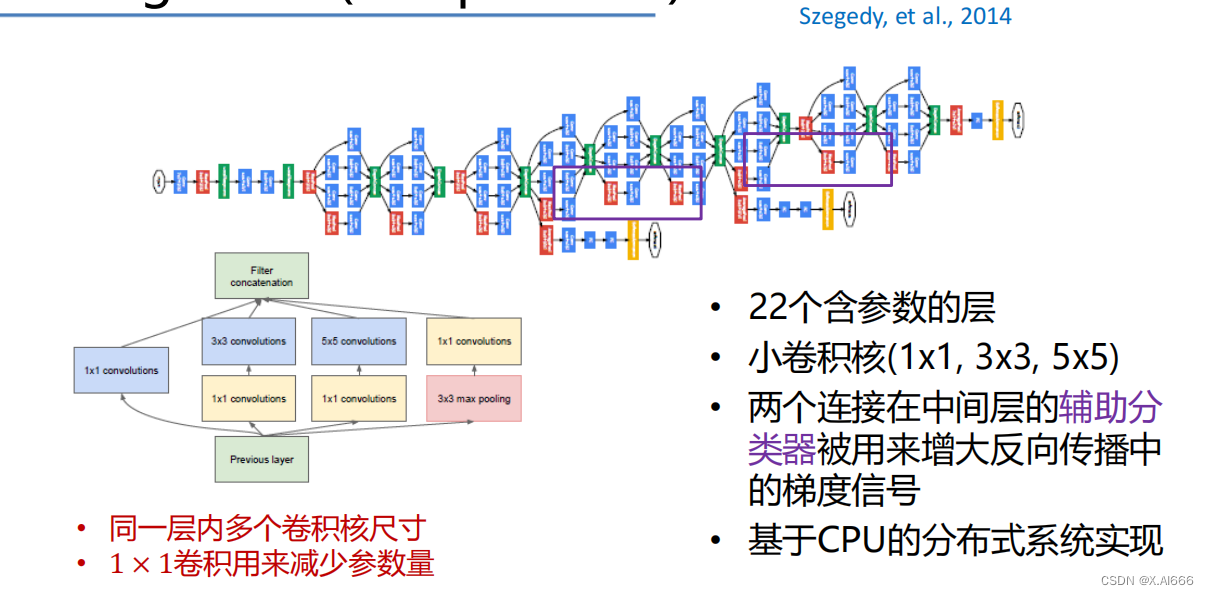

GoogLeNet (Inception):引入了一种名为Inception的模块,通过并行的不同尺寸的卷积核和池化操作,有效地增加了网络的宽度和深度,同时保持了计算资源的效率。

-

ResNet (残差网络):通过引入残差模块来解决深度网络训练过程中的梯度消失/爆炸问题,使得网络能够达到前所未有的深度,极大地提高了图像识别的准确性。

-

这些典型的CNN架构不仅在图像分类任务上取得了显著的成绩,也为后续的研究和应用奠定了基础,推动了深度学习技术在计算机视觉领域的快速发展。

卷积神经网络在实践中的应用

CNN在许多计算机视觉任务中取得了突破性的进展,包括但不限于:

模型训练技巧与优化策略

训练深度CNN模型是一个挑战,需要精心设计的网络结构、合理的初始化策略,以及有效的正则化和优化技巧:

深度学习框架和工具

深度学习社区开发了多种框架和工具来简化模型的开发和训练过程,包括:

未来方向和挑战

尽管卷积神经网络已经在视觉任务中取得了巨大成功,但仍有许多挑战和发展方向,包括提高模型的解释性、保护用户隐私、减少模型的能耗和计算需求等。此外,深度学习技术在自然语言处理、语音识别、强化学习等其他领域的应用也是未来研究的热点。

结论

卷积神经网络已经成为深度学习和计算机视觉领域的基石,通过持续的技术创新和应用拓展,它们将继续推动人工智能技术的进步,影响我们的工作和生活方式。随着研究的深入和技术的发展,未来必将揭开更多令人兴奋的可能性。

-

图像分类:从简单的MNIST手写数字识别到复杂的ImageNet挑战,CNN能够准确地识别出图像中的对象。

-

物体检测和分割:CNN不仅可以识别图像中的对象,还能定位它们的位置,甚至精确到像素

级的边缘进行分割,如使用R-CNN(区域卷积神经网络)系列模型在复杂图像中识别并定位多个对象。

-

面部识别和验证:CNN通过学习面部的深层特征,已经在面部识别技术中取得了巨大成功,应用包括自动标记社交媒体图片、安全验证等。

-

图像生成和风格转换:利用CNN的变体,如生成对抗网络(GANs)和风格迁移技术,可以生成逼真的图像,或将一种图像风格转换到另一张图片上,开启了创意和艺术的新可能性。

-

参数初始化:正确的参数初始化方法可以加速模型的收敛,避免训练过程中的梯度消失或爆炸问题。常见的初始化方法包括Xavier初始化和He初始化。

-

激活函数的选择:ReLU(线性整流单元)因其简单高效成为最受欢迎的激活函数之一,它解决了传统Sigmoid函数在深层网络中的梯度消失问题。

-

正则化技术:Dropout和Batch Normalization是两种广泛使用的正则化技术,可以减少过拟合,提高模型的泛化能力。Dropout通过随机“丢弃”一部分神经元的激活值来增加模型的鲁棒性,而Batch Normalization通过规范化层输入来加速训练过程。

-

优化算法:随机梯度下降(SGD)及其变体(如带动量的SGD、AdaGrad、RMSprop、Adam)是训练深度学习模型的常用优化算法,它们通过不同的方式调整学习速率,以寻找模型的最优参数。

-

TensorFlow和PyTorch:这两个框架因其强大的功能、灵活的设计和庞大的社区支持成为深度学习研究和应用的首选。TensorFlow由Google开发,支持静态计算图,适合生产环境和大规模部署;PyTorch由Facebook支持,采用动态计算图,更加灵活,适合研究和开发。

-

其他框架:除了TensorFlow和PyTorch,还有如Caffe、Theano、MXNet等其他深度学习框架,各有特点,适合不同的需求和场景。