什么是 RAG

LLM 会产生误导性的 “幻觉”,依赖的信息可能过时,处理特定知识时效率不高,缺乏专业领域的深度洞察,同时在推理能力上也有所欠缺。

正是在这样的背景下,检索增强生成技术(Retrieval-Augmented Generation,RAG)应时而生,成为 AI 时代的一大趋势。

RAG 通过在语言模型生成答案之前,先从广泛的文档数据库中检索相关信息,然后利用这些信息来引导生成过程,极大地提升了内容的准确性和相关性。RAG 有效地缓解了幻觉问题,提高了知识更新的速度,并增强了内容生成的可追溯性,使得大型语言模型在实际应用中变得更加实用和可信。

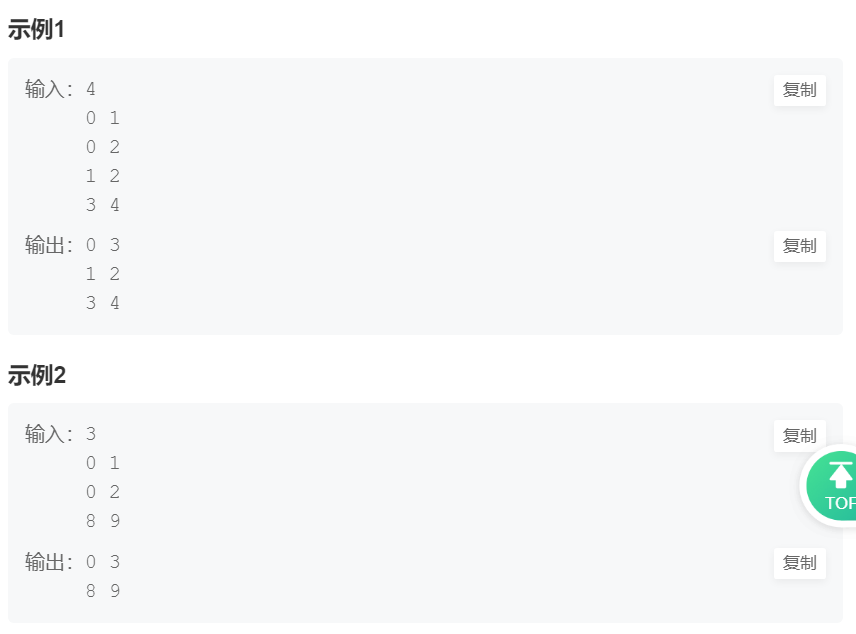

一个典型的RAG的例子:

这里面主要包括包括三个基本步骤:

-

索引 — 将文档库分割成较短的 Chunk,并通过编码器构建向量索引。

-

检索 — 根据问题和 chunks 的相似度检索相关文档片段。

-

生成 — 以检索到的上下文为条件,生成问题的回答。

技术交流&资料

技术要学会分享、交流,不建议闭门造车。一个人可以走的很快、一堆人可以走的更远。

成立了大模型面试和技术交流群,相关资料、技术交流&答疑,均可加我们的交流群获取,群友已超过2000人,添加时最好的备注方式为:来源+兴趣方向,方便找到志同道合的朋友。

方式①、微信搜索公众号:机器学习社区,后台回复:加群

方式②、添加微信号:mlc2040,备注:来自CSDN + 技术交流

- 重磅消息!《大模型面试宝典》(2024版) 正式发布!

- 重磅消息!《大模型实战宝典》(2024版) 正式发布!

Qwen1.5版本年前开源了包括0.5B、1.8B、4B、7B、14B和72B在内的六种大小的基础和聊天模型,同时,也开源了量化模型。不仅提供了Int4和Int8的GPTQ模型,还有AWQ模型,以及GGUF量化模型。为了提升开发者体验,Qwen1.5的代码合并到Hugging Face Transformers中,开发者现在可以直接使用transformers>=4.37.0 而无需 trust_remote_code。

与之前的版本相比,Qwen1.5显著提升了聊天模型与人类偏好的一致性,并且改善了它们的多语言能力。所有模型提供了统一的上下文长度支持,支持32K上下文。还有,基础语言模型的质量也有所小幅改进。

Qwen1.5全系列统一具备强大的链接外部系统能力(agent/RAG/Tool-use/Code-interpreter)。

正因为Qwen1.5作为中文LLM率先合入了Transformers,我们也可以使用LLaMaIndex的原生HuggingFaceLLM来加载模型。

LLaMaIndex

LlamaIndex 是一个基于 LLM 的应用程序的数据框架,受益于上下文增强。 这种LLM系统被称为RAG系统,代表“检索增强生成”。LlamaIndex 提供了必要的抽象,可以更轻松地摄取、构建和访问私有或特定领域的数据,以便将这些数据安全可靠地注入 LLM 中,以实现更准确的文本生成。

GTE文本向量

文本表示是自然语言处理(NLP)领域的核心问题, 其在很多NLP、信息检索的下游任务中发挥着非常重要的作用。近几年, 随着深度学习的发展,尤其是预训练语言模型的出现极大的推动了文本表示技术的效果, 基于预训练语言模型的文本表示模型在学术研究数据、工业实际应用中都明显优于传统的基于统计模型或者浅层神经网络的文本表示模型。这里, 我们主要关注基于预训练语言模型的文本表示。

GTE-zh模型使用retromae初始化训练模型,之后利用两阶段训练方法训练模型:第一阶段利用大规模弱弱监督文本对数据训练模型,第二阶段利用高质量精标文本对数据以及挖掘的难负样本数据训练模型。

最佳实践

环境配置与安装

-

python 3.10及以上版本

-

pytorch 1.12及以上版本,推荐2.0及以上版本

-

建议使用CUDA 11.4及以上

安装依赖库

!pip install llama-index llama-index-llms-huggingface ipywidgets

!pip install transformers -U

import logging

import sys

logging.basicConfig(stream=sys.stdout, level=logging.INFO)

logging.getLogger().addHandler(logging.StreamHandler(stream=sys.stdout))

from IPython.display import Markdown, display

import torch

from llama_index.llms.huggingface import HuggingFaceLLM

from llama_index.core.prompts import PromptTemplate

from modelscope import snapshot_download

from llama_index.core.base.embeddings.base import BaseEmbedding, Embedding

from abc import ABC

from typing import Any, List, Optional, Dict, cast

from llama_index.core import (

VectorStoreIndex,

ServiceContext,

set_global_service_context,

SimpleDirectoryReader,

)

加载大语言模型

因为Qwen本次支持了Transformers,使用HuggingFaceLLM加载模型,模型为(Qwen1.5-4B-Chat)

# Model names

qwen2_4B_CHAT = "qwen/Qwen1.5-4B-Chat"

selected_model = snapshot_download(qwen2_4B_CHAT)

SYSTEM_PROMPT = """You are a helpful AI assistant.

"""

query_wrapper_prompt = PromptTemplate(

"[INST]<<SYS>>\n" + SYSTEM_PROMPT + "<</SYS>>\n\n{query_str}[/INST] "

)

llm = HuggingFaceLLM(

context_window=4096,

max_new_tokens=2048,

generate_kwargs={"temperature": 0.0, "do_sample": False},

query_wrapper_prompt=query_wrapper_prompt,

tokenizer_name=selected_model,

model_name=selected_model,

device_map="auto",

# change these settings below depending on your GPU

model_kwargs={"torch_dtype": torch.float16},

)

加载数据:导入测试数据

!mkdir -p 'data/xianjiaoda/'

!wget 'https://modelscope.oss-cn-beijing.aliyuncs.com/resource/rag/xianjiaoda.md' -O 'data/xianjiaoda/xianjiaoda.md'

documents = SimpleDirectoryReader("/mnt/workspace/data/xianjiaoda/").load_data()

documents

构建Embedding类

加载GTE模型,使用GTE模型构造Embedding类

embedding_model = "iic/nlp_gte_sentence-embedding_chinese-base"

class ModelScopeEmbeddings4LlamaIndex(BaseEmbedding, ABC):

embed: Any = None

model_id: str = "iic/nlp_gte_sentence-embedding_chinese-base"

def __init__(

self,

model_id: str,

**kwargs: Any,

) -> None:

super().__init__(**kwargs)

try:

from modelscope.models import Model

from modelscope.pipelines import pipeline

from modelscope.utils.constant import Tasks

# 使用modelscope的embedding模型(包含下载)

self.embed = pipeline(Tasks.sentence_embedding, model=self.model_id)

except ImportError as e:

raise ValueError(

"Could not import some python packages." "Please install it with `pip install modelscope`."

) from e

def _get_query_embedding(self, query: str) -> List[float]:

text = query.replace("\n", " ")

inputs = {"source_sentence": [text]}

return self.embed(input=inputs)['text_embedding'][0].tolist()

def _get_text_embedding(self, text: str) -> List[float]:

text = text.replace("\n", " ")

inputs = {"source_sentence": [text]}

return self.embed(input=inputs)['text_embedding'][0].tolist()

def _get_text_embeddings(self, texts: List[str]) -> List[List[float]]:

texts = list(map(lambda x: x.replace("\n", " "), texts))

inputs = {"source_sentence": texts}

return self.embed(input=inputs)['text_embedding'].tolist()

async def _aget_query_embedding(self, query: str) -> List[float]:

return self._get_query_embedding(query)

建设索引

加载数据后,基于文档对象列表(或节点列表),建设他们的index,就可以方便的检索他们。

embeddings = ModelScopeEmbeddings4LlamaIndex(model_id=embedding_model)

service_context = ServiceContext.from_defaults(embed_model=embeddings, llm=llm)

set_global_service_context(service_context)

index = VectorStoreIndex.from_documents(documents)

查询和问答

搭建基于本地知识库的问答引擎

query_engine = index.as_query_engine()

response = query_engine.query("西安交大是由哪几个学校合并的?")

print(response)

通俗易懂讲解大模型系列

-

重磅消息!《大模型面试宝典》(2024版) 正式发布!

-

重磅消息!《大模型实战宝典》(2024版) 正式发布!

-

做大模型也有1年多了,聊聊这段时间的感悟!

-

用通俗易懂的方式讲解:不要再苦苦寻觅了!AI 大模型面试指南(含答案)的最全总结来了!

-

用通俗易懂的方式讲解:我的大模型岗位面试总结:共24家,9个offer

-

用通俗易懂的方式讲解:大模型 RAG 在 LangChain 中的应用实战

-

用通俗易懂的方式讲解:一文讲清大模型 RAG 技术全流程

-

用通俗易懂的方式讲解:如何提升大模型 Agent 的能力?

-

用通俗易懂的方式讲解:ChatGPT 开放的多模态的DALL-E 3功能,好玩到停不下来!

-

用通俗易懂的方式讲解:基于扩散模型(Diffusion),文生图 AnyText 的效果太棒了

-

用通俗易懂的方式讲解:在 CPU 服务器上部署 ChatGLM3-6B 模型

-

用通俗易懂的方式讲解:使用 LangChain 和大模型生成海报文案

-

用通俗易懂的方式讲解:ChatGLM3-6B 部署指南

-

用通俗易懂的方式讲解:使用 LangChain 封装自定义的 LLM,太棒了

-

用通俗易懂的方式讲解:基于 Langchain 和 ChatChat 部署本地知识库问答系统

-

用通俗易懂的方式讲解:在 Ubuntu 22 上安装 CUDA、Nvidia 显卡驱动、PyTorch等大模型基础环境

-

用通俗易懂的方式讲解:Llama2 部署讲解及试用方式

-

用通俗易懂的方式讲解:基于 LangChain 和 ChatGLM2 打造自有知识库问答系统

-

用通俗易懂的方式讲解:一份保姆级的 Stable Diffusion 部署教程,开启你的炼丹之路

-

用通俗易懂的方式讲解:对 embedding 模型进行微调,我的大模型召回效果提升了太多了

-

用通俗易懂的方式讲解:LlamaIndex 官方发布高清大图,纵览高级 RAG技术

-

用通俗易懂的方式讲解:为什么大模型 Advanced RAG 方法对于AI的未来至关重要?

-

用通俗易懂的方式讲解:使用 LlamaIndex 和 Eleasticsearch 进行大模型 RAG 检索增强生成

-

用通俗易懂的方式讲解:基于 Langchain 框架,利用 MongoDB 矢量搜索实现大模型 RAG 高级检索方法

-

用通俗易懂的方式讲解:使用Llama-2、PgVector和LlamaIndex,构建大模型 RAG 全流程