Transformer?

Transformer是一个利用注意力机制来提高模型训练速度的模型,因其适用于并行化计算以及本身模型的复杂程度使其在精度和性能上都要高于之前流行的循环神经网络。

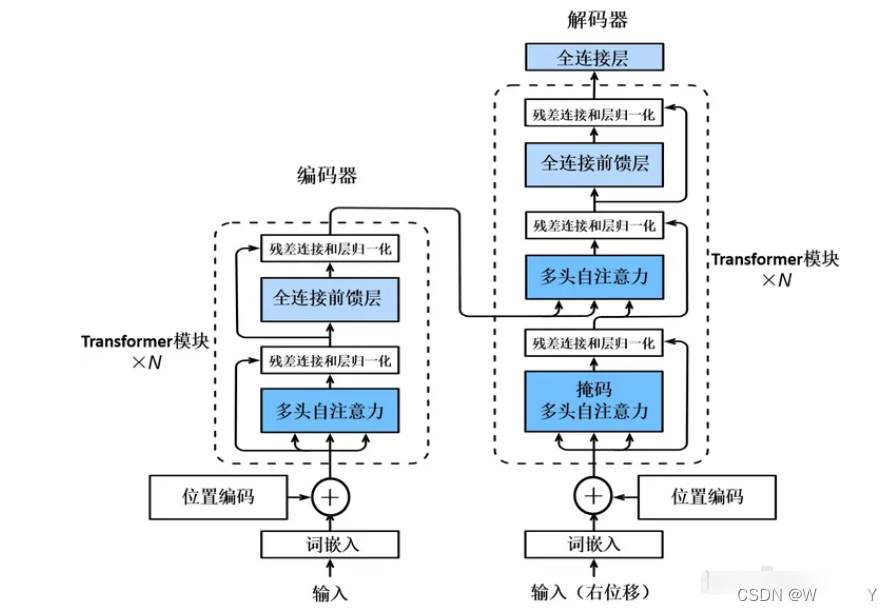

标准的Transformer结构如下图所示(图来自知乎-慕文),是一个编码器-解码器架构,其编码器和解码器均有一个编码层和若干相同的Transformer模块层堆叠组成。

transformer的训练过程?

训练过程通常包括以下步骤:

数据预处理:对原始数据进行清洗、标记和转换,以适应 Transformer 模型的输入格式。

模型初始化:根据任务需求,初始化 Transformer 模型的参数,通常使用随机初始化的方法。

前向传播:将预处理的数据输入到 Transformer 模型中,通过一系列的编码器和解码器层,生成模型的预测输出。

损失计算:将模型的预测输出与真实标签进行比较,计算损失函数(如交叉熵损失)来衡量预测与真实值之间的差异。

反向传播:使用反向传播算法计算损失函数对模型参数的梯度,并根据梯度更新模型参数,以最小化损失函数。

优化算法:使用优化算法(如梯度下降)根据梯度更新模型参数,不断迭代优化模型的性能。

迭代训练:重复执行前向传播、损失计算和反向传播步骤,直到模型收敛或达到指定的训练轮数。

tensorflow与transformer有什么关系?

TensorFlow是一个开源机器学习框架,而transformer是一种用于自然语言处理任务的模型架构。在TensorFlow中,可以使用transformer模型来构建和训练用于处理自然语言文本的模型。因此,TensorFlow和transformer之间的关系是,TensorFlow可以用来实现和部署transformer模型。TensorFlow还提供了许多用于构建和训练transformer模型的工具和库。

训练架构除了Transformer,还有什么?

- 循环神经网络(Recurrent Neural Networks,RNN):RNN 是一种经典的序列模型,通过循环连接实现对序列数据的建模。RNN 在处理序列任务时具有记忆性,可以捕捉到序列中的时序信息。其中,长短期记忆网络(Long Short-Term Memory,LSTM)和门控循环单元(Gated Recurrent Unit,GRU)是 RNN 的两种常见变体。

- 卷积神经网络(Convolutional Neural Networks,CNN):CNN 主要用于处理图像数据,但也可以应用于序列任务。通过卷积层和池化层的组合,CNN 可以提取序列中的局部特征,并在后续的全连接层中进行特征转换和预测。

- 强化学习(Reinforcement Learning,RL):强化学习是一种训练模型的框架,它通过与环境进行交互,通过奖励信号来调整模型的参数。在强化学习中,模型通过与环境进行试错学习,以最大化累积奖励。

- 预训练模型(Pretrained Models):预训练模型是指在大规模数据上预先训练的模型。常见的预训练模型包括BERT、GPT、Transformer-XL等。这些模型在大规模语料库上学习了通用的语言表示,可以通过微调或迁移学习来适应特定任务。

- 自编码器(Autoencoders):自编码器是一种无监督学习的模型,用于学习数据的紧凑表示。自编码器通过编码器将输入数据映射到低维空间,然后通过解码器重构输入数据。这种架构可以用于特征提取、降维和数据压缩等任务。

受欢迎程度排序如下?

-转换器(Transformer)

-卷积神经网络(CNN)

-强化学习(Reinforcement Learning,RL)

-递归神经网络(RNN)

-生成对抗网络(GAN)

-自编码器(Autoencoders)

强化学习和Transformer两者架构的区别?

强化学习(Reinforcement Learning,RL)和 Transformer 是两种不同的架构,用于解决不同类型的问题。

- 目标任务:强化学习主要用于解决序贯决策问题,其中智能体需要通过与环境的交互来学习最优的行为策略,以最大化累积奖励。强化学习可以应用于各种任务,如游戏玩法、机器人控制和自动驾驶等。

Transformer 则主要应用于自然语言处理(Natural Language Processing,NLP)领域的任务,如机器翻译、文本生成和文本分类等。它是一种用于处理序列数据的架构,通过自注意力机制和编码器-解码器结构来捕捉序列中的依赖关系和上下文信息。 - 建模方式:强化学习基于智能体与环境的交互,通过学习最优策略来最大化累积奖励。它通常包括状态、动作、奖励和环境模型等组成部分。

Transformer 是一种神经网络架构,通过多层自注意力机制和前馈神经网络对序列数据进行编码和解码。它没有明确的环境模型或动作选择过程,而是通过学习输入序列之间的关系来进行推理和生成。 - 数据需求:强化学习通常需要与环境进行大量的交互,并通过试错学习来优化策略。这可能需要较长的训练时间和大量的训练数据。

Transformer 在训练时通常使用标注的数据对模型进行有监督的学习。虽然 Transformer 也可以使用大规模的非标注数据进行预训练,但在特定任务上的微调通常需要相对较少的标注数据。

总的来说,强化学习和 Transformer 是应用于不同类型问题的不同架构。强化学习用于序贯决策问题,通过交互学习最优策略;而 Transformer 是一种序列建模架构,主要用于自然语言处理任务。以下是转换器相对于强化学习的一些优势:

(1)应用领域:转换器主要用于序列数据处理,特别是在自然语言处理(NLP)领域中取得了巨大的成功。它在语言建模、机器翻译、文本生成等任务中表现出色。而强化学习则主要用于解决序贯决策问题,例如游戏玩法、机器人控制和自动驾驶等领域。因此,转换器和强化学习在应用领域上有所不同。

(2)数据需求:转换器通常需要大量的标注数据进行监督式或无监督式的训练。对于预训练的转换器模型,需要大规模的文本数据来进行预训练。相比之下,强化学习通常需要与环境进行交互,并通过奖励信号进行学习。它可能需要更多的实际交互数据和更长的训练时间。

(3)训练方式:转换器通常通过监督式学习或无监督式学习进行训练,其中监督式学习通常需要标注数据。相比之下,强化学习采用的是试错和奖励信号的方式进行学习,在训练过程中可以通过与环境的交互进行自我优化。

(4)解释性:转换器可以提供对文本和序列数据的解释性,可以通过注意力权重等方式分析模型在输入数据中的关注点。而强化学习的决策过程通常是基于智能体与环境的交互,解释性可能相对较弱。

深度学习中的全连接层是什么?

通俗来说,全连接层在深度学习中的作用是将前一层的特征与权重相乘,并通过激活函数进行非线性变换,从而生成下一层的输出。

我们可以将全连接层看作是一个神经网络中的"大脑",它负责对输入的特征进行处理和提取。具体而言,全连接层的作用有以下几个方面:

- 特征组合:全连接层将前一层的特征进行线性组合,通过调整权重的大小,可以突出不同特征之间的关联性。这样可以使网络更好地捕捉到输入数据中的相关模式和结构。

- 非线性变换:通过激活函数(如ReLU、sigmoid或tanh),全连接层引入了非线性变换,使得网络能够学习更复杂的特征表示。非线性变换能够帮助网络学习到更丰富的特征表达,从而提升模型的表达能力。

- 特征映射:全连接层将输入的高维特征映射到输出的类别概率或回归值。通过训练过程中不断调整权重,全连接层可以学习到适合特定任务的特征表示,使得网络能够对输入数据进行有效的分类、预测或回归。

总的来说,全连接层在深度学习中起到了连接不同层之间的作用,通过特征组合和非线性变换,它能够将输入数据转化为更高级的特征表示,并为最终的任务提供有效的输入。全连接层在许多深度学习模型和任务中都扮演着重要的角色,如图像分类、目标检测、自然语言处理等。

残差连接和归一化

残差连接(Residual Connection)和归一化(Normalization)是深度学习中常用的技术,它们的作用和全连接层有所不同。

- 残差连接的作用:

残差连接是为了解决深层神经网络训练中的梯度消失和梯度爆炸问题。它通过在网络中引入跳跃连接,将前一层的输出直接添加到后续层的输入中,使得信息可以更快地传递和更新。

残差连接能够帮助网络学习到更深层次的特征表示,提升网络的表达能力和学习效果。它可以减轻梯度消失问题,使得网络更容易训练,并且有助于避免退化问题,即加深网络深度反而导致性能下降。 - 归一化的作用:

归一化技术(如批量归一化 Batch Normalization 和层归一化 Layer Normalization)用于在网络中调整输入数据的分布,以加速网络的收敛和提高训练的稳定性。

归一化可以使得输入数据在训练过程中保持较小的方差,并且有助于缓解梯度消失问题。它可以提供更稳定的梯度信号,使得网络更容易学习到有效的特征表示。

归一化还可以增加网络的鲁棒性,使得网络对输入数据的尺度变化不敏感,提高模型的泛化能力。

解决的问题不同:全连接层主要解决特征的组合和映射问题,通过学习适合任务的特征表示。残差连接主要解决深层网络的训练问题,通过传递跳跃连接的残差信息,提升网络的学习能力。归一化技术主要解决梯度消失、训练不稳定和模型的鲁棒性问题。

与全连接层相比,残差连接和归一化有以下区别:

(1)功能不同:全连接层主要用于特征的组合和映射,将输入特征与权重相乘并进行非线性变换。而残差连接和归一化主要用于改善深层网络的训练和优化过程。

(2)应用范围不同:全连接层在神经网络的各个层中都可以使用,用于连接不同层之间的神经元。而残差连接主要应用于深层网络中,用于增强信息传递和梯度的流动,减轻梯度消失问题。归一化技术可以在网络的不同层中使用,用于调整输入数据的分布。

(3)解决的问题不同:全连接层主要解决特征的组合和映射问题,通过学习适合任务的特征表示。残差连接主要解决深层网络的训练问题,通过传递跳跃连接的残差信息,提升网络的学习能力。归一化技术主要解决梯度消失、训练不稳定和模型的鲁棒性问题。