一、简介

深度Q网络(DQN)是一种结合了深度学习和强化学习的算法,它在近年来成为了人工智能领域的一个热点。DQN首次被引入是在2013年,由DeepMind的研究人员开发。它标志着深度学习技术在解决高维度决策问题上的一大突破。

DQN的定义

DQN是一种算法,它使用深度神经网络来逼近最优的Q函数。在传统的Q学习中,Q函数用于估计在给定状态下采取特定动作的期望回报。DQN通过训练神经网络来学习这个Q函数,使其能在更复杂的环境中做出决策。

DQN与传统Q学习的对比

与传统的Q学习相比,DQN的一个主要优势在于它能处理更高维度的状态空间。在传统的Q学习中,状态和动作的每种组合都需要单独评估,这在复杂环境中变得不切实际。DQN通过使用深度神经网络来解决这个问题,使得算法能够在包含数千或数百万种可能状态的环境中有效工作。

DQN的重要性和影响

DQN对现代人工智能的发展具有重要意义。它不仅在理论上展示了深度学习和强化学习的结合是可能的,而且在实际应用中也取得了显著成效。DQN最著名的应用之一是在玩Atari游戏时,它能够达到甚至超越人类的表现。这一成就不仅展示了DQN在处理复杂视觉输入方面的能力,也证明了它在长期策略规划方面的有效性。

DQN的成功也促进了强化学习领域的进一步研究和发展。自DQN问世以来,出现了许多改进和变体,如双重DQN、优先经验回放等,这些都在不断推动着强化学习技术的边界。

DQN不仅是一个算法,它还代表了一种新的思维方式,即如何将深度学习的强大能力应用于复杂决策过程中。

二、历史背景

深度Q网络(DQN)的出现是在强化学习和深度学习领域多年发展的基础上。要理解DQN的历史背景,我们需要回溯到这两个领域早期的发展。

传统强化学习的简要历史

强化学习作为一个研究领域,起源于20世纪50年代。最初,它受到心理学中行为主义理论的影响,专注于通过奖励和惩罚来塑造算法的行为。早期的强化学习模型相对简单,但随着时间的推移,研究者开始引入更复杂的模型和算法。到了1980年代,随着计算机科学的发展,强化学习开始被应用于更复杂的任务,如机器人导航和游戏。

深度学习的兴起

深度学习,特别是神经网络的研究,可以追溯到上世纪50年代和60年代。但是,直到21世纪初,由于计算能力的大幅提升和大数据的可用性,深度学习才真正开始蓬勃发展。2006年,深度学习的一个关键时刻是多层神经网络训练方法的改进,使得深度神经网络变得更加实用和强大。

DQN的诞生和发展

DQN的诞生发生在这两个领域交汇的时刻。2013年,DeepMind的研究人员首次提出了深度Q网络,将深度学习应用于强化学习中。这一突破性的研究展示了深度神经网络在处理高维度输入(如视觉数据)方面的能力,并将其与Q学习结合,从而使得算法能够在复杂环境中进行有效的决策学习。

DQN的成功引起了巨大的关注。2015年,DeepMind进一步改进了DQN算法,使其能够在多种Atari游戏中达到超越人类的表现。这不仅证明了DQN的有效性,也标志着强化学习在实际应用中的一个重要里程碑。

从那以后,DQN及其变体(如双重DQN、优先经验回放DQN等)成为了强化学习研究的热点。这些研究不仅推动了强化学习技术的发展,也为人工智能的其他领域,如自然语言处理和计算机视觉,提供了新的灵感和方法。

总之,DQN的历史是强化学习和深度学习这两个领域共同发展的产物。它不仅是一个技术上的突破,也是对这两个领域未来可能融合的一个预示。

三、核心原理

深度Q网络(DQN)的核心原理涉及到结合经典Q学习算法和深度神经网络。本部分将探讨Q学习的基础,深度学习在DQN中的角色,以及DQN的关键技术。

Q学习的基本原理

Q学习是一种无模型的强化学习算法,用于学习在给定状态下每个动作的价值。其核心是Q函数,即动作价值函数,定义为:

Q ( s , a ) = E [ R t ∣ s t = s , a t = a ] Q(s, a) = \mathbb{E}[R_t | s_t = s, a_t = a] Q(s,a)=E[Rt∣st=s,at=a]

其中, Q ( s , a ) Q(s, a) Q(s,a) 是在状态 s s s 下采取动作 a a a 所得到的期望回报。 R t R_t Rt 是时间 t t t 的回报。Q学习的目标是找到一个策略,最大化累积回报。

Q函数更新规则如下:

Q n e w ( s , a ) ← Q ( s , a ) + α [ R + γ max a ′ Q ( s ′ , a ′ ) − Q ( s , a ) ] Q_{new}(s, a) \leftarrow Q(s, a) + \alpha [R + \gamma \max_{a'} Q(s', a') - Q(s, a)] Qnew(s,a)←Q(s,a)+α[R+γa′maxQ(s′,a′)−Q(s,a)]

这里, α \alpha α 是学习率, γ \gamma γ 是折扣因子, s ′ s' s′ 是下一个状态, R R R 是当前回报。

深度学习在DQN中的应用

在DQN中,传统Q学习中的Q表被深度神经网络所替代。这个网络被训练来近似Q函数。使用深度神经网络可以有效处理高维输入空间,这在传统方法中是非常困难的。

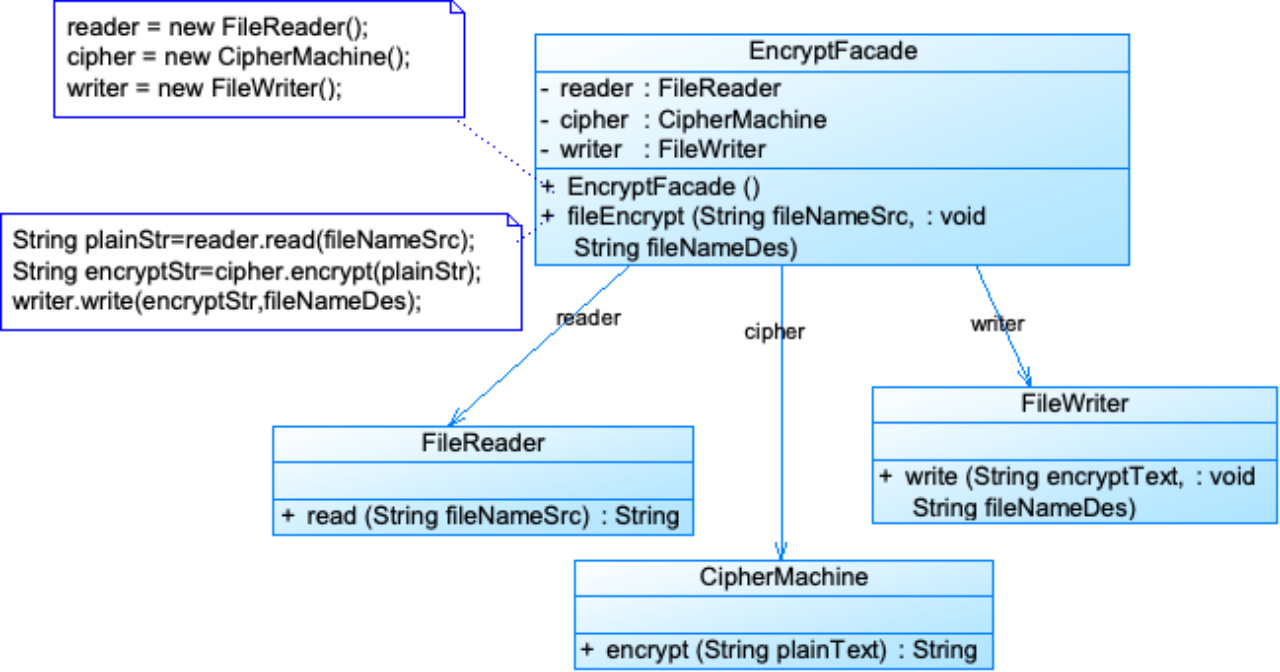

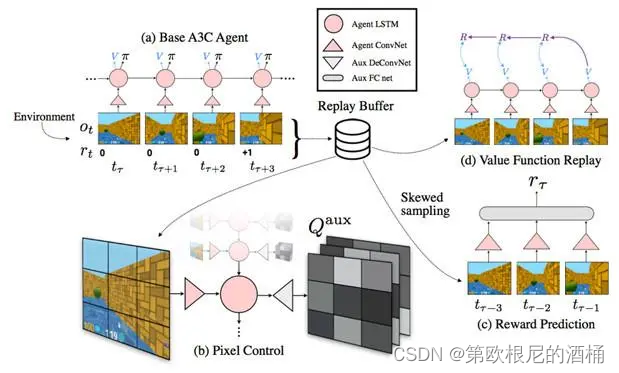

关键技术:经验回放和目标网络

经验回放是DQN中的一个关键技术。在这种机制下,智能体的经验 ( s , a , R , s ′ ) (s, a, R, s') (s,a,R,s′) 被存储在回放记忆中。在训练过程中,这些经验会被随机抽取,用于训练网络。这种方法可以提高数据利用率并减少样本间的相关性。

另一个重要技术是目标网络。在DQN中,有两个神经网络:一个用于确定实际值(在线网络),另一个用于预测未来值(目标网络)。目标网络的参数定期从在线网络复制过来。这种设置可以提高学习的稳定性。

综上所述,DQN通过结合深度学习和Q学习的原理,成功地应用于处理复杂的决策问题。其关键技术如经验回放和目标网络的引入,进一步提高了算法的性能和稳定性。

四、实际应用

深度Q网络(DQN)已经在多个领域展示了其强大的应用潜力。以下是DQN在不同场景中应用的一些例子,以及一个基本的代码示例。

DQN在游戏中的应用

DQN最初并最著名的应用是在Atari视频游戏中。2013年,DeepMind展示了DQN算法在多个Atari 2600游戏中的性能,其中在一些游戏中,DQN的表现甚至超过了人类玩家。这一成就显示了DQN处理复杂视觉输入和学习有效策略的能力。

DQN在机器人技术中的应用

在机器人技术中,DQN被用来实现自主控制和决策。例如,在机器人导航和抓取任务中,DQN可以帮助机器人学习如何在不确定的环境中作出决策,以完成特定的任务。

DQN在其他领域的应用

除了游戏和机器人技术,DQN还被应用于其他多个领域,如自然语言处理、推荐系统和医疗诊断。在这些领域,DQN帮助算法在复杂的决策环境中找到有效的策略。

代码示例

以下是一个使用Python和TensorFlow实现DQN的基本示例。请注意,这只是一个简化版本,旨在说明DQN的基本框架。

import numpy as np

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Activation, Flatten

from tensorflow.keras.optimizers import Adam

class DQNAgent:

def __init__(self, state_size, action_size):

self.state_size = state_size

self.action_size = action_size

self.model = self._build_model()

def _build_model(self):

# 创建一个序贯模型

model = Sequential()

model.add(Flatten(input_shape=(1, self.state_size)))

model.add(Dense(24, activation='relu'))

model.add(Dense(24, activation='relu'))

model.add(Dense(self.action_size, activation='linear'))

model.compile(loss='mse', optimizer=Adam(lr=0.001))

return model

# 其他DQN相关的方法将在这里实现

# 示例:创建一个DQNAgent

state_size = 4 # 假设状态空间大小为4

action_size = 2 # 假设动作空间大小为2

agent = DQNAgent(state_size, action_size)

这个代码示例展示了如何构建一个简单的DQN代理。它涵盖了模型的创建和初始化部分。在实际应用中,这个代理需要进一步扩展,以包括经验回放、目标网络更新等。

五、总结

深度Q网络(DQN)自推出以来已经取得了显著的成功,但它在未来发展中还面临一些挑战和改进的空间。以下是对DQN未来发展的一些展望,包括当前挑战、改进方向和潜在影响。

当前DQN面临的挑战

尽管DQN在多个领域表现出色,但它仍然面临一些挑战,如样本效率低下、泛化能力有限和训练稳定性问题。例如,DQN通常需要大量的数据才能学习有效的策略,这在现实世界应用中可能是一个限制。

潜在的改进方向

为了克服这些挑战,研究人员正在探索多种改进方向。这些方向包括改进学习算法以提高样本效率、使用元学习技术来提高泛化能力,以及结合模型预测控制(MPC)来改善决策过程。以下是一些相关的研究论文,它们探讨了DQN的这些改进方向:

- 提高样本效率的方法

- DQN的元学习应用

- 结合模型预测控制的DQN

对未来技术发展的影响

DQN及其变体在未来可能对多个领域产生深远的影响。在自动化、健康护理和教育等行业中,DQN的改进可能会带来更加智能和适应性强的解决方案。此外,DQN的研究也可能为理解和模仿人类学习过程提供新的视角。

结论

总的来说,DQN的发展前景广阔,但也需要继续探索和解决其当前面临的挑战。随着人工智能领域的不断进步,我们可以期待DQN及其衍生技术在未来将带来更多创新和改变。

![[机器学习]人工智能为小米智架保驾护航](https://img-blog.csdnimg.cn/9ce5039ffe5246f78843a13ab28ffc79.jpg)

![【洛谷 P8655】[蓝桥杯 2017 国 B] 发现环 题解(邻接表+并查集+路径压缩)](https://img-blog.csdnimg.cn/direct/378c2e3302ba420bac3cc8056a199fc9.jpeg)