神经网络为什么要进行权重初始化?

神经网络进行权重初始化的目的在于促进网络的有效训练和收敛。正确的权重初始化可以帮助缓解梯度消失或梯度爆炸等问题,并且有助于加速训练过程。以下是权重初始化的几个重要原因:

1. **避免梯度消失或梯度爆炸**:如果权重初始化过大,可能会导致梯度爆炸,从而使网络参数迅速变得极大。相反,如果权重初始化过小,可能会导致梯度消失,使得网络难以学习。通过适当的初始化方法,可以使权重分布在一个合理的范围内,有助于避免梯度消失或梯度爆炸。

2. **加速收敛**:良好的权重初始化可以帮助网络更快地收敛到一个较好的解决方案。初始化的好坏直接影响网络的初始状态,从而影响了训练过程中参数的更新速度和模型的收敛速度。

3. **防止权重对称性**:如果所有的权重都初始化为相同的值,那么在反向传播过程中,它们会以相同的方式更新。这可能导致网络无法学习到丰富的特征表示。通过随机初始化权重,可以破坏权重的对称性,使得每个神经元都能够学习到不同的特征。

4. **避免陷入局部最优解**:神经网络的损失函数通常是非凸的,存在许多局部最优解。通过良好的权重初始化,可以提高网络收敛到全局最优解的概率,从而提高模型的性能。

5. **稳定性和鲁棒性**:适当的权重初始化可以提高网络的稳定性和鲁棒性,使得网络对输入数据的变化具有更好的适应性。

综上所述,权重初始化是神经网络训练中非常重要的一步,它直接影响着网络的训练效果和性能。选择合适的权重初始化方法可以提高网络的训练速度、模型的性能和稳定性。

Kaiming初始化方法

Kaiming初始化方法是由何博士(He Kaiming)等人提出的,主要针对深度神经网络中的ReLU(修正线性单元)激活函数而设计的一种权重初始化方法。该方法旨在解决传统的初始化方法对深度神经网络的训练效果不佳的问题。

传统的初始化方法,如Xavier初始化,是根据输入和输出层的连接数来初始化权重的,但在使用ReLU激活函数时,这种方法可能导致梯度在反向传播过程中逐渐消失,尤其是在深度网络中。Kaiming初始化方法的提出就是为了解决这个问题。

Kaiming初始化方法的核心思想是根据激活函数的特性来初始化权重,从而保持梯度的稳定传播。具体而言,对于ReLU激活函数,Kaiming初始化方法使用了激活函数的非线性属性,将权重初始化为以0为中心、标准差为sqrt(2 / fan_in)的正态分布,其中fan_in表示输入的数量。

这个初始化方法的理论基础是根据了解ReLU激活函数在负半轴上的性质。在ReLU中,负数部分的梯度为零,因此通过使用以0为中心的分布来初始化权重,可以使得神经元在训练过程中更容易激活,并且有助于避免梯度消失问题。

总之,Kaiming初始化方法的提出为深度神经网络的训练提供了更有效的初始化策略,特别是在使用ReLU等激活函数时。它帮助加速网络的收敛速度,并提高了网络的性能和稳定性,成为了训练深度神经网络时广泛使用的初始化方法之一。

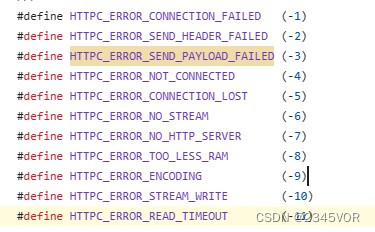

nn.init.kaiming_normal_方法

'nn.init.kaiming_normal_' 是PyTorch中的一个方法,用于根据ReLU (Rectified Linear Unit,整流线性单元)激活层的kaiming(也称为He)初始化方案初始化神经网络层的权重。这种初始化方法对深度神经网络特别有用,在深度神经网络中,使用标准初始化技术可能会导致训练期间梯度消失或爆炸。

Kaiming初始化方法用正态分布中采样的值初始化权重,该正态分布的均值为0,标准差根据层中使用的特定非线性计算。对于ReLU激活函数,标准差计算为sqrt(2 / fan_in),其中fan_in表示输入单元的数量。

下面是nn.init.kaiming_normal_的语法:

nn.init.kaiming_normal_(tensor, a=0, mode='fan_in', nonlinearity='relu')

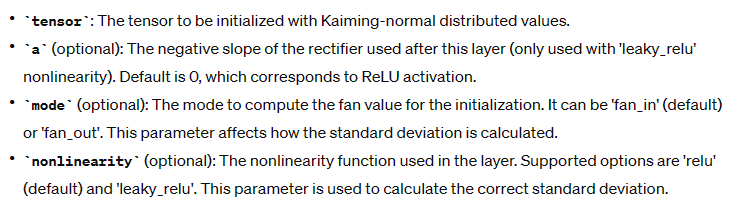

tensor:用Kaiming正态分布值初始化的张量。

tensor:用Kaiming正态分布值初始化的张量。

a(可选):该层之后使用的整流器的负斜率(仅用于'leaky_relu'非线性)。默认值为0,对应于ReLU激活。

mode(可选):它可以是'fan_in'(默认)或'fan_out'。该参数影响如何计算标准差。fan_in:权重是通过线性层(卷积或全连接)隐性确定 ; fan_out:通过创建随机矩阵显式创建权重。

在神经网络中权重初始化的情况下,“fan_out”指的是一层中输出单元(神经元)的数量。

当使用kaiming初始化等方法初始化权重时,使用“fan_out”模式来计算绘制权重的分布的标准差。具体来说,标准偏差计算为sqrt(2 / fan_out)。

在完全连接层(也称为线性层)中,当前层中的每个神经元都连接到前一层的每个神经元。在这方面:

“fan_in”指的是该层的输入单元数量(即前一层的神经元数量)。

“fan_out”指的是该层输出单元的数量(即当前层的神经元数量)。

非线性(可选):层中使用的非线性函数。支持的选项是'relu'(默认)和'leaky_relu'。该参数用于计算正确的标准差。

示例:

import torch

import torch.nn as nn

# Create a linear layer

linear_layer = nn.Linear(10, 5)

# Initialize the weights of the linear layer using Kaiming normal initialization

nn.init.kaiming_normal_(linear_layer.weight, mode='fan_out', nonlinearity='relu')

在这个例子中,linear_layer是一个线性层,有10个输入单元和5个输出单元。我们使用nn.init.kaiming_normal_,用kaiming正态分布值初始化这一层的权值,特别是对于ReLU非线性。”“mode”参数被设置为“fan_out”,因为它通常用于线性层;并且“nonlinearity”参数被设置为“relu”。

详细介绍可参考He, K等人于2015年发表的论文《Delving deep into rectifiers: Surpassing human-level performance on ImageNet classification》,论文链接如下:

He_Delving_Deep_into_ICCV_2015_paper.pdf (cv-foundation.org)

![[flask]执行上下文的四个全局变量](https://img-blog.csdnimg.cn/direct/b46f61eb392548d1adf39b9ead79e9cf.png)