摘要

知识图嵌入是数据挖掘研究中的一个基本问题,在现实世界中有着广泛的应用。它的目的是将图中的实体和关系编码到低维向量空间中,以便后续算法使用。负抽样,即从训练数据中未观察到的负三元组中抽取负三元组,是KG嵌入的重要步骤。近年来,生成对抗网络(GAN)被引入到负采样中。这些方法通过对分数较大的负三元组进行采样,避免了梯度消失的问题,从而获得了更好的性能。然而,使用GAN会使原始模型变得更加复杂和难以训练,因此必须使用强化学习。在本文中,由于观察到具有大分数的负三元组很重要但很少见,我们提出使用缓存直接跟踪它们。然而,如何从缓存中采样和更新缓存是两个重要的问题。我们精心设计了解决方案,不仅效率高,而且在勘探和开采之间取得了良好的平衡。通过这种方式,我们的方法作为先前基于gan的方法的“提炼”版本,它不会浪费训练时间在附加参数上以拟合负三元组的完整分布。大量的实验表明,我们的方法可以在各种KG嵌入模型上获得显著的改进,并且优于基于GAN的最先进的负采样方法。

1.介绍

均匀采样因其简单、高效而被广泛应用于KG嵌入中[40]。然而,这是一个固定的方案,忽略了训练过程中负三元组分布的变化。因此,它严重地受到梯度消失问题的困扰。具体而言,如文献[39]所观察到的,样本集中大多数阴性三胞胎都是易于分类的三胞胎。由于评分函数倾向于给观察到的(正的)三元组很大的值,随着训练的进行,大多数未观察到的(可能是负的)三元组的分数(从评分函数中评估)变得更小。因此,当负三元组被均匀采样时,我们很可能会选择一个梯度为零的三元组。因此,KG嵌入的训练过程将受到这种消失梯度的阻碍,而不是优化算法的阻碍。这样的问题阻碍了KG嵌入获得理想的性能。一种更好的抽样方案,即伯努利抽样,在[42]中被引入。通过考虑头尾之间的一对多、多对多和多对一的映射关系,改进了均匀采样。然而,它仍然是一个固定的采样方案,受到梯度消失的影响。

因此,高质量的负三胞胎应该有较大的分数。为了在训练过程中有效地捕获它们,我们对负采样有两个主要挑战:(i)如何捕获和建模负三联体的动态分布?(ii)我们如何以一种有效的方式对负三联体进行采样?最近,有两个开创性的作品,即IGAN[39]和KBGAN[9],试图解决这些挑战。他们的想法都是用生成对抗网络(GAN)取代固定的采样方案[16]。然而,基于gan的解决方案仍然存在许多问题。首先,由于引入了一个额外的生成器,GAN增加了训练参数的数量。其次,GAN训练可能存在不稳定性和退化性[1],[18],并且已知IGAN和KBGAN中使用的强化梯度[44]具有高方差。这些缺点导致不同评分函数的性能不稳定,因此对于IGAN和KBGAN都必须进行预训练。

在本文中,为了解决高质量负采样的挑战,同时避免使用GAN带来的问题,我们提出了一种新的基于缓存的负采样方法,称为NSCaching。通过实证研究负样本的得分分布,我们发现得分分布是高度偏态的,即只有少数负三胞胎得分大,其余的都是无用的。这一观察结果促使我们在训练过程中只维护高质量的负三联体,并动态更新所维护的三联体。首先,我们将高质量的负三元组存储在缓存中,然后设计重要性采样(IS)策略来更新缓存。IS策略既能捕捉到分布的动态特征,又能提高nscing的效率。此外,我们还很注意“探索和开发”,它平衡了探索所有可能的高质量负三联体和从缓存中的几个大分数负三联体中采样。我们的工作贡献总结如下:

- 我们提出了一种简单有效的负采样方案——NSCaching。它是一种通用的负抽样方案,可以注入到所有常用的KG嵌入模型中。与IGAN和KBGAN相比,nscach具有更少的参数,并且可以像原始的KG嵌入模型一样使用梯度下降进行训练。

- 在NSCaching中,我们提出了统一的缓存采样策略和IS策略来更新缓存,同时要注意“探索和开发”。

- 我们分析了NSCaching与self-paced learning之间的联系[3],[24]。我们证明NSCaching可以先学习容易分类的样本,然后逐渐切换到更难分类的样本。

- 我们对四个流行的数据集WN18和FB15K,以及它们的变体WN18RR和FB15K237进行了实验。实验结果表明,我们的方法是非常有效的,并且比目前最先进的方法,即IGAN和KBGAN更有效。

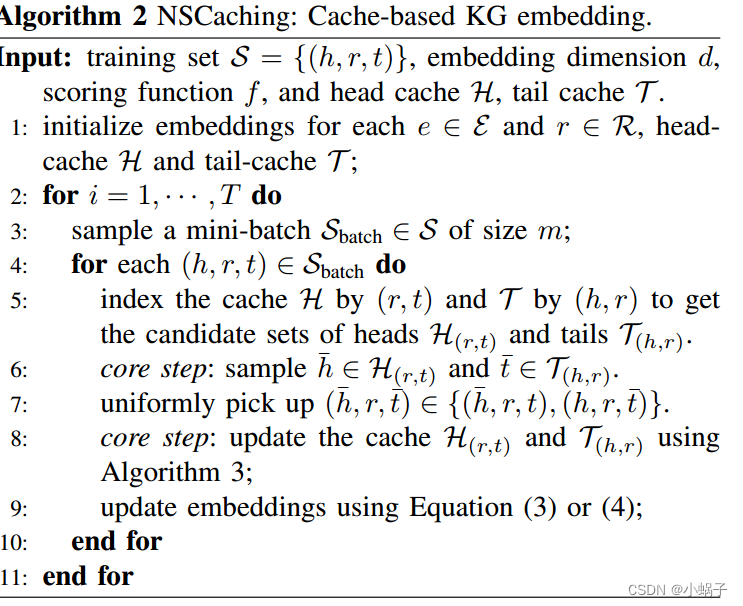

III. PROPOSED MODEL

在本节中,我们首先描述我们在第III-A节中的关键观察结果,这些观察结果被现有作品所忽略,但却是我们工作的主要动机。在第III-B节中描述了所提出的方法,其中我们展示了如何通过缓存解决负采样中的挑战。最后,我们在Section III-C中展示了NSCaching和self-pace learning之间有趣的联系[24],这进一步解释了良好的性能。

A. Closer Look at Distribution of Negative Triplets

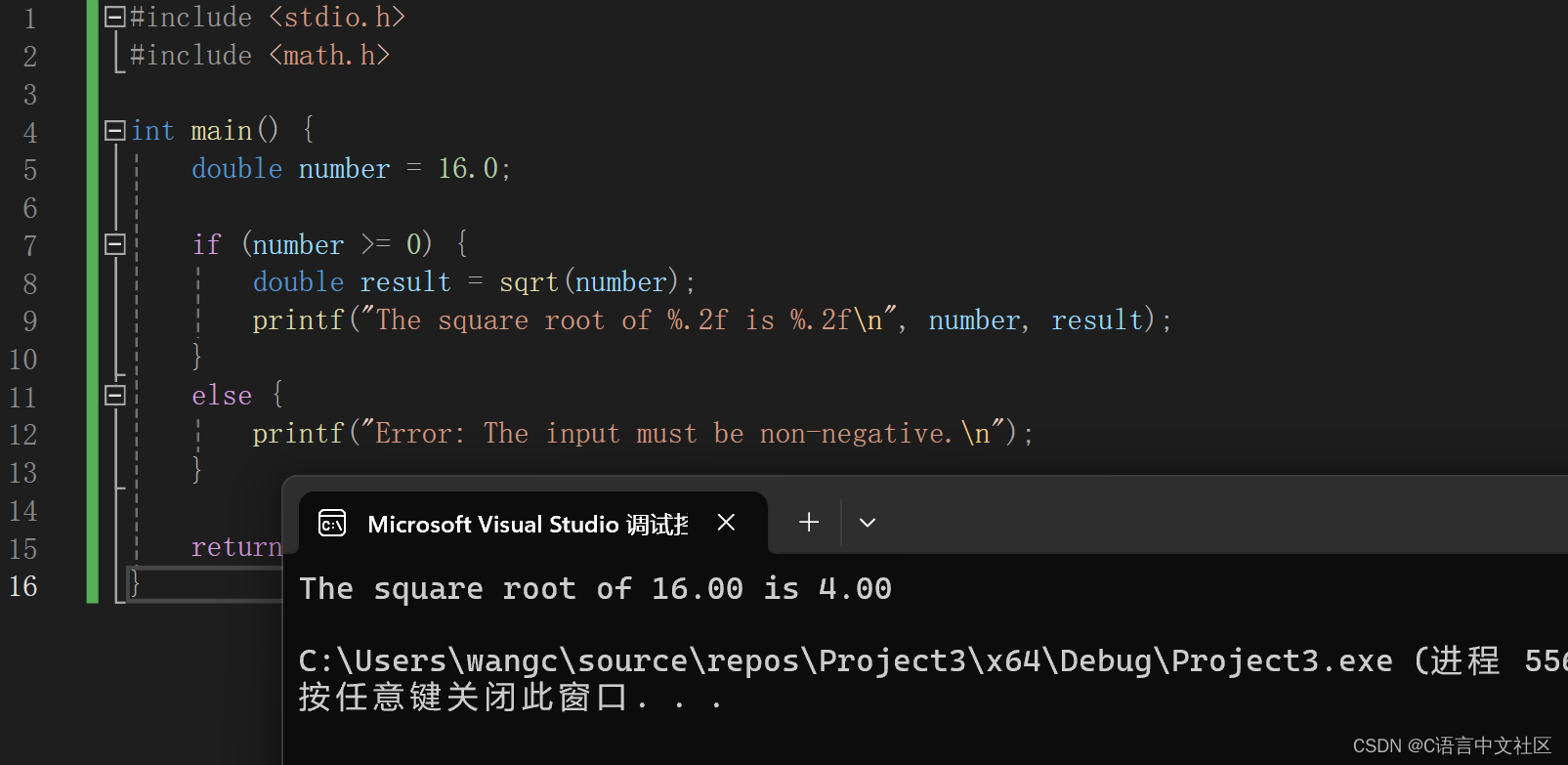

•阴性三胞胎的得分分布高度倾斜。

•无论训练(图1(a))和正三胞胎的选择(图1(b))如何,只有少数负三胞胎得分高。

![[蓝桥杯 2022 省 A] 求和](https://img-blog.csdnimg.cn/direct/6802f778d4d041bc8870c6a901fccbbf.png)