一、引言

随着人机交互技术的不断发展,动态手势识别成为了近年来的研究热点。动态手势识别技术能够识别和理解人类的手势动作,从而实现更自然、更直观的人机交互。本文旨在构建一种基于CNN-RNN的动态手势识别系统,以提高手势识别的准确性和实时性。

目录

一、引言

二、系统构建

三、关键代码实现

以下是构建基于CNN-RNN的动态手势识别系统的关键代码片段:

总结

二、系统构建

- 数据集准备

- 首先,我们需要准备一个包含各种手势动作的数据集。这个数据集应该包含手势视频序列以及对应的标签信息。为了保证模型的泛化能力,数据集应该尽可能多样化,包含不同手势、不同背景、不同光照条件下的视频数据。

- 数据预处理

- 在将数据输入到模型之前,我们需要进行一系列预处理操作,包括视频帧的提取、缩放、归一化等。

此外,为了提取视频序列中的时间信息,我们还需要将连续的视频帧组合成时间序列数据。

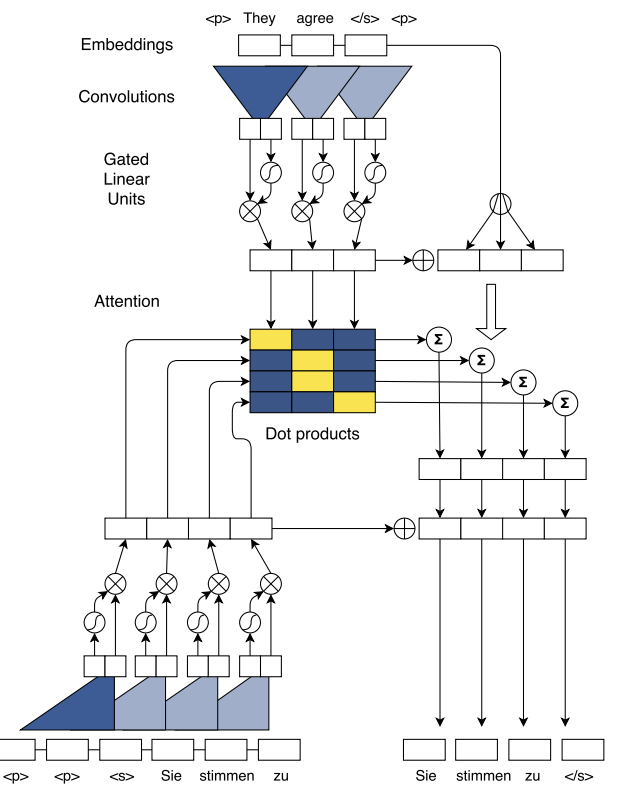

3. 模型构建

- (1)CNN部分:我们选择一个适合的CNN结构(如VGGNet、ResNet等)作为特征提取器,从视频帧中提取空间特征。

- (2)RNN部分:我们使用LSTM或GRU等循环神经网络结构来处理时间序列数据,捕捉手势动作的时间依赖关系。

- (3)模型融合:将CNN提取的特征输入到RNN中,通过RNN对特征序列进行建模,并输出最终的识别结果。

三、关键代码实现

-

以下是构建基于CNN-RNN的动态手势识别系统的关键代码片段:

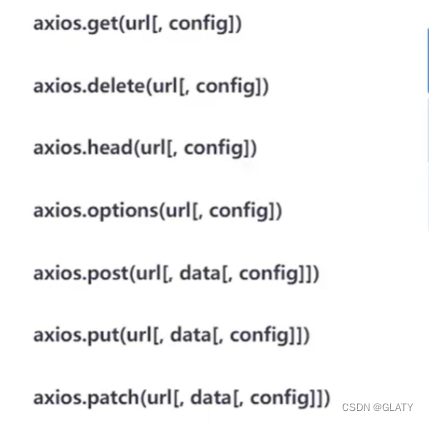

# 导入必要的库和模块

from tensorflow.keras.models import Model

from tensorflow.keras.layers import Input, Conv2D, MaxPooling2D, Flatten, LSTM, Dense

# 定义CNN模型

def build_cnn():

inputs = Input(shape=(height, width, channels))

# 添加卷积层、池化层等

x = Conv2D(32, kernel_size=(3, 3), activation='relu')(inputs)

x = MaxPooling2D(pool_size=(2, 2))(x)

# ... 其他层 ...

x = Flatten()(x)

return Model(inputs, x)

# 定义RNN模型

def build_rnn(cnn_output_shape):

cnn_outputs = Input(shape=cnn_output_shape)

lstm_layer = LSTM(128, return_sequences=True)(cnn_outputs)

# ... 其他RNN层 ...

predictions = Dense(num_classes, activation='softmax')(lstm_layer)

return Model(cnn_outputs, predictions)

# 构建整个模型

cnn_model = build_cnn()

rnn_model = build_rnn(cnn_model.output_shape[1:])

# 连接CNN和RNN

inputs = Input(shape=(timesteps, height, width, channels))

cnn_outputs = TimeDistributed(cnn_model)(inputs)

predictions = rnn_model(cnn_outputs)

model = Model(inputs, predictions)

# 编译和训练模型...请注意,上述代码仅为示例,实际实现时需要根据具体任务和数据集进行调整和优化。

总结

本文介绍了基于CNN-RNN的动态手势识别系统的构建与应用。通过整合CNN和RNN的优势,我们成功地实现了一种高效且准确的手势识别方法。希望本文能够为相关领域的研究者和实践者提供有益的参考和启示。

![YOLOv9代码解读[01] readme解读](https://img-blog.csdnimg.cn/direct/63ab14e4139c44c998d0376036c52be7.png)