原文标题

Vocabulary size and its effect on topic representation

摘要

这项研究调查了如何通过选择性地从被建模的文本语料库的词汇中删除术语来减少主题模型训练的计算开销。我们使用三个数据集,比较了删除单独出现的术语、前0.5%、1%和 5% 最频繁出现的术语以及前 0.5% 最频繁和单独出现的术语的影响,以及建模主题数量的变化(10、20、30、40、50、100) 。对四种结果指标进行了比较。删除单独出现的术语对所有测试的结果几乎没有影响。通过文档空间密度来衡量的文档区分能力,随着频繁出现的术语的移除而降低,但随着主题数量的增加而增加。词汇量对熵的影响不大,但熵受主题数量的影响。最后,由成对主题相似度和Jensen-Shannon散度衡量的主题相似度随着频繁项的删除而降低。这些发现对利用主题建模的信息检索和信息计量学中的信息科学研究有影响。

关键词:信息检索;信息计量学;主题建模;潜在狄利克雷分布;词汇量;词频

1.引言

主题建模是一种应用于文本语料库的机器学习技术,最初开发它是为了减少在信息检索 (IR) 等环境中发现的高维空间中固有的计算开销。主题建模采用计算方法 (例如无监督学习或矩阵分解) 从文本语料库中揭示潜在主题结构,即文档和术语之间的不可观察层。这些主题通常被表示为语义连贯性术语 (概率不同) 的混合体,集中在一些可解释的主题上。该技术已广泛用于信息检索,最近已在信息计量研究中得到应用。与传统的词袋表示相比,经过训练的主题也被认为是语义空间的更简洁的表示,因此可能更有利。在过去的十年中,主题建模的形式已应用于信息计量研究,由于现在可以获得更大的全文数据集,类似的计算开销问题正变得越来越普遍。信息计量研究中使用的一种主题建模形式依赖于LDA。

LDA模型将文档视为主题的混合体,将主题视为术语的混合体。Rosenzvi等人(2010)将原始的LDA模型扩展到包含作者,并提出了作者-主题模型,该模型可直接应用于基于作者的比较的信息度量。最近,Lu等人(2012)提出使用LDA来比较作者的作品之间的相似性。

尽管主题建模技术(如LDA)可以在训练主题之后减少比较实体的计算负担,但训练过程本身可能是耗时和计算密集的。LDA算法的复杂度与语料库中的文档数量、主题数量和术语数量成正比。随着越来越大的文本语料库的编制,词汇量可以是巨大的。如果在训练期间可以减少词汇表的大小,而不显著影响主题表示或文档比较的性质,这也可以减少识别主题的计算开销。本研究旨在系统考察词汇量对主题模型结果的影响。本研究探讨了以下研究问题:

1) 删除频繁和/或非频繁出现的术语对基于文档空间密度区分文本语料库中的文档的能力有什么影响?

2) 删除频繁和/或非频繁出现的术语如何影响文档中的主题分布,以及使用几种度量标准来衡量训练主题的区别性 (熵、两两主题相似度和Jensen-Shannon散度)?

三个数据集上进行实验,考察了不同词汇选择策略对主题模型结果的影响。有助于在信息科学研究中更有效地使用主题建模技术,包括使用大型文本语料库的 IR 和信息学研究。

2.文献回顾

2.1 主题建模的发展

向量空间模型是一种经典的数学模型,它描述了文档和查询间以及文档本身之间的关系。文档和查询在高维空间中表示为向量,其维数由系统索引的词汇数量决定。文档和查询关系由空间内各种计算的距离或基于角度的度量确定。随着IR系统索引的文档数量(n)的增加,与处理文档和查询相关的计算负担也会增加。由于可能有数亿个术语(m)和数百万个文档,处理一个n x m空间所带来的计算挑战变得很明显。

如果一种降维方法能够降低这种计算开销,而不会对存在于文档和查询之间的可观察关系造成明显的损失,那么这种方法将有利于文档的评估和检索。假设主题之间彼此独立:(Deerwester 1990, 潜在语义索引, LSI)\ (Hofmann 1999, 概率LSI)\ (Blei 2003, LDA);主题之间不独立:已经引入了相关主题建模 (主题之间的相关性);已经开发了分层主题建模 (主题之间的分层关系);主题建模还被扩展到多语言环境,以适应处理多语言文本资源的需要。

2.2 主题建模的应用

基于LDA的主题建模已经在信息科学中涉及自然语言处理的各种情况下变得非常流行,包括信息检索、信息计量和其他应用。

• 信息检索Wei 等人 (2006) 研究了如何使用基于 LDA 的文档模型来改进 ad-hoc 检索;Yi 等人(2009) 发现更复杂的主题模型不一定比 LDA 模型提供额外的 IR 优势。基于 LDA 和其他形式的主题建模也被引入到不同的IR应用中,例如文本分割、文本分类、文本摘要、查询扩展、搜索查询中的模式识别、跨语言信息检索和引文推荐。

• 信息计量主题建模广泛用于信息计量研究,作为基于引用和协作方法的替代或补充,以识别感兴趣实体间关系。与引用和协作不同 (作者或文档间必须存在链接才能识别可衡量的关系),在文档本身(标题、摘要和/或全文)中使用NL可以提供一个指示实体间关系或相似性的密切程度。

• 其它主题建模作为信息计量研究方法学工具的另一种可能用途是将作者身份归属于匿名或有争议的作品。例如,Savoy (2013) 使用 LDA 来识别有争议文本的主题分布,然后能够通过计算文本的主题分布与每个集合的主题分布之间的距离来确定该文本的最可能作者作者的。

2.3 主题建模的计算开销

这些研究没有涉及的一个领域是与开发和训练主题模型相关的计算开销。减少开销的技术可以解决词汇表大小和主题计算方法的问题。在许多研究中使用了基于频率的术语移除方法(Newman, 2007) (Jiang, 2015) (Yan, 2013) (Chang, 2009) (Wang, 2007) (Ramage, 2010);人们还尝试了其他删除词汇的技术 (Mcauliffe, 2008, tf-idf)。

尽管在许多主题建模研究中已经应用了基于频率的术语删除,但还没有系统的调查来比较基于删除不同数量的术语的模型结果。本研究通过比较使用不同词汇量和几种评估措施的训练模型的结果来解决这一差距。这项研究的结果有助于在未来的研究中更有效地使用主题建模。

3.方法

进行了实验以检查词汇选择对基于四种评估措施的主题模型结果的影响。方法部分介绍了数据收集、应用的主题建模方法、词汇选择策略以及本研究中使用的评估措施。

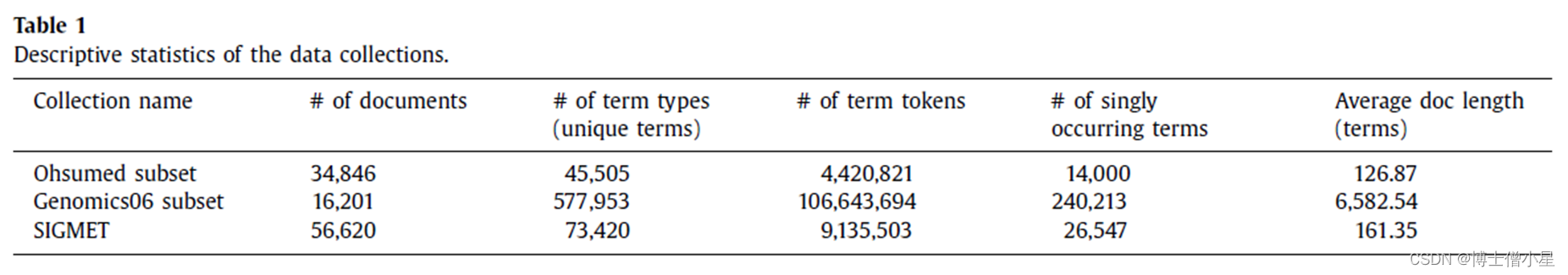

3.1 数据收集

3.2 主题模型

Java实现的LDA模型。参数设置:α=50/K (K为主题数),β=0.01,迭代次数为1000。α和β的设置是基于Steyvers等人(2007)的建议,他们发现在许多不同的文本集合中都能很好地工作。对于迭代的数量没有特定的指导方针。 (K = 10、20、30、40、50、100),检验K对结果的影响。

3.3 词汇选择策略

为了了解词汇量对主题表示的影响,使用不同的词汇选择方法为LDA模型选择词汇。具有完整词汇表表示的数据集作为基线 (只删除了停用词列表)。然后,测试了去除单次出现的术语,以及去除最常出现的前0.5%、1%和5%的术语类型。移除频繁和不频繁的词汇也进行了测试,前0.5%最频繁和单独出现的词汇都被移除。使用不同的词汇选择方法对每个结果数据集进行LDA主题训练。然后根据下一节中描述的结果比较度量对主题表示进行比较。

尽管在IR系统中词汇表大小与文档集大小相关,但是随着附加文档的增加,词汇表大小的增加会逐渐减少。添加的标记越多,添加的新类型就越少,因为它们已经存在于索引中 (希普斯定律, 1978)。频繁出现的术语在频率上继续增加,新术语类型的数量也在增加,但速度是渐进的。如果频繁或不频繁出现的术语在主题开发中没有发挥重要作用,那么应该在主题训练之前删除它们,以减少计算开销。

3.4 结果比较

4.发现

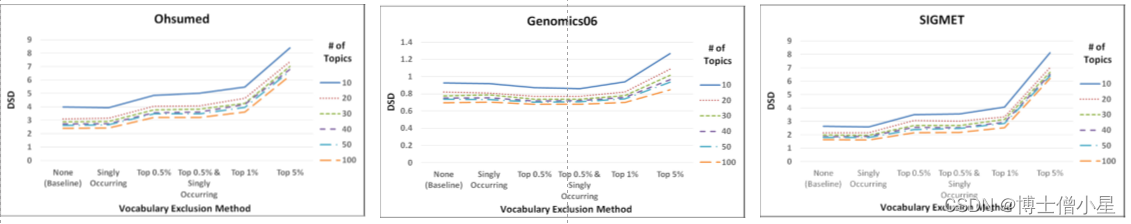

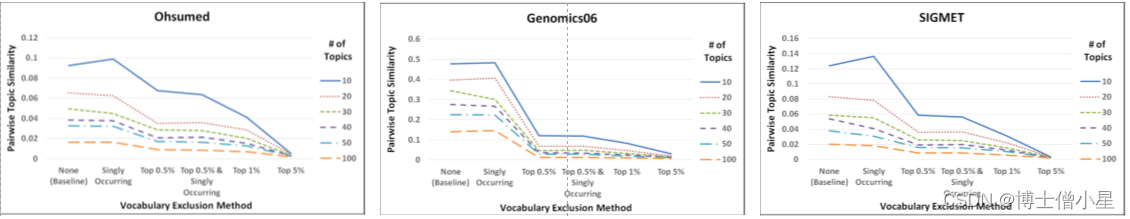

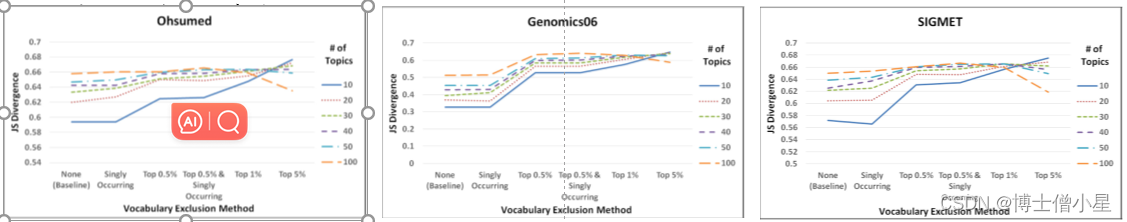

(x):None (Baseline)、Singly Occurring、Top 0.5%、Top 0.5% & Singly Occurring、Top 1%、Top 5%; (y):度量值;(z):六个主题总数(10,20,30,40,50,100个主题) 。然后对使用四种结果比较方法的每个组合的结果进行可视化比较。本节介绍了实验的结果 (折线图)。

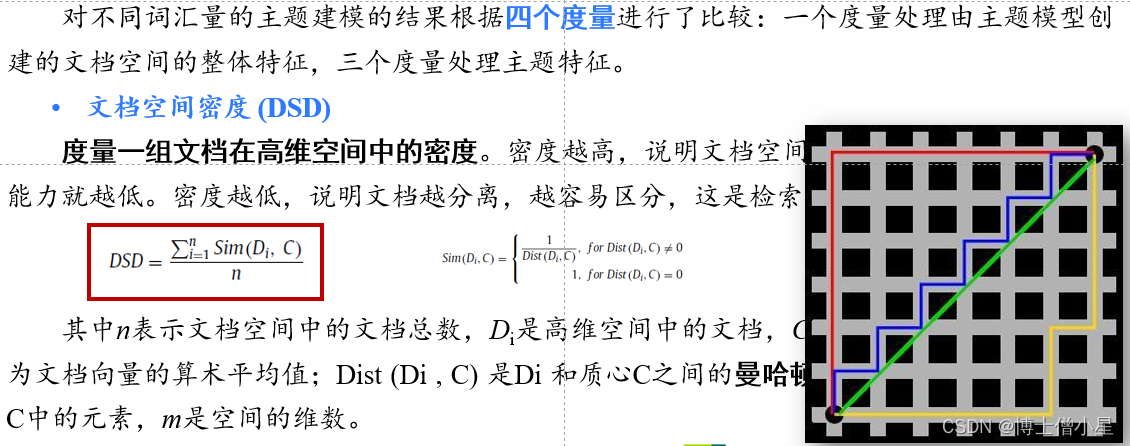

• 文档空间密度 (DSD): 度量一组文档在高维空间中的密度,越低越好使用基于主题的 DSD 删除单个出现的术语不会对基于主题的 DSD 或由此产生的文档判别能力产生太大影响,而删除频繁出现的术语会增加 DSD,这会对检索产生负面影响。

• 熵 ( Entopy ) : 文档中的主题分布是否均匀,越大越好词汇量在结果熵中并没有发挥很大的作用。去掉Top术语后,熵值略有增加,这表明文档中的主题分布更加均匀。

主题数量确实在每个数据集的熵结果中发挥了更突出的作用。使用较少的主题所带来的较低的熵值并不令人惊讶。由于主题较少,人们会期望文档更多地关注某些主题。使用不同词汇量训练主题模型对熵的影响不大。

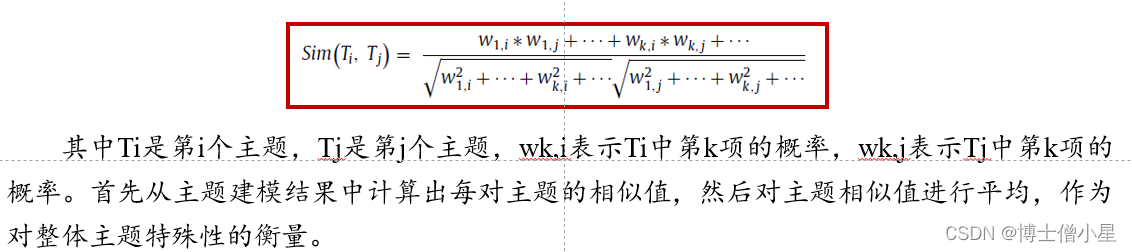

• 成对主题相似度 (PTS) : 衡量训练主题间不同的程度,越低越好 ( 主题越有特色 )去除单一出现的词汇后,稍微增加了成对的话题相似度;最值得注意的是,通过删除最常出现的术语,基本上消除了主题数量对成对主题相似度的影响;通过删除存在于大多数文档中并且可能会影响主题独特性的频繁出现的术语,主题越有特色;删除Top 0.5% 和Singly Occurring会产生与单独删除Top 0.5% 的非常相似的结果。

• Jensen-Shannon 散度 ( JS) : 两个概率分布差异的对称度量,越大越好与其他三个指标相比,主题数量和术语删除之间的交互作用更大;当使用完整的词汇表或删除Singly Occurring时,使用更多的主题时,主题之间的分歧会更大;通过删除最常出现的术语,特别是对于较少的主题,发散值会增加,并且在删除Top 1%到Top 5%最常出现的术语时,无论主题的数量如何,发散值都会收敛;除去Top 5%最常出现的术语,较低的主题数量比较高的主题数量导致更大的区别性;去掉Top 0.5%和Singly Occurring的结果与去掉Top 0.5%的项目的结果相似。

5.结果与讨论

Ø 无论使用何种测量方法, 都可删除单独出现的术语 ,而基于主题的结果没有明显差异;Ø 即使将术语转换为主题, 中频术语 仍然在通过主题表示来区分文档方面发挥重要作用;Ø 主题应该是独特的 ,以帮助区分文档和解释语料库的内容。本研究的结果对使用主题建模来表示文本语料库(如IR和Informmetrics)的研究具有启示意义。主题建模本身通过将处理的维数从数百万项降低到更易于管理的主题数量,最终减少了计算开销。这使得文本语料库的前端处理任务更加高效。然而,主题本身的初始训练在计算上仍然是昂贵的。本研究表明,这种训练开销可以通过减少训练过程中涉及的词汇表的大小来降低,而对主题的表示或结果文档空间的影响很小。信息检索和信息计量学研究都越来越多地使用主题建模的形式来揭示和表示在文献语料库中发现的实体关系,包括文章、作者和期刊。通过战略性地消除对主题发展无关紧要的词汇来减少计算处理开销的能力,将允许研究人员更有效地处理数据。

本研究揭示了词汇选择与话题建模结果之间的关系,对话题模型理论也有一定的贡献。虽然这四种测量方法提供了词汇量和话题数量变化对话题特殊性和检索性能的影响的证据,但这些都是间接测量方法。类似地,使用三个数据集也不允许我们概括所使用的样本数据集之外的结果,样本数据集主要由英语文档组成。我们无法得出结论,如果将频繁或不频繁的术语移除应用于其他语言的数据集,是否会有相同的效果。