目录

- 1 非监督学习的概念

- 1.1 非监督学习的定义

- 1.2 非监督学习的重要性

- 2 聚类问题的定义和意义

- 2.1 聚类问题的定义

- 2.2 聚类问题的意义

- 2.3 聚类问题在非监督学习中的地位

- 3 聚类算法介绍

- 3.1 K均值聚类

- 3.2 层次聚类

- 3.3 密度聚类

- 4 聚类问题的评估

- 4.1 内部评估指标

- 4.2 外部评估指标

- 5 聚类问题的挑战与应对方法

- 5.1 数据维度灾难

- 5.2 噪声和异常值处理

- 5.3 选择合适的聚类算法

- 5.4 参数选择和调优

- 5.5 可解释性与可视化

- 结语

引言

在机器学习领域,监督学习是一种常见的方法,它依赖于标记好的数据进行训练。但是,有时候我们可能无法获取大量标记好的数据,或者标记数据的成本非常高昂。这时候,非监督学习就成为了一个非常有用的工具。非监督学习是一种从无标签数据中学习数据结构和模式的机器学习方法。

1 非监督学习的概念

在机器学习领域,非监督学习是一种重要的方法,其与监督学习相比,不需要预先标记的输出数据。这使得非监督学习在许多现实场景中具有重要的应用意义。

1.1 非监督学习的定义

非监督学习是一种机器学习方法,其目标是从无标签的数据中学习数据的结构和模式。与监督学习不同,非监督学习不依赖于已知的输出标签,而是通过对数据进行统计分析、聚类或降维等方法来揭示数据的内在结构。

1.2 非监督学习的重要性

非监督学习在数据挖掘、特征提取和模式识别等领域具有广泛的应用。它可以帮助我们发现数据中隐藏的模式和结构,为后续的数据分析和决策提供重要的参考。例如,通过聚类方法可以将相似的数据点归为一类,从而实现对数据集的分组和分类,为后续的数据分析和理解提供便利。

2 聚类问题的定义和意义

2.1 聚类问题的定义

聚类是一种无监督学习任务,其目标是将数据集中的对象划分为若干个组或簇,使得同一组内的对象更加相似,而不同组之间的对象尽可能不同。聚类问题的核心是寻找数据中的内在结构,将相似的数据点归为一类,从而实现对数据的分组和分类。

2.2 聚类问题的意义

聚类问题在数据分析和模式识别中具有重要的应用价值。通过聚类算法可以发现数据集中的潜在规律和结构,帮助我们理解数据的组织方式和特征分布。在实际应用中,聚类可以用于市场细分、社交网络分析、图像分割等领域,为决策和预测提供重要的依据。

2.3 聚类问题在非监督学习中的地位

聚类问题是非监督学习中最重要的任务之一。通过聚类算法可以发现数据集中的内在结构和模式,为后续的数据分析和理解提供重要的参考。各种聚类算法的发展使得非监督学习在实际应用中有着广泛的应用,如K均值聚类、层次聚类和密度聚类等,为数据分析和决策提供了强大的工具和方法。

3 聚类算法介绍

在聚类问题中,有多种算法可供选择,每种算法都有其特定的优缺点和适用场景。下面将介绍三种常用的聚类算法:K均值聚类、层次聚类和密度聚类。

3.1 K均值聚类

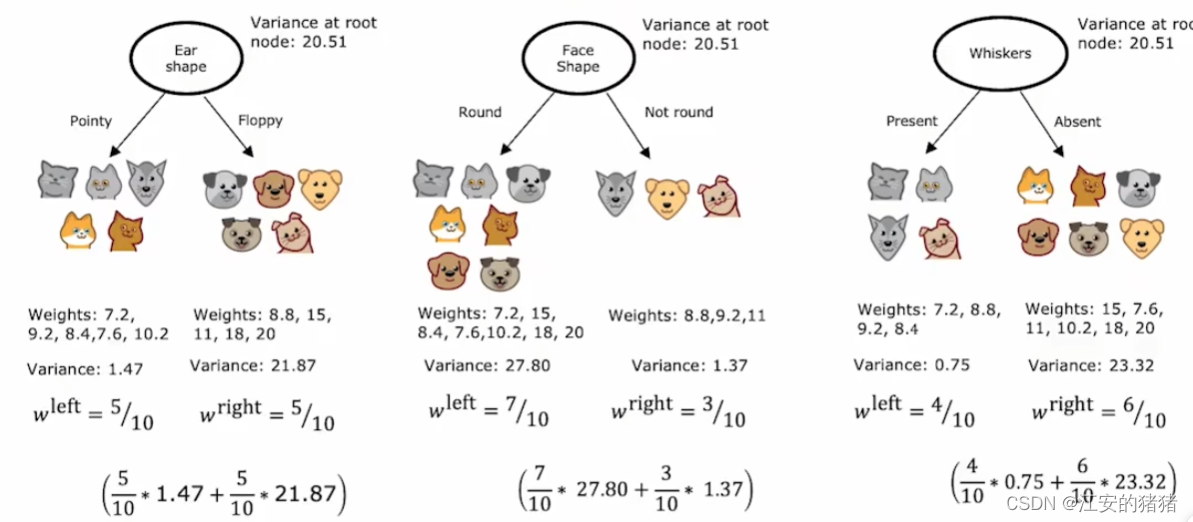

K均值聚类是一种经典的聚类算法,其思想简单且易于实现。该算法将数据点划分为K个簇,使得每个数据点都属于离它最近的簇中心点所代表的簇。

K均值聚类的步骤如下:

1 随机初始化K个簇中心点。

2 将每个数据点分配到离它最近的簇中心点所代表的簇。

3 更新每个簇的中心点,即取簇内所有数据点的均值作为新的簇中心点。

4 重复步骤2和步骤3,直到簇中心点不再发生变化或达到预定的迭代次数。

K均值聚类的优点是算法简单,计算速度快,适用于大规模数据集。然而,K均值聚类对初始簇中心点的选择敏感,可能收敛到局部最优解。

3.2 层次聚类

层次聚类是一种自底向上或自顶向下的聚类方法,通过逐步合并或分裂数据点来构建聚类树,从而形成聚类簇的层次结构。

层次聚类的步骤如下:

1 初始化每个数据点为一个单独的簇。

2 计算两个最近的簇之间的距离,并将其合并成一个新的簇。

3 重复步骤2,直到所有数据点都合并成一个簇或达到预定的聚类数目。

层次聚类的优点是不需要预先指定聚类数目,且可以形成聚类簇的层次结构。然而,层次聚类的计算复杂度较高,在处理大规模数据集时可能效率较低。

3.3 密度聚类

密度聚类算法将聚类看作是数据空间中高密度区域的寻找,通过找到数据密度较高的区域来识别簇。

密度聚类的核心是密度可达性和密度相连性的概念,即数据点周围的密度足够高才能被划分到同一个簇中。

DBSCAN(Density-Based Spatial Clustering of Applications with Noise)是密度聚类算法的一种典型代表。

密度聚类的优点是可以发现任意形状的簇,并且对噪声和异常值具有一定的鲁棒性。然而,密度聚类的参数设置较为敏感,需要进行适当的调参。

这三种聚类算法各有特点,可以根据具体的数据特点和问题需求选择合适的算法进行应用。

4 聚类问题的评估

在应用聚类算法时,评估聚类结果的质量是十分重要的,它可以帮助我们了解聚类效果的好坏以及算法的性能优劣。通常可以采用内部评估指标和外部评估指标来评估聚类结果。

4.1 内部评估指标

内部评估指标用于评估聚类结果的质量,它们不依赖于任何外部信息,只根据数据集本身的特征来进行评估。常用的内部评估指标包括:

-

簇内紧密度(Intra-cluster cohesion):衡量簇内数据点之间的相似度或紧密度,通常是簇内数据点的平均距离或方差。

-

簇间分离度(Inter-cluster separation):衡量不同簇之间的分离程度,通常是簇中心点之间的距离或簇之间的最小距离。

-

轮廓系数(Silhouette Coefficient):综合考虑了簇内的紧密度和簇间的分离度,取值范围在[-1, 1]之间,值越接近1表示聚类结果越好。

4.2 外部评估指标

外部评估指标用于评估聚类结果与真实标签之间的一致性,通常需要事先知道数据集的真实类别信息。常用的外部评估指标包括:

-

兰德指数(Rand Index):用于衡量两个聚类结果的一致性,取值范围在[0, 1]之间,值越接近1表示两个聚类结果越一致。

-

Jaccard系数(Jaccard Coefficient):用于衡量两个聚类结果的相似度,取值范围在[0, 1]之间,值越接近1表示两个聚类结果越相似。

外部评估指标需要使用真实标签信息来计算,因此只有在有真实标签的情况下才能够使用。这些指标可以帮助我们了解聚类结果与真实标签之间的一致性程度,从而评估聚类算法的性能。

通过使用内部评估指标和外部评估指标,我们可以对聚类结果的质量进行全面的评估,从而选择合适的聚类算法并调优参数,以获得更好的聚类效果。

5 聚类问题的挑战与应对方法

在实际应用中,聚类问题面临着各种挑战,包括数据维度灾难、噪声和异常值处理、选择合适的聚类算法、参数选择和调优以及结果可解释性与可视化等方面。

5.1 数据维度灾难

高维数据集可能导致维度灾难问题,使得传统的聚类算法效果不佳。为了解决这一问题,可以采取以下方法:

- 特征选择(Feature Selection):选择与目标相关性较高的特征进行聚类,减少数据维度。

- 降维(Dimensionality Reduction):利用主成分分析(PCA)等技术将高维数据映射到低维空间进行聚类分析。

5.2 噪声和异常值处理

噪声和异常值会对聚类结果产生不良影响,因此需要采取相应的预处理和过滤策略:

- 异常值检测(Outlier Detection):通过统计方法或基于距离的方法检测并移除异常值。

- 数据清洗(Data Cleaning):对数据进行预处理,如平滑、插值或截断等,以减少噪声的影响。

5.3 选择合适的聚类算法

不同的数据集和问题可能适合不同的聚类算法,因此需要根据具体情况进行选择:

- K均值聚类适用于球形或近似球形的簇结构。

- 层次聚类适用于不同尺度的簇结构,且不需要预先指定聚类数目。

- 密度聚类适用于发现任意形状的簇,并对噪声和异常值具有一定的鲁棒性。

5.4 参数选择和调优

聚类算法中通常存在一些参数需要调节,需要通过交叉验证等方法来选择最优参数:

- 网格搜索(Grid Search):通过在参数空间中搜索最优参数组合来寻找最优解。

- 交叉验证(Cross Validation):将数据集分为训练集和验证集,通过在验证集上评估不同参数下的性能来选择最优参数。

5.5 可解释性与可视化

聚类结果的可解释性和可视化对于理解数据结构和模式非常重要:

- 可解释性:通过对聚类结果进行解释,理解簇内数据点的特征和簇间的差异。

- 可视化:利用散点图、热力图等可视化技术将聚类结果可视化,帮助用户直观地理解数据结构和模式。

结语

通过本文的介绍,我们对非监督学习中的聚类问题有了更深入的了解。聚类作为非监督学习中的重要任务,对于理解数据结构、发现模式和提取特征具有重要意义。在实际应用中,我们需要综合考虑不同的聚类算法、评估指标和挑战因素,从而更好地解决实际问题。希望本文能够为读者提供一些有价值的参考和启发,促进非监督学习领域的进一步发展和应用。