文章目录

- 一、现象:

- 二、解决方案

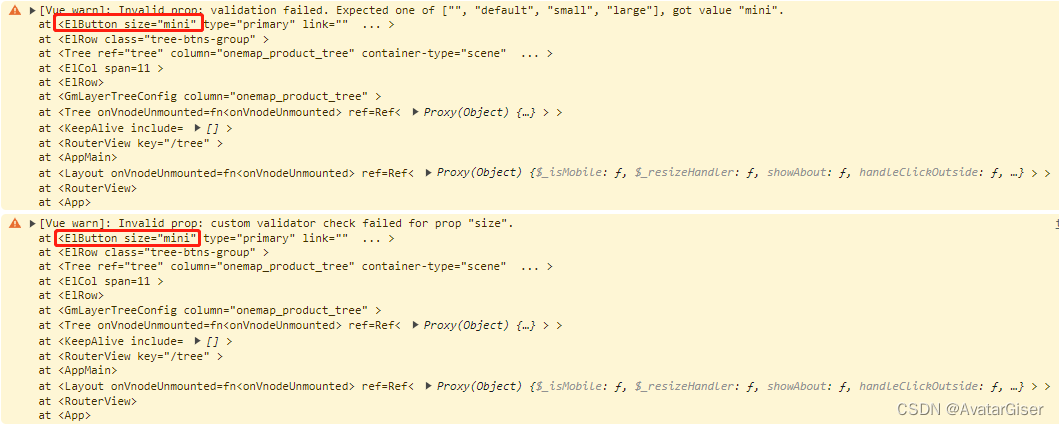

一、现象:

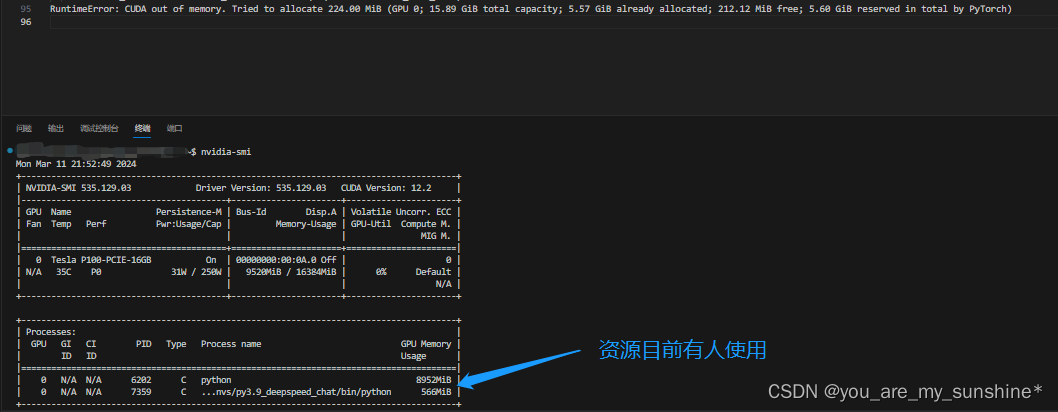

PyTorch深度学习框架,运行bert-mini,本地环境是torch1.4-gpu,发现报错显示:RuntimeError: CUDA out of memory. Tried to allocate 224.00 MiB (GPU 0; 15.89 GiB total capacity; 5.57 GiB already allocated; 212.12 MiB free; 5.60 GiB reserved in total by PyTorch)

二、解决方案

1.用nvidia-smi查看当前资源使用情况,若无人使用,再执行操作;若无人使用,还是报该错误,可以将参数进一步缩小,比如:epochs、batch_size等等。

2.有条件换个更大的资源环境再执行该程序

数据代码参考:阿里云天池

解决方案:网上各种资料尝试一番

![[云原生] K8s之ingress](https://img-blog.csdnimg.cn/direct/e890c936265f44118f20d71509988fd2.png)

![Django用户访问日志记录插件[django_user_visit 2.0]汉化](https://img-blog.csdnimg.cn/direct/f8df6e8e82af49e399b09fc44e39047e.png)