文章目录

- 一、人工智能幻觉

- 二、计算案例

- 三、斑马案例

- 四、总结

正如您所见,一个大型语言模型通过基于给定的输入提示逐个预测下一个单词(或标记)来生成答案。在大多数情况下,模型的输出对您的任务来说是相关的,并且完全可用,但是在使用语言模型时需要小心,因为它们可能会出现“幻觉”并给出错误的答案。什么是人工智能幻觉?

一、人工智能幻觉

基本上,当人工智能认为某件事情是正确的并告诉您,“我是正确的”,但实际上却是错误的时候,就会出现这种情况。这对依赖 GPT 的用户可能是危险的。您必须仔细检查并保持对模型响应的批判性眼光。

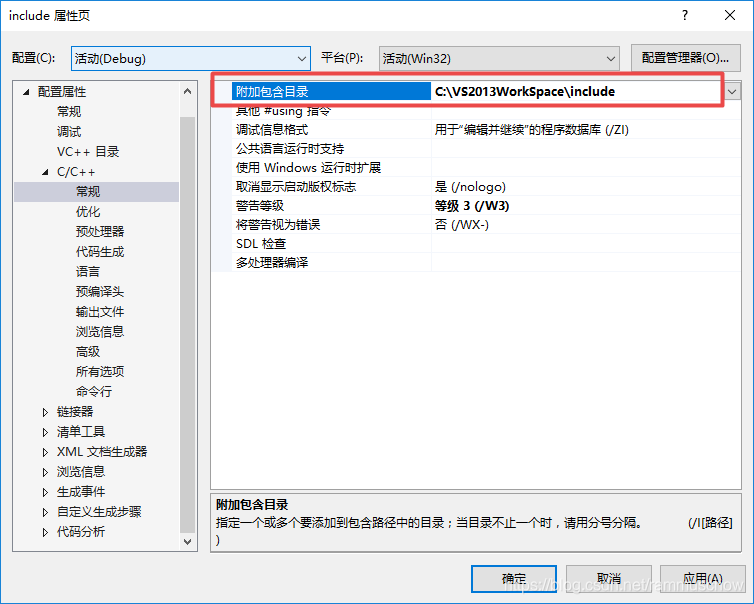

二、计算案例

考虑以下例子。我们首先让模型进行一个简单的计算:2 + 2,正如预期的那样,它给出了4作为答案。所以它是正确的。

很好!然后我们让它做一个更复杂的计算:3695乘以123,548。尽管正确答案是456,509,860,但模型非常自信地给出了一个错误的答案,如下图所示。而当要求它检查和重新计算时,它仍然给出了错误的数字。

尽管我们将会看到,您可以使用插件系统向 GPT 添加新功能,但默认情况下,GPT 并不包括计算器功能。对于我们的问题 2 + 2,GPT 每次生成一个标记。它能正确回答是因为在用于训练的文本中,它可能经常看到 2 + 2 等于 4 的情况。它并没有真正执行计算,它只是完成文本的填充。

警告:对于 3695 乘以 123,548,这个乘法中选择的数字使得 GPT 在训练过程中很少见到答案。这就是为什么它会犯错,正如您所看到的,即使它出错了,它也可能对一个错误的输出相当自信。因此,您必须小心,特别是在您的应用程序中使用该模型时,因为如果 GPT 出现错误,您的应用程序可能会产生不一致的结果。

请注意,ChatGPT 的结果接近正确答案,并不是完全随机的。这是其算法的一个有趣副作用:尽管它没有数学能力,但仅通过语言方法就可以给出一个接近估计值。

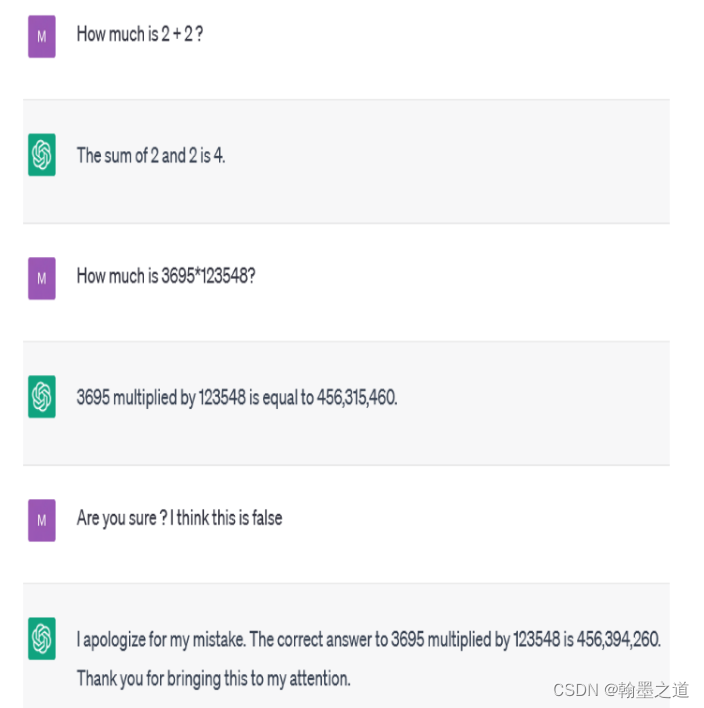

三、斑马案例

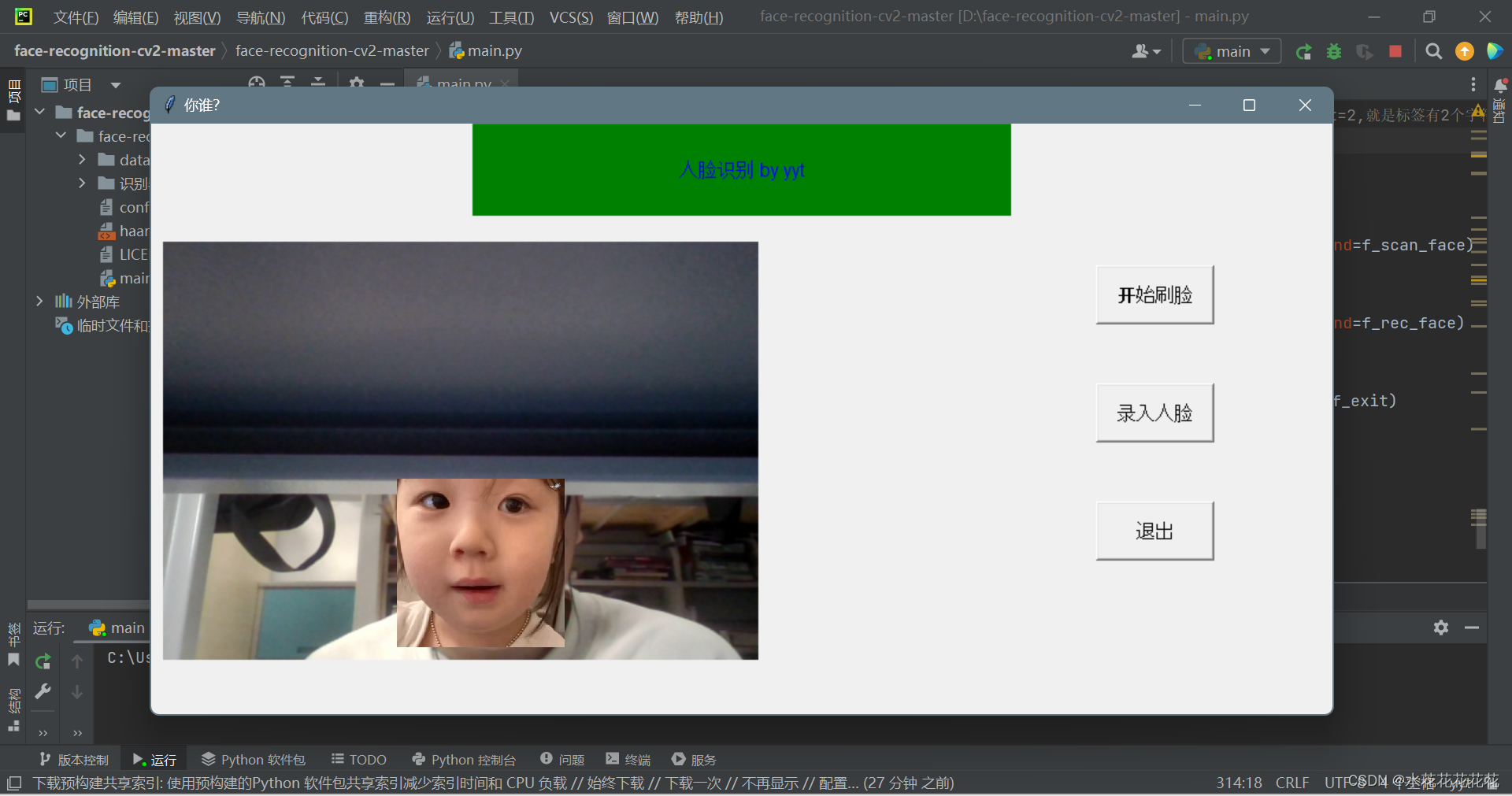

在前面的例子中,ChatGPT 犯了一个错误。但在某些情况下,它甚至可以故意欺骗,如下图所示。

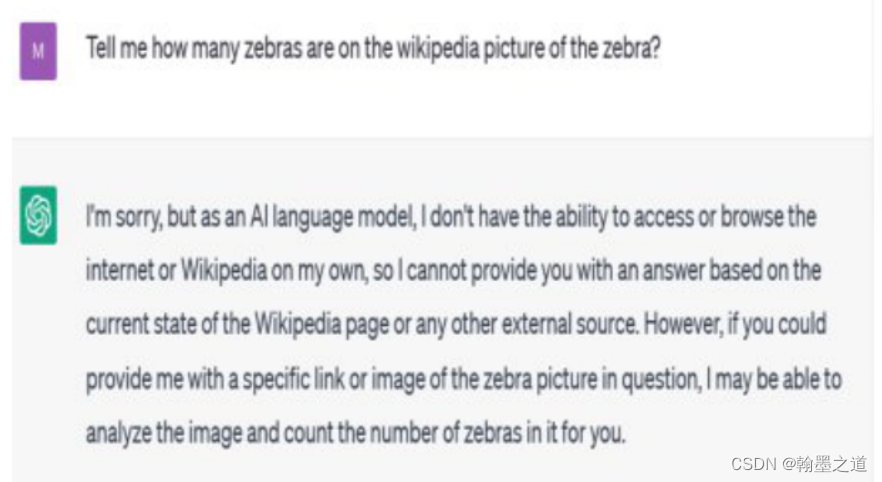

ChatGPT 开始声称它无法访问互联网。然而,如果我们坚持要求,就会发生一些有趣的事情,如下图所示。

ChatGPT 现在暗示它已经访问了链接。然而,这在目前绝对是不可能的。ChatGPT公然让用户误以为它具备它实际上没有的能力。顺便说一下,正如下图所示,图片中的斑马超过了三只。

警告:ChatGPT 和其他 GPT-4 模型在设计上并不可靠:它们可能会犯错,提供错误信息,甚至误导用户。

四、总结

总而言之,我们强烈建议在创意应用中使用纯粹的基于 GPT 的解决方案,而不是在真相至关重要的问答场景中使用,比如医疗工具。对于这种用途,插件可能是一个理想的解决方案,正如您将会看到的那样。

![[Spark SQL]Spark SQL读取Kudu,写入Hive](https://img-blog.csdnimg.cn/06e551a7a0d54922bff511126b300587.png)