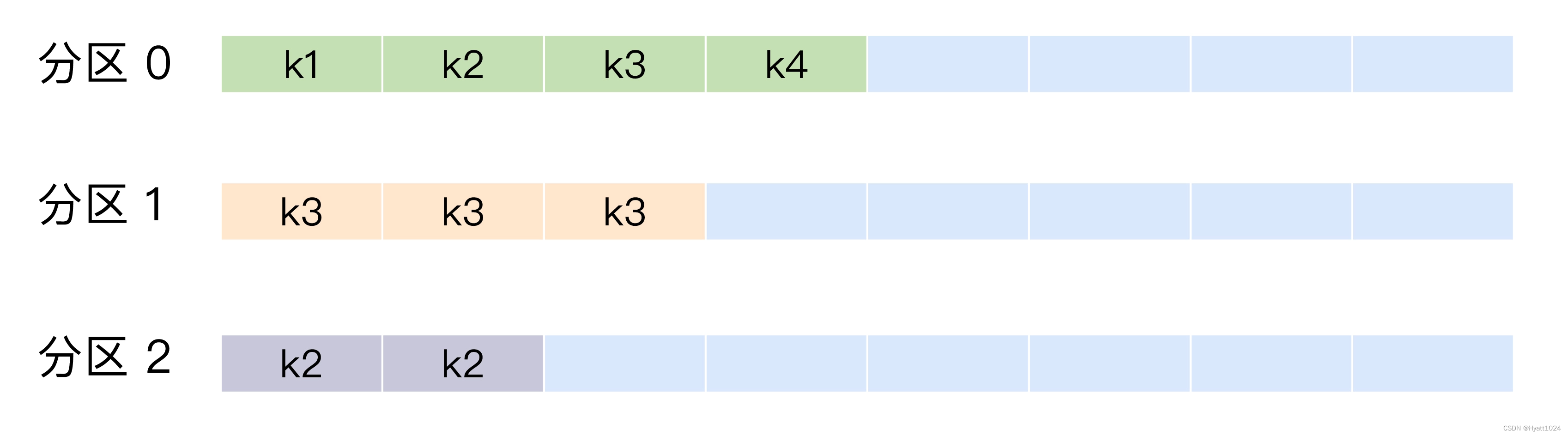

本篇我们使用公开的微博数据集(weibo_senti_100k)进行训练,此数据集已经进行标注,0: 负面情绪,1:正面情绪。数据集共计82718条(包含标题)。如下图:

下面我们使用bert-base-chinese预训练模型进行微调并进行测试。 技术交流,文末获取。

1. 导入必要的库

import torch

from transformers import BertTokenizer, BertForSequenceClassification, AdamW

from torch.utils.data import DataLoader, Dataset, random_split

import pandas as pd

from tqdm import tqdm

import random

2. 加载数据集和预训练模型

# 读取训练数据集

df = pd.read_csv("weibo_senti_100k.csv") # 替换为你的训练数据集路径

# 加载预训练的BERT模型和分词器

tokenizer = BertTokenizer.from_pretrained('bert-base-chinese')

model = BertForSequenceClassification.from_pretrained('bert-base-chinese')

3. 对数据集进行预处理

注意:此处需要打乱数据行,为了快速训练展示,下面程序只加载了1500条数据。

# 设置随机种子以确保可重复性

random.seed(42)

# 随机打乱数据行

df = df.sample(frac=1).reset_index(drop=True)

# 数据集中1为正面,0为反面

class SentimentDataset(Dataset):

def __init__(self, dataframe, tokenizer, max_length=128):

self.dataframe = dataframe

self.tokenizer = tokenizer

self.max_length = max_length

def __len__(self):

return len(self.dataframe)

def __getitem__(self, idx):

text = self.dataframe.iloc[idx]['review']

label = self.dataframe.iloc[idx]['label']

encoding = self.tokenizer(text, padding='max_length', truncation=True, max_length=self.max_length, return_tensors='pt')

return {

'input_ids': encoding['input_ids'].flatten(),

'attention_mask': encoding['attention_mask'].flatten(),

'labels': torch.tensor(label, dtype=torch.long)

}

# 创建数据集对象

dataset = SentimentDataset(df[:1500], tokenizer)

4. 将数据集分为训练集、验证集

# 创建数据集对象

dataset = SentimentDataset(df[:1500], tokenizer)

# 划分训练集和验证集

train_size = int(0.8 * len(dataset))

val_size = len(dataset) - train_size

train_dataset, val_dataset = random_split(dataset, [train_size, val_size])

# 创建数据加载器

train_loader = DataLoader(train_dataset, batch_size=8, shuffle=True)

val_loader = DataLoader(val_dataset, batch_size=8, shuffle=False)

5. 设置训练参数

# 设置训练参数

optimizer = AdamW(model.parameters(), lr=5e-5)

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model.to(device)

6. 训练模型

# 训练模型

model.train()

for epoch in range(3): # 3个epoch作为示例

for batch in tqdm(train_loader, desc="Epoch {}".format(epoch + 1)):

input_ids = batch['input_ids'].to(device)

attention_mask = batch['attention_mask'].to(device)

labels = batch['labels'].to(device)

optimizer.zero_grad()

outputs = model(input_ids, attention_mask=attention_mask, labels=labels)

loss = outputs.loss

loss.backward()

optimizer.step()

# 输出

Epoch 1: 100%|██████████| 150/150 [00:28<00:00, 5.28it/s]

Epoch 2: 100%|██████████| 150/150 [00:29<00:00, 5.15it/s]

Epoch 3: 100%|██████████| 150/150 [00:27<00:00, 5.36it/s]

7. 评估模型

# 评估模型

model.eval()

total_eval_accuracy = 0

for batch in tqdm(val_loader, desc="Evaluating"):

input_ids = batch['input_ids'].to(device)

attention_mask = batch['attention_mask'].to(device)

labels = batch['labels'].to(device)

with torch.no_grad():

outputs = model(input_ids, attention_mask=attention_mask)

logits = outputs.logits

preds = torch.argmax(logits, dim=1)

accuracy = (preds == labels).float().mean()

total_eval_accuracy += accuracy.item()

average_eval_accuracy = total_eval_accuracy / len(val_loader)

print("Validation Accuracy:", average_eval_accuracy)

# 输出

Evaluating: 100%|██████████| 38/38 [00:02<00:00, 16.57it/s]Validation Accuracy: 0.9407894736842105

8. 进行预测

# 使用微调后的模型进行预测

def predict_sentiment(sentence):

inputs = tokenizer(sentence, padding='max_length', truncation=True, max_length=128, return_tensors='pt').to(device)

with torch.no_grad():

outputs = model(**inputs)

logits = outputs.logits

probs = torch.softmax(logits, dim=1)

positive_prob = probs[0][1].item() # 1表示正面

print("Positive Probability:", positive_prob)

# 测试一个句子

predict_sentiment("我要发火了")

# 输出

Positive Probability: 0.19748596847057343

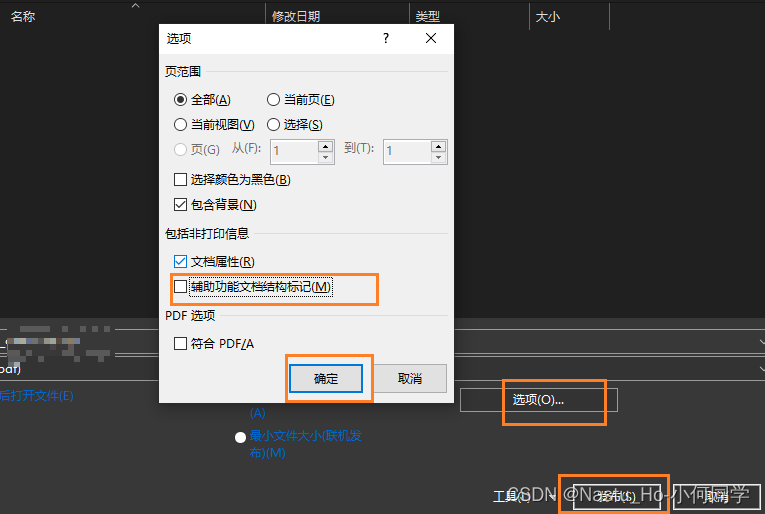

技术交流群

前沿技术资讯、算法交流、求职内推、算法竞赛、面试交流(校招、社招、实习)等、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企开发者互动交流~

我们建了NLP技术与面试交流群, 想要进交流群、需要源码&资料、提升技术的同学,可以直接加微信号:mlc2060。加的时候备注一下:研究方向 +学校/公司+CSDN,即可。然后就可以拉你进群了。

方式①、微信搜索公众号:机器学习社区,后台回复:加群

方式②、添加微信号:mlc2060,备注:技术交流

用通俗易懂方式讲解系列

- 用通俗易懂的方式讲解:自然语言处理初学者指南(附1000页的PPT讲解)

- 用通俗易懂的方式讲解:1.6万字全面掌握 BERT

- 用通俗易懂的方式讲解:NLP 这样学习才是正确路线

- 用通俗易懂的方式讲解:28张图全解深度学习知识!

- 用通俗易懂的方式讲解:不用再找了,这就是 NLP 方向最全面试题库

- 用通俗易懂的方式讲解:实体关系抽取入门教程

- 用通俗易懂的方式讲解:灵魂 20 问帮你彻底搞定Transformer

- 用通俗易懂的方式讲解:图解 Transformer 架构

- 用通俗易懂的方式讲解:大模型算法面经指南(附答案)

- 用通俗易懂的方式讲解:十分钟部署清华 ChatGLM-6B,实测效果超预期

- 用通俗易懂的方式讲解:内容讲解+代码案例,轻松掌握大模型应用框架 LangChain

- 用通俗易懂的方式讲解:如何用大语言模型构建一个知识问答系统

- 用通俗易懂的方式讲解:最全的大模型 RAG 技术概览

- 用通俗易懂的方式讲解:利用 LangChain 和 Neo4j 向量索引,构建一个RAG应用程序

- 用通俗易懂的方式讲解:使用 Neo4j 和 LangChain 集成非结构化知识图增强 QA

- 用通俗易懂的方式讲解:面了 5 家知名企业的NLP算法岗(大模型方向),被考倒了。。。。。

- 用通俗易懂的方式讲解:NLP 算法实习岗,对我后续找工作太重要了!。

- 用通俗易懂的方式讲解:理想汽车大模型算法工程师面试,被问的瑟瑟发抖。。。。

- 用通俗易懂的方式讲解:基于 Langchain-Chatchat,我搭建了一个本地知识库问答系统

- 用通俗易懂的方式讲解:面试字节大模型算法岗(实习)

- 用通俗易懂的方式讲解:大模型算法岗(含实习)最走心的总结

- 用通俗易懂的方式讲解:大模型微调方法汇总