01 知识点:特征归一化(第一章 特征工程)

摘要:

为什么需要对数值类型的特征做归一化?

简要回答:对数值类型的特征做归一化,使得各指标除以同一个数量级,以便进行分析。

场景描述

为了消除数据特征之间的量纲影响,我们需要对特征进行归一化处理,使得不同指标之间具有可比性。

example:

分析一个人的身高和体重对健康的影响,如果使用米(m)和千克(kg)作为单位,那么身高特征会在1.6 ~ 1.8m的数值范围内,体重特征会在50 ~ 100kg的范围内,分析出来的结果显然会倾向于数值差别比较大的体重特征。想要得到更为准确的结果,就需要进行**特征归一化(Normalization)**处理,使各指标处于同一数值量级,以便进行分析。

问题:为什么需要对数值类型的特征做归一化?(难度:1颗星)

分析与解答

目的:对数值类型的特征做归一化可以将所有的特征都统一到一个大致相同的数值区间内。

最常用的方法:主要有以下两种。

- 线性函数归一化(Min-Max Scaling)

它对原始数据进行线性变换,使结果映射到[0,1]的范围,实现对原始数据的等比缩放。归一化公式如下

X

n

o

r

m

=

(

X

−

X

m

i

n

)

/

(

X

m

a

x

−

X

m

i

n

)

Xnorm=(X-Xmin)/(Xmax-Xmin)

Xnorm=(X−Xmin)/(Xmax−Xmin)

其中X为原始数据,Xmax、Xmin分别为数据最大值和最小值。

-

零均值归一化(Z-Score Normalization)

它会将原始数据映射到均值为0、标准差为1的分布上。

具体来说,假设原始特征的均值为μ、标准差为σ,那么归一化公式定义为

z = ( x − μ ) / σ z=(x-\mu)/\sigma z=(x−μ)/σ

重要性:

我们不妨借助随机梯度下降的实例来说明归一化的重要性。

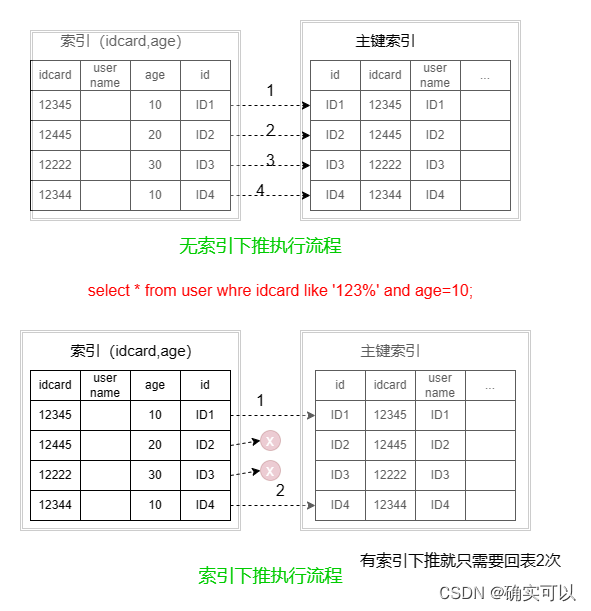

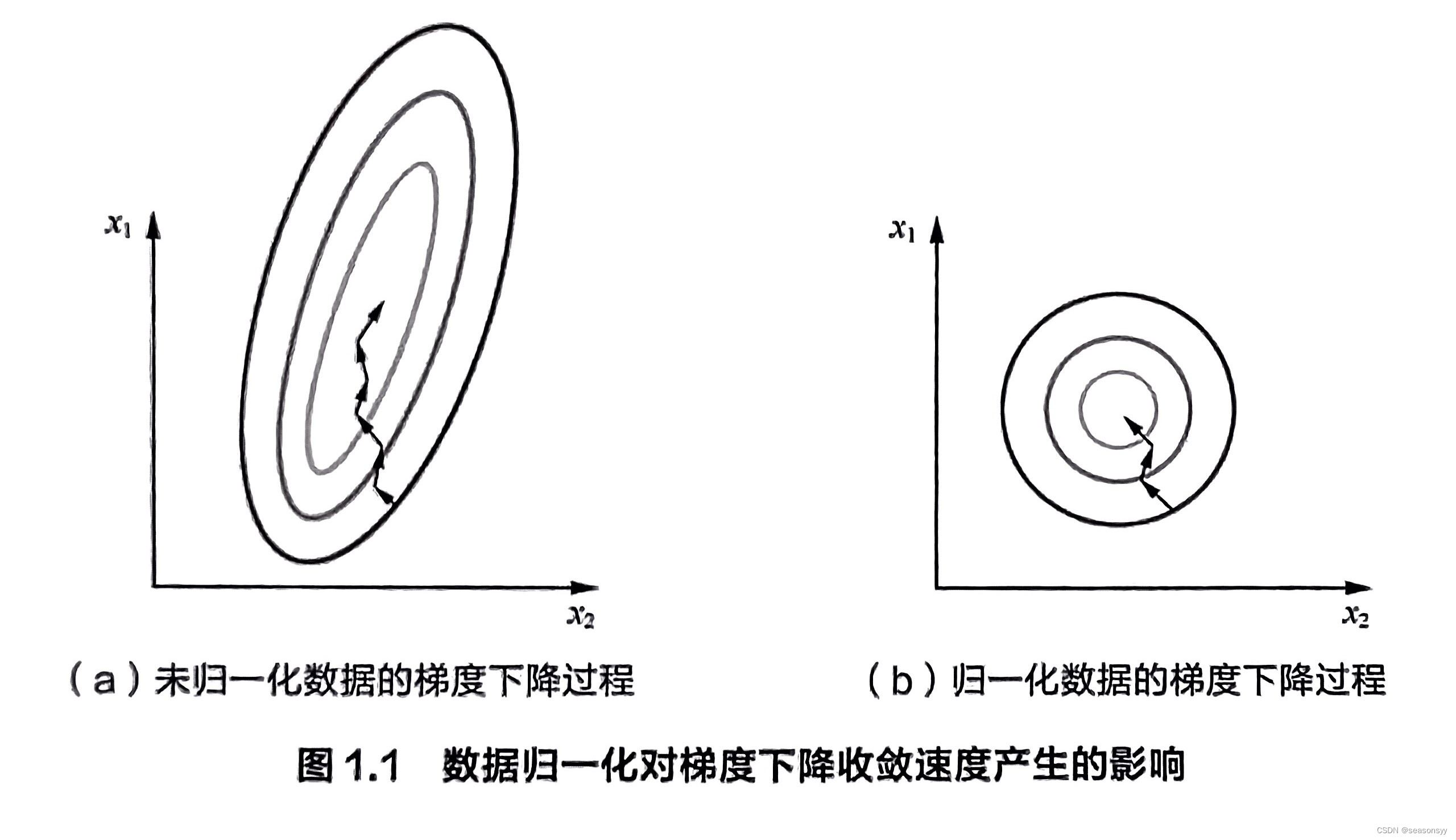

假设有两种数值型特征,x₁的取值范围为[0,10],x₂的取值范围为[0,3],于是可以构造一个目标函数符合图1.1(a)中的等值图。

在学习速率相同的情况下,x₁的更新速度会大于x₂,需要较多的迭代才能找到最优解。如果将x₁和x₂归一化到相同的数值区间后,优化目标的等值图会变成图1.1(b)中的圆形,x₁和x₂的更新速度变得更为一致,容易更快地通过梯度下降找到最优解。

当然,数据归一化并不是万能的。在实际应用中,通过梯度下降法求解的模型通常是需要归一化的,包括线性回归、逻辑回归、支持向量机、神经网络等模型。

但对于决策树模型则并不适用,以C4.5为例,决策树在进行节点分裂时主要依据数据集D关于特征x的信息增益比(详见第3章第3节),而信息增益比跟特征是否经过归一化是无关的,因为归一化并不会改变样本在特征x上的信息增益。

参考文献:

《百面机器学习》 诸葛越主编

出版社:人民邮电出版社(北京)

ISBN:978-7-115-48736-0

2022年1月北京第19次印刷