本文首发:AIWalker,欢迎关注~~

殊途同归!SAM轻量化的终点竟然是RepViT + SAM,移动端速度可达38.7fps。

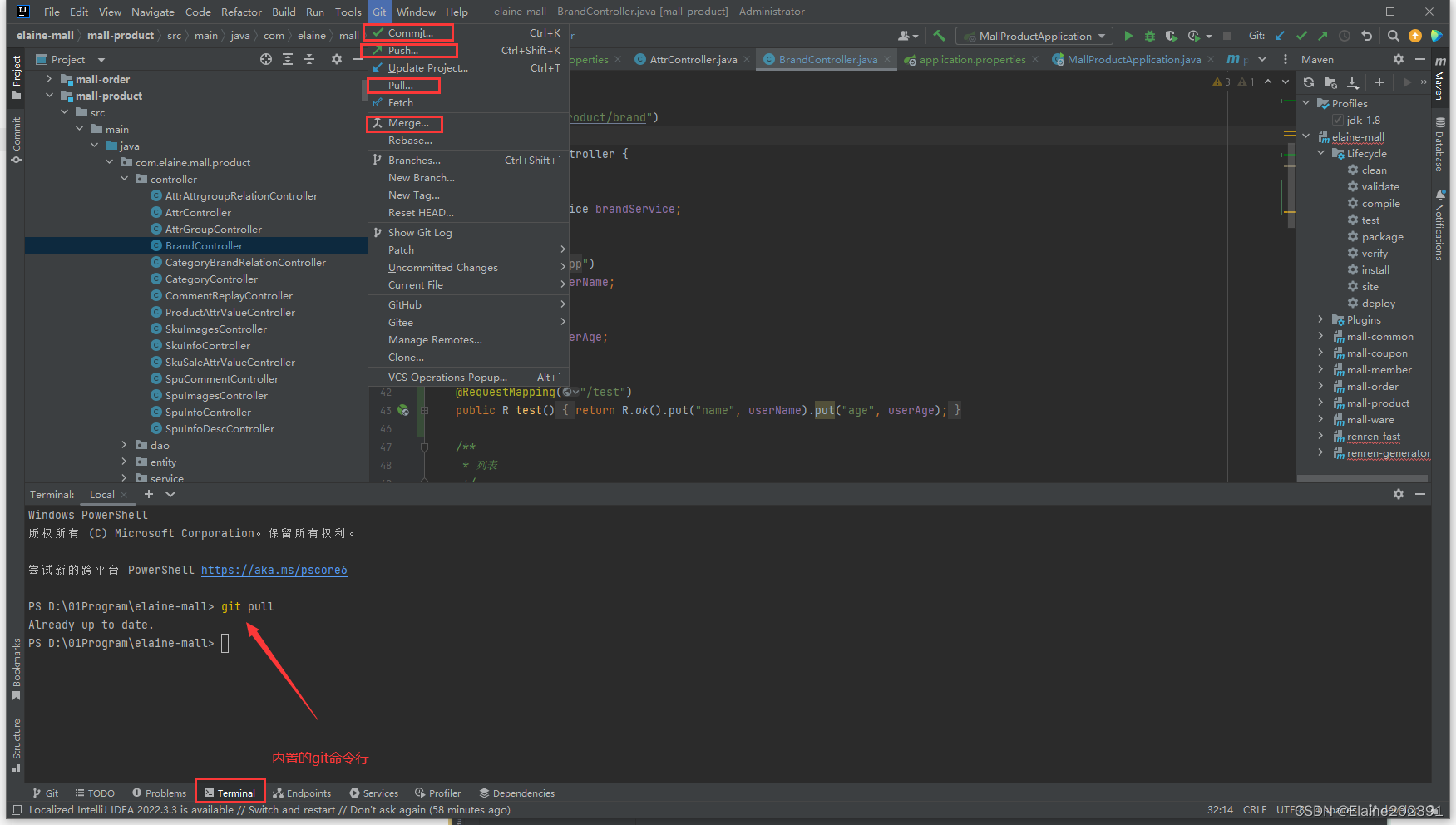

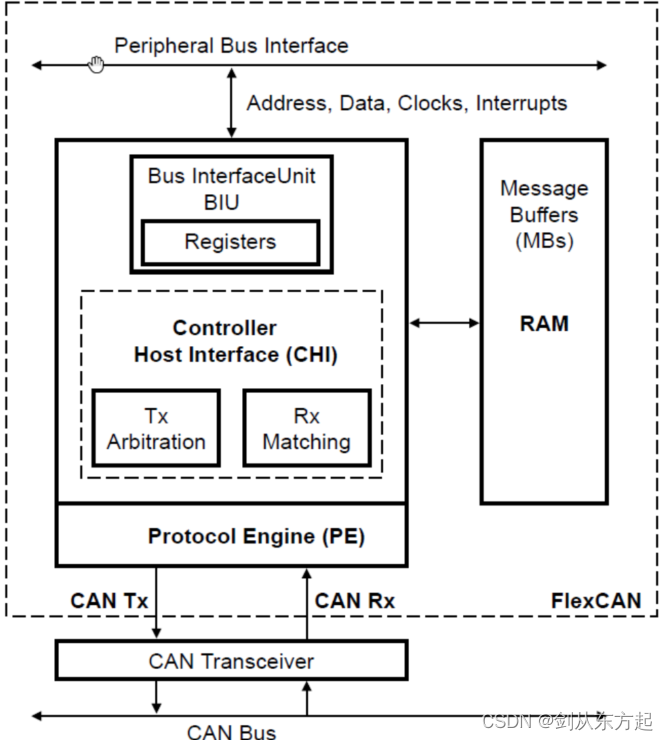

对于 2023 年的计算机视觉领域来说,「分割一切」(Segment Anything Model)是备受关注的一项研究进展。尽管SAM具有各种优势,但速度慢是其不得不提的一个缺点,端侧根本就跑不动。研究者们也提出了一些改进策略:将默认 ViT-H 图像编码器中的知识提炼到一个微小的 ViT 图像编码器中,或者使用基于 CNN 的实时架构降低用于 Segment Anything 任务的计算成本。

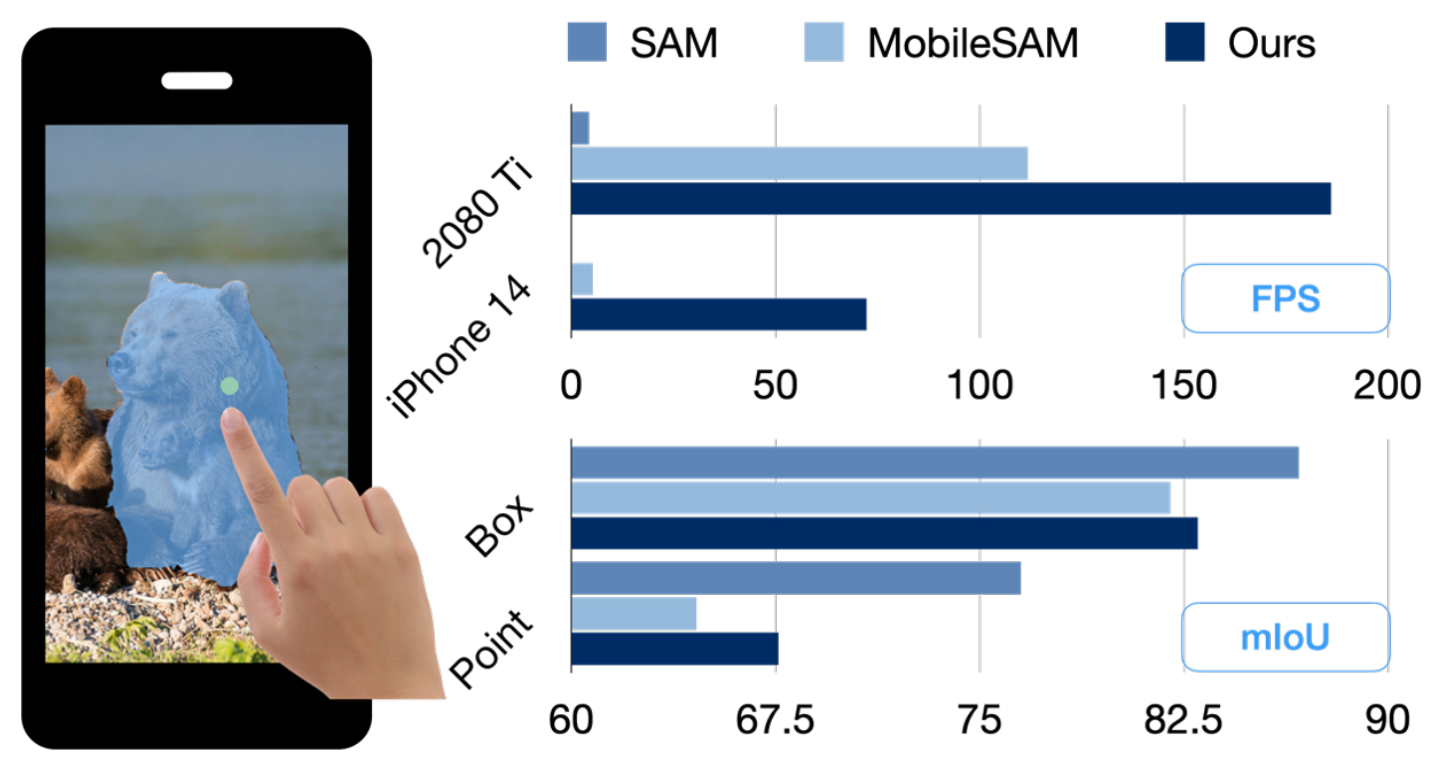

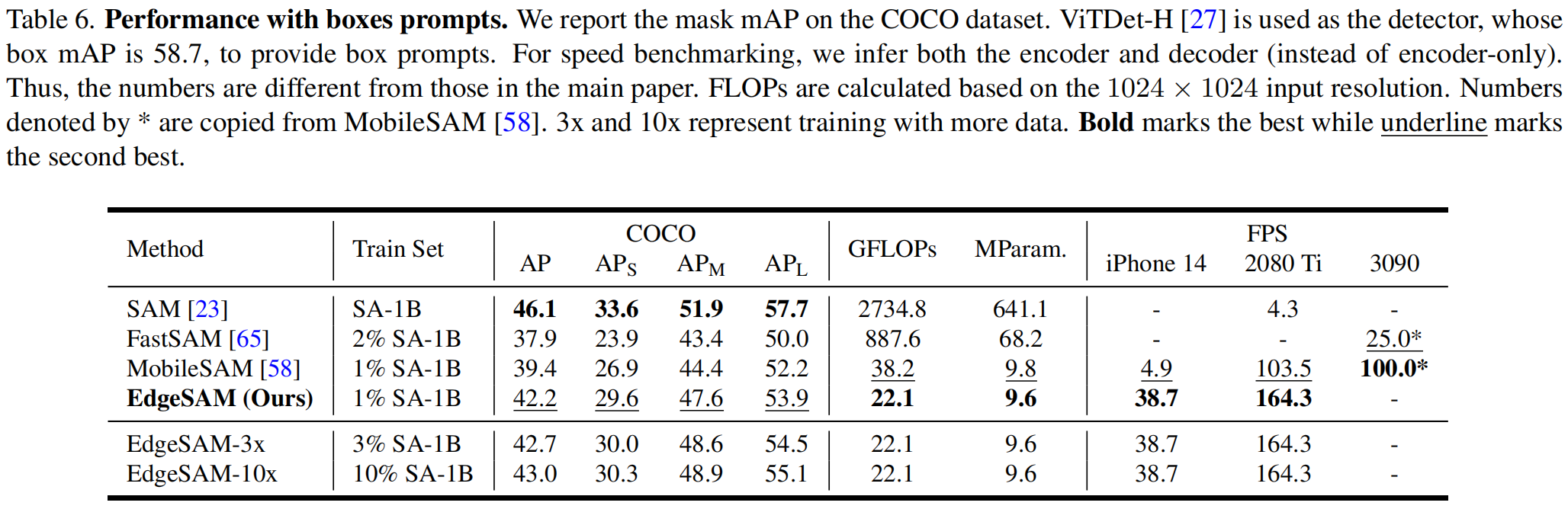

就在今日,arXiv上同时公开两篇SAM轻量化的方法EdgeSAM、RepViT-SAM,更巧合的是两者采用了完全相同的Image Encoder模块:RepViT;两者也都在手机端能以超快的速度进行任意分割,值得一提的是:EdgeSAM能在iphone14手机上达到38.7fps的处理速度。

https://arxiv.org/abs/2312.05760

https://github.com/THU-MIG/RepViT

在AIWalker后台回复【RepViT-SAM】即可下载原文与中文译文

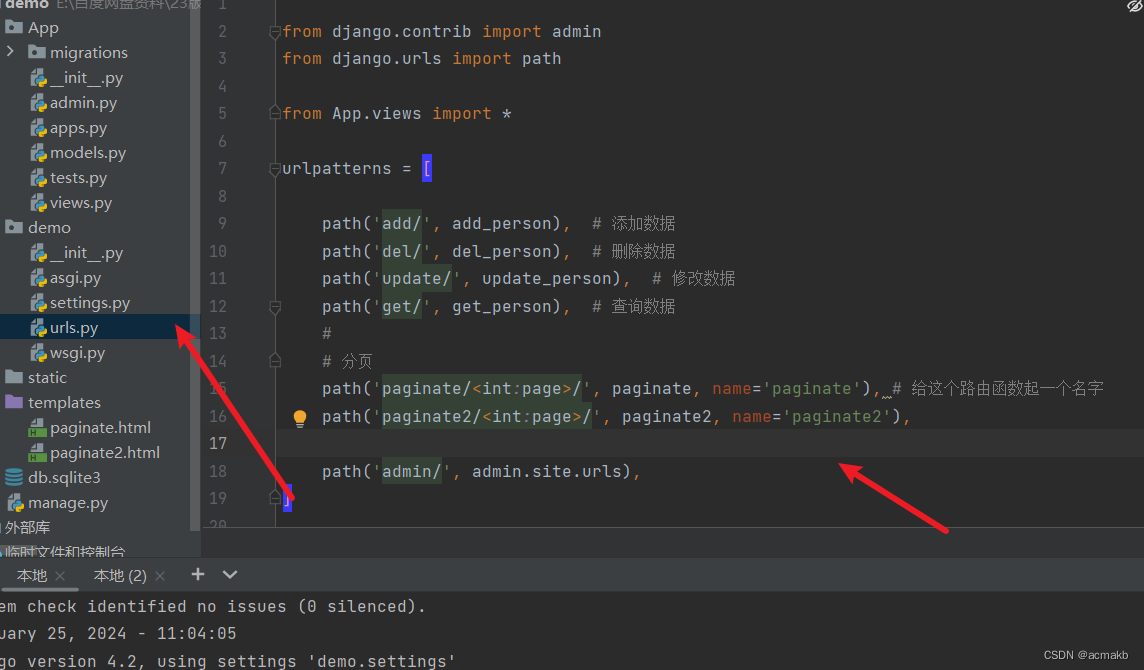

该方案延续了MobileSAM的处理方式,即采用原生SAM的ViT Encoder模块对所替换的Encoder模块进行知识蒸馏。

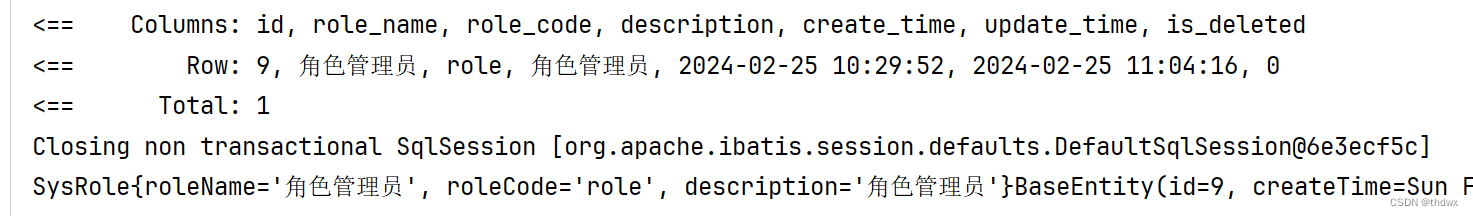

- 在实现方面,RepViT-SAM引入了移动端新秀RepViT的RepViT-M2.3作为图像编码器提取图像特征;

- 在老师模型方面,它选用了SAM-ViT-H版本进行蒸馏。

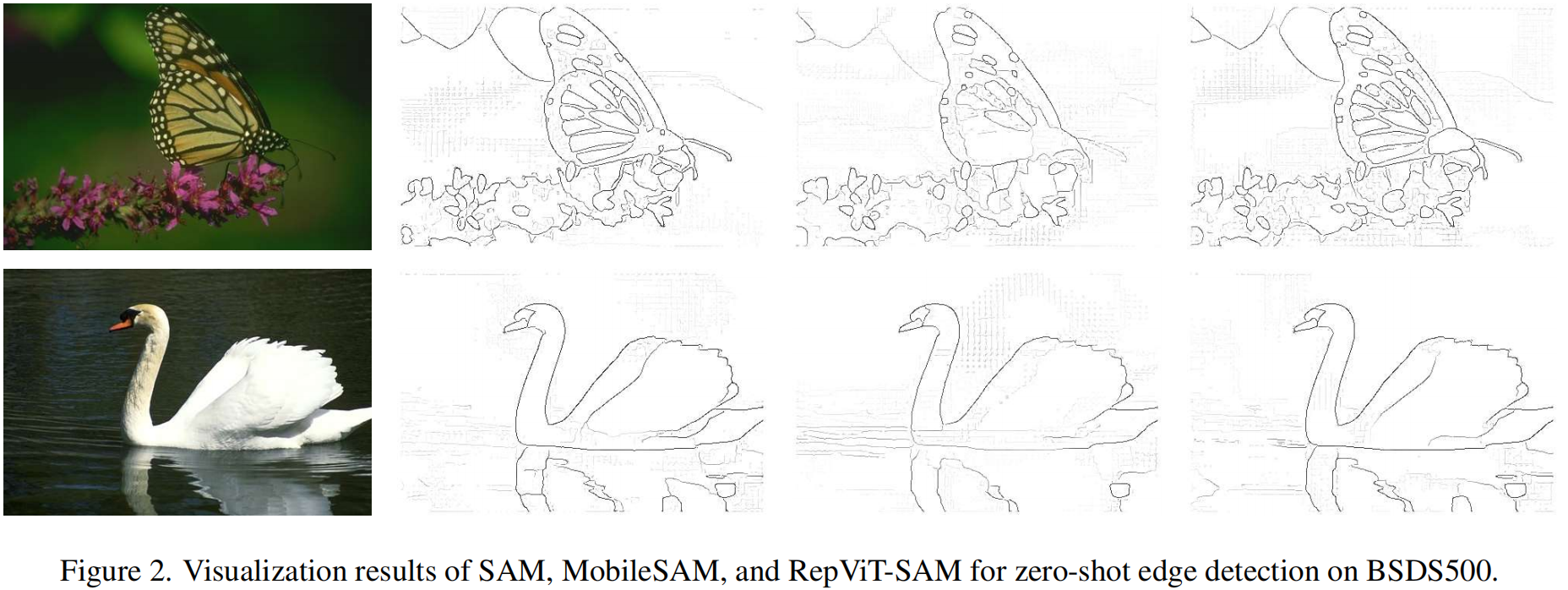

- 在应用方面,该方案进行了多种任务适配,如Mask预测、边缘检测等。

https://arxiv.org/abs/2312.06660

https://github.com/chongzhou96/EdgeSAM

在AIWalker后台回复【EdgeSAM】即可下载原文与中文译文

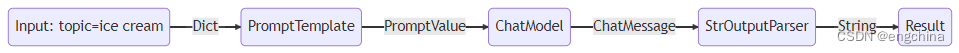

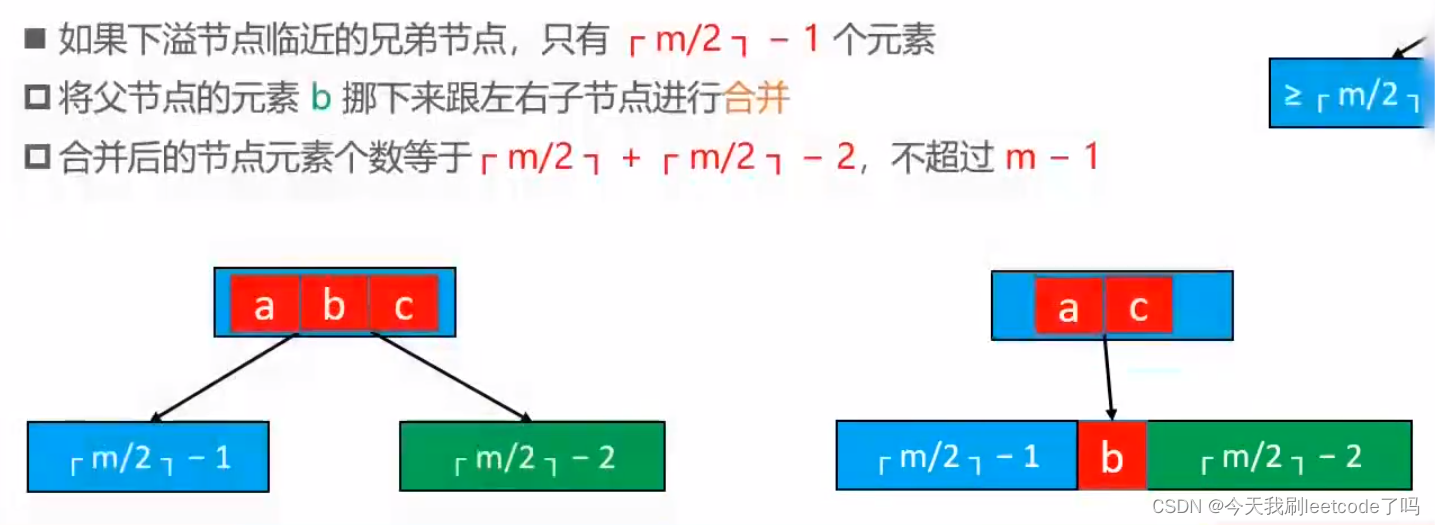

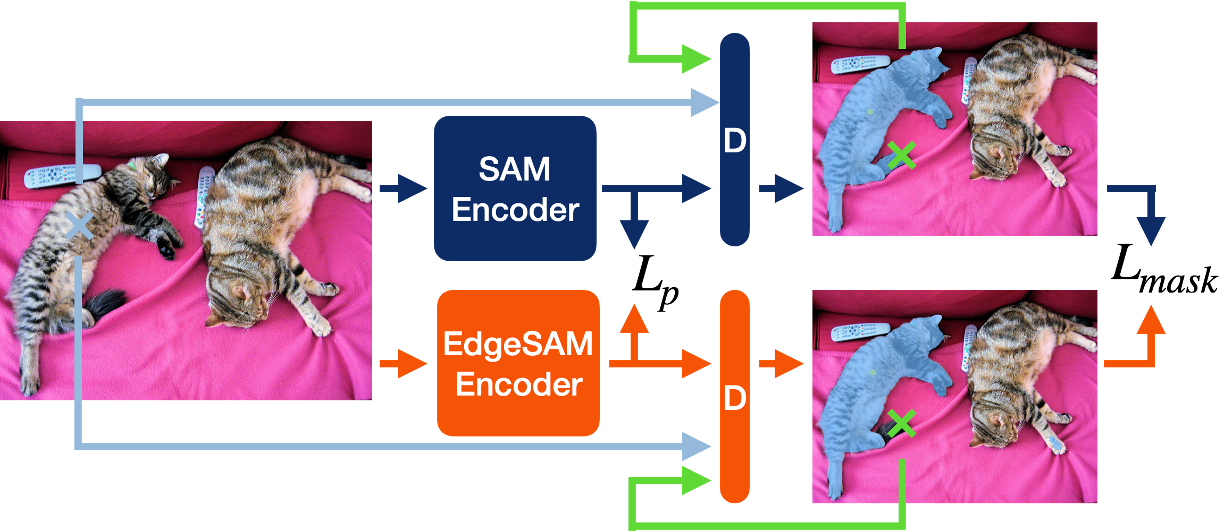

相比而言,EdgeSAM方法上会显得更优异:它并非仅仅参考MobileSAM进行了Image Encoder的蒸馏,还仔细分析了不同蒸馏策略并证实:任务不可知的编码器蒸馏难以学习到SAM所具备的全部知识。

有鉴于此,作者提出:循环使用bbox与point提示词,同时对提示词编码器与Mak解码器进行蒸馏,以便于蒸馏模型能够准确的学习到提示词与Mask之间的复杂关系。

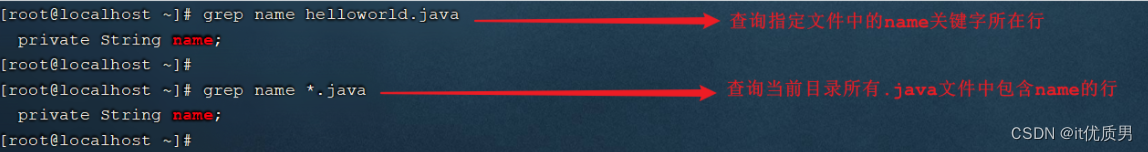

- 在2080Ti上,相比原生SAM,EdgeSAM推理速度快40倍;

- 在iPhone14上,相比MobileSAM,EdgeSAM推理速度快14倍,达到了38.7fps。

在AIWalker后台回复:【EdgeSAM】,即可下载原文与中文译本;

在AIWalker后台回复【RepViT-SAM】即可下载原文与中文译本。

推荐阅读

- RepViT: 从ViT角度重新审视轻量级CNN移动端架构

- EfficientSAM | 借助MIM机制,MetaAI让SAM更高效!

- FastSAM:基于CNN的SAM任务解决方案,速度提升50倍!

- MobileSAM | 让SAM再快一点!处理一张图像仅需10ms

- NanoSAM:让您在Jetson Orin上享受实时分割的卓越体验

- 实践教程|硬核详解SAM TensorRT模型转换