目录

🐶🐶1.摘要

🐭🐭 2.设计动机

🐹🐹 3.区域残差和语义残差

🐰🐰 4.Dilation-wise Residual和Simple Inverted Residual

🍃 4.1DWR

🍂 4.2SIR

🐺🐺5.网络整体结构

🌿 5.1整体结构

🍄 5.2Stem block

🌵5.3解码器

🐸🐸 6.实验

🌴 6.1不同膨胀率参数在不同网络阶段表现

🌲 6.2不同参数结果对比

🌰 6.3Citysacpes数据集上不同方法结果对比

🌼6.4CamVid数据集上不同方法结果对比

整理不易,欢迎一键三连!!!

送你们一条美丽的--分割线--

👉题目:重新思考高效获取多尺度上下文信息以进行实时语义分割

👉论文:paper

👉代码:未开源

最近在看的一些小而精的创新点,所以有的论文是没有开源代码的,主要是体会作者的创新点思维,看看能不能为我所用。后续若开源,会持续更新开源代码地址,请持续关注。

🐶🐶1.摘要

Many current works directly adopt multi-rate depth-wise dilated convolutions to capture multi-scale contextual information simultaneously from one input feature map, thus improving the feature extraction efficiency for real-time semantic segmentation. However, this design may lead to difficult access to multi-scale contextual information because of the unreasonable structure and hyperparameters. To lower the difficulty of drawing multi-scale contextual information, we propose a highly efficient multi-scale feature extraction method, which decomposes the original single-step method into two steps, Region Residualization-Semantic Residualization. In this method, the multi-rate depth-wise dilated convolutions take a simpler role in feature extraction: performing simple semantic-based morphological filtering with one desired receptive field in the second step based on each concise feature map of region form provided by the first step, to improve their efficiency. Moreover, the dilation rates and the capacity of dilated convolutions foreach network stage are elaborated to fully utilize all the feature maps of region form that can be achieved. Accordingly, we design a novel Dilation-wise Residual (DWR) module and a Simple Inverted Residual (SIR) module for the high and low level network, respectively, and form a powerful DWR Segmentation (DWRSeg) network. Extensive experiments on the Cityscapes and CamVid datasets demonstrate the effectiveness of our method by achieving a state-of-theart trade-off between accuracy and inference speed, in addition to being lighter weight. Without pretraining or resorting to any training trick, we achieve an mIoU of 72.7% on the Cityscapes test set at a speed of 319.5 FPS on one NVIDIA GeForce GTX 1080 Ti card, which exceeds the latest methods of a speed of 69.5 FPS and 0.8% mIoU. The code and trained models are publicly available.

当前的许多工作直接采用多尺度深度扩张卷积从一个输入特征图中同时捕获多尺度上下文信息,从而提高实时语义分割的特征提取效率。 然而,这种设计可能会因为结构和超参数的不合理而导致多尺度上下文信息的访问困难。 为了降低绘制多尺度上下文信息的难度,我们提出了一种高效的多尺度特征提取方法,该方法将原始的单步特征提取方法分为两个步骤,区域残差-语义残差。 在该方法中,多尺度深度扩张卷积在特征提取中发挥更简单的作用:根据第一步提供的每个简明区域形式特征图,在第二步中使用一个所需的感受野执行简单的基于语义的形态过滤 ,提高他们的效率。 此外,每个网络阶段的扩张率和扩张卷积的容量都经过精心设计,以充分利用所有可以实现的区域形式的特征图。 因此,我们分别为高层和低层网络设计了一种新颖的扩张式残差(DWR)模块和简单倒置残差(SIR)模块,并形成了强大的DWR分段(DWRSeg)网络。 对 Cityscapes 和 CamVid 数据集的大量实验表明:除了权重更轻之外,我们的方法还通过在准确性和推理速度之间实现最先进的权衡来提高其有效性。 在不进行预训练或采用任何训练技巧的情况下,我们在 Cityscapes 测试集上以 319.5 FPS 的速度在一张 NVIDIA GeForce GTX 1080 Ti 卡上实现了 72.7% 的 mIoU,超过了最新方法的 69.5 FPS 和 0.8% miou。 代码和经过训练的模型是公开的。

ps:虽然摘要里说了模型和代码是公开的,却没有给出链接,有找到源码的同学请分享,谢谢啦~~~

🐭🐭 2.设计动机

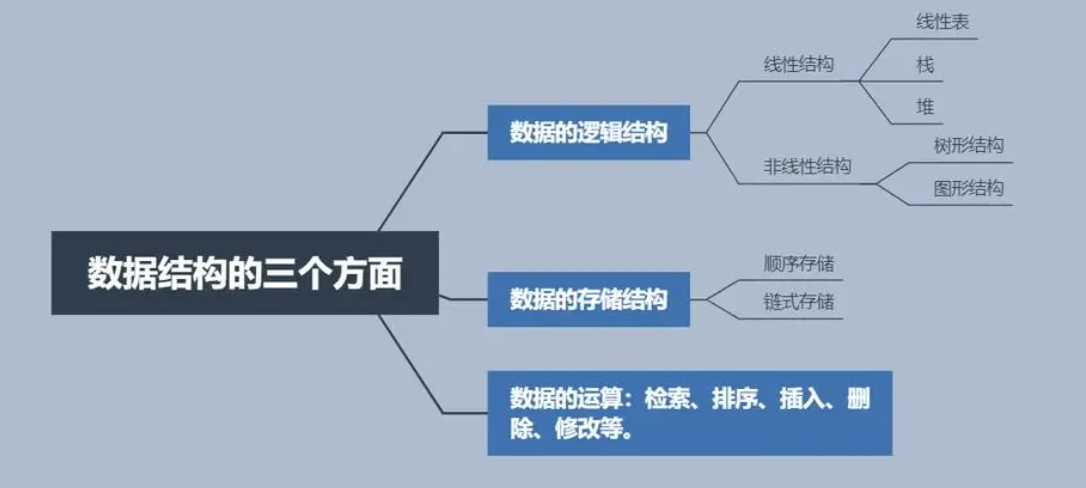

本文的设计动机主要来自一下三方面:

- 感受野设计增加上下文信息

- 感受野是越大越好吗?

- 空洞卷积的rate在不同层级的特征图上要保持一致吗?

最近的许多方法都为实时语义分割任务设计了专用主干,其中感受野的设计是其中的一个重要部分。通常,这些方法追求广阔的感受野以捕获更多的上下文信息,从而提高特征表示能力。然而,作者认为,在实践中这可能会导致低效的特征提取。

DABNet和CGNet在其网络的深层使用具有大空洞率的空洞卷积,但作者观察到,这些卷积中几乎没有任何参数可以被学习。这种现象的原因是,这种卷积几乎不可能在实质上大的空间跨度上直接建立特征之间的连接,从而导致低的特征提取效率。而STDC在整个网络中保持相同的感受野大小,这对于low-level特征提取来说太大,从而限制了效率。作者观察到,在STDC的low-level,更少的卷积层但更多的通道可以产生更好的结果。

作者认为,确定合适的感受野大小对于提高特征提取的效率至关重要,并且在网络的不同阶段对感受野大小的要求是不同的。随着特征语义表示的增强,更高的阶段需要更大的感受野。因此,分别为较高和较低阶段设计了使用空洞卷积来扩展感受野的模块和使用规则卷积来限制感受野的模型。

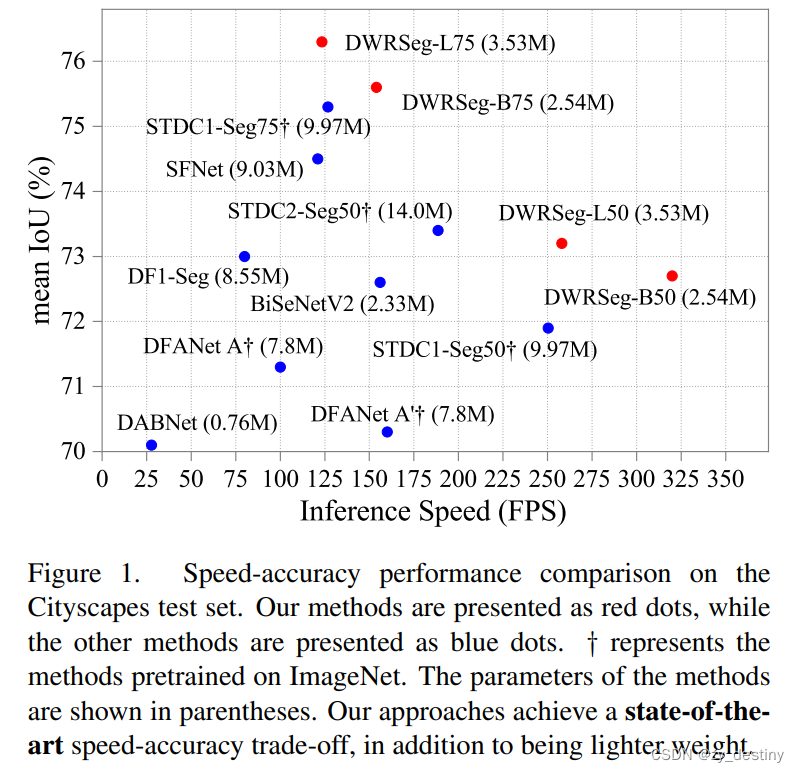

以下是本文在精度和效率方面基于Cityscapes数据集上的表现,看起来还是很不错的。

🐹🐹 3.区域残差和语义残差

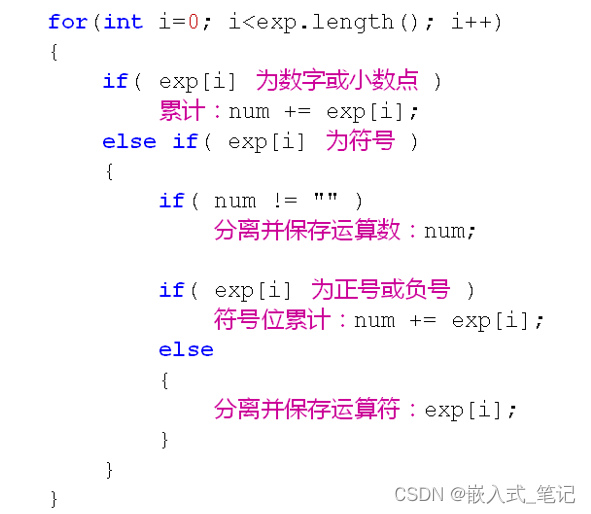

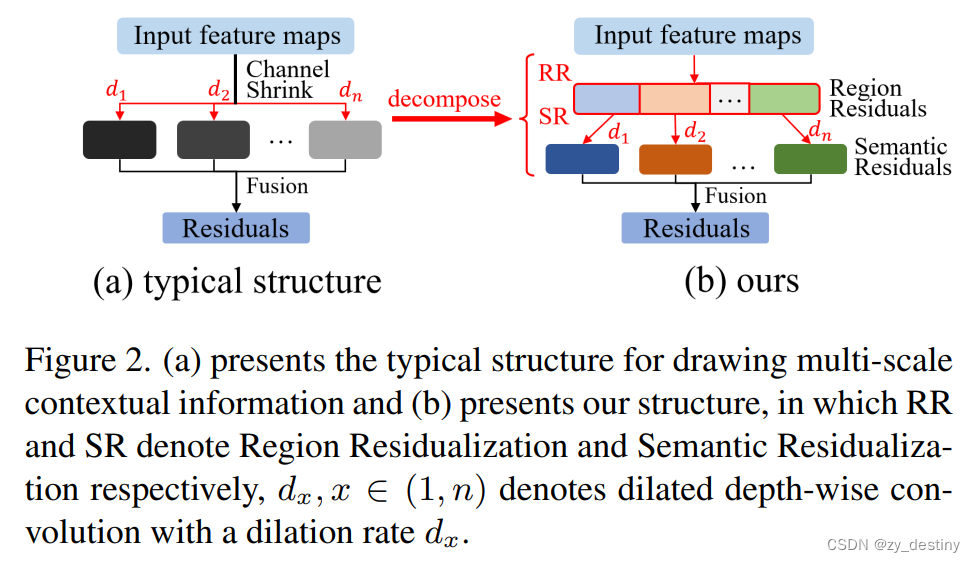

为了降低构建多尺度上下文信息的难度,将原始的单步结构分成2步,其中:

- 第一步,生成具有不同大小的简洁区域表达的关注特征,称为区域残差化。

- 第二步,只有一个深度方向使用具有所需感受野的扩张卷积对每个简洁的基于语义的形态过滤区域形式的特征图,称为语义残差。

通过这种方式,多速率深度扩张卷积在特征提取中的作用是从困难到简单:从从复杂表达的特征图中获取尽可能多的复杂上下文信息到执行对每个简洁表达的内容进行简单的形态过滤具有所需膨胀率的特征图。 简洁的区域特征图形成清晰,简化学习扩展深度卷积的目标并使学习过程更加有序。

🐰🐰 4.Dilation-wise Residual和Simple Inverted Residual

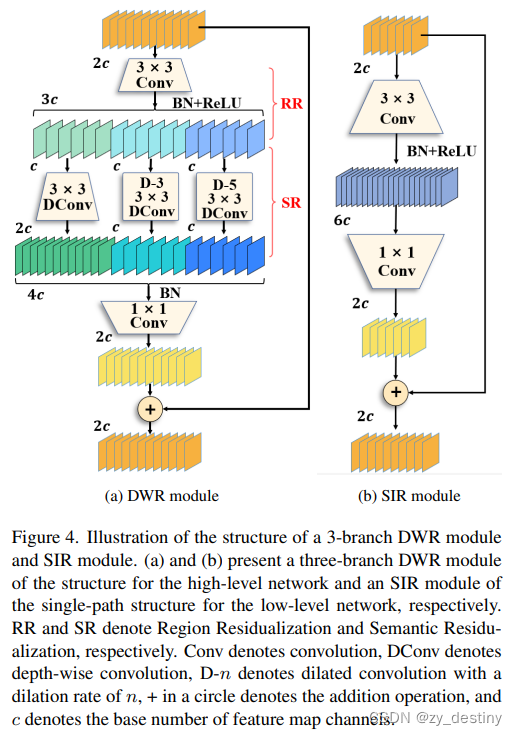

- 首先,引入了一个Dilation-wise Residual(DWR)模块,用于提取网络高层的特征,如图4a所示。多分支结构用于扩展感受野,其中每个分支采用不同空洞率的空洞深度卷积。

- 然后,专门设计了一个Simple Inverted Residual(SIR)模块来提取网络低层的特征,如图4b所示。该模块仅具有3×3的微小感受野,但使用inverted bottleneck式结构来扩展通道数量,确保更强的特征提取能力。

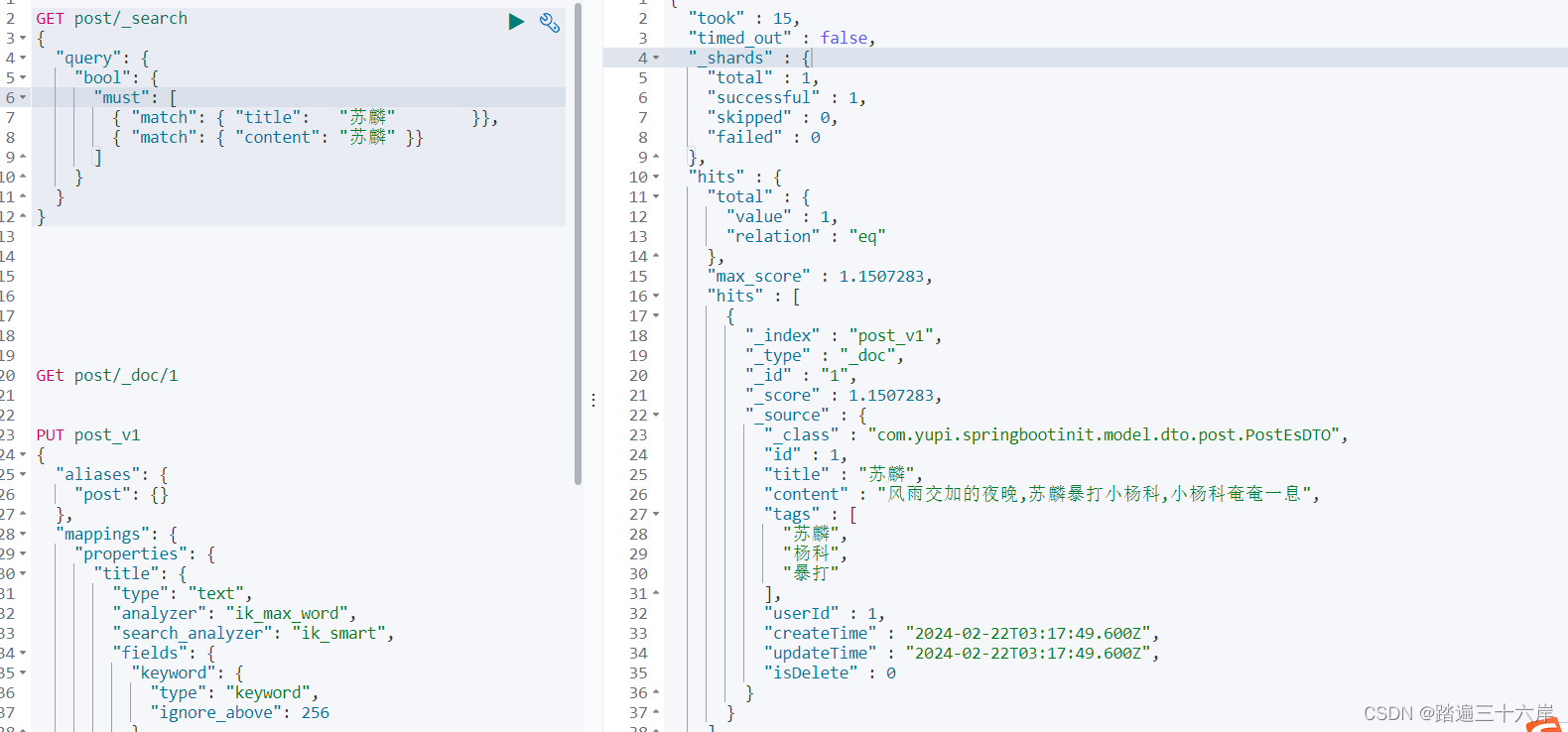

🍃 4.1DWR

DWR设计思想和结构:通常,DWR模块以残差方式设计,如图4a所示。在残差内部,使用两步方法有效地绘制多尺度上下文信息,然后融合多尺度感受野生成的特征图。

具体来说,为了降低获取难度,将之前的单步多尺度上下文将信息获取方法分解为两步法。

第一步: 区域残差特征是由输入特征生成的,具体的操作是将输入特征经过一个3*3卷积、BN和ReLU激活的组合操作来完成,得到具由不同区域大小的区域残差特征RR;

第二步:将RR特征分成3组,分别采用不同膨胀率的膨胀深度卷积来对不同大小的区域特征进行形态学过滤,这被称为语义残差SR。

🍂 4.2SIR

Simple Inverted Residual(SIR)模块是在DWR模块的基础上设计的,以满足低级较小的感受野尺寸的要求,以保持较高的特征提取效率。 其结构如图4b所示。 在DWR模块的基础上做了两点修改:

(1)去掉了多分支扩张卷积结构,只保留第一个分支来压缩感受野。

(2)3x3 深度卷积(语义残差)由于其贡献最小而被删除。 由于输入特征图尺寸大且语义弱,单通道卷积所能收集的信息太少。 因此,在低级阶段,一步特征提取比两步特征提取效率更高。 最终得到一个相当简单的模块,继承了DWR模块的残差和倒瓶颈结构。

🐺🐺5.网络整体结构

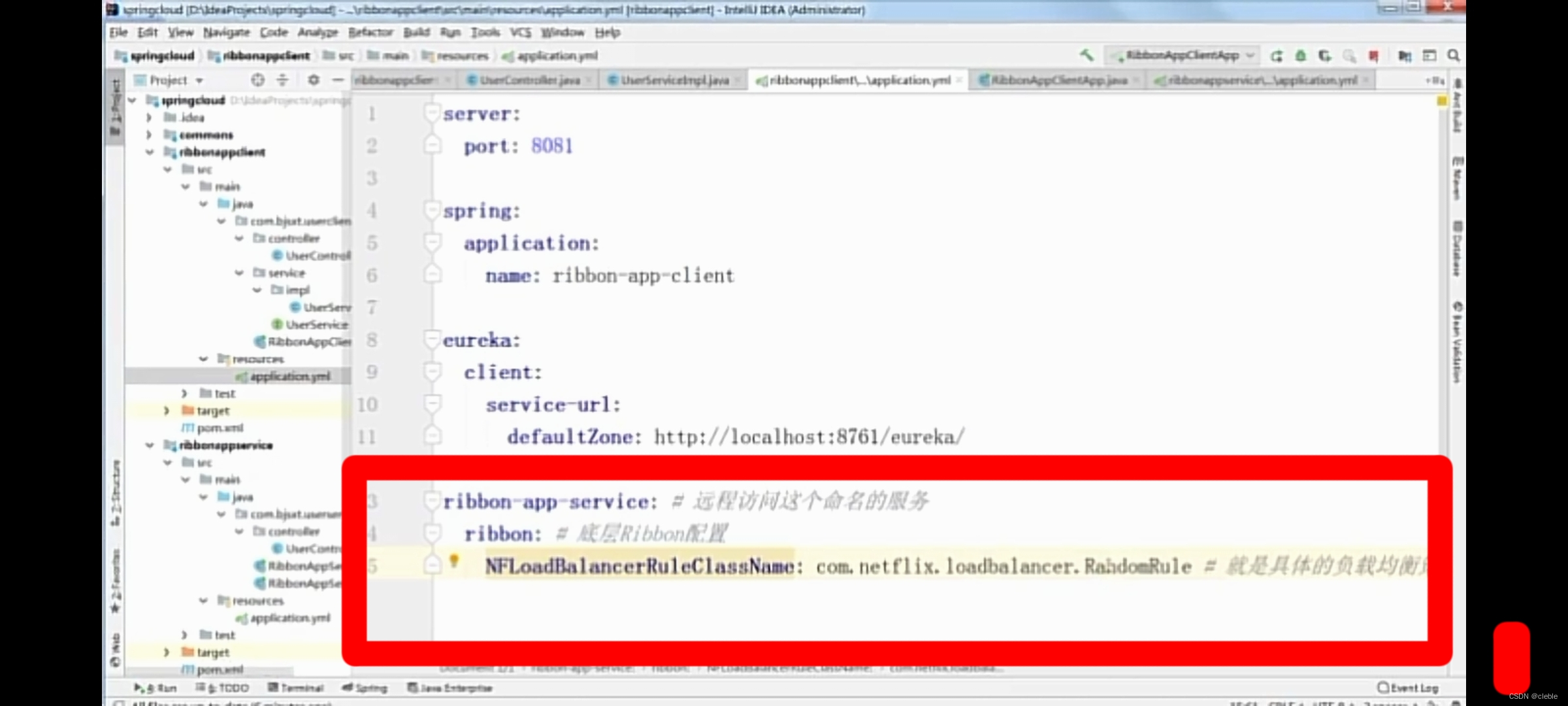

🌿 5.1整体结构

DWRSeg网络结构基于DWR和SIR模块,构建了一个编码器-解码器风格的网络,如图3所示,其中解码器采用了简单的类似FCN的结构。解码器使用来自最后两个阶段的强语义信息直接对特征图进行上采样,然后将它们与来自较低阶段的特征图(包含丰富的详细信息)拼接起来,以进行最终预测。

DWRSeg网络的编码器部分由4个stage进行连接组成,分别是:stem block、低层级的SIRblock和2个高层级的DWRblock。其中,DWRblock就是被用来通过2步获取多尺度上下文信息的特征提取模块;SIRblock即是在DWR模块的基础上进行修改的,以满足更小的感受野要求。具体的网络结构图如下所示,下表记录的是不同量级的模型具体参数。

🍄 5.2Stem block

Stem block:依据BiSeNetV2网络中Stem block模块,采用Stem block作为我们网络的第一阶段,如图所示图 6a。

对 BiSeNetV2 中的Stem block进行了两项调整:

- 我们删除第一个卷积的激活层,以保留原始图像中更多的有效信息。

- 最后一个卷积不进行特征收缩。 该结构具有较低的计算成本和有效的特征表达能力

🌵5.3解码器

文章的重点在编码器部分,解码器部分比较简单,都是普通的操作。

解码器采用简单的类似 FCN 的结构,如图 3 所示。第 3 阶段和第 4 阶段的输出特征图首先进行上采样,然后与第 2 阶段的特征图连接。之后,BN 层作用于连接的特征图 。 最后来一个细分head(SegHead)用于预测。 SegHead 结构如图 6b 所示。 设置具有 BN 层和 ReLU 层的 3×3 卷积来合并特征图。 然后,使用逐点卷积进行预测。 特征图最终被上采样到输入大小。 解码器中的超参数均如表1所示。

🐸🐸 6.实验

🌴 6.1不同膨胀率参数在不同网络阶段表现

🌲 6.2不同参数结果对比

🌰 6.3Citysacpes数据集上不同方法结果对比

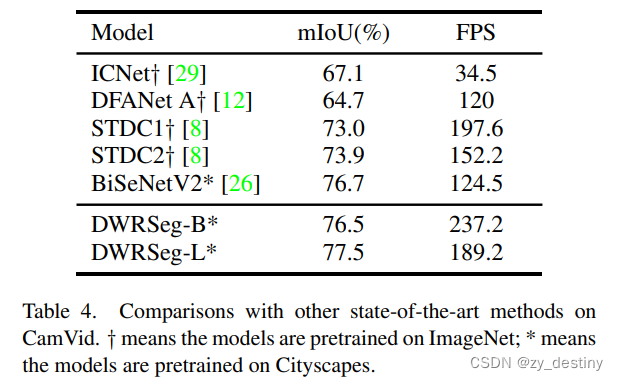

🌼6.4CamVid数据集上不同方法结果对比

整理不易,欢迎一键三连!!!

送你们一条美丽的--分割线--

🌷🌷🍀🍀🌾🌾🍓🍓🍂🍂🙋🙋🐸🐸🙋🙋💖💖🍌🍌🔔🔔🍉🍉🍭🍭🍋🍋🍇🍇🏆🏆📸📸⛵⛵⭐⭐🍎🍎👍👍🌷🌷

![[设计模式Java实现附plantuml源码~行为型]遍历聚合对象中的元素——迭代器模式](https://img-blog.csdnimg.cn/direct/eecb5643b860432ab72082bd0acef2c4.png)