🎈个人主页:豌豆射手^

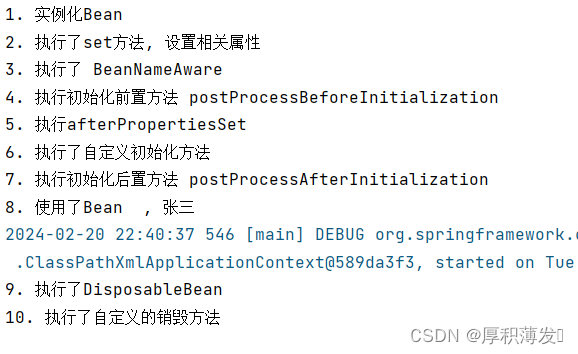

🎉欢迎 👍点赞✍评论⭐收藏

🤗收录专栏:机器学习

🤝希望本文对您有所裨益,如有不足之处,欢迎在评论区提出指正,让我们共同学习、交流进步!

【机器学习】数据清洗之处理重复点

- 一 删除重复点:

- 1.1 基于行的删除:

- 1.2 基于列的删除:

- 1.3 基于所有点的删除:

- 1.4 常用的删除重复点的工具

- 二 合并重复点:

- 2.1 平均值合并:

- 2.2 众数合并:

- 2.3 加权平均值合并:

- 2.4 自定义逻辑合并:

- 2.5 聚类合并:

- 2.6 机器学习模型合并:

- 2.7 常用的合并重复的的工具

- 三 标记重复点:

- 3.1 添加标志列:

- 3.2 标记第一个出现的点:

- 3.3 标记所有重复点:

- 3.4 使用哈希函数标记:

- 四 调整权重:

- 4.1 调整样本权重:

- 4.2 重采样技术:

- 4.3 生成合成样本:

- 4.4 使用集成模型:

- 4.5 自定义损失函数:

- 五 重采样:

- 5.1 下采样(Undersampling):

- 5.2 过采样(Oversampling):

- 5.3 集成重采样方法:

- 5.4 自适应重采样方法:

- 5.5 生成对抗网络(GANs):

- 总结

引言:

在机器学习和数据分析中,数据清洗是一个至关重要的步骤。其中,处理重复点是一个常见的任务,因为重复点会影响模型的性能和结果的准确性。

在本博客中,我们将探讨如何处理重复点,包括删除重复点、合并重复点、标记重复点、调整权重和重采样等方法。

一 删除重复点:

1.1 基于行的删除:

这种方法是在数据集的行方向上进行操作,即在单个数据点的水平方向上识别和删除重复。具体方法包括比较单个数据点的特征值,如果两行的特征值完全相同,则将其中一行视为重复行,并删除。

1.2 基于列的删除:

这种方法是在数据集的列方向上进行操作,即在单个特征的垂直方向上识别和删除重复。具体方法包括比较单个特征的取值,如果某列的值在整个列中都是唯一的,那么该列对于判断重复行可能没有贡献,可以将其作为重复点判断的依据。

1.3 基于所有点的删除:

这种方法是综合考虑整个数据集中的所有数据点,通过比较数据点之间的相似性或唯一性来识别和删除重复点。具体方法包括基于特征值、哈希函数、相似度、机器学习模型等。这种方法通常更加综合和复杂,可以适用于不同类型的数据集和场景。

在实际应用中,常常会结合多种方法来处理重复点,以确保数据质量和模型性能的提高。选择合适的方法取决于数据集的特点、业务需求以及计算资源的限制。

1.4 常用的删除重复点的工具

删除重复点的常用工具主要取决于数据处理的环境和使用的编程语言。以下是一些常见的工具和库,用于在不同环境中删除重复点:

1 Pandas(Python):

Pandas是Python中一个强大的数据处理库,提供了drop_duplicates()函数,可以方便地删除DataFrame中的重复行。

示例代码如下:

import pandas as pd

# 创建DataFrame

df = pd.DataFrame({'A': [1, 2, 2, 3], 'B': ['a', 'b', 'b', 'c']})

# 删除重复行

df.drop_duplicates(inplace=True)

详细介绍可以看我的这篇博客

【机器学习】数据清洗——基于Pandas库的方法删除重复点

2 NumPy(Python):

NumPy是用于科学计算的Python库,可以用于处理数组数据。可以使用NumPy的unique()函数来删除重复值。

示例代码如下:

import numpy as np

# 创建数组

arr = np.array([1, 2, 2, 3])

# 删除重复值

unique_arr = np.unique(arr)

详细介绍可以看我的这篇博客。

【机器学习】数据清洗——基于Numpy库的方法删除重复点

3 SQL(数据库):

如果数据存储在关系型数据库中,可以使用SQL语句来删除重复行。

示例代码如下:

sql

DELETE FROM table_name

WHERE row_id NOT IN (

SELECT MIN(row_id)

FROM table_name

GROUP BY column1, column2, ...

);

其中,table_name是表的名称,column1, column2, …是用于识别重复行的列。

4 Excel/Google Sheets:

对于小型数据集,可以手动使用Excel或Google Sheets来删除重复行。可以使用内置的数据筛选或函数来实现。

5 R语言: R语言也提供了用于删除重复行的函数,例如unique()。

示例代码如下:

# 创建数据框

df <- data.frame(A = c(1, 2, 2, 3), B = c('a', 'b', 'b', 'c'))

# 删除重复行

df_unique <- unique(df)

这些工具和库提供了在不同环境下删除重复点的方法,具体选择取决于数据处理的需求、编程语言的选择以及数据的存储方式。

二 合并重复点:

在机器学习数据清洗中,处理重复点的合并方法旨在将重复的数据点合并成一个单独的数据点,从而减少数据集中的重复信息,提高模型的训练效率和性能。

以下是一些常见的合并重复点的方法:

2.1 平均值合并:

对于数值型特征,在合并重复点时,可以计算这些重复点的特征值的平均值,并将平均值作为合并后数据点的特征值。这种方法适用于数值型数据,能够保留数据点的整体趋势。

2.2 众数合并:

对于分类特征或离散型特征,在合并重复点时,可以计算这些重复点的特征值的众数,并将众数作为合并后数据点的特征值。这种方法适用于离散型数据,能够保留数据点的主要特征。

2.3 加权平均值合并:

在某些情况下,可以根据数据点的重要性或权重对特征值进行加权平均,然后将加权平均值作为合并后数据点的特征值。这种方法可以更好地反映数据点的相对重要性。

2.4 自定义逻辑合并:

根据业务需求和数据特点,可以自定义合并规则。例如,对于时间序列数据,可以根据时间间隔将重复点合并成一个时间段内的数据点;对于地理位置数据,可以根据距离将重复点合并成一个区域内的数据点。

2.5 聚类合并:

使用聚类算法对数据点进行聚类,然后将同一簇内的数据点合并成一个代表性的数据点。这种方法能够有效地识别和合并具有相似特征的数据点,减少数据集的复杂度。

2.6 机器学习模型合并:

使用机器学习模型对数据点进行学习和预测,然后将预测结果作为合并后数据点的特征值。这种方法能够充分利用数据集中的信息,生成合适的合并结果。

在选择合并重复点的方法时,需要考虑数据集的特点、业务需求以及模型训练的效果。通常情况下,会结合多种方法来处理重复点,以达到合并后数据集清洗、减少噪声、提高模型性能的目的。

2.7 常用的合并重复的的工具

并重复点通常需要根据具体的数据和任务来选择合适的工具和方法。以下是一些常用的工具和库,可用于合并重复点:

1 Pandas(Python):

Pandas是Python中一个常用的数据处理库,提供了groupby()和agg()等函数,可以方便地对数据进行分组和聚合操作,从而实现对重复点的合并。

示例代码如下:

import pandas as pd

# 创建DataFrame

df = pd.DataFrame({'A': [1, 2, 2, 3], 'B': ['a', 'b', 'b', 'c']})

# 合并重复点

df_merged = df.groupby(['A', 'B']).size().reset_index(name='count')

2 SQL(数据库):

如果数据存储在关系型数据库中,可以使用SQL语句来进行重复点的合并。通过使用GROUP BY和聚合函数如AVG()、COUNT()等,可以实现对重复点的合并。示例代码如下:

SELECT A, B, AVG(C) AS avg_C, COUNT(*) AS count

FROM table_name

GROUP BY A, B;

3 NumPy(Python):

NumPy可以用于处理数组数据,对于数值型数据,可以使用np.mean()函数计算平均值来合并重复点。

4 R语言:

R语言也提供了丰富的函数和包,可以用于数据处理和合并重复点。

例如,使用dplyr包中的group_by()和summarise()函数可以实现合并重复点。

示例代码如下:

library(dplyr)

# 创建数据框

df <- data.frame(A = c(1, 2, 2, 3), B = c('a', 'b', 'b', 'c'))

# 合并重复点

df_merged <- df %>%

group_by(A, B) %>%

summarise(count = n())

这些工具和库提供了在不同环境下合并重复点的方法,具体选择取决于数据处理的需求、编程语言的选择以及数据的存储方式

三 标记重复点:

在机器学习数据清洗中,标记重复点的方法是将数据集中的重复点进行标记或标识,以便在后续处理中进行进一步的分析或删除。以下是一些常见的标记重复点的方法:

3.1 添加标志列:

一种简单的方法是在数据集中添加一个额外的列,用于标记每个数据点是否是重复的。可以使用布尔值或其他标志来表示。

示例代码如下(使用Pandas库):

import pandas as pd

# 创建DataFrame

df = pd.DataFrame({'A': [1, 2, 2, 3], 'B': ['a', 'b', 'b', 'c']})

# 标记重复点

df['is_duplicate'] = df.duplicated()

在上述代码中,df.duplicated()会返回一个布尔序列,表示每个数据点是否是重复的,然后将这个序列添加到DataFrame中作为新的标志列。

3.2 标记第一个出现的点:

有时候,我们可能希望保留第一个出现的数据点,而将后续的重复点进行标记。可以使用Pandas的duplicated函数的keep参数来实现。

示例代码如下:

df['is_duplicate'] = df.duplicated(keep='first')

这会将第一个出现的重复点保留为不重复,而将后续的重复点标记为True。

3.3 标记所有重复点:

可以选择将所有重复点都标记为True。示例代码如下:

df['is_duplicate'] = df.duplicated(keep=False)

这样会将所有重复点都标记为True,无论它们是第几次出现。

3.4 使用哈希函数标记:

对数据点进行哈希处理,将哈希值作为标记。这样,相同的数据点将具有相同的哈希值,从而可以标记重复点。这种方法在处理大型数据集时比较有效。

import hashlib

df['hash'] = df.apply(lambda row: hashlib.md5(str(row).encode('utf-8')).hexdigest(), axis=1)

df['is_duplicate'] = df.duplicated(subset='hash')

在上述代码中,hashlib.md5用于计算哈希值,然后duplicated函数用于标记重复点。

这些方法提供了一些灵活的选项,可以根据具体需求来标记重复点。标记重复点是清洗数据的一部分,可以在特征工程和模型训练前进一步处理这些标记,确保数据集的质量和模型的性能。

四 调整权重:

在机器学习数据清洗中,处理重复点的调整权重方法旨在更好地处理重复样本,以防止模型过于偏向这些样本。以下是一些常见的处理重复点并调整权重的方法:

4.1 调整样本权重:

一种直观的方法是通过调整样本的权重来反映其重要性。

对于重复样本,可以降低其权重,以减轻其对模型的影响。在许多机器学习框架中,模型训练时都提供了一个sample_weight参数,可以用于指定每个样本的权重。

通过设置重复样本的权重为较小的值,可以使模型更关注非重复样本。

4.2 重采样技术:

另一种方法是通过重采样技术来处理重复样本。这包括下采样(移除一些重复样本)和过采样(复制或生成新的非重复样本)。

这些技术可以用于平衡数据集中的类别分布,并且在处理重复样本时可以调整采样比例。

但要注意,过度的重采样可能导致过拟合,因此需要谨慎使用。

4.3 生成合成样本:

为了避免过分依赖重复样本,一种创新的方法是生成合成样本,以增加数据的多样性。

这可以通过在原始数据的基础上进行微小的变化或应用生成对抗网络(GANs)等方法来实现。

生成合成样本有助于模型更好地捕捉数据分布,而不仅仅是记住重复的样本。

4.4 使用集成模型:

集成模型可以有效地处理重复样本。通过训练多个模型,每个模型看到的数据略有不同,模型之间的集成可以减轻对重复样本的过度依赖。

例如,Bagging(自助采样聚合)和Boosting(迭代加权)是两种常见的集成学习方法,可以在一定程度上处理重复样本。

4.5 自定义损失函数:

如果其他方法无法满足需求,还可以考虑使用自定义损失函数。

通过设计损失函数,可以对重复样本施加额外的惩罚或调整权重,以达到更好的模型训练效果。

这需要深入理解模型框架和优化算法,并谨慎调整损失函数的参数。

在实践中,选择合适的方法通常取决于具体的问题和数据集。

需要注意的是,处理重复样本时应谨慎,因为过度处理可能导致信息损失或模型性能下降。

最佳方法通常是在交叉验证中进行实验,评估不同方法对模型性能的影响,以选择最适合特定任务的方法。

五 重采样:

在机器学习数据清洗中,处理重复点的重采样方法是通过调整数据集中样本的分布,以减轻重复样本对模型的影响。

以下是一些常见的重采样方法:

5.1 下采样(Undersampling):

下采样是通过减少重复样本的数量来平衡数据集。

这可以通过简单地删除一些重复样本来实现。但是,下采样可能导致信息丢失,并且在样本较少时容易引入采样偏差。

因此,在执行下采样时,需要仔细考虑保留哪些重复样本。

5.2 过采样(Oversampling):

过采样是通过增加非重复样本的数量来平衡数据集。

最简单的方法是简单地复制一些非重复样本,但这可能导致过拟合。更高级的过采样技术包括SMOTE(Synthetic Minority Over-sampling Technique),它通过生成合成样本来增加数据的多样性。

SMOTE通过在特征空间内对每个重复样本的邻居之间插入新样本,创建了一些新的合成样本,以模拟非重复样本的分布。

5.3 集成重采样方法:

将集成学习与重采样相结合,通过构建多个模型并集成它们的预测,可以有效地处理重复样本。

Bagging(Bootstrap Aggregating)是一种集成学习技术,它通过有放回地从训练集中抽样创建多个子集,每个子集可能包含一些重复样本。

在训练过程中,每个子集都用于训练一个基础模型,最后这些模型的预测进行平均或投票。这有助于减轻对重复样本的过度依赖。

5.4 自适应重采样方法:

一些方法根据模型的性能自适应地调整采样策略。

例如,EasyEnsemble和BalanceCascade是两种通过迭代训练和调整重采样策略的方法,以确保模型对重复样本不过度敏感。

5.5 生成对抗网络(GANs):

GANs可以用于生成逼真的合成样本,从而增加数据集的多样性。

生成的样本旨在与真实样本难以区分,从而在模型训练中提供更多信息。

GANs的使用需要谨慎,以防止生成的样本过分地偏向某些类别。

在选择重采样方法时,需要根据具体的问题和数据集特征进行评估。重采样可能有助于解决类别不平衡和重复样本的问题,但需要注意可能引入的偏差和过拟合。通常建议在交叉验证中评估不同的重采样方法,以选择最适合特定任务的策略。

总结

在本博客中,我们介绍了处理重复点的多种方法,包括删除重复点、合并重复点、标记重复点、调整权重和重采样等。

这些方法可以根据具体情况和需求进行选择和应用。

在实际应用中,需要根据数据的特点和模型的要求来选择合适的方法,以提高模型的性能和结果的准确性。

同时,我们还介绍了一些常用的工具和技术,如numpy.unique函数、聚类算法、机器学习模型等,来处理重复点。

希望本博客能够帮助读者更好地理解和应用数据清洗中的重复点处理方法。

这篇文章到这里就结束了

谢谢大家的阅读!

如果觉得这篇博客对你有用的话,别忘记三连哦。

我是甜美的江,让我们我们下次再见