ch3-homework-基于InternLM和LangChain搭建自己的知识库

- 复现课程知识库助手搭建过程

- 先看结果

- 环境配置

- 语料

- 开源词向量模型Sentence Transformer

- 知识库搭建

- InternLM 接入 LangChain

- 构建检索问答链,并基于Gradio框架部署

基础作业:

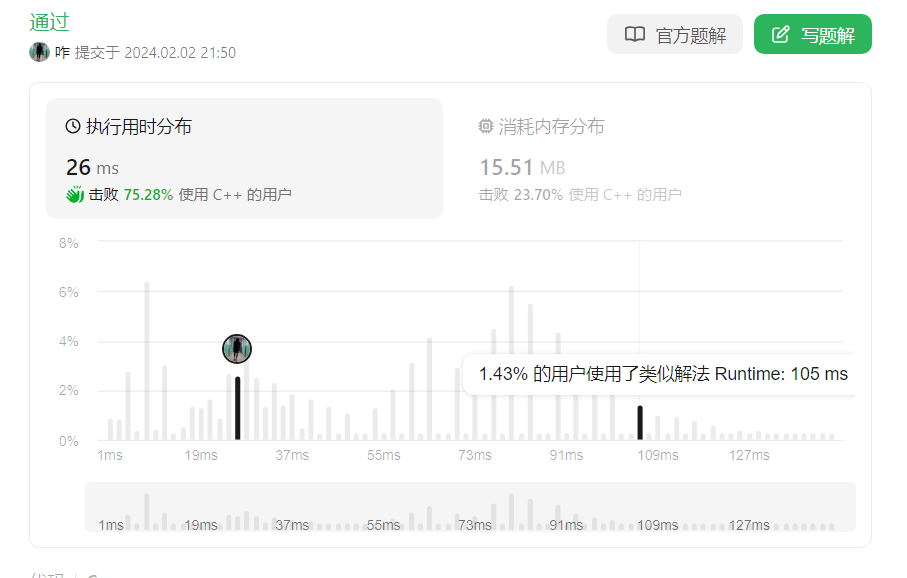

复现课程知识库助手搭建过程 (截图)

进阶作业:

选择一个垂直领域,收集该领域的专业资料构建专业知识库,并搭建专业问答助手,并在 OpenXLab 上成功部署(截图,并提供应用地址)

复现课程知识库助手搭建过程

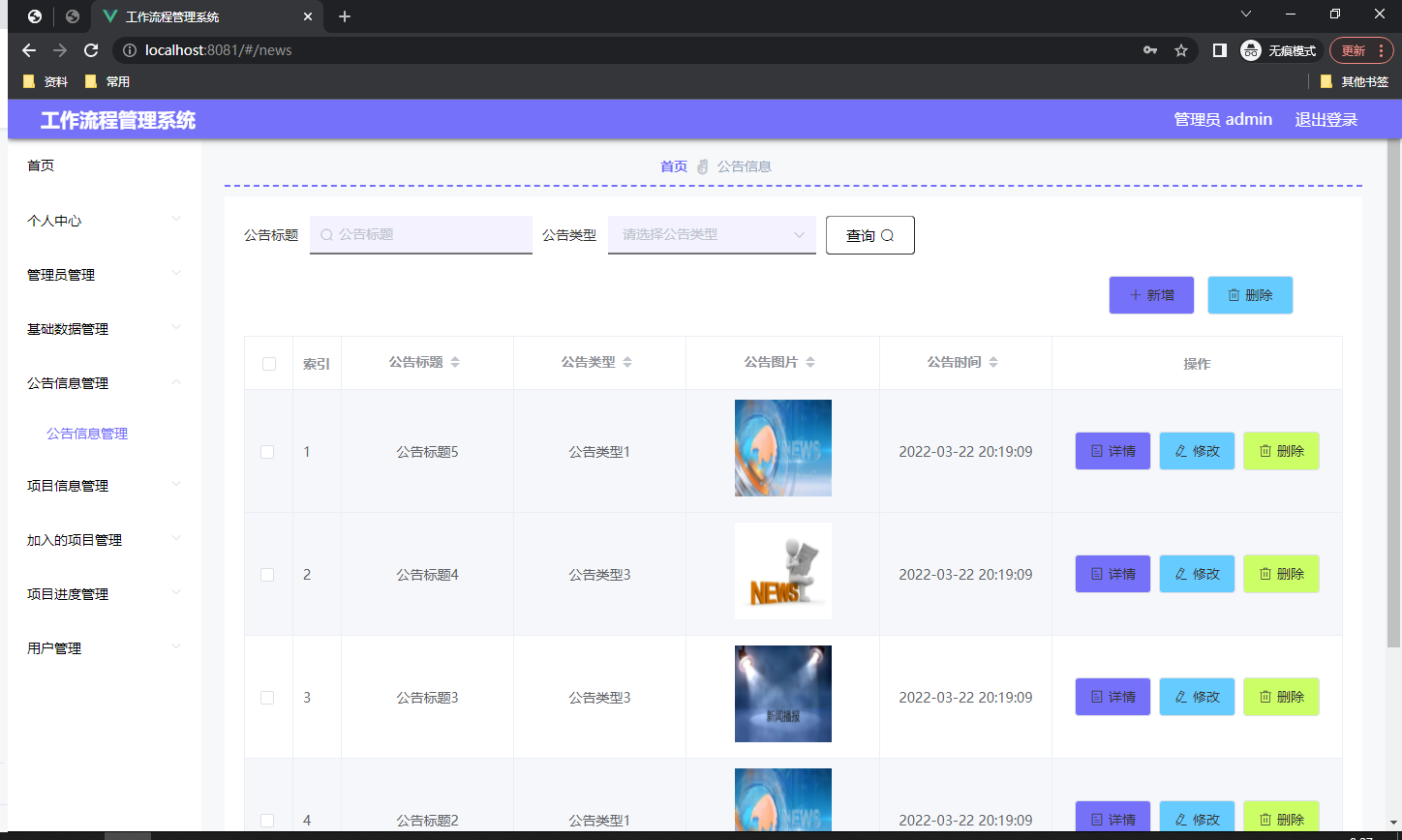

先看结果

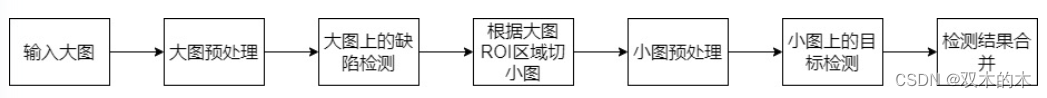

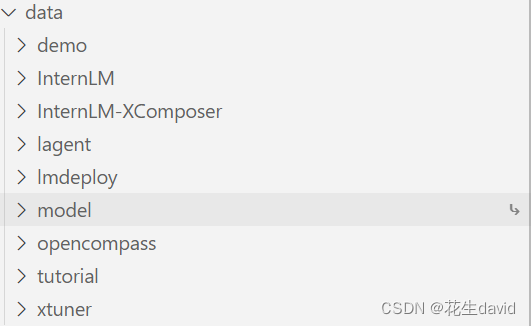

课程所用的训练语料主要是internLM相关的几个开源库,基本上按照教程走下来即可,本地最后完成的整体目录结构如下:

构建好的web应用截图:

可以看到,因为所用的语料比较少,所以模型的回答马马虎虎,不过跟internLM相关的还行,其他的就需要给模型喂更多的知识了~

下面简述根据文档的复现过程,也可以直接看文档:

- https://github.com/internLM/tutorial

环境配置

在已完成 InternLM 的部署基础上,还需要安装以下依赖包:

pip install langchain==0.0.292

pip install gradio==4.4.0

pip install chromadb==0.4.15

pip install sentence-transformers==2.2.2

pip install unstructured==0.10.30

pip install markdown==3.3.7

语料

主要选择由上海人工智能实验室开源的一系列大模型工具开源仓库作为语料库来源,包括:

- OpenCompass:面向大模型评测的一站式平台

- IMDeploy:涵盖了 LLM 任务的全套轻量化、部署和服务解决方案的高效推理工具箱

- XTuner:轻量级微调大语言模型的工具库

- InternLM-XComposer:浦语·灵笔,基于书生·浦语大语言模型研发的视觉-语言大模型

- Lagent:一个轻量级、开源的基于大语言模型的智能体(agent)框架

- InternLM:一个开源的轻量级训练框架,旨在支持大模型训练而无需大量的依赖

下载到data目录下即可

开源词向量模型Sentence Transformer

同时,我们需要使用到开源词向量模型 Sentence Transformer:

首先需要使用 huggingface 官方提供的 huggingface-cli 命令行工具。安装依赖:

pip install -U huggingface_hub

然后下载代码如下:

import os

# 设置环境变量

os.environ['HF_ENDPOINT'] = 'https://hf-mirror.com'

# 下载模型

os.system('huggingface-cli download --resume-download sentence-transformers/paraphrase-multilingual-MiniLM-L12-v2 --local-dir model/sentence-transformer')

下载到model/sentence-transformer目录下即可

知识库搭建

选用上述仓库中所有的 markdown、txt 文件作为示例语料库,主要代码放在了create_db.py下面(注意,其中的路径需要自己修改为本地的目录):

# 首先导入所需第三方库

from langchain.document_loaders import UnstructuredFileLoader

from langchain.document_loaders import UnstructuredMarkdownLoader

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain.vectorstores import Chroma

from langchain.embeddings.huggingface import HuggingFaceEmbeddings

from tqdm import tqdm

import os

# 获取文件路径函数

def get_files(dir_path):

# args:dir_path,目标文件夹路径

file_list = []

for filepath, dirnames, filenames in os.walk(dir_path):

# os.walk 函数将递归遍历指定文件夹

for filename in filenames:

# 通过后缀名判断文件类型是否满足要求

if filename.endswith(".md"):

# 如果满足要求,将其绝对路径加入到结果列表

file_list.append(os.path.join(filepath, filename))

elif filename.endswith(".txt"):

file_list.append(os.path.join(filepath, filename))

return file_list

# 加载文件函数

def get_text(dir_path):

# args:dir_path,目标文件夹路径

# 首先调用上文定义的函数得到目标文件路径列表

file_lst = get_files(dir_path)

# docs 存放加载之后的纯文本对象

docs = []

# 遍历所有目标文件

for one_file in tqdm(file_lst):

file_type = one_file.split('.')[-1]

if file_type == 'md':

loader = UnstructuredMarkdownLoader(one_file)

elif file_type == 'txt':

loader = UnstructuredFileLoader(one_file)

else:

# 如果是不符合条件的文件,直接跳过

continue

docs.extend(loader.load())

return docs

# 目标文件夹

tar_dir = [

"/root/data/InternLM",

"/root/data/InternLM-XComposer",

"/root/data/lagent",

"/root/data/lmdeploy",

"/root/data/opencompass",

"/root/data/xtuner"

]

# 加载目标文件

docs = []

for dir_path in tar_dir:

docs.extend(get_text(dir_path))

# 对文本进行分块

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=500, chunk_overlap=150)

split_docs = text_splitter.split_documents(docs)

# 加载开源词向量模型

embeddings = HuggingFaceEmbeddings(model_name="/root/data/model/sentence-transformer")

# 构建向量数据库

# 定义持久化路径

persist_directory = 'data_base/vector_db/chroma'

# 加载数据库

vectordb = Chroma.from_documents(

documents=split_docs,

embedding=embeddings,

persist_directory=persist_directory # 允许我们将persist_directory目录保存到磁盘上

)

# 将加载的向量数据库持久化到磁盘上

vectordb.persist()

直接python运行create_db,本地生成data_base语料库

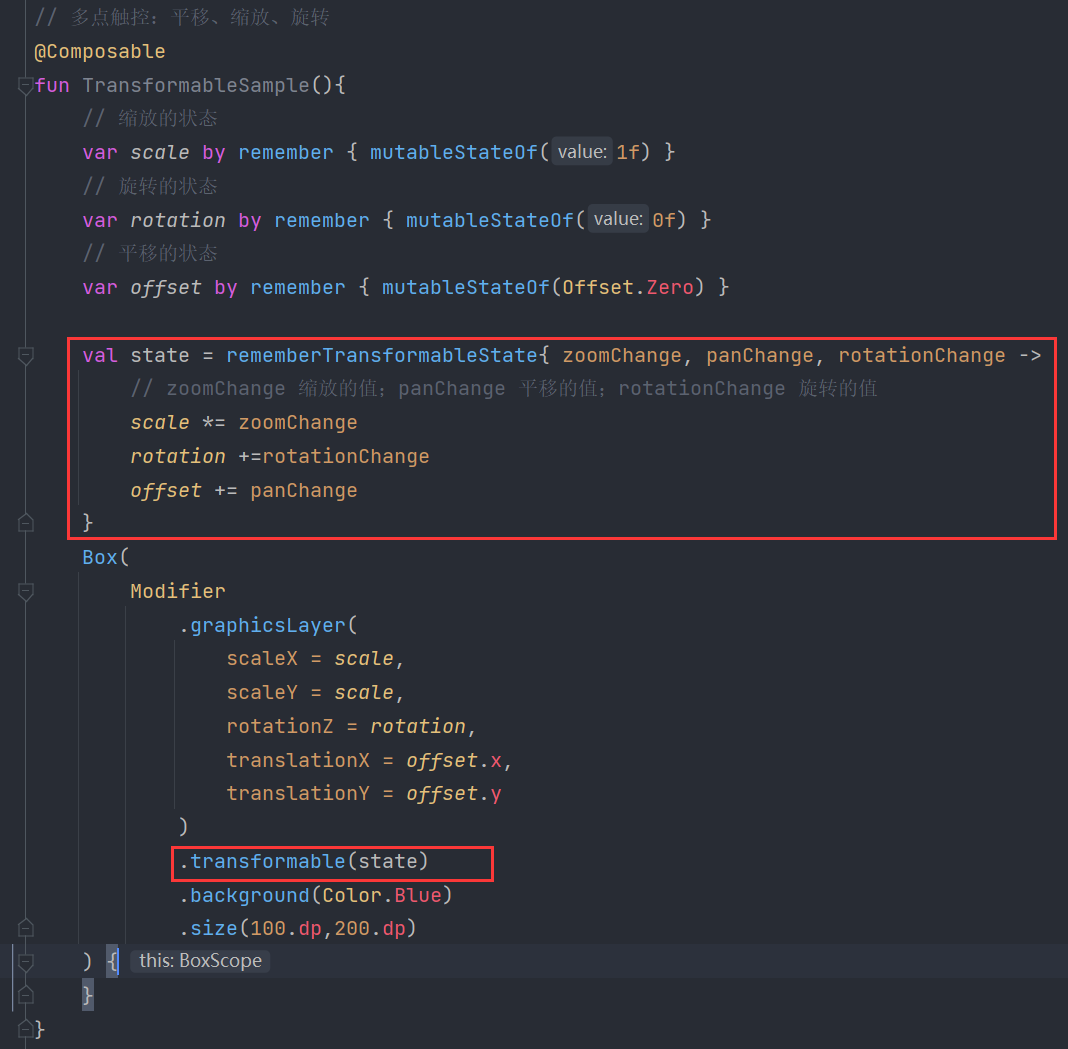

InternLM 接入 LangChain

为便捷构建 LLM 应用,我们需要基于本地部署的 InternLM,继承 LangChain 的 LLM 类自定义一个 InternLM LLM 子类,从而实现将 InternLM 接入到 LangChain 框架中。完成 LangChain 的自定义 LLM 子类之后,可以以完全一致的方式调用 LangChain 的接口,而无需考虑底层模型调用的不一致。

基于本地部署的 InternLM 自定义 LLM 类并不复杂,我们只需从 LangChain.llms.base.LLM 类继承一个子类,并重写构造函数与 _call 函数即可:

from langchain.llms.base import LLM

from typing import Any, List, Optional

from langchain.callbacks.manager import CallbackManagerForLLMRun

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

class InternLM_LLM(LLM):

# 基于本地 InternLM 自定义 LLM 类

tokenizer : AutoTokenizer = None

model: AutoModelForCausalLM = None

def __init__(self, model_path :str):

# model_path: InternLM 模型路径

# 从本地初始化模型

super().__init__()

print("正在从本地加载模型...")

self.tokenizer = AutoTokenizer.from_pretrained(model_path, trust_remote_code=True)

self.model = AutoModelForCausalLM.from_pretrained(model_path, trust_remote_code=True).to(torch.bfloat16).cuda()

self.model = self.model.eval()

print("完成本地模型的加载")

def _call(self, prompt : str, stop: Optional[List[str]] = None,

run_manager: Optional[CallbackManagerForLLMRun] = None,

**kwargs: Any):

# 重写调用函数

system_prompt = """You are an AI assistant whose name is InternLM (书生·浦语).

- InternLM (书生·浦语) is a conversational language model that is developed by Shanghai AI Laboratory (上海人工智能实验室). It is designed to be helpful, honest, and harmless.

- InternLM (书生·浦语) can understand and communicate fluently in the language chosen by the user such as English and 中文.

"""

messages = [(system_prompt, '')]

response, history = self.model.chat(self.tokenizer, prompt , history=messages)

return response

@property

def _llm_type(self) -> str:

return "InternLM"

将上述脚本保存成LLM.py备用

构建检索问答链,并基于Gradio框架部署

LangChain 通过提供检索问答链对象来实现对于 RAG 全流程的封装。所谓检索问答链,即通过一个对象完成检索增强问答(即RAG)的全流程,针对 RAG 的更多概念,我们会在视频内容中讲解,也欢迎读者查阅该教程来进一步了解:《LLM Universe》。我们可以调用一个 LangChain 提供的 RetrievalQA 对象,通过初始化时填入已构建的数据库和自定义 LLM 作为参数,来简便地完成检索增强问答的全流程,LangChain 会自动完成基于用户提问进行检索、获取相关文档、拼接为合适的 Prompt 并交给 LLM 问答的全部流程。

构建一个名为run_gradio.py的文件,输入下述内容:

from langchain.vectorstores import Chroma

from langchain.embeddings.huggingface import HuggingFaceEmbeddings

import os

from LLM import InternLM_LLM

from langchain.prompts import PromptTemplate

from langchain.chains import RetrievalQA

def load_chain():

# 加载问答链

# 定义 Embeddings

embeddings = HuggingFaceEmbeddings(model_name="/data/ssd-stor/fsf/work/tutorials/3_bigmodel/InternLM/demo/model/sentence-transformer")

# 向量数据库持久化路径

persist_directory = 'data_base/vector_db/chroma'

# 加载数据库

vectordb = Chroma(

persist_directory=persist_directory, # 允许我们将persist_directory目录保存到磁盘上

embedding_function=embeddings

)

# 加载自定义 LLM

llm = InternLM_LLM(model_path = "/data/ssd-stor/fsf/work/tutorials/3_bigmodel/InternLM/demo/model/Shanghai_AI_Laboratory/internlm-chat-7b")

# 定义一个 Prompt Template

template = """使用以下上下文来回答最后的问题。如果你不知道答案,就说你不知道,不要试图编造答

案。尽量使答案简明扼要。总是在回答的最后说“谢谢你的提问!”。

{context}

问题: {question}

有用的回答:"""

QA_CHAIN_PROMPT = PromptTemplate(input_variables=["context","question"],template=template)

# 运行 chain

qa_chain = RetrievalQA.from_chain_type(llm,retriever=vectordb.as_retriever(),return_source_documents=True,chain_type_kwargs={"prompt":QA_CHAIN_PROMPT})

return qa_chain

# 接着我们定义一个类,该类负责加载并存储检索问答链,并响应 Web 界面里调用检索问答链进行回答的动作:

class Model_center():

"""

存储检索问答链的对象

"""

def __init__(self):

# 构造函数,加载检索问答链

self.chain = load_chain()

def qa_chain_self_answer(self, question: str, chat_history: list = []):

"""

调用问答链进行回答

"""

if question == None or len(question) < 1:

return "", chat_history

try:

chat_history.append(

(question, self.chain({"query": question})["result"]))

# 将问答结果直接附加到问答历史中,Gradio 会将其展示出来

return "", chat_history

except Exception as e:

return e, chat_history

# 然后我们只需按照 Gradio 的框架使用方法,实例化一个 Web 界面并将点击动作绑定到上述类的回答方法即可:

import gradio as gr

# 实例化核心功能对象

model_center = Model_center()

# 创建一个 Web 界面

block = gr.Blocks()

with block as demo:

with gr.Row(equal_height=True):

with gr.Column(scale=15):

# 展示的页面标题

gr.Markdown("""<h1><center>InternLM</center></h1>

<center>书生浦语</center>

""")

with gr.Row():

with gr.Column(scale=4):

# 创建一个聊天机器人对象

chatbot = gr.Chatbot(height=450, show_copy_button=True)

# 创建一个文本框组件,用于输入 prompt。

msg = gr.Textbox(label="Prompt/问题")

with gr.Row():

# 创建提交按钮。

db_wo_his_btn = gr.Button("Chat")

with gr.Row():

# 创建一个清除按钮,用于清除聊天机器人组件的内容。

clear = gr.ClearButton(

components=[chatbot], value="Clear console")

# 设置按钮的点击事件。当点击时,调用上面定义的 qa_chain_self_answer 函数,并传入用户的消息和聊天历史记录,然后更新文本框和聊天机器人组件。

db_wo_his_btn.click(model_center.qa_chain_self_answer, inputs=[

msg, chatbot], outputs=[msg, chatbot])

gr.Markdown("""提醒:<br>

1. 初始化数据库时间可能较长,请耐心等待。

2. 使用中如果出现异常,将会在文本输入框进行展示,请不要惊慌。 <br>

""")

gr.close_all()

# 直接启动

demo.launch()

![[office] Excel 数据库函数条件区域怎样设置 #笔记#笔记](https://img-blog.csdnimg.cn/img_convert/87d0bd62103657336ef377840a4f240b.jpeg)