无参考图像质量评价算法

无参考图像质量评价是指参考图像不存在的情况下,直接计算失真图像的视觉质量。根据无参考图像质量评价模型在计算图像视觉质量时是否需要图像的主观分数来进行训练,无参考图像质量评价算法可分为基于监督学习的无参考图像质量评价算法和基于无监督学习的无参考图像质量评价算法。

1 基于监督学习的无参考图像质量评价算法

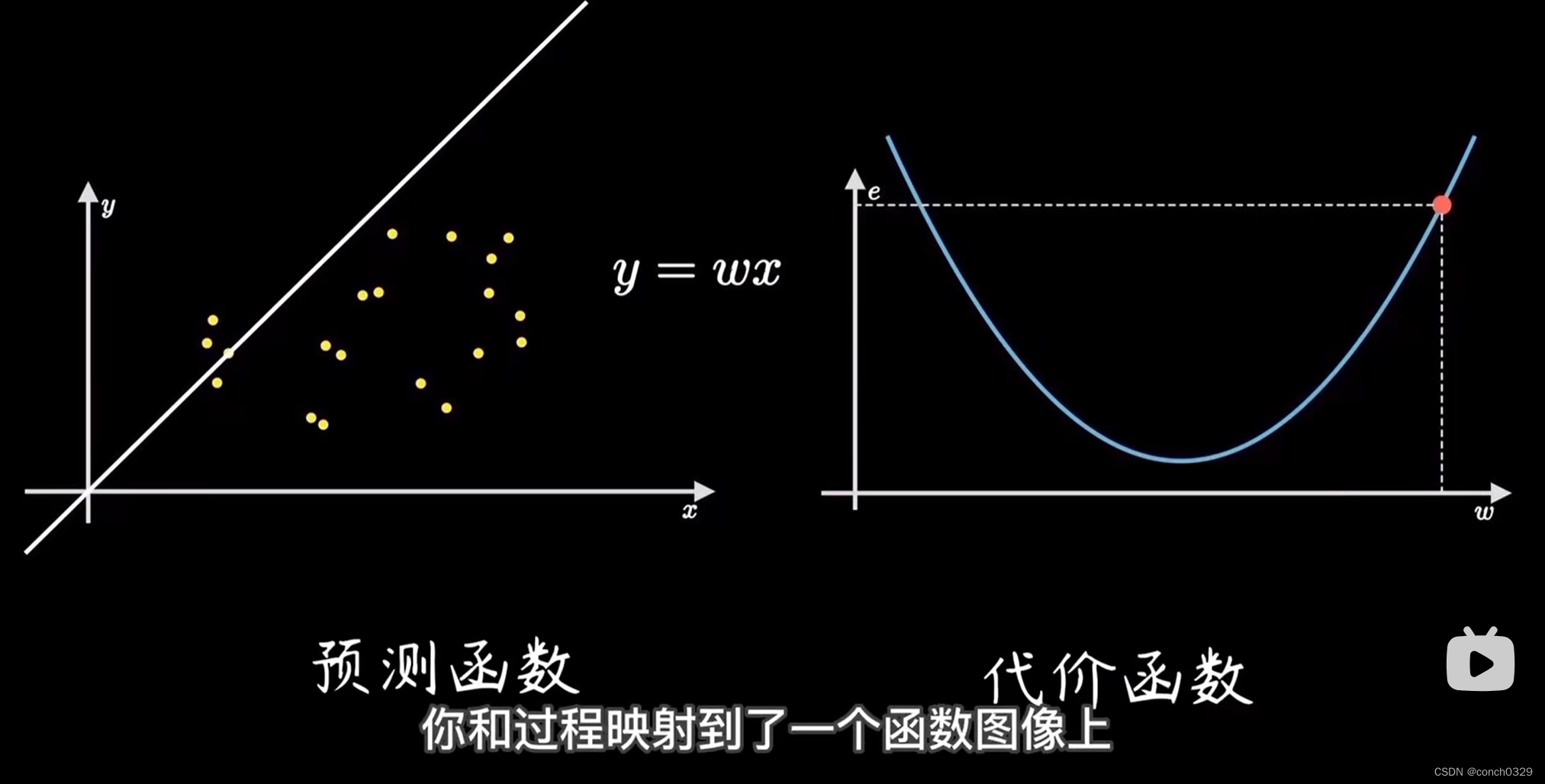

基于监督学习的无参考图像质量评价算法主要包括基于传统机器学习的方法和基于深度学习的方法。基于传统机器学习的该类方法旨在设计有效的视觉特征表达方法,通过支持向量回归等传统机器学习方法学习视觉特征到图像视觉质量的映射模型,而基于深度学习的方法则主要通过构建深度神经网络,学习图像的视觉特征以构建图像质量评价模型,或直接通过端到端来学习失真图像到图像视觉质量的函数表达。

2 基于无监督学习的无参考图像质量评价算法

类似基于监督学习的无参考图像质量评价算法,基于无监督学习的无参考图像质量评价算法主要包括基于传统机器学习的方法和基于深度学习的方法。

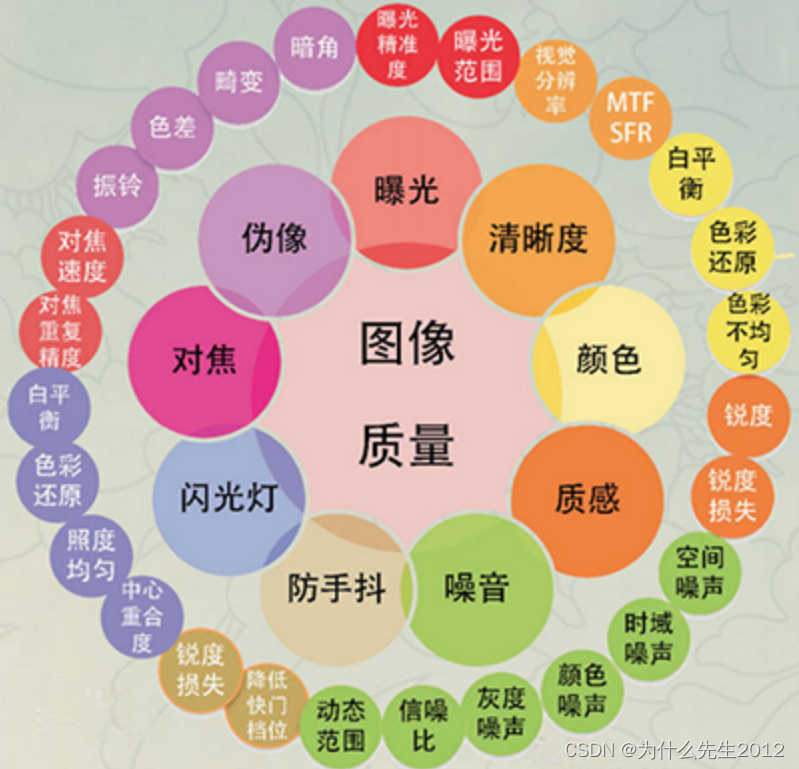

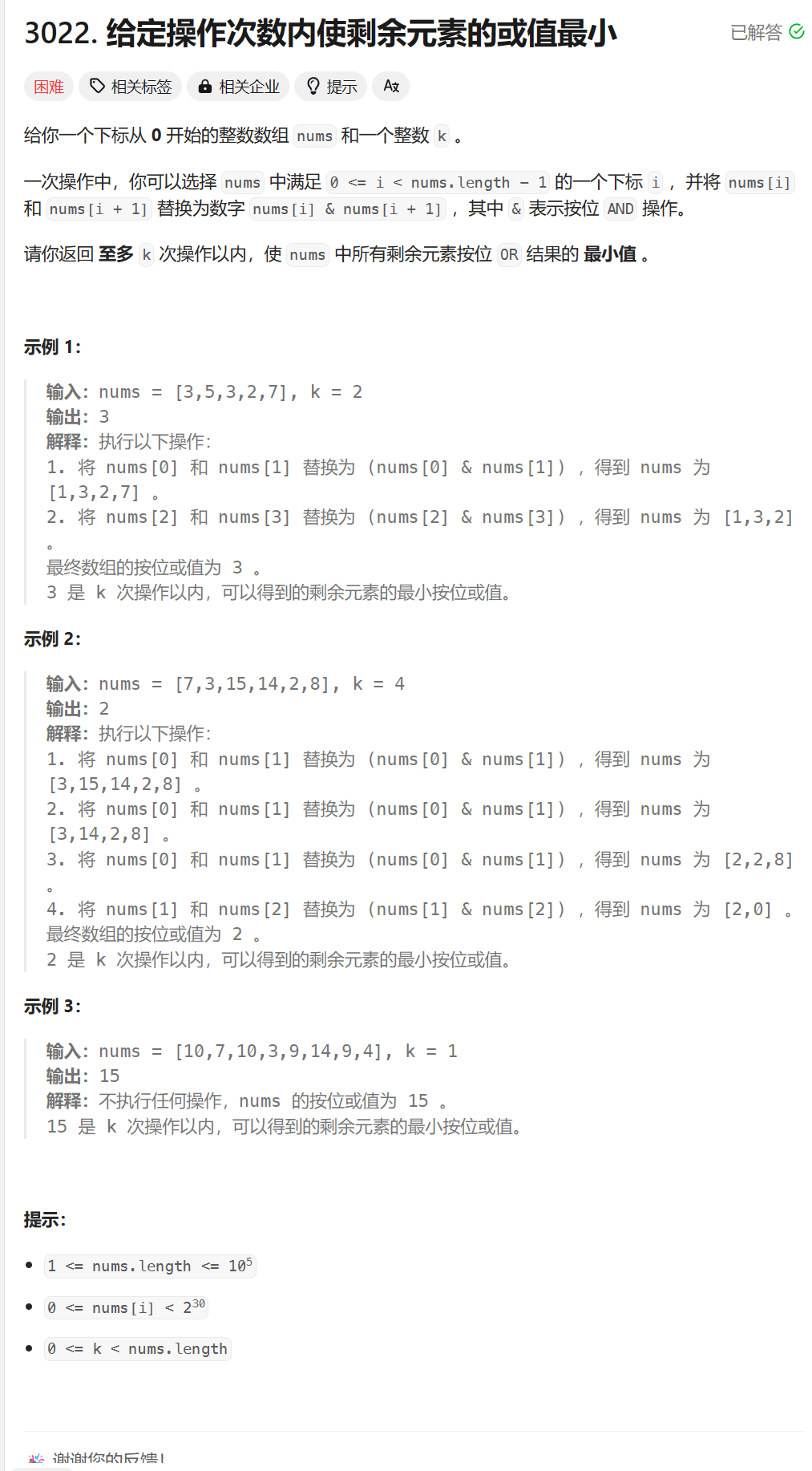

常见的图像退化因素如图所示:

1 A Review on No-reference Quality Assessment for Blurred Image 2022

NR-IQA方法很好地解决了无参考图像情况下的图像质量评估. NR-IQA也称为盲图像质量评价(Blind image quality assessment, BIQA), 该类方法主要根据失真图像的自身特征来估计图像质量. 针对模糊失真的NR-IQA方法又称为盲/无参考图像清晰度评价(Blind/no-reference image sharpness assessment)方法, 该方法分为两类, 一类是仅针对模糊失真的NR-IQA方法, 另外一类则是针对各种失真类型(包含模糊失真)的通用NR-IQA方法, 包括各种类型的噪声(如加性噪声、高斯噪声、掩模噪声、脉冲噪声等)、各种类型的模糊(如失焦模糊、运动模糊等)、JPEG(2000)压缩、JPEG(2000)传输错误、对比度问题(如对比度变化、整体对比度缩减等)、局部块失真、快速瑞利衰减等.

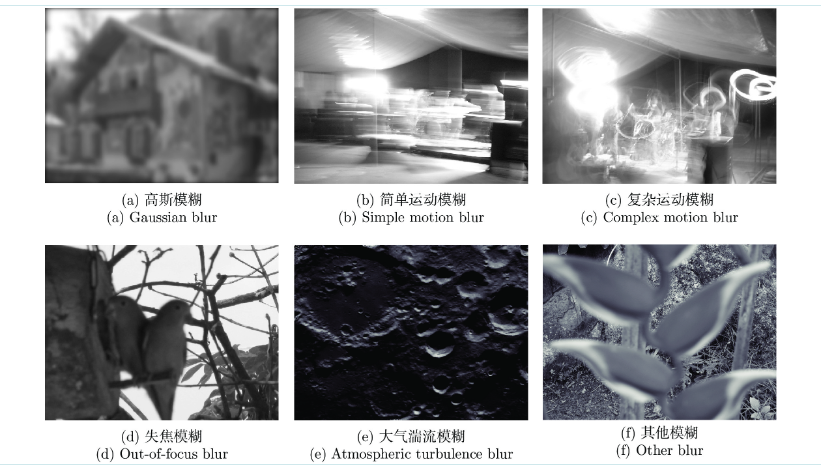

针对模糊失真的NR-IQA性能已经逐渐接近甚至达到FR-IQA方法和RR-IQA方法的评价性能. 尤其是近几年来, 随着深度学习等基于学习的方法在NR-IQA中的广泛应用, 评价性能得到了进一步的提升. 与此同时, 伴随着方法的改进, 针对不同模糊失真(人工模糊及自然模糊)的数据集也不断涌现, 从而为不同算法的验证提供了保证。产生模糊的原因可分为两大类型: 人工模糊与自然模糊. 人工模糊是通过不同类型的滤波器人为地给清晰图像加入不同类型的模糊, 如经常被用于模糊图像质量评价的高斯模糊. 而自然模糊包括物体移动引起的运动模糊, 拍摄时相机抖动引起的抖动模糊, 采集过程中失焦引起的失焦模糊, 远距离成像时的大气湍流模糊等。

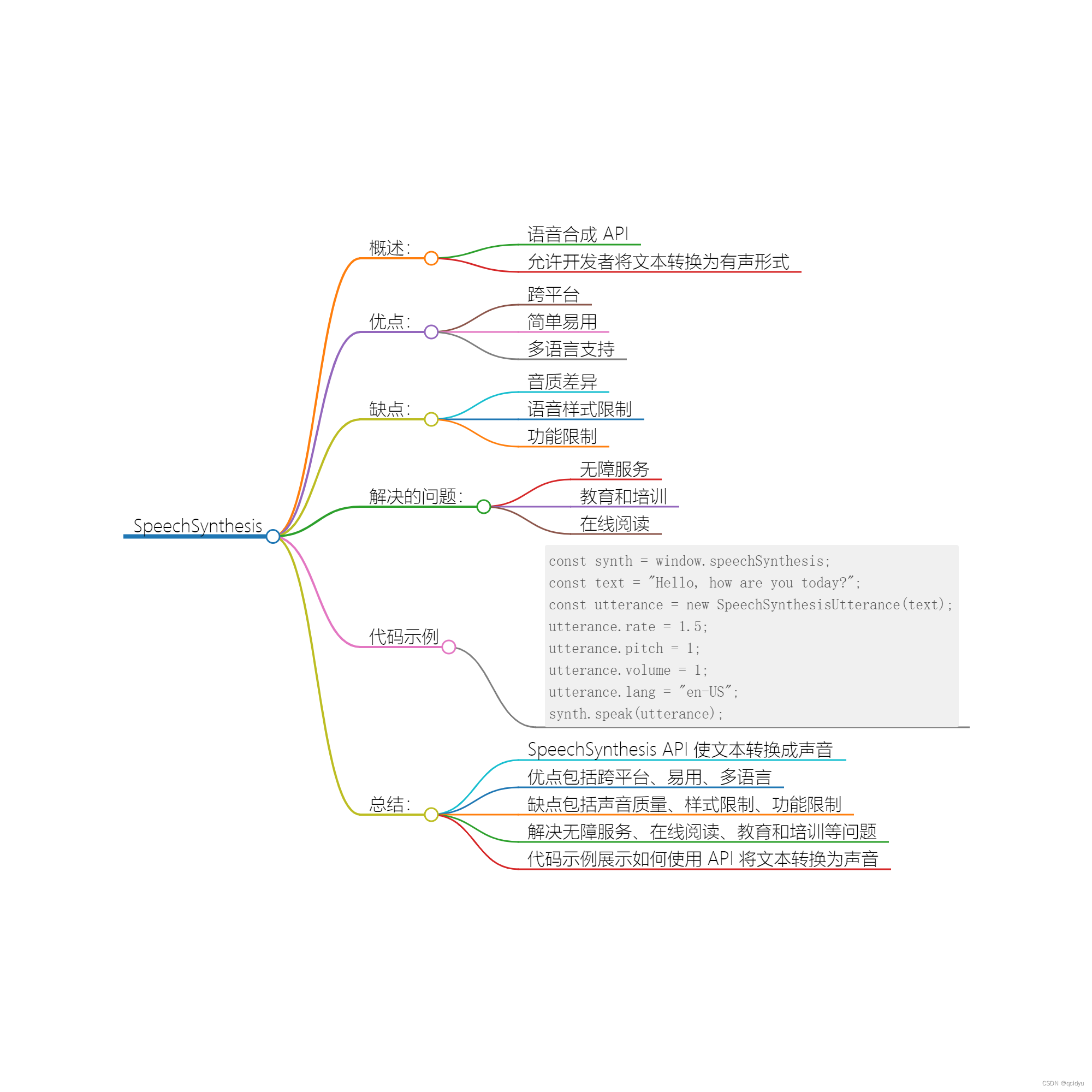

2 Blind Image Quality Assessment via Vision-Language Correspondence: A

Multitask Learning Perspective CVPR2023

LIQA

目标检测识别依赖于对失真不敏感的特征,从而对这种损坏具有鲁棒性。这也表现在视觉识别的常见做法中,即将合成扭曲视为数据增强[16]的形式。与之形成鲜明对比的是,BIQA优先依赖于失真敏感特征来量化各种语义内容的图像的感知质量。

例如,图1中的(c)可以被描述为“一张带有高斯模糊伪影的城市景观的照片,其质量很差。”我们首先使用文本模板来总结输入图像的场景类别、失真类型和质量水平。我们用场景类别和失真类型标签来补充现有的IQA数据集[7,11,17,22,27,54]。

近年来,BIQA的新模式蓬勃发展,旨在探索下一代BIQA的新发展方向。代表性的工作包括:局部质量预测[72]的补丁到图像学习,有价值样本识别[65,66]的主动学习,交叉失真场景[78]的统一优化,快速适应[80]的元学习,流畸变[29,39,74,77]的持续学习,以及鲁棒性评估[75]的感知攻击。在本文中,我们利用多任务学习来促进辅助知识的转移。在本文中,我们利用多任务学习来促进辅助知识的转移。

5种质量水平: c∈C={1,2,3,4,5}={“坏”,“差”,“好”,“好”,“完美“}

9个场景类别:s∈S={“动物”、“城市景观”、“人”、“室内场景”、“景观”、“夜景”、“植物”、“静物”和“其他”}

11个退化判断 d ∈ D={“模糊”、“颜色相关”、“对比度”、“JPEG压缩”、“JPEG2000压缩”、“噪声”、“过度曝光”、“量化”、“曝光不足”、“空间本地化”和“其他”},“其他”类别表示没有退化的图像,即原始质量。

自然创建一个文本模板,将三个任务的标签放在一起:“一个(n) {s}与{}文物的照片,14073边缘化软余弦相似度是{}质量”,我们有5×9×11 = 495候选文本描述(类别)。

然而,p(c,s,d|x)可能不能被准确地推断出来,因为现有的IQA数据集只提供连续的质量分数,而不是离散的质量水平。此外,由于主观测试数据集的差异,不同的IQA数据集具有不同的感知尺度,这进一步使质量分数到水平的转换复杂化。

在深度学习的时代,BIQA的发展可以通过策略来缓解带MoS标签的数据缺乏的问题,当合成距离(如高斯噪声和JPEG压缩)是主要问题时,分段训练[4]、质量预训练[32,37,76]和从噪声伪标签中学习[2,38,67]是实用的训练技巧,较少依赖Mos。这里是基于这三个假设,1)原始质量的图像存在并且是允许的,2)视觉失真可以有效地自动模拟,3)全参考IQA模型[64]是适用的,并提供足够的质量近似。

UNIQUE 效果不错

3 Blind Image Quality Assessment: A Brief Survey 2023.10

这些IQA数据库考虑了各种类型的失真,其中最常见的一种是压缩失真(如JPEG、JPEG2K、H.26X)、模糊失真(如高斯模糊、运动模糊、失焦模糊)和不同类型的噪声(如白噪声、脉冲噪声、多重噪声)。表1简要总结了一些具有代表性的数据库,包括失真类型(如真实和合成)和应用场景(如特定失真和通用)

首先,重要的是要强调合成扭曲和真实扭曲之间的根本区别。合成畸变通常是简单的,并且在生成IQA数据集的过程中可以很容易地控制和操作。另一方面,真实的扭曲要复杂得多,并可能出现在现实世界场景中的图像获取、压缩和处理的各个阶段。因此,针对真实的扭曲制定质量指标在质量评估中具有更大的实用价值。

4 A Survey on Image Quality Assessment 2022.7

图像质量评估(IQA)在基于图像的应用中越来越重要。其目的是建立一个模型,可以取代人类来准确评估图像质量。根据参考图像是否完整和可用,图像质量评价可分为全参考(FR)、减少参考(RR)和非参考(NR)图像质量评价三类。由于深度学习的蓬勃发展和研究者的广泛关注,近年来人们提出了几种基于深度学习的非参考图像质量评估方法,其中一些方法已经超过了减少参考甚至全参考图像质量评估模型的性能。本文将对图像质量评价和视频质量评价的概念和指标进行回顾,简要介绍一些全参考和半参考图像质量评价的方法,并重点介绍基于深度学习的非参考图像质量评价方法。然后介绍了常用的合成数据库和真实世界的数据库。最后,总结并提出了一些挑战。

5 Review: A Survey on Objective Evaluation of Image Sharpness 2013-2021

建立一个准确的图像清晰度的客观评价度量是图像分析、识别和质量测量的关键。在这篇综述中,我们强调了非参考图像质量评估研究的最新进展,将所报道的算法分为四组(基于空间域的方法、基于光谱域的方法、基于学习的方法和组合方法),并概述了每种方法组的优缺点。此外,我们进行了一项简短的文献计量学研究,其中概述了2013-2021年的当前趋势,并比较了代表性算法在公共数据集上的性能。最后,我们描述了当前研究中的缺点和未来的挑战。

在图像质量评价的概述中,常用的评价指标[1]包括图像噪声、图像颜色、伪影、锐度等。图像噪声评价方法[2]主要依靠图像的时空噪声、信噪比和灰度噪声来获得评价结果。图像颜色评价方法[3]通常是评价图像的色度和均匀性。图像伪影评价方法[4]更关注色差、畸变和渐晕因素,而图像锐度评价方法[5]是基于图像边缘和细节的综合评价,是目前最流行的图像质量评价方法之一,与仿生学[6]、非织造材料[7]、医药[8]等研究领域密切相关。

图像锐度是指图像的各个细节部分的纹理和边界的清晰度,它影响着对信息的感知、图像采集和后续处理,特别是在基于高质量图像[12–14]的一些应用中。理想的图像清晰度评价函数应具有高灵敏度、鲁棒性好和计算成本低的特点。

虽然上述研究取得了丰硕的成果,但图像清晰度的客观评价标准还不够成熟;适合大多数场景的评价方法很少。由于复杂的图像纹理和特征,要求一个锐度评估算法处理所有潜在的图像是不现实的。因此,本文对现有的锐度评价方法进行了回顾和聚类,并对几种具有代表性的方法进行了系统的比较分析,为研究人员在不同类型的图像上选择或开发锐度评价算法提供了方向。

本文对近十年来对无参考图像的锐度评价方法进行了回顾、分类和总结。将评价评价方法分为四类,比较其评价结果,讨论其优缺点。本文给出了图像锐度在图像处理中的应用前景,并为进一步研究无参考图像的锐度评价方法提供了指导方向。

6 No-reference image sharpness assessment based on discrepancy measures of structural degradation 2020

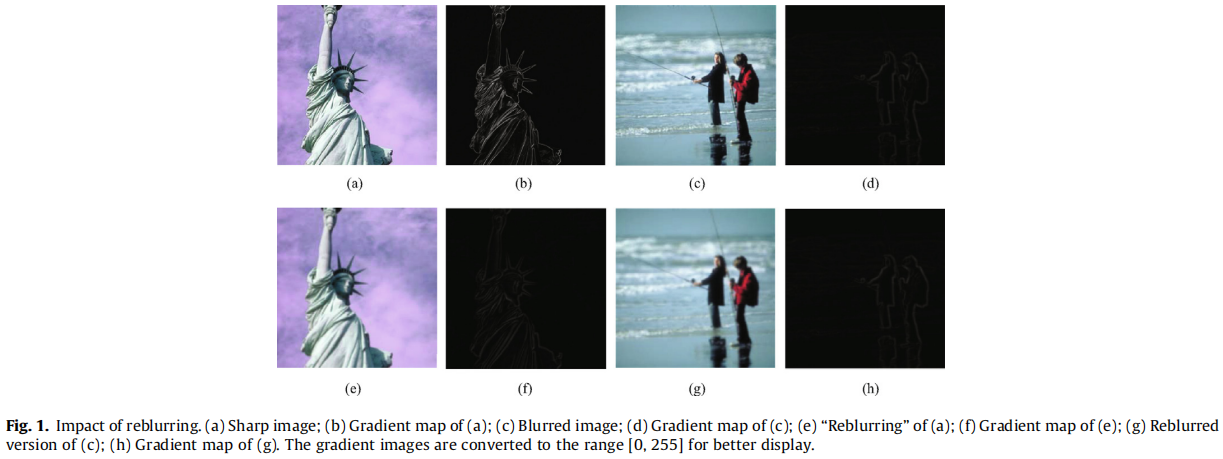

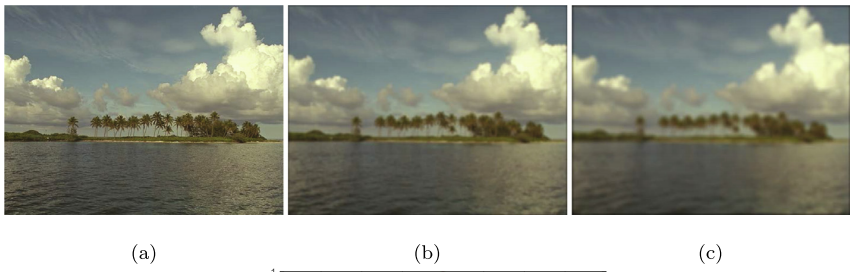

图像与其“重新模糊”版本之间的差异表明了图像中的模糊程度。本文提出了一种新的无参考图像锐度评估方法,利用空间和小波域结构退化的差异措施。具体来说,输入图像的局部结构退化的特征是基于方向选择性的视觉模式和图像与其对应的重模糊版本之间的log-Gabor滤波器响应的差异度量。考虑到观看距离对图像质量的影响,通过分辨率间的自相似性来测量全局锐度差异。最后,利用计算出的差异作为锐度感知特征,然后利用支持向量回归器将特征向量映射到质量分数中。在6个公共图像质量数据库上评估了该方法的性能,其中包括2个真实模糊图像数据库。实验结果表明,我们提出的方法在所有这些数据库中都取得了最先进的性能

模糊作为图像质量感知的关键决定因素,其典型的特征是边缘[14]的扩散。模糊的原因是多方面的,如离焦、相对运动和图像压缩。一般来说,模糊很可能发生在图像的整个生命周期中。值得注意的是,一个图像和它的“重新模糊”版本之间的差异通常表明了图像中的模糊程度。这是因为模糊主要影响图像的高频分量,而低频分量则保持相当稳定的[9]。特别是,模糊改变了模糊图像的结构大于模糊图像的结构。模糊对清晰图像的影响大于对模糊图像的影响。一般来说,如果一个图像与之相似,则被认为是模糊的。因此,差异可以作为模糊程度的一个指标。

在此,我们提出通过计算基于方向选择性的视觉模式和输入图像与其相应的重模糊版本之间的对数-ggabor滤波器响应的差异来提取锐度感知特征。观看距离和图像分辨率对图像质量评价[34]有重要影响。图3显示了图像分辨率对清晰度的影响。将原始图像在水平方向和垂直方向上分别进行2和4的降采样,从而生成降采样图像。虽然从原始图像中可以清楚地观察到模糊度,但由于空间分辨率的降低,降采样图像看起来比原始图像更清晰。

1 自相似性:原图方差和其不同分辨率图像块的方差之间的MSE求和取均值

2 差异测量:基于方向选择性的视觉模式的直方图差异,来估计模糊图像中的局部空间结构退化

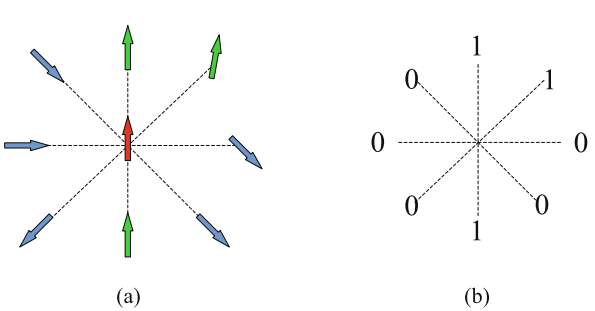

HVS对视觉感知[31]表现出显著的定向选择性。通过模拟皮层神经元之间相互作用的排列,将中心像素与其相邻像素之间的相关性进行二值化。然后,根据这些相关性,可以得到基于取向选择性的模式。

3 log-Gabor过滤器响应的差异度量

4 SVM

5 GT:主观评价分

7 An Image Quality Assessment Dataset for Portraits

DXOMARK

本文介绍了PIQ23,一个由100部智能手机获得的50个预定义场景的5116张图像,涵盖了各种品牌、模型和用例。该数据集包括不同性别和种族的个人,他们已经明确和知情地同意他们的照片用于公共研究。它通过从30多名图像质量专家那里收集的两两比较(PWC)对三个图像属性进行了注释:人脸细节保存,人脸目标曝光,和整体图像质量。

Blind IQA(BIQA),它是IQA的一个分支,在不需要无扭曲的参考图像的情况下评估图像质量。基于学习的BIQA方法[15,24,25,27,52,59,62,67,69]在真实相机失真数据集[9,13,21,56,61,70]上表现出良好的性能,通过图像质量的主观评价。注释这些数据集被认为是一个不适定的问题,因为主观意见不是确定性的,这使得使用BIQA方法作为准确的质量度量具有挑战性。因此,有必要建立一个定量和正式的框架来客观地评价和比较主观判断。在本文中,我们依赖于由图像质量专家对一组固定的和相关的属性集进行的两两比较。

基于多个属性定义图像质量,包括目标曝光,动态曝光范围、颜色、锐度、噪声和伪影,肖像图像需要额外的考虑,如肤色、散景效果、面部细节渲染和人脸上的目标曝光,这些都属于肖像质量评估(PQA)的范围。

我们的论文介绍了第一个同类的,智能手机肖像质量数据集。我们希望为IQA创造一个新的应用领域,并推动智能手机肖像摄影。4个贡献如下:

1一个新的数据集,PIQ23,由5116张单一肖像图像组成,使用来自14个品牌的100台智能手机设备拍摄,并分布在50个不同的自然场景(场景=固定的视觉内容)。

2在固定观察条件的实验室环境下控制的大型IQA实验。通过两两比较(PWC),并遵循精心设计的指导方针,我们从30多名图像质量专家(专业摄影师和图像质量专家)中,对每个场景收集了与肖像质量相关的三个属性的意见:人脸细节保存、人脸目标曝光和整体肖像图像质量。

3一种深入的统计分析方法,使我们能够评估标签的精度和一致性,这也是IQA任务的难度。因为其质量标注受到主观性、观察者之间的分歧和注释数量的严重影响。

4广泛比较多个BIQA模型和一种简单的结合场景语义信息和质量特征的新方法,以加强对PIQ23的图像质量预测。

BIQA datasets

早期的数据集,如LIVE [50]、CSIQ [29]、TID [44,45]和BAPPS [66],都是由经过几种人工失真处理的无噪声图像组成的。这些扭曲旨在描述图像压缩或传输场景,其中大多数未能捕捉到现代智能手机摄像系统的复杂性,通过非线性处理管道。

最近的ªin-the-wildº数据集,如CLIVE [13]、KonIQ10k [21]和PaQ-2-PiQ [61],由媒体收集的图像组成,更复杂的扭曲混合物更接近真实世界的图像。然而,由于它们的野性和不受控制的标签环境,它们并没有形成一个强大的背景来评估数码相机的质量,这是我们最感兴趣的。

作为对这一主题的早期努力,维尔塔宁等人[56]开发了一个数据库(CID2013),该数据库跨越了8个视觉场景和79个数码相机,在最近的工作中,Zhu等人[70]提供了一个智能手机IQA数据集(SCPQD2020),包含在120个视觉场景上用15个设备拍摄的1800张图像。他们在一个控制良好的实验室中对数据库进行了注释。Fang等人发布了SPAQ [9],一个智能手机IQA数据集,基于66台设备获取11125张图像。这两个数据集都提供了多个属性评估和场景类别。它们包括通用的视觉内容,并且不处理PQA。 除TID2013 [44]和BAPPS [66]外,前面提到的所有数据集都依赖于评级系统(MOS),并没有密切关注交叉内容观察的难度,在PIQ23中,我们提供了50个场景,每个场景都有独立的注释。我们通过两两比较收集了30多名图像质量专家的意见,这在IQA实验[34,43]中被证明更加一致。我们还通过一种新的统计分析方法,分析了注释的不确定性和一致性。

BIQA methods.

最近采用变压器架构[15,25,59,62]来提取全局质量信息的工作,在IQA数据集上显示出了令人印象深刻的性能。由于我们的数据集的每个场景注释结构,我们采用了一种语义感知的多任务处理方法来使规模和特征适应输入场景。

Domain shift

不同的IQA数据集之间的注释策略和图像内容可能有很大的差异。因此,它们各自的质量量表通常是相对的和独立的。有了这个特性,我们遇到了一个被称为域移位[53,63,68,69]的问题。由于质量量表是相对的,相似的分数可能并不表明不同数据集之间相同的感知质量水平。当我们试图从多个来源学习时,这可能会导致混淆。因此,理解图像的语义是必要的。当前的BIQA模型隐式地试图同时学习语义和质量。然而,合并这两个问题是极其困难的,因为它们似乎是相互矛盾的[9,26]。一些论文试图使用多任务学习[9,22,53,63]来解决这个问题。从质量中明确地分离语义信息在以前的工作中没有很好的表现。Su等人[52]提出了HyperIQA,这是一种自适应的超网络,可以隐式地提取语义信息并相应地调整质量预测。然而,超网络并没有经过训练来明确地预测类别。由于PIQ23由多个相对内容依赖的尺度组成,我们建议将多任务处理与HyperIQA相结合,以基于语义理解来适应每个场景的质量尺度。

PIQ23是从一个更大的数据集中进行下采样的,该数据集是经过很长时间(几年)收集的,这是工程和摄影领域累积努力的结果。因此,我们相信它有能力覆盖广泛的智能手机摄影领域。

Annotation strategy:基于感知的IQA实验具有很高的难度,而且通常是主观的。观点因多种因素而有很大差异:观看条件、观察者的文化和专业背景、图像内容等。PIQ23的目标是提供从公正和无偏见的观察中获得的(尽可能多地)的图像质量注释。为了使客观性和一致性最大化,我们提出了两个基本步骤:

1 两两对比,观察者被要求按照补充材料中描述的指导方针,从两幅图像中选择最好的一幅

2 我们为每个属性固定了感兴趣的区域(ROI)

我们提出了PIQ23,这是一个新的数据集,使用各种智能手机相机和用例,由图像质量专家使用两两比较对其进行了注释。我们通过提供一种新的统计分析方法,将质量尺度聚为一致的质量水平,从而证明了识别注释中的不确定性的重要性。最后,我们采用了一种训练策略和深度神经网络架构,以适应PIQ23的高分辨率图像,并从语义信息和多任务处理中获益,以适应数据集的每个场景质量缩放

No-reference image quality assessment via transformers, relative ranking, and self-consistency 2022

Musiq: Multi-scale image quality transformer. 2021

Maniqa: Multi-dimension attention network for no-reference image quality assessment. 2022

Transformer for image quality assessment 2021

8 Re-IQA: Unsupervised Learning for Image Quality Assessment in the Wild CVPR2023

我们提出了一种混合专家的方法来训练两个独立的编码器在无监督设置下学习高水平内容和低水平图像质量特征。

FR:SSIM [35], FSIM [43], and LPIPS [44]

NR-IQA算法: BRISQUE [19], PaQ-2-PiQ [40], and CONTRIQUE [16]

学习高级图像内容特征的编码器在ImageNet数据库的一个子集上进行训练

最近,许多“在野外”的数据集,如KonIQ [9],CLIVE [6],FLIVE [40],和SPAQ [5],已经被视觉质量研究人员开发和使用,因为它们解决了遗留数据集的缺点。

9 Quality-aware Pre-trained Models for Blind Image Quality Assessment cvpr2023

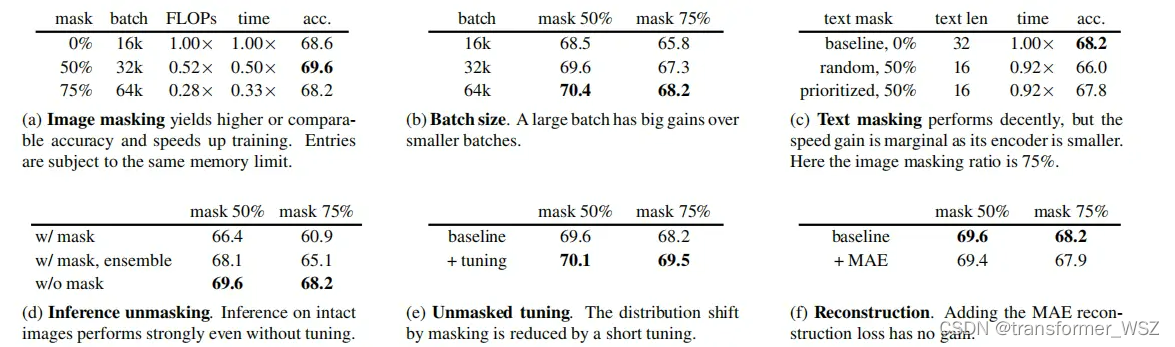

在本文中,我们提出通过自监督学习的方式为BIQA定制的借口任务来解决这个问题,这样可以从更多数量级的数据中学习表示,为了约束学习过程,我们提出了一个基于简单假设的质量感知对比损失:来自扭曲图像的补丁质量应该相似,但来自同一图像的补丁和来自不同图像的补丁不同,进一步,我们改进了现有的降解过程,形成了一个大小约为2×107的降解空间。使用我们的方法在ImageNet上进行预训练后,模型对图像质量更加敏感,在下游BIQA任务上表现显著更好。实验结果表明,该方法在流行的BIQA数据集上得到了显著的改进。

因此,[12,20,22,24,52,73]一直致力于建立一种与人类观众相一致的图像质量评估(IQA)方法。在现实场景中,通常不存在对参考图像的访问,而且参考图像的质量是可疑的。因此,盲IQA(BIQA)方法更具吸引力和适用性,尽管全参考IQA已经取得了前瞻性的结果[33]。

10 From Patches to Pictures (PaQ-2-PiQ): Mapping the Perceptual Space of Picture Quality

为了推进这一问题的进展,我们引入了(迄今为止)最大的主观图像质量数据库,该数据库有大约4万张图片和12万个补丁,我们通过将近8000个独特的受试者(受试者拒绝后)收集了400万条人类判断。

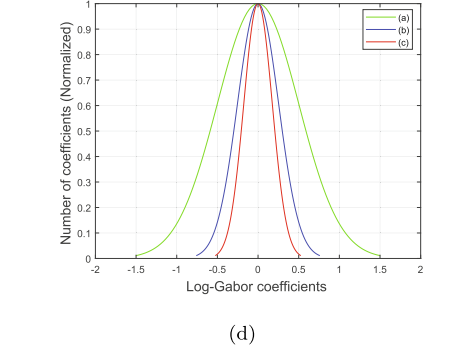

这是一个常见的误解,即如果两幅图片被相同数量的失真(如模糊)所破坏,它们将有相似的感知质量,例如图a、b。另一方面,图1中的(c)应用了空间上均匀的白噪声,但其感知到的失真严重程度在整个图片中有所不同。

图片内容和扭曲之间复杂的相互作用,以及失真伪影的视觉处理方式,在可见或恼人的视觉扭曲中扮演着重要的角色。此外,感知质量与分辨率和比特率等简单量的相关性很差。

1 没有任何图片被降采样,因为这种干预可以实质上改变图片的质量。此外,包括不同大小的图片也能更好地反映实际实践。

2 我们设计了一个图片集合,其特征直方图与从一个社交媒体网站上随机选择的1500万张图片相匹配。

主观图片质量评分是对人类受试者的真正的心理测量测量,需要10-20倍的时间进行审查(每张照片),例如,物体标签[50]。我们使用亚马逊机械土耳其(AMT)众包系统,为此目的[17,18,62,63],以收集人类图片质量标签。

处理主观分数:N=210

人员:我们只接受接受率>为75%的工人。

一致性检查:重复图像:每一阶段随机重复N中5个内容,以确定受试者是否给予了一致的评分;

金标准:N含量中有5个是“从15张图片和76张斑块中取样的黄金图片,在18名可靠的受试者的对照实验室研究中分别进行评分。”这些“黄金”图像并不是新数据库的一部分。

我们根据两个因素接受或拒绝了一个HIT中的每个评分者的得分:重复内容得分与总体标准差的差异,以及他们超过50%的得分是否相同。由于我们希望获得许多评级,员工可以参与多个hit。每个内容收到至少35个质量评级,其中一些收到多达50个。每个受试者提供的标签被转换为标准化的Z分数[24],[17],平均(按内容计算),然后缩放到[0,100],产生平均意见分数(MOS)。受试者拒绝后收集的人类主观标签总数为3931710个(图像上950574个,补丁上2981136个)。

检验主观数据一致性的标准方法[24],[17],是将受试者随机分为两个不相交的等组,计算每张图片上的两个MOS(每组一个),然后计算两组MOS值之间的皮尔逊线性相关(LCC)。当重复超过25次随机分割时,两组MOS之间的平均LCC为0.48,说明在该真实图像数据集上的质量预测问题存在困难.

Input image pre-processing:因为图像质量预测(无论是由人类还是机器进行的)是一种心理测量预测,所以不修改被输入网络的图片是至关重要的。虽然大多数视觉识别学习者通过裁剪、调整大小、翻转等来增强输入图像,但在训练感知质量预测器时做同样的事情将是一个心理测量错误。这种输入预处理将导致感知质量分数与记录的图片相关。为了解决输入大小不一样问题,我们将每个训练图片填充到640×640,将每个实例中的内容居中。有一个或两个尺寸都大于640的图片被移到测试集中。这种方法有以下优点,a)它允许向网络提供固定大小的图片,使它稳定收敛好,(b)它允许大批量,改善训练,(c)它同意图片评分者的经验,因为AMT渲染的图片周围的白色边界不占据整个网页的宽度。

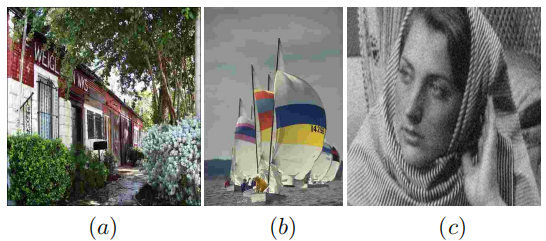

图11中局部与全球质量感知竞争的例子突出了无参考感知图像质量评估问题的基本困难:它的主观性质,内容和无数可能的扭曲组合之间的复杂互动,以及掩蔽等感知现象的影响。更复杂的体系结构可能会减轻其中的一些问题。此外,关于图片(如面孔、动物、婴儿)或场景(如室外和室内)中物体的中级语义侧信息也可能有助于捕捉更高层次的过程在图像质量评估中的作用。

11 Quality-aware Pre-trained Models for Blind Image Quality Assessment

CVPR 2023|快手视频质量评估算法被顶会收录 - 实时互动网

1 先验条件:一张图不同patch的质量是相似的,一张图经过不同降质后,质量不一样

不同图像的质量不一样

2 带质量标注MOS的数据相比其他任务的数据非常少;

3 基于imagenet的图像分类任务的预训练权重不适合作为质量估计模型的初始化话参数,因为分类任务是希望不同退质的图像仍然保持相同的语义,没有对低级别特征敏感,因此作者希望通过自监督的方法得到一个适合下游为质量估计的预训练模型权重,这个预训练模型需要对不同退化敏感;

4 构建了一个2*10^14的退化空间,更加接近真实退化。

5 对称学习目标参考MoCov2+infoNCE

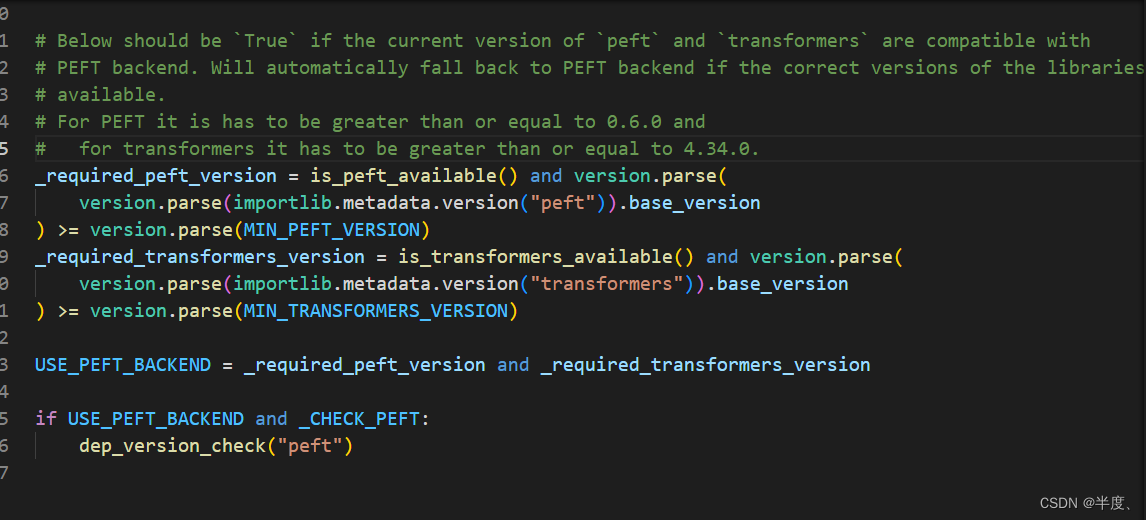

值得注意的是,上述所有作品都可以归类为语义感知预训练,因为它们鼓励同一图像的视图(增强)具有相似的表示,而忽略了感知图像质量的变化。在这项工作中,我们重新设计了BIQA的质量感知借口任务,这将在Sec中讨论。在这项工作中,我们结合了[70,84]在图像恢复领域提出的多种退化技巧,形成一个更大的退化空间,生成更真实的失真图像。

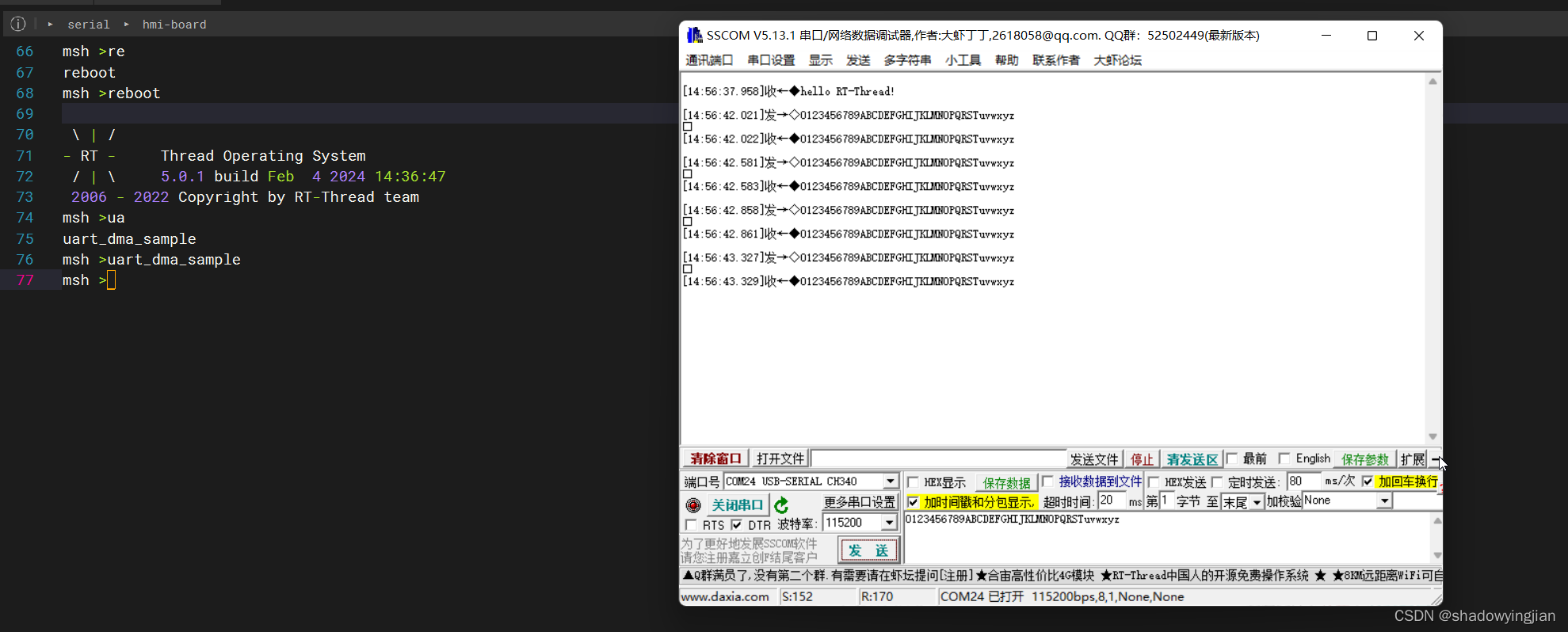

12 MUSIQ: Multi-scale Image Quality Transformer ICCV2021

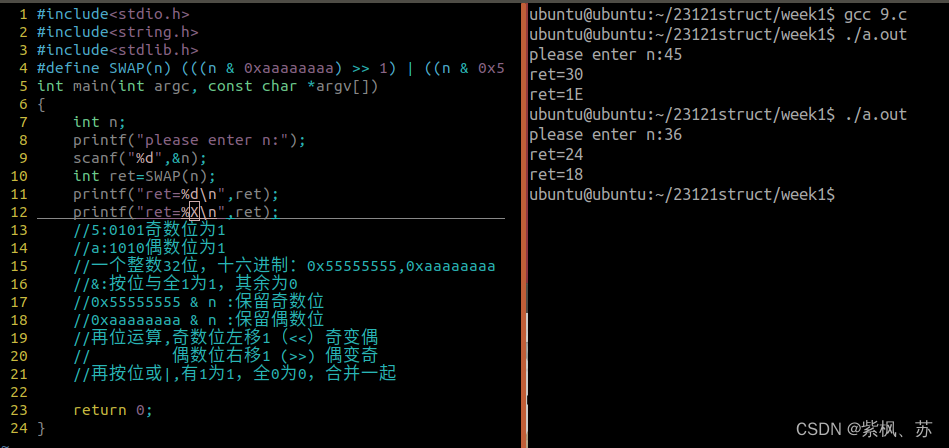

1 基于深度学习的方法需要对输入图像进行resize和scale,是影响质量判断;

2 目前的方法,有的padd ing,有的一个batch一张图像,有的基于空洞卷积进行处理成统一的尺寸;

![pwn旅行之[WUSTCTF 2020]getshell2(一些小知识)](https://img-blog.csdnimg.cn/direct/05311b5e2604406485f6c1fe4ac06356.png)